基于残差编解码网络的单光子压缩成像  下载: 1701次

下载: 1701次

1 引言

单光子成像是利用单光子探测器对单个光子进行甄别和计数,从而在光极其微弱环境下实现成像,在生物医学成像[1-4]、荧光寿命显微镜成像[5-6]、多光谱成像[7-8]等领域得到了广泛应用。实现单光子成像的方法主要有两种。一种方法是采用面阵单光子探测器实现二维成像。面阵探测器增强CCD(ICCD)[9]和电子倍增CCD(EMCCD)[10]可以在光子计数模式下工作,具有很高的空间分辨率,但需要极高的读出帧频和低电路噪声,因此成本很高。其他面阵单光子探测器,如单光子雪崩二极管(SPAD)阵列、微通道板光电倍增管(MCP-PMT)[11-13]、多阳极光电倍增管(MAPMT)[14]、硅光电倍增管(SIPM)阵列[15]等,价格昂贵、分辨率比较低。另一种实现单光子成像的方法是利用点探测器加光机扫描的方式进行成像。常用的光电倍增管、雪崩光电二极管和超导纳米线等单光子探测器作为点探测器。由于扫描方式光子采集效率较低,因此成像时间较长。

基于压缩感知理论的单像素成像为单光子成像提供了一种新的思路。2012年,Yu等[16]提出了一种基于单像素成像技术的单光子压缩成像系统。它有两个主要优势:仅使用点探测器即可实现二维成像,因此这种成像方法成本较低,特别是在某些特殊波段;单像素成像系统中的点探测器可以同时采集多个像素的光强,所以该系统的成像灵敏度不再受单光子点探测器探测灵敏度的限制,信噪比大大提高。

然而,单光子压缩成像的成像速度非常慢,限制了其应用。它还有两个方面需要改进。一是设计测量矩阵对最有效的信息进行采样,从而减少总采样时间。二是开发一种快速、高质量的重建算法。在测量矩阵方面,利用高斯矩阵[17]、二进制随机矩阵[18]、Toeplitz矩阵[19]等矩阵进行少量测量,可以有效地恢复信号。为了实现高效采样,一些研究人员基于从已有测量数据中获得的先验信息构造了自适应测量矩阵[20],以减少测量次数。为了更有效地对信息进行采样,本文利用专门设计的深度学习网络来产生测量矩阵。在重建算法方面,已经提出了许多优秀的算法,如OMP(Orthogonal Matching Pursuit)[21]、ROMP(Regularized Orthogonal Matching Pursuit)[22]、IHT(Iterative Hard Thresholding)[23]和TVAL3(Total Variation Augmented Lagrangian Alternating Direction Algorithm)[24]。这些算法大多基于图像稀疏或一定变换域下稀疏的假设,采用迭代策略求解凸优化问题。其中TVAL3算法是结合了增强拉格朗日函数和基于最小全变分法的交替极小化方法。使用上述各种算法重建图像所需的时间普遍较长,特别是处理分辨率较大的图像时。

深度神经网络[25]在图像分类[26]、超分辨率[27]、目标检测[28]、恢复[29]等计算机视觉任务上取得了一系列突破。近年来,人们提出了几种用于压缩感知(CS)测量中重建图像的深度神经网络。由于其强大的学习能力,目前基于深度学习的方法有效地避免了计算量大、重建时间长等问题,并且具有良好的重建性能[30]。Shimobaba等[31]利用深度学习提高计算鬼影成像(CGI)图像的质量,并取得了良好的效果。2015年,Mousavi等[32]将叠加去噪自动编码器(SDA)应用于无监督特征学习,大大缩短了重建时间。2016年,Kulkarni等[30]提出了基于图像超分辨率重建的重建模型,重建效果优于SDA。2019年,Yao等[33]利用深层残差学习构建了DR2-Net,重建结果更加准确。实验结果表明,在不降低重建图像质量的前提下,利用深度学习重建压缩感知图像的时间复杂度可降低为原来的1%左右。Xie等[34]提出了一种用于压缩感知图像重建的自适应测量网络,该网络采用全连接层代替随机高斯矩阵来实现CS测量,获得了更精确的重建图像。上述基于深度学习的压缩感知成像方法均采用浮点型随机矩阵作为测量矩阵,且仅通过仿真进行了验证。然而,在单光子压缩成像系统中,加载在数字微镜阵列(DMD)上的测量矩阵必须是二进制矩阵,且上述方案的可行性需要实验系统的验证。

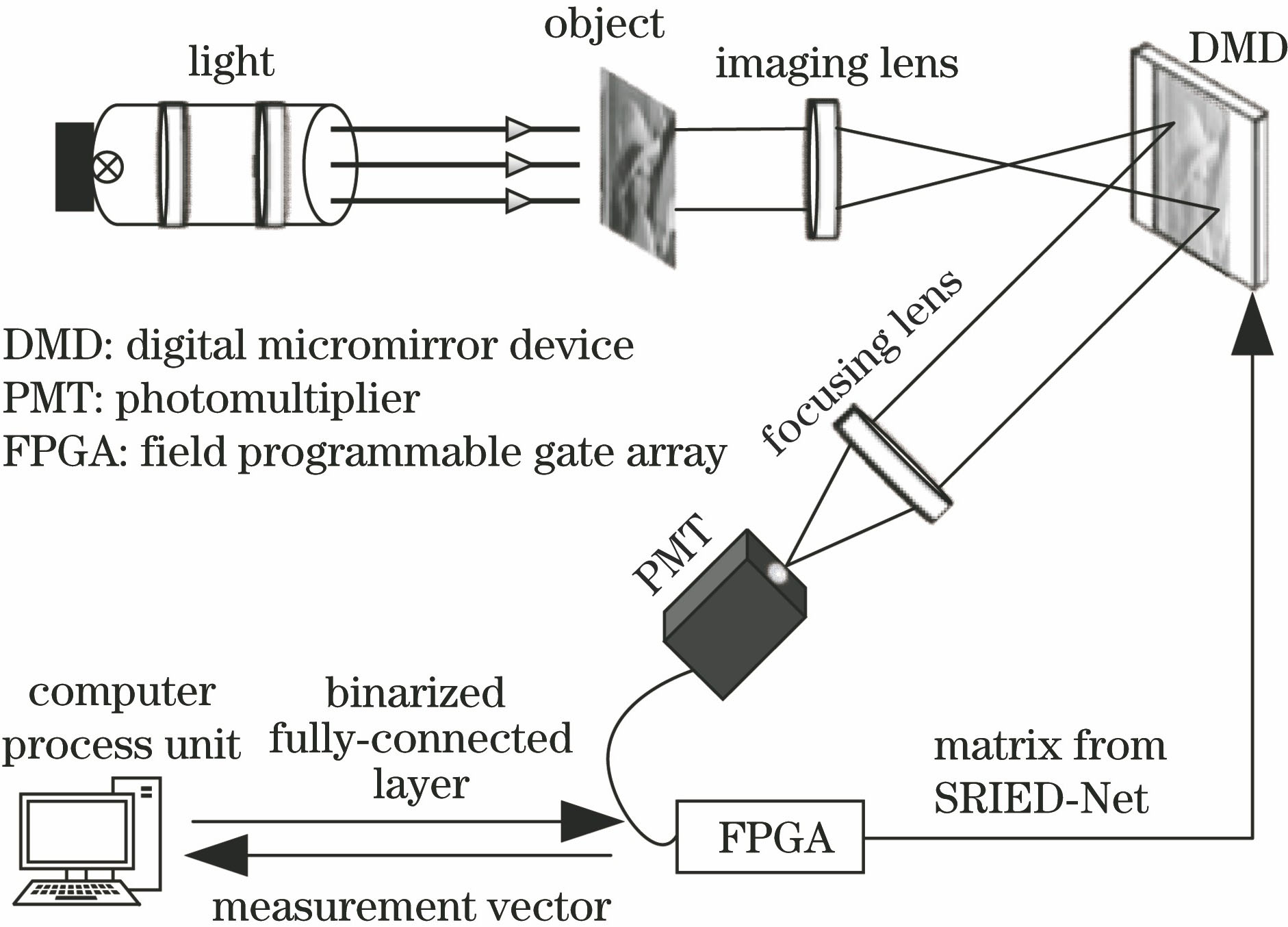

本文提出了一种新的采样和重建集成的残差编解码网络。网络的第一层使用二值化的全连接层实现图像的CS测量。也就是说,将网络第一层的二值化权值矩阵加载到DMD上对图像进行采样,然后利用后续的网络对图像进行重建,从而实现大面积高分辨率的快速成像。在此基础上,建立单光子压缩成像实验系统,验证了SRIED-Net的可靠性。

2 原理与实现

2.1 单光子压缩成像系统

在+12°的位置上放置一个会聚透镜,用来会聚DMD调制的光信号,使其进入工作在光子计数模式的光电倍增管 (PMT,Hamamatsu Photonics H10682-110)。工作在光子计数模式的光电倍增管可作为点探测器,可以在一次采集中同时收集多个DMD上像素的光强值,输出一个一个离散脉冲至接收器。因此,该系统的信噪比非常高,可以在很高的灵敏度下进行成像。将已经训练好的SRIED网络的第一层全连接层的二值化权值矩阵作为测量矩阵,通过基于FPGA的控制模块加载至DMD上实现光的调制,并在每一次采集之后读出光电倍增管的计数值,即光子数,通过FPGA的串口将数据发送到上位机,上位机处理后,输入已经训练好的SRIED后续网络重建出采集到的图像。

2.2 网络架构

本文提出的SRIED-Net结构如

压缩采样子网络:网络的输入是第i个原始图像xi(xi∈R1×m)。第一层全连接层可以看作一个压缩感知测量矩阵W1(W1∈Rm×n),用以代替传统的随机高斯测量矩阵。为了适应DMD的采样特性,本文对第一层全连接层的权值矩阵W1进行了二值化,并将其表示为

式中:yi∈R1×n为第i个原始图像压缩采样后的结果,n为测量次数。

初步重建子网络:网络中第二层全连接层用于对压缩测量结果进行初步重建,重建过程可以表示为

式中:

式中:N为训练一个批次所用图像块的个数。

残差编解码卷积子网络:受到RED-CNN网络[35]的启发,本文采用残差编解码卷积网络对测量结果进行进一步的重建。网络的总体结构如

残差映射:与现有技术方法[36-37]一样,卷积将消除一些图像细节。尽管反卷积层可以恢复一些细节,但是当网络越来越深时,累积的损失可能导致图像重建效果不是很理想的。此外,当网络深度增加时,梯度扩散可能使网络难以训练。为了解决这两个问题,本文在网络中引入了剩余补偿机制,类似于深度残差学习[38-39]。采用残差映射,而不是仅通过堆叠层将输入映射到输出,如

重建过程:对于给定的图像,本文首先将其无重叠的部分分割成32×32大小的图像块,将分割后的图像块作为SRIED-Net的输入并将其拉伸为1×1024大小。在压缩采样子网络中,n随着测量率(MR)的变化而变化,n=256,103,41,11对应的测量率分别为0.25,0.10,0.04,0.01。输入图像经过第一层全连接层后,输出压缩采样后的信号。第二层全连接层是由1024个神经元组成的,可将连接层输出的1×1024的图像转为32×32的图像,并将其作为初步重建图像。残差编解码卷积网络Fr(·)以初步重建结果

2.3 二值化及训练方法

本节主要介绍了本文使用的二值化方法和相应的训练方法。受文献[ 40]的启发,对神经网络第一个全连接层的权值W1进行二值化。相比于文献[ 40]中对所有层都进行二值化,本文只对第一层进行了二值化,从而更好地保证了重建的精度。本文使用的二值化方案是基于符号函数sign的确定性方法,即

式中:xb为二值化的变量;x为实值变量,它的实现非常简单,在实践中也非常有效。已知二值化操作(即前向传播过程)为

符号函数sign的导数为零,显然无法进行反向传播运算。因此,在反向传播过程中需要对梯度进行修正,假设梯度

注意,这保留了梯度的信息,并在r太大时取消了梯度。当r太大时,如果不取消梯度就会显著降低性能。其中

3 实验结果与讨论

在重建质量方面,将本文的重建方案与目前比较先进的CS图像重建算法TVAL3进行比较,将Xie等[34]提出的AD_RE-Net的首层全连接层进行二值化后也与本文的方案进行比较。另外,本文分别使用SRIED-Net生成的测量矩阵和随机高斯矩阵来实现CS测量,然后使用TVAL3算法对这两个测量结果进行重建并比较它们的重建质量。

本文使用与文献[ 30]中相同的91幅图像来生成SRIED-Net的训练集。然后用步幅14提取32×32大小的图像块,这个过程最终从91幅图像中采样到21760个图像块。对于每个图像块,首先提取其亮度分量,将亮度分量表示为xi,并将其用作网络的输入。测试集也与文献[ 30]中的相同。

表 1. 不同算法在不同测量率下重建结果的峰值信噪比

Table 1. SNR of reconstruction results of different algorithms at different MRdB

|

在实验中,使用峰值信噪比(SNR)来比较重建质量,这是因为SNR经常被用作图像压缩领域中信号重建质量的测量方法,常通过均方差(MSE)进行定义。对于两个m×n大小的单色图像I和K,如果一个为另一个的噪声近似,那么他们的均方差定义为

峰值信噪比定义为

式中:M表示图像点颜色的最大数值,如果每个采样点用8位表示,其数值就为255。

图 4. 不同算法在不同测量率下的平均峰值信噪比比较

Fig. 4. Comparison of average SNRs of different algorithms at different MR

图 7. 使用TVAL3算法重建的单光子压缩成像。(a)使用随机高斯矩阵进行采样;(b)使用SRIED-Net的第一层全连接层作为测量矩阵进行采样

Fig. 7. Single photon compressive imaging using TVAL3 to reconstruct. (a) Sampling by random Gaussian matrix; (b) sampling by measurement matrix from the first FC layer in SRIED-Net

图 8. 使用不同测量矩阵采样后重建结果的峰值信噪比

Fig. 8. SNRs of reconstruction results after sampling with different measurement matrices

图 9. 使用不同测量矩阵采样后重建结果的结构相似性

Fig. 9. SIMs of reconstruction results after sampling with different measurement matrices

4 结论

本文展示了一种新型的基于采样和重建集成的残差编解码网络的单光子压缩成像系统。在SRIED-Net的第一层上设置二值化的全连接层用以产生测量矩阵并将其加载到DMD上进行压缩测量,然后使用后续的残差编解码卷积网络进行重建。实验结果表明,将本文所提出的SRIED-Net用于单光子压缩成像是完全可行的,其重建质量远优于自适应测量网络[34]。SRIED-Net的重建质量在高测量率下接近TVAL3算法的重建质量,在低测量率下优于TVAL3算法。SRIED-Net生成的测量矩阵不仅可以实现基于深度学习方法的良好重建,还适用于使用TVAL3算法的重建,并且重建结果优于使用随机高斯测量矩阵的结果。此外,当深度学习重建网络训练完成后,图像重建阶段的时间复杂度将大大降低。

[1] Studer V, Bobin J, Chahid M, et al. Compressive fluorescence microscopy for biological and hyperspectral imaging[J]. Proceedings of the National Academy of Sciences, 2012, 109(26): E1679-E1687.

[2] Ueda T. Yuh W T C. Single-photon emission CT imaging in acute stroke[J]. Neuroimaging clinics of North America, 2005, 15(3): 543-551.

[3] Pourmorteza A, Symons R, Sandfort V, et al. Abdominal imaging with contrast-enhanced photon-counting CT: first human experience[J]. Radiology, 2016, 279(1): 239-245.

[4] Taguchi K, Iwanczyk J S. Vision 20/20: single photon counting X-ray detectors in medical imaging[J]. Medical Physics, 2013, 40(10): 100901.

[5] ChenY, PeriasamyA. 13-time-correlated single-photon counting fluorescence lifetime imaging-FRET microscopy for protein localization[M] ∥Periasamy A, Day R N. Molecular imaging. USA: Academic Press, 2005: 239- 259.

[6] Becker W, Bergmann A, Hink M A, et al. Fluorescence lifetime imaging by time-correlated single-photon counting[J]. Microscopy Research and Technique, 2004, 63(1): 58-66.

[7] Liu Y X, Shi J H, Zeng G H. Single-photon-counting polarization ghost imaging[J]. Applied Optics, 2016, 55(36): 10347-10351.

[8] Liu X F, Yu W K, Yao X R, et al. Measurement dimensions compressed spectral imaging with a single point detector[J]. Optics Communications, 2016, 365: 173-179.

[9] Qi L, Just F, Leuchs G, et al. Autonomous absolute calibration of an ICCD camera in single-photon detection regime[J]. Optics Express, 2016, 24(23): 26444-26453.

[10] Morris P A, Aspden R S. Bell J E C, et al. Imaging with a small number of photons[J]. Nature Communications, 2015, 6: 5913.

[11] 张兴华, 赵宝升, 缪震华, 等. 紫外单光子成像系统的研究[J]. 物理学报, 2008, 57(7): 4238-4243.

Zhang X H, Zhao B S, Miao Z H, et al. Study of ultraviolet single photon imaging system[J]. Acta Physica Sinica, 2008, 57(7): 4238-4243.

[12] 尼启良, 何玲平, 刘世界, 等. 使用感应电荷位敏阳极的极紫外单光子计数成像系统[J]. 光学精密工程, 2010, 18(12): 2543-2548.

[14] Calvi M, Carniti P, Cassina L, et al. Characterization of the Hamamatsu H12700A-03 and R12699-03 multi-anode photomultiplier tubes[J]. Journal of Instrumentation, 2015, 10(9): P09021.

[15] Martinenghi E, di Sieno L, Contini D, et al. Time-resolved single-photon detection module based on silicon photomultiplier: a novel building block for time-correlated measurement systems[J]. Review of Scientific Instruments, 2016, 87(7): 073101.

[16] Yu WK, Liu XF, Yao XR, et al. ( 2012-02-27)[2019-08-28]. https:∥arxiv.gg363.site/abs/1202. 5866.

[17] He CW, Yin TT, Yu WB, et al. Information-weighted Gaussian matrix in compressed sensing for ECG[C]∥2016 Chinese Control and Decision Conference (CCDC), May 28-30, 2016, Yinchuan, China. New York: IEEE, 2016: 3827- 3830.

[18] 朱志臻, 周崇彬, 刘发林, 等. 用于压缩感知的二值化测量矩阵[J]. 微波学报, 2014, 30(2): 79-83, 96.

Zhu Z Z, Zhou C B, Liu F L, et al. Binarized measurement matrix for compressive sensing[J]. Journal of Microwaves, 2014, 30(2): 79-83, 96.

[19] Xu S, Yin H P, Chai Y, et al. An improved Toeplitz measurement matrix for compressive sensing[J]. International Journal of Distributed Sensor Networks, 2014, 10(6): 846757.

[20] Ji S H, Xue Y, Carin L. Bayesian compressive sensing[J]. IEEE Transactions on Signal Processing, 2008, 56(6): 2346-2356.

[21] Tropp J A, Gilbert A C. Signal recovery from random measurements via orthogonal matching pursuit[J]. IEEE Transactions on Information Theory, 2007, 53(12): 4655-4666.

[22] Needell D, Vershynin R. Signal recovery from incomplete and inaccurate measurements via regularized orthogonal matching pursuit[J]. IEEE Journal of Selected Topics in Signal Processing, 2010, 4(2): 310-316.

[24] LiC. An efficient algorithm for total variation regularization with applications to the single pixel camera and compressive sensing[D]. USA: Rice University, 2010.

[25] Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[J]. Communications of the ACM, 2017, 60(6): 84-90.

[26] 陈洋, 范荣双, 王竞雪, 等. 基于深度学习的资源三号卫星遥感影像云检测方法[J]. 光学学报, 2018, 38(1): 0128005.

[27] DongC, Loy CC, He KM, et al. Learning a deep convolutional network for image super-resolution[M] ∥Fleet D, Pajdla T, Schiele B, et al. Computer vision-ECCV 2014. Lecture notes in computer science. Cham: Springer, 2014, 8692: 184- 199.

[28] 赵恒, 安维胜. 结合深度学习的图像显著目标检测[J]. 激光与光电子学进展, 2018, 55(12): 121003.

[29] SvobodaP, HradisM, BarinaD, et al. ( 2016-05-02)[2019-08-28]. https:∥arxiv.gg363.site/abs/1605. 00366.

[30] KulkarniK, LohitS, TuragaP, et al. ReconNet: non-iterative reconstruction of images from compressively sensed measurements[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 449- 458.

[31] Shimobaba T, Endo Y, Nishitsuji T, et al. Computational ghost imaging using deep learning[J]. Optics Communications, 2018, 413: 147-151.

[32] MousaviA, Patel AB, Baraniuk RG. A deep learning approach to structured signal recovery[C]∥2015 53rd Annual Allerton Conference on Communication, Control, and Computing (Allerton), September 29-October 2, 2015, Monticello, IL, USA. New York: IEEE, 2015: 1336- 1343.

[33] Yao H T, Dai F, Zhang S L, et al. DR 2-Net: deep residual reconstruction network for image compressive sensing[J]. Neurocomputing, 2019, 359: 483-493.

[34] Xie XM, Wang YX, Shi GM, et al. Adaptive measurement network for CS image reconstruction[M] ∥Yang J F, Hu Q H, Cheng M M, et al. Computer vision. CCCV 2017. Communications in computer and information science. Singapore: Springer, 2017, 772: 407- 417.

[35] Chen H, Zhang Y, Kalra M K, et al. Low-dose CT with a residual encoder-decoder convolutional neural network[J]. IEEE Transactions on Medical Imaging, 2017, 36(12): 2524-2535.

[36] XieJ, XuL, ChenE. Image denoising and inpainting with deep neural networks[C]∥Advances in Neural Information Processing Systems, December 3-6, 2012, Lake Tahoe, Nevada, United States. Canada: NIPS, 2012: 341- 349.

[37] AgostinelliF, Anderson MR, LeeH. Adaptive multi-column deep neural networks with application to robust image denoising[C]∥Advances in Neural Information Processing Systems, December 5-8, 2013, Lake Tahoe, Nevada, United States. Canada: NIPS, 2013: 1493- 1501.

[38] He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 770- 778.

[39] Srivastava RK, GreffK, SchmidhuberJ. Training very deep networks[C]∥Advances in Neural Information Processing Systems, December 7-12, 2015, Montreal, Quebec, Canada. Canada: NIPS, 2015: 2377- 2385.

[40] CourbariauxM, HubaraI, SoudryD, et al. and activations constrained to +1 or -1[J/OL]. ( 2016-03-17)[2019-08-28]. https:∥arxiv.gg363.site/abs/1602. 02830.

[41] Yan Q R, Wang H, Yuan C L, et al. Large-area single photon compressive imaging based on multiple micro-mirrors combination imaging method[J]. Optics Express, 2018, 26(15): 19080-19090.

Article Outline

管焰秋, 鄢秋荣, 杨晟韬, 李冰, 曹芊芊, 方哲宇. 基于残差编解码网络的单光子压缩成像[J]. 光学学报, 2020, 40(1): 0111022. Yanqiu Guan, Qiurong Yan, Shengtao Yang, Bing Li, Qianqian Cao, Zheyu Fang. Single-Photon Compressive Imaging Based on Residual Codec Network[J]. Acta Optica Sinica, 2020, 40(1): 0111022.