基于深度神经网络的迷彩目标发现仿真学习方法  下载: 1153次

下载: 1153次

ing at the problem of serious lack of effective samples in the automatic discovery of camouflage targets, a simulation training method is proposed based on the sample simulation of a deep neural network and the technical idea of AlphaGo. A simulation synthesis model of camouflage scenes is established. The compound algorithm in the image space, the deep feature extraction strategy of scene images, the measurement strategy of target fusion degree, and the sampling algorithm for graph clustering are designed, respectively. Thus the representative samples for camouflage scene simulation are batch generated, which can be used for the deep neural network training and learning. Moreover, a discovery model of camouflage targets is designed based on a deep residual neural network, in which a multi-scale network training strategy is considered. The experimental results on the simulated samples and real scene images show that the proposed method can be effectively used for the automatic discovery and evaluation of camouflage targets.

1 引言

战场环境中,为了提高**目标的生存概率,会对**目标采取一定的伪装措施。战场形势瞬息万变,战机稍纵即逝,因此,在战场上快速地发现敌方**目标具有重要意义[1-2]。目前,常用的目标特征识别手段包括多光谱成像[3-4]、偏振成像[5-7]和可见光图像处理等,其优势特点各异。

可见光图像处理方法主要模拟人眼视觉机制,并从图像特征分析的角度进行迷彩目标识别与评估。崔宝生等[8]提出从图像像素统计、形状和纹理3个方面筛选提取特征量,并利用反向传播(BP)神经网络建立了伪装效果量化评估模型;许卫东等[9]利用斑点形状、尺寸、颜色亮度和空间分布等方面的纹理特征定量分析伪装器材遮障面,并比较目标与背景图像间的纹理特征相似度的方法;林伟等[10]提出了基于图像特征与心理感知量的伪装效果评价方法;王鹏烨[11]等研究了基于图像修复技术的目标可见光伪装效果评价方法。

但由文献资料可知,目前的迷彩目标特征识别分析主要基于可见光图像特征提取+辨别模型的技术手段。随着深度学习技术的提出和不断发展[12],深度神经网络在图像分类和识别上的性能优势已逐渐得到显现。Krizhevsky等[13]利用卷积神经网络在图像分类竞赛中取得重大突破;He等[14]提出了一种残差学习框架实现了高深层次的网络优化;Huang等[15]通过稠密卷积神经网络,将每一层与之前所有层相连接,可实现更好的训练效率和精度。目前,基于深度神经网络的图像处理方法几乎全面整体地超越了传统的图像处理手段。而对于伪装迷彩目标的发现识别来说,有效地运用深度神经网络技术进行建模研究显得尤其重要。

然而,深度神经网络需要大量的标注样本进行训练后才能有效工作,但对于迷彩目标的发现识别而言,由于受场景条件、**管理等因素所限,不可能借助直接采集样本的方式获取足够量的可训练真实场景样本数据。为此,本文提出一种基于伪装迷彩目标发现的仿真深度学习新方法,主要考虑利用极少量的真实样本,通过在样本空间中仿真模拟训练样本的方式,实现深度神经网络的有效学习。

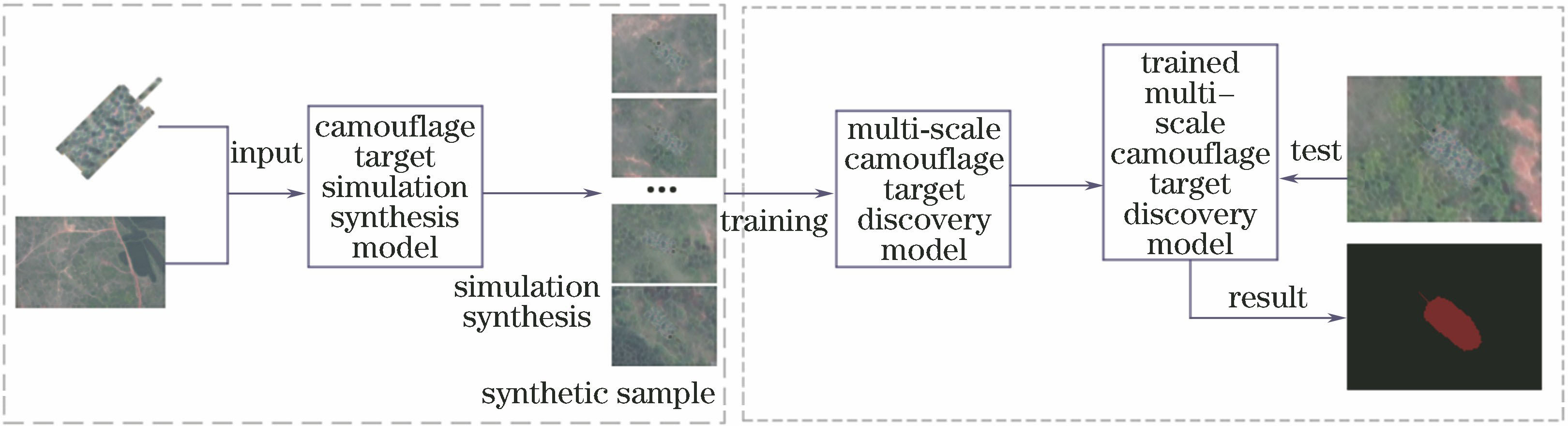

2 模型方法

研究设计的仿真深度学习模型分为两个部分:1)迷彩目标仿真合成模型,利用有限的真实样本,在样本空间中仿真合成大量有效训练样本;2)迷彩目标发现神经网络模型的设计与训练,通过设计语义分割的深度神经网络模型,并利用第一部分中所生成的仿真样本,对网络模型进行训练学习。相应的方法框架如

图 1. 迷彩目标发现的仿真学习框架

Fig. 1. Simulation learning framework for discovery of camouflage targets

2.1 迷彩场景图像仿真模型

受多方面条件所限,大批量地获得战场环境下的真实迷彩场景图像极为困难,而大批量的样本图像又是有效训练深度神经网络模型必不可少的。因此,考虑使用极少量的真实场景图像,借助仿真合成的方式,生成大量可用的训练样本。相应的模型框架如

计算的关键点在于如何从随机生成的大量候选仿真样本集中选取出更具真实性的仿真场景图像,为此提出了图聚类采样和融合度等级均衡两个策略。具体地,模型中考虑从真实场景图像中分离出目标,然后将其与场景背景在图像空间进行随机变换融合。使用上述策略生成候选仿真样本,计算其图像深度特征向量,再在图像相似性空间进行聚类采样,同时计算采样后的每个候选仿真样本中目标的融合度,并依据不同融合等级随机均衡地筛选出具有代表性的迷彩场景仿真样本集。相应的示意结果如

2.1.1 迷彩目标融合变换

为了增加迷彩目标的仿真合成的多样性,考虑对迷彩目标进行多种变换策略,除了尺度对齐要求,研究中主要考虑空间位置变换、姿态角度变换以及光照明暗度的均衡等3类变换策略。

空间位置变换和姿态角度变换是二维几何变换中的平移和绕任意点的旋转变换。此外,由于场景中存在不可放置迷彩目标的区域,因此在空间位置的变换操作中,引入可放置区域预识别处理策略,去除这部分不合理的区域,提升仿真样本的真实度。使用航拍视角的灌木层、水面、马路、草地、土地等不同区域的图像数据集训练标准化的卷积神经网络模型,利用训练后的模型通过较小尺度扫描搜索的方式,对较大的场景图像进行区域处理。

图 4. 可放置目标场景区域预处理。(a)原场景图;(b)预处理二值图

Fig. 4. Preprocessing of scene area in which target can be placed. (a) Original scene map; (b) preprocessed binary map

为了使迷彩目标更具融合真实性,引入迷彩目标与背景的光照明暗度一致性策略,采用直接调节色相、饱和度和数值(HSV)颜色空间中

式中:

2.1.2 候选仿真样本采样

由于初始的场景仿真合成具有很大的随机性,产生样本图像的均衡性、代表性较差。为了进一步选出具有代表性的样本图像,提出基于图聚类的采样算法。算法主要过程为:采用VGG-16深度神经网络模型[12]对每个仿真场景图像及相应纯背景图像提取特征向量,并基于实验对比分析,给出任意两个仿真场景样本图像间的特征距离的定义

式中:

对于同一组目标与背景随机生成的一批候选样本图像(实验中设置为2500),基于上述图象间的特征距离的定义,采用最近距离优先的策略,构建这些候选样本图像的近邻关系图结构。其中,对于每个候选样本图像,筛选出近邻节点的策略为

式中:

通过计算每个仿真样本图像的目标融合度进行不同融合度等级的样本均衡。每个仿真样本图像的目标融合度直接定义为

2.2 迷彩目标发现模型

2.2.1 迷彩目标发现的深度神经网络模型结构

为了能够快速、准确地发现迷彩目标,并精准地锁定迷彩目标的位置,提出了一种基于图像语义分割的迷彩目标发现模型。该模型主要是以深度卷积神经网络为主体,采用一个多层卷积神经网络,以及并行的空洞卷积层结构。

受残差神经网络启发,把Resnet101深度残差神经网络的部分残差模块中的卷积操作修改为带有空洞的卷积操作,添加带有空洞的卷积层,可以有效地扩大感受野,从而保留更多的原始图像中的信息,提高模型的性能。

由于迷彩目标种类的多样性,其形状和大小各有不同,为了能够更有效地发现不同大小的迷彩目标,使用一个并行结构,在给定的输入上执行多个采样率的空洞卷积,以扩大网络的感受野。并行空洞卷积层中引入了一层图像级特征层,图像级特征层的处理过程为:采用全局平均池化对输入的特征向量进行处理,将得到的图像级特征输入到卷积层中,计算得到一个特征向量,然后将特征向量进行双线性上采样到特定的空间维度,该过程主要为了能够充分获取整个图像级的语义特征,以保留整个图像的完整语义信息。其网络结构如

2.2.2 多尺度模型

为提升模型性能,引入多尺度模型训练方法,对每一个图像采用多个尺度的目标发现模型进行多次学习,最后融合多个尺度的学习结果得到该图像的每一个像素属于每类的语义类的概率分布,获取其对应的语义类别标签。研究中,在原图像大小的基础上,分别以原图像大小的50%、75%和100%作为3个尺度,输入到目标发现模型中进行训练学习,将3个不同尺寸大小的训练结果通过concat函数融合成一个向量,对这个向量的每个维度求最大值,用每个维度的最大值生成的向量表示最终的输出结果。相应模型结构如

3 实验及结果分析

3.1 实验设计

3.1.1 迷彩目标发现模型训练

通过反向传播和随机梯度下降法[18-20]对迷彩目标发现模型进行端到端的训练。在训练过程中对输入图像进行多尺度变换,可以有效提高模型的最终准确性。采用DeepLab-Resnet预训练模型作为初始模型。模型训练过程中,初始的学习速率设置为0.001,对整个目标发现模型进行10000次迭代训练;随后将学习速率缩小至0.00025,继续进行10000次迭代训练。

3.1.2 实验数据集建立

实验中,基于采集得到的70张真实场景下带有迷彩目标的图像,对这70张真实图像进行人工处理,抠出其中10个具有代表性的迷彩目标作为仿真模型的目标输入,同时选取一批纯背景图像作为仿真场景背景输入素材。基于前文所述方法形成了36000张有效的仿真样本图像,并对其进行了目标区域语义标注。由于仿真样本生成中已知有明确的原始背景,因此标注过程可直接通过图像域异或操作实现。

在36000张仿真生成的样本数据集中,选取30000张作为训练数据集;选取4000张作为模型训练时的验证数据集;选取剩余的2000张样本图像,加上除用于仿真生成模型素材的10张外的60张真实场景图像作为测试数据集。

3.1.3 评价指标

为了定量地评价整个模型对迷彩目标的发现性能,每个像素点作为计量单位,统计迷彩目标像素点的分类结果,计算目标像素点的发现精度(

式中:

3.2 实验结果

评估文中提出的多尺度模型对模型的性能影响。

表 1. 不同尺度参数下所提方法的性能结果

Table 1. Performance results obtained by proposed method at different scale parameters%

|

分析实验结果可以得出,与其他尺度模型对比,3种不同尺度叠加的模型中,迷彩目标发现的3个指标均有所提高,网络模型达到更好的效果。

与其他算法对比,所提方法的效果达到了较好的准确率,并与全卷积神经网络(FCN)[21]、Pix2Pix[22]作对比分析,如

表 2. 不同方法的迷彩目标发现性能结果

Table 2. Discovery performance results of camouflage targets obtained by different methods%

|

为更实际地测试模型结果性能,对单独测试用的60张真实迷彩场景图像进行性能评估。这60张场景图中,经专家人工判读迷彩等级为优、良、差的分别为25、18和17张。相应的实验测试结果如

表 3. 一组真实场景图像上的模型性能结果

Table 3. Model performance results obtained on a group of real scene images%

|

由

为进一步可视化地呈现实验结果,给出了如

图 7. 典型迷彩目标发现输出实验结果。(a)(c)测试输入图像;(b)(d)对应的模型测试输出

Fig. 7. Experimental discovery output results of representative camouflage targets. (a)(c) Test input images; (b) (d) corresponding model test outputs

4 结论

针对仅有少量有效样本情况下的迷彩目标发现,提出了深度神经网络的仿真学习方法。通过设计有效的仿真样本生成模型,以及迷彩目标发现的深度神经网络模型,并引入多尺度模型结构,有效地实现了一种新型的迷彩目标自动化发现模型。实验结果显示了新模型的优良性能,初步研究表明,在深度神经网络和仿真增强学习等新技术手段下,传统的迷彩设计与迷彩目标发现策略将面临新的挑战。

[1] 张海瑞, 李彦彬, 邢瑞康, 等. 基于集对分析的防空导弹装备红外伪装能力评估[J]. 激光与光电子学进展, 2018, 55(7): 070402.

[2] 郭彤, 华文深, 刘恂, 等. 一种基于高光谱的光学伪装效果综合评价方法[J]. 激光与光电子学进展, 2016, 53(10): 101002.

[3] 白雪琼, 廖宁放, 黄浩, 等. 基于色差和光谱特性的海面船只隐身效果评估[J]. 激光与光电子学进展, 2018, 55(9): 093301.

[4] 蔡伟, 伍樊成, 杨志勇, 等. 磁光调制技术与应用研究[J]. 激光与光电子学进展, 2015, 52(6): 060003.

[5] 王田, 牛明生, 步苗苗, 等. 可调光程的差分偏振成像系统及其特性研究[J]. 光学学报, 2017, 37(7): 0711001.

[6] 陶菲, 宋茂新, 洪津, 等. 基于离轴三反的同时全偏振成像仪的偏振定标方法[J]. 光学学报, 2018, 38(9): 0912005.

[7] 王小龙, 王峰, 刘晓, 等. 荒漠背景下典型伪装目标的高光谱偏振特性[J]. 激光与光电子学进展, 2018, 55(5): 051101.

[8] 崔宝生, 薛士强, 姬艳军, 等. 图像特征的伪装效果评估技术[J]. 红外与激光工程, 2010, 39(6): 1178-1183.

[9] 许卫东, 吕绪良, 陈兵, 等. 一种基于纹理分析的伪装器材效果评价模型[J]. 兵工学报, 2002, 23(3): 329-331.

[10] 林伟, 陈玉华, 王吉远, 等. 基于图像特征与心理感知量的伪装效果评价方法[J]. 兵工学报, 2013, 34(4): 412-417.

[11] 王鹏烨, 赵德辉, 李明锋. 基于图像修复技术的目标可见光伪装效果评价[J]. 激光与光电子学进展, 2018, 55(3): 031011.

[12] 张荣, 李伟平, 莫同. 深度学习研究综述[J]. 信息与控制, 2018, 47(4): 385-397, 410.

Zhang R, Li W P, Mo T. Review of deep learning[J]. Information and Control, 2018, 47(4): 385-397, 410.

[14] He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2016: 770- 778.

[15] HuangG, LiuZ, Maaten L V D, et al. Densely connected convolutional networks[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2017: 2261- 2269.

[16] 辛宇, 杨静, 谢志强. 基于随机游走的语义重叠社区发现算法[J]. 计算机研究与发展, 2015, 52(2): 499-511.

[17] 王勇, 唐靖, 饶勤菲, 等. 高效率的K-means最佳聚类数确定算法[J]. 计算机应用, 2014, 34(5): 1331-1335.

[18] 安喆, 徐熙平, 杨进华, 等. 结合图像语义分割的增强现实型平视显示系统设计与研究[J]. 光学学报, 2018, 38(7): 0710004.

[19] 李素梅, 雷国庆, 范如. 基于双通道卷积神经网络的深度图超分辨研究[J]. 光学学报, 2018, 38(10): 1010002.

[20] 孙汉卿, 庞彦伟. 一种自学习不确定度的神经网络架构[J]. 光学学报, 2018, 38(6): 0620002.

[21] LongJ, ShelhamerE, DarrellT. Fully convolutional networks for semantic segmentation[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2015: 3431- 3440.

[22] IsolaP, Zhu JY, Zhou TH, et al. Image-to-image translation with conditional adversarial networks[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2017: 5967- 5976.

[23] Goodfellow IJ, Pouget-AbadieJ, MirzaM, et al. Generative adversarial nets[C]∥Advances in Neural Information Processing Systems, 2014: 2672- 2680.

卓刘, 陈晓琪, 谢振平, 蒋晓军, 毕道鹍. 基于深度神经网络的迷彩目标发现仿真学习方法[J]. 激光与光电子学进展, 2019, 56(7): 071102. Liu Zhuo, Xiaoqi Chen, Zhenping Xie, Xiaojun Jiang, Daokun Bi. Simulation Learning Method for Discovery of Camouflage Targets Based on Deep Neural Networks[J]. Laser & Optoelectronics Progress, 2019, 56(7): 071102.