基于深度学习的行人属性识别  下载: 1526次

下载: 1526次

1 引言

行人属性识别[1]旨在挖掘监控场景中行人可被观察到的一些高级语义信息,如性别、年龄、服饰、携带品等。通常,这些信息可通过人工观察的方式进行提取,这会导致工作量巨大且十分耗时。行人属性识别可以无需人工操作地将这些信息转换成可以用于检索的高级语义信息。目前,行人属性识别存在2个主要的挑战。1)模型将背景区域特征误判为某个属性的特征,从而产生一定的特征提取损失;2)行人间的互相遮挡会使模型混淆提取。

随着深度学习[2-3]在计算机视觉任务中的表现越来越出色,研究人员开始尝试利用卷积神经网络提取监控场景中行人图像的属性特征。卷积神经网络使用多层非线性变换进行自动特征提取,能更有效地表征行人图像的特征。

总体来说,国内外基于深度学习的行人属性识别算法有4种:1)对损失函数进行改进,以解决数据不平衡的问题;2)基于局部特征的行人属性识别方法结合了全局和细粒度部件的特征;3)基于注意力机制的属性识别方法;4)利用联合循环学习提取上下文信息,以辅助属性识别。李亚鹏等[4]通过加入正样本比例因子改进损失函数的方法使网络的性能得到提高。Li等[5]提出可用于学习不同属性间相关性的卷积神经网络模型DeepMAR。这两种算法均属于第一类算法,模型较为简单,难以进一步提升识别效果。Li等[6]使用poselet部件检测器得到分割后的行人部件,再将其与行人整体结合,提取深度特征进行行人属性识别,这种算法属于第二类算法,但该部件分割算法在监控场景中效果不佳。Liu等[7]提出一个基于注意力机制的深度网络HydraPlus-Net,这属于第三类算法,其能够捕获细节和局部特征,但模型参数较多且训练过程较为繁琐。Wang等[8]提出联合循环学习模型,该模型可挖掘属性上下文信息及属性间的相互关系,可提升识别准确率,属于第四类算法,但该模型复杂度较高,当训练集较小时,易出现过拟合现象。

除上述算法外,凌弘毅[9]使用知识蒸馏方法挖掘被丢弃的属性信息,以辅助属性识别,但被丢弃的属性样本非常少,准确率提升效果并不明显。知识蒸馏法常用于模型压缩,教师网络为复杂模型,学生网络为精简模型。教师网络可利用学习到的隐藏知识指导学生网络训练,实现“知识迁移”。针对行人属性识别现存的问题,受Song等[10]在研究行人再识别问题时所使用方法的启发,本研究提出基于背景抑制的行人属性识别方法。以残差网络[11-13]为基础网络,增加两个分支,辅助网络提取不同区域的特征,同时利用联合代价函数减小行人图像特征与背景区域特征的相似度,增大行人图像特征与人体区域特征的相似度,以此来减小背景对网络特征提取的影响。通过在公开数据集上的实验验证,所提方法能取得良好的识别效果。

2 行人属性识别网络构建

2.1 训练网络的整体结构

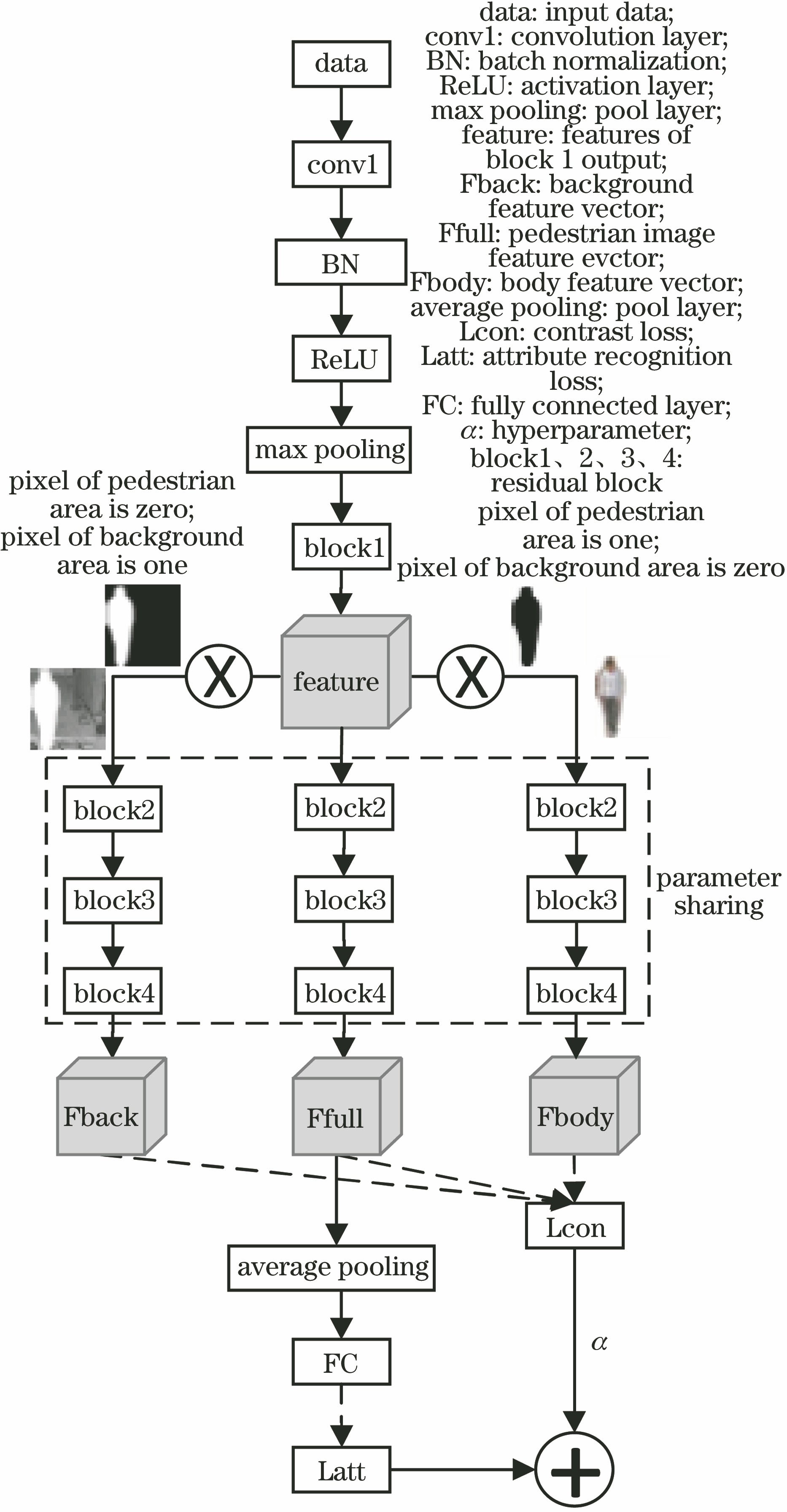

背景抑制的行人属性识别网络结构如

中间分支提取行人图像特征后通过全局平均池化层进行降采样,然后通过全连接层将网络提取的特征映射到样本标记空间中,最后通过加权交叉熵损失函数计算网络预测结果与真实标签之间的误差,该误差即为属性识别的损失。通过区域对比损失函数计算网络特征提取的损失,然后将两个损失按比例相加作为网络总的损失,再通过随机梯度下降算法对参数进行优化更新。block1、block2、block3、block4为四个残差块,具体实现细节可查阅文献[ 11],这里不再赘述。

2.2 残差块结构

残差网络[11]由何凯明团队提出,其在ILSVRC2015比赛中取得冠军,残差网络在前向网络中增加了一些快捷连接。这些连接会跳过某些层,将原始数据直接传到之后的层。这些连接即可称为残差块,结构如

2.3 人体区域及背景区域的特征提取

由于行人属性数据集中的图像分辨率较低,清晰度较差,以往很少有利用行人掩码来辅助提高识别准确率的属性识别方法。随着大量基于深度学习的图像分割算法[14-16]被提出,对行人掩码的提取成为一种可能。

图像分割分为语义分割和实例分割。语义分割是将图中每一点像素标注为某个类别,同一物体的不同实例不需要单独分割出来,相对于语义分割,实例分割则需要将每一个物体的不同实例分割开,如

图 3. 图像分割示例。(a)待分割图像;(b)语义分割结果;(c)实例分割结果

Fig. 3. Examples of image segmentation. (a) Image to be segmented; (b) result of semantic segmentation; (c) result of instance segmentation

如果要将行人与背景分离,并且无需对每个行人单独分割,可采用图像语义分割方法中较为经典的Deeplab-v2[14]算法进行行人掩码提取。对于数据集中少量错误提取的图像,可采用手工标注的方法提取掩码。

行人掩码为一个与行人图像等高等宽等通道的二值图像。将行人图像中人体区域的像素值置为1,背景区域的像素值置为0,即可获得行人掩码。人体区域特征提取如

1)对行人掩码进行尺度变换,使变换结果的维度与block1的输出维度相同。

2)将行人图像作为网络的输入,将尺度变换得到的行人掩码与block1输出的特征图相乘,得到人体区域的特征图。

3)将人体区域的特征图作为block2的输入,继续提取特征可得到人体区域特征。

背景区域特征提取方式与人体区域特征提取方式相似,利用一个与行人掩码等维度的全1矩阵减去行人掩码,得到一个人体区域像素值为0,背景区域像素值为1的二值图像,然后对其尺度变换,再将变换结果与block1输出的特征图相乘得到背景区域特征图,将其作为block2的输入,继续进行特征提取即可得到背景区域特征。

2.4 加权交叉熵损失函数

如果一张图片中出现某个属性,那么这张图片对于该属性为正样本,否则为负样本。在行人属性数据集中,每个属性的正样本和负样本数目相差很大,PETA[17]数据集就是其中一例。

对正负样本的损失乘以同样的权重系数,训练得到的网络会把大部分正样本预测成负样本。为了应对这种属性分布不平衡的问题,Li等[18]提出加权交叉熵损失函数,该函数可为每个属性的正负样本赋予不同的惩罚权重。当某个属性的正样本数目较少时,该函数可为该属性的正样本赋予一个较大的惩罚权重,同时可为该属性的负样本赋予一个较小的惩罚权重,即

式中:L为属性的个数;N为行人图像的数量;yn,l为第n个样本的第l个属性标签,yn,l∈{0,1},yn,l=1代表第n个样本包含第l个属性,反之不包含;pn,l为属性识别网络对第n个样本的第l个属性的预测结果;rl为第l个属性的正样本比率,即该属性正样本数目在训练集中所占的比率;wpos为第l个属性的正样本权重;wneg为负样本权重;σ设置为1。

2.5 区域对比损失函数

为了减小行人间的互相遮挡以及嘈杂的背景对属性识别带来的影响,引入区域对比损失函数,该损失函数以欧氏距离来衡量特征之间的相似度。

式中:m为一个超参数,指行人图像的特征向量与背景特征向量的欧氏距离;Ffull、Fbody、Fbackground均为由网络提取的2048维的特征向量,表征行人图像、人体区域、背景区域的特征。

2.6 联合代价函数

为了在完成属性识别的同时,提高网络在嘈杂背景下特征提取的稳定性,减小背景影响,可将加权交叉熵损失函数和区域对比损失函数联合作为网络的损失函数,即

式中:α为一个超参数,用来控制区域对比损失函数在整体损失中所占的比例;Latt为加权交叉熵损失函数计算的行人属性识别的损失;Lcon为区域对比损失函数所计算的网络特征提取的损失。

3 实验与结果分析

3.1 行人属性数据集

PETA数据集包含19000个行人图像,分辨率最小为17×39,最大为169×365,每个行人用61个二分类属性标签和4个多分类属性标签进行标注。由于某些属性的正样本数量极少,所以大多数方法主要还是关注35个正样本比例较高的属性。该数据集中9500个行人图像用于训练,1900个行人图像用于验证,7600个行人图像用于测试,在本实验中,将训练集与验证集合并用于训练。RAP[19]数据集包含41585张图片,其中33268张图片用于训练,其余图片用于测试,分辨率范围从36×92到344×554,每个行人用69个二分类属性标签和3个多分类属性标签进行标注。对于RAP数据,大多数方法只关注其正样本比例较大的51个属性。

经过对数据集的观察发现,PETA数据集存在一个问题,即该数据集中一个行人存在多张图像,仅通过随机选择一个示例图像进行一次注释,然后对该人的多张图像共享相同的注释属性,会造成一些图像的标签存在错误,如

表 1. 行人图像标签及属性比例

Table 1. Label of pedestrian image and the ratio of attribute

|

3.2 参数初始化及数据预处理

本实验在构建属性识别网络时使用的深度学习框架是PyTorch。不同于大多数深度学习框架,PyTorch在运行期间是使用反向模式自动微分来构建计算图表的。

由于行人属性数据集的数据量较小,而

1)去除预训练模型参数中全连接层的参数。

2)利用该参数对属性识别网络的conv1层及block1、block2、block3、block4块进行参数初始化。

3)全连接层使用均值为0、标准差为0.01的高斯分布进行随机初始化。

在训练前需要对数据进行预处理(如尺度变换、随机水平翻转、数据归一化操作等)。随机水平翻转会随机产生一个0到1的数,然后判断该数是否小于0.5,若小于0.5,则将行人图像与行人掩码翻转,若大于等于0.5,则不进行翻转。在测试时,只需要作尺度变换及数据归一化操作。

3.3 评估标准

Deng等[17]采用平均精度(EmA)来评估属性识别算法。对于每个属性,分别计算正样本和负样本的分类准确度,然后将它们的平均值作为属性的识别结果,最后,通过对所有属性取平均值来获得识别率。平均精度的表达公式为

式中:NTPi和NTNi分别为正确预测的正样本和负样本的数量;Pi和Ni分别为正样本和负样本的数量。

Yu等[20]将上述标准称为基于标签的评估标准,并提出基于实例的评估标准。基于实例的评估标准包括四个指标,即准确度、精确度、召回率和F1值,计算方法分别为

式中:N为样本的个数;Yi为样本xi的标签;f(xi)为样本xi经过网络预测的结果。

3.4 实验结果与分析

在训练网络时,采用随机梯度下降法(SGD)优化网络,将初始学习率设置为0.001,每经过50次迭代,将学习率乘以0.1,迭代120次后网络能够达到良好的效果。动量和权重衰减因子根据经验设置为0.9和0.0005。在测试阶段,只使用

采用3种实验。实验1,使用

在PETA和RAP两个数据集上实验,结果分别如

表 2. PETA数据集的实验结果

Table 2. Experimental results of PETA dataset%

|

由

表 3. RAP数据集实验结果

Table 3. Experimental results of RAP dataset%

|

由

图 5. 训练过程中区域对比损失函数的变化趋势

Fig. 5. Variation trend of regional contrast loss function during training

对单张图像进行测试,结果如

4 结论

提出基于背景抑制的行人属性识别方法。通过改进残差网络,并引入区域对比损失函数和加权交叉熵损失函数,网络提取的特征会集中于人体区域,能减小背景对于行人属性识别的影响,强制网络提取的特征具有一定的背景杂乱不变性,从而提高属性识别效果。实验结果表明,与现有方法相比,所提方法具有较好的性能。但所提模型仍然存在一些不足,如图像语义分割方法是独立地对行人图像进行掩码提取的,后续可以将掩码的提取过程整合到行人属性识别的网络中,实现一个端到端的网络,以进一步提高网络的性能。

[1] WangX, Zheng SF, YangR, et al. ( 2019-01-22)[2019-04-18]. https:∥arxiv.gg363.site/abs/1901. 07474.

[2] 赵建堂. 基于深度学习的单幅图像去雾算法[J]. 激光与光电子学进展, 2019, 56(11): 111005.

[3] LeCun Y, Bengio Y, Hinton G. Deep learning[J]. Nature, 2015, 521(7553): 436-444.

[4] 李亚鹏, 万遂人. 基于深度学习的行人属性多标签识别[J]. 中国生物医学工程学报, 2018, 37(4): 423-428.

Li Y P, Wan S R. Multi-label recognition of pedestrian attributes based on deep learning[J]. Chinese Journal of Biomedical Engineering, 2018, 37(4): 423-428.

[5] Li DW, Chen XT, Huang KQ. Multi-attribute learning for pedestrian attribute recognition in surveillance scenarios[C]∥2015 3rd IAPR Asian Conference on Pattern Recognition (ACPR), November 3-6, 2015, Kuala Lumpur, Malaysia. New York: IEEE, 2015: 111- 115.

[6] Li YN, HuangC, Loy CC, et al. Human attribute recognition by deep hierarchical contexts[M] ∥Leibe B, Matas J, Sebe N, et al. Computer vision-ECCV 2016. Lecture notes in computer science. Cham: Springer, 2016, 9910: 684- 700.

[7] Liu XH, Zhao HY, Tian MQ, et al. HydraPlus-Net: attentive deep features for pedestrian analysis[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 350- 359.

[8] Wang JY, Zhu XT, Gong SG, et al. Attribute recognition by joint recurrent learning of context and correlation[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 531- 540.

[9] 凌弘毅. 基于知识蒸馏方法的行人属性识别研究[J]. 计算机应用与软件, 2018, 35(10): 181-184, 193.

Ling H Y. Pedestrian attribute recognition based on knowledge distillation[J]. Computer Applications and Software, 2018, 35(10): 181-184, 193.

[10] Song CF, HuangY, Ouyang WL, et al. Mask-guided contrastive attention model for person re-identification[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 1179- 1188.

[11] He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 770- 778.

[12] 李净, 管业鹏. 基于深度学习行人属性自适应权重分配行人再识别方法[J]. 激光与光电子学进展, 2019, 56(14): 141003.

[13] 张超, 陈莹. 残差网络下基于困难样本挖掘的目标检测[J]. 激光与光电子学进展, 2018, 55(10): 101003.

[14] Chen L C, Papandreou G, Kokkinos I, et al. DeepLab: semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834-848.

[15] 裴亮, 刘阳, 高琳. 结合全卷积神经网络与条件随机场的资源3号遥感影像云检测[J]. 激光与光电子学进展, 2019, 56(10): 102802.

[16] 郭呈呈, 于凤芹, 陈莹. 基于卷积神经网络特征和改进超像素匹配的图像语义分割[J]. 激光与光电子学进展, 2018, 55(8): 081005.

[17] Deng YB, LuoP, Loy CC, et al. Pedestrian attribute recognition at far distance[C]∥Proceedings of the ACM International Conference on Multimedia-MM '14, November 3-7, 2014, Orlando, Florida, USA. New York: ACM, 2014: 789- 792.

[18] Li DW, Chen XT, ZhangZ, et al. Pose guided deep model for pedestrian attribute recognition in surveillance scenarios[C]∥2018 IEEE International Conference on Multimedia and Expo (ICME), July 23-27, 2018, San Diego, CA, USA. New York: IEEE, 2018: 18163829.

[19] Li DW, ZhangZ, Chen XT, et al. ( 2016-04-27)[2019-04-18]. https:∥arxiv.gg363.site/abs/1603. 07054.

[20] YuK, LengB, ZhangZ, et al. and localization[J/OL]. ( 2016-11-17)[2019-04-18]. https:∥arxiv.gg363.site/abs/1611. 05603.

[21] SudoweP, SpitzerH, LeibeB. Person attribute recognition with a jointly-trained holistic CNN model[C]∥2015 IEEE International Conference on Computer Vision Workshop (ICCVW), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 329- 337.

Article Outline

袁配配, 张良. 基于深度学习的行人属性识别[J]. 激光与光电子学进展, 2020, 57(6): 061001. Peipei Yuan, Liang Zhang. Pedestrian Attribute Recognition Based on Deep Learning[J]. Laser & Optoelectronics Progress, 2020, 57(6): 061001.