编码摄像  下载: 3183次特邀综述

下载: 3183次特邀综述

1 引言

视觉信息的获取是人类认识客观世界、发现自然科学现象、揭示自然科学规律的主要途径,与听觉、嗅觉和味觉等其他感觉相比,视觉可以通过感知光学信号的光强和色彩变化来获得更为直观和丰富的信息。在人类接受的所有信息中,大约有70%来自视觉[1]。随着人类对自然世界探索的需求更加深入与丰富,对场景迫切需要更全面、更复杂的信息感知。然而,受物理、噪声等因素的限制,传统光学系统的信息传递效率存在瓶颈。编码摄像通过调制光照、光路、传感器等方法,对场景高维视觉信息进行耦合采集,打破传统摄像中“所见即所得”的约束,提高成像系统信息传递效率,使传统摄像中不可能实现的或实现代价过高的任务成为可能。

1.1 编码摄像的发展

编码摄像是研究摄像技术的前沿热点方向,是新一代摄像技术,之前经历过模拟摄像和数字摄像两个阶段。模拟摄像阶段从1837年达盖尔发明“银版摄像术”开始[2-3],到1969年维拉·波义耳和乔治·史密斯发明CCD(电荷耦合元件,Charge coupled device)[4]结束。相机的发明使人类不仅可以记录生活,拍摄电影,也可以记录人眼分辨不了的各种信号,对物理光学的发展起到了重要的推动作用。第二阶段是数字摄像阶段,从1969年CCD出现,经过1975年史蒂芬·沙森发明数码相机,一直到20世纪90年代。数码相机可以直接将光信号转换成数字信号进行处理,增强了人类对光信号的处理能力,借助库利和图基提出的快速傅里叶变换算法[5]等高效数字信号处理方法,摄像系统、摄像方式得到全面发展,摄像的应用领域更加广泛,数字显微镜[6]等一系列重要光学器件和技术都是在这一阶段诞生的。第三阶段就是从20世纪90年代开始发展的编码摄像阶段[7-8],也是本文着重介绍的部分。

1.2 编码摄像的目标

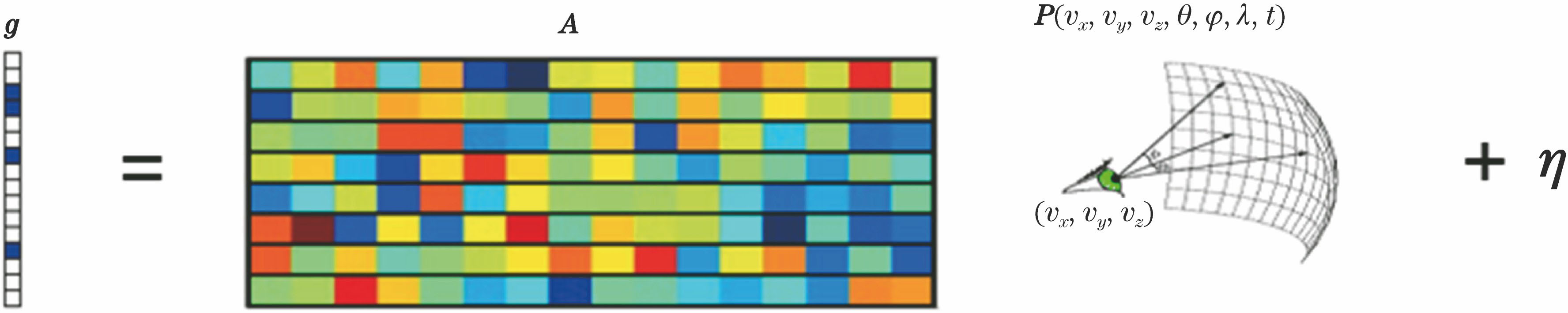

光信号作为一种分布在空间中的电磁场,可以用7维全光函数P(vx,vy,vz,θ,φ,λ,t)来表示[9],其中vx、vy、vz为视点即观察者的空间位置,θ、φ为场景点相对于视点的角度,λ为所采集光线的光谱信息,t为视点对光线进行捕获的时刻。传统的数字摄像方法中,采集的数据I是高维光信号的一个二维投影的采样I(x,y)=TprojP,其中Tproj是投影变换函数,丢失了多个维度的信息,受到几何光学机制和有限采样率带来的景深、分辨率等因素影响,成像能力有限,导致对场景的理解和分析也受到限制。而从物理光学的角度来看,光信号的偏振、相位等信息也会在传统摄像过程中丢失,从而限制了数字摄像在生物医学、材料等重要领域中的应用。为了克服这些问题,一种典型的方式是成像系统通过扫描采集多维高分辨率的场景信息。但通过扫描采集的二维图像重建高维场景,通常会产生大量的冗余信息,或者丢失部分信息,因此会降低信息的传递效率。比如激光扫描共聚焦显微(CLSM)为了获得更好的轴向分辨率,将非焦面出射的光全部通过针孔滤除。除此之外,这些设备往往复杂昂贵,成像速度慢,而且具有任务单一性。

对于给定的光学成像系统,瑞利衍射极限给出了成像面上物理能实现的最小分辨率,根据这个分辨率计算出该成像系统的自由度。对于尺寸为L的传感器平面,系统的光圈直径为D,焦距为f的情况下,其系统自由度S=

系统的自由度决定了其所能传递信息量的上限。受传感器的高斯白噪声、光信号的泊松噪声等干扰,以及信号采样率不足、信号间存在相关性等导致的信息冗余,都会导致系统信息传递效率不足,无法达到所传递信息量的理论上限。借助香农信息论对通信信道传输容量上限Cp=Bwlog2(1+RSN)进行分析,其中Bw为传输带宽,RSN为信噪比。通过编码等方式提高系统的信噪比和有效采样频率,减少信息冗余,可以大幅提高信息的传递效率,打破传统摄像中有限信道容量和复杂信号保真的矛盾,使高维度场景的高质量成像成为可能。随着编码摄像学的发展,有望获得更高维度、更多尺度,更为丰富、生动,更具有视觉表现力的视觉信息,为生命科学、医学、材料科学、计算机视觉、图形学等领域的发展提供新的手段与契机。

1.3 编码摄像的概况

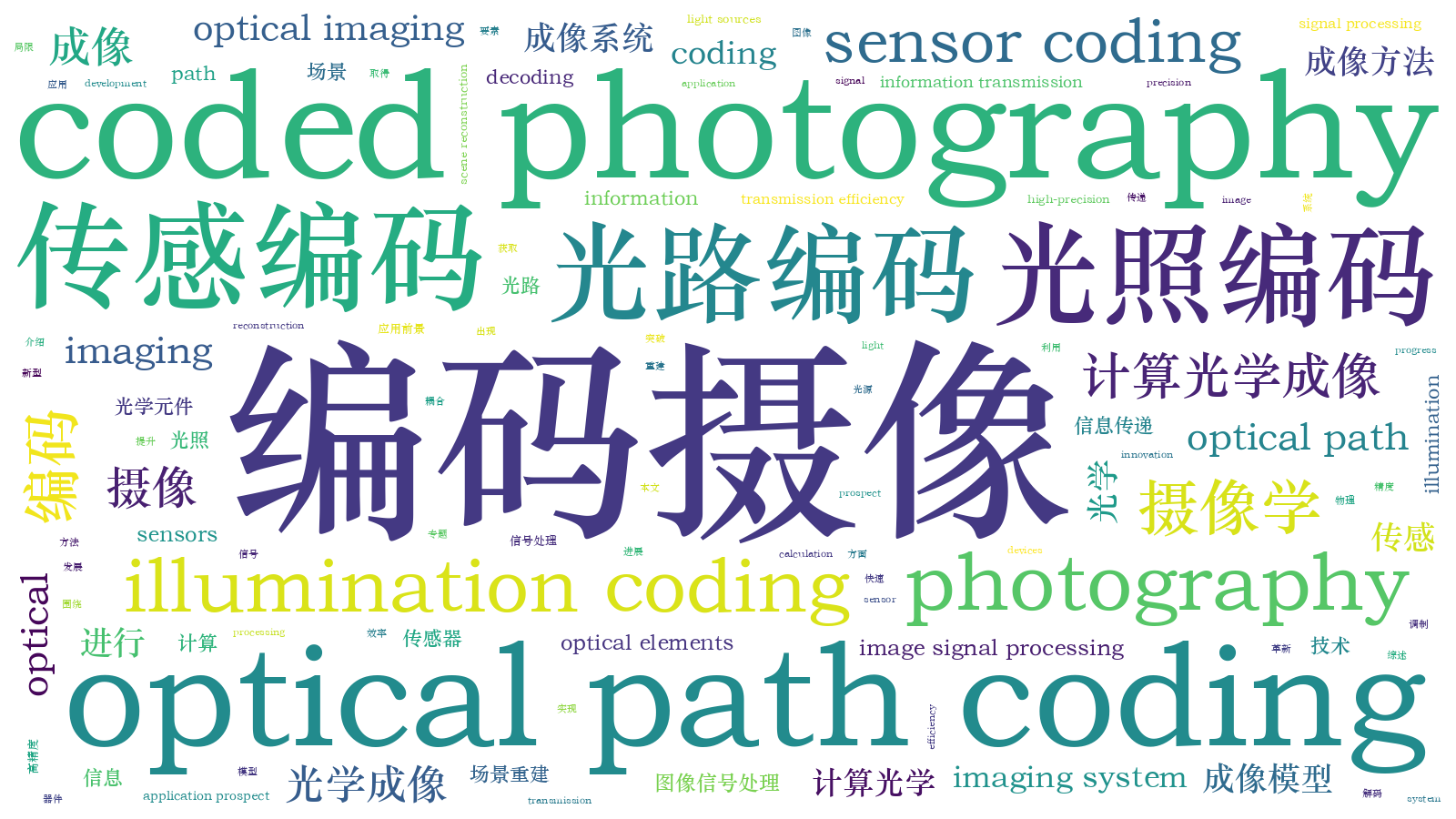

编码摄像对成像过程进行特定调制,实现场景信息的编码采集,所拍摄图像通常难以直接辨别,需要通过解码进行高维高分辨率重建。高维场景信号到低维采集信号的过程可以通过矩阵方程g=AP+η来表示,其中g为图像,A为编码矩阵,P为场景,η为噪声,如

本文主要围绕编码摄像中的光照编码、光路编码和传感编码三个方面进行讨论总结,

表 1. 典型的编码摄像方法

Table 1. Typical coded photography approaches

|

2 光照编码摄像

传统摄像模型是一个低通滤波模型,受限于系统孔径,场景的高频信息会被滤除。在不改变传统系统的光路、传感等模块情况下,通过仅对场景的光照进行编码,可增强系统对场景高频信息的获取能力,从而实现高分辨率重建。

傅里叶叠层显微(FPM)是一种典型的光照编码摄像方法,由Zheng等[12]在2013年提出。该方法通过15×15的LED阵列作为光源,依次点亮拍摄225张图,获得从225个角度入射的准相干光成像图。FPM的迭代重建过程如

利用FPM的定位成像能力,Tian等[13]在2015年成功将FPM光源编码摄像方法从对二维物体成像拓展到三维物体,使其能从一组二维图像中得到物体的三维强度和相位图,实验结果如

由于牛顿反传法要精确设置传播的参数,需较长的参数搜索时间,Zhang等[14]借鉴深度学习的优化思想,提出了一种基于梯度误差的反传方法,简化优化过程,同时获得清晰的三维物体图像。FPM算法通过将入射光的角度编码到所拍摄图像中,实现高分辨率、宽视场的2D或3D幅值和相位成像,但拍摄时间较长,不适用于动态物体。为解决这个问题,人们提出将多个角度的光复用在一起[33],及用单次成像获取多角度图[35]等方法,这些方法减少了图像采集时间,但图像质量也有对应的降低。为了解决系统传递效率问题,即采集时间和图像质量之间的矛盾,还需要进一步研究更高效率的编码方式。

结构光照明法也是一种典型的光照编码摄像方法[36-37],与FPM倾斜角度的照明光不同,结构光照明法基于叠珊条纹的思想,通过在物体上照射正弦干涉条纹,将物体的高频部分搬移到低频处,可将场景的分辨率提高1倍以上。

3 光路编码摄像

光路编码摄像是应用非常广泛的一类编码摄像方法。相比传统摄像模型,光路编码摄像通过在光路中加入额外的编码元件,提高系统的信息传递效率,实现高维高精度场景重建。其中,编码光圈摄像、散射编码摄像、光场编码摄像是最典型的3种方法。

3.1 编码光圈摄像

利用编码光圈对场景信息进行编码是最早提出的一种编码摄像方法,通过在光瞳处添加编码光圈,拍摄得到的图像具有空间不变性,可直接对系统的点扩展函数(PSF)进行调制。根据傅里叶光学[38]理论,在非相干光的照明下(如自然光),系统的点扩展函数XPSF,ori(x,y)=

由于不同深度的XPSF(x,y;ϕ)不同,用编码光圈进行深度估计是最直接的想法。虽然Pentland[39]在1987年提出了非编码的深度估计方法,即从两张不同模糊程度图像中提取深度。这种方法需要通过移动相机,在两个不同的位置拍摄到不同模糊程度的图像,并且该方法受噪声影响严重。由于编码能对数据进行更高效表示,耦合更多高维信息,Dowski等[7]提出利用单相机、单张图实现深度估计的方法,通过理论推导得出,要从采集到的图像I(x,y;ϕ)=M(x,y;ϕ)

式中v=

除了获得物体的深度信息,利用编码光圈还可解决传统的光谱成像中分辨率和进光量(直接影响到图像信噪比)之间的矛盾,提高信道的信噪比可获取物体更多的光谱信息。利用光学器件调制解决光谱成像缺陷的想法由来已久,Golay[42]于1949年就提出了用多缝元件替代光谱仪中的单缝元件,提高传统光谱仪的进光量、信噪比和成像速度。随后发现采用Hadamard矩阵进行编解码,可以获得更好的效果[43]。2006年,杜克大学的Gehm等[44]基于正交函数理论提出了一种新的静态编码模式,解决了漫反射物体进光量严重不足的问题,编码方式更简单,光路结构也更简单。2006年压缩感知理论[45]的兴起推动了编码光圈光谱成像技术的发展。压缩感知理论认为,如果信号在某些基上是稀疏的,可通过很少的几次非相干测量恢复出这个信号的完整信息。压缩感知技术本质上是通过测量矩阵降低信号的冗余,从而提升实际信号信噪比实现低采样率重建。与需要多次曝光采集编码或未编码的三维光谱数据(第三维坐标是波长)的光谱成像方法[46-47]相比,Gehm等[17]提出的双分散编码孔径快照光谱成像仪(DD-CASSI),只采集少量数据就可以通过算法重建出物体的三维光谱图。该方法的结构如

DD-CASSI的编码方式是将物体的空间和光谱信息耦合到一起,无法对于点光源进行成像(没有空间信息)。Wagadarikar等[48-49]发现用一个散射元件也能实现编码光圈光谱成像,装置如

随后,研究人员对编码方式进行进一步探索,希望获得更好和更高维度的信息。物体的光谱信息反映了物体的光吸收谱情况,是物体信息的一个重要维度。但是自然界中有20%的物体是能发出荧光的,传统光谱成像没有考虑物体的荧光信号对光谱的影响。Ji等[52]通过加入一个空间-光谱编码光圈,将物体的反射谱信号和荧光信号分开,获得了更丰富准确的物体信息。Rueda等[53]将单图像光谱成像能力和深度相机结合起来,可同时获得高光谱三维成像,还使用数字微镜器件(DMD)代替光学掩模版,能同时对空间和光谱进行编码,得到更好的重建结果[54]。

除此之外,基于编码光圈的编码摄像方法还可用于图像超分辨率[55],不需要参考光的全息成像[56],断层扫描成像[57]可以低成本实现普通相机功能[58]。该方法旨在提高编码效率的同时兼顾解码效果,通过单张图像实现高维场景信息的采集,如深度信息、光谱信息、相位信息。不过,该方法目前的成像质量还比不上传统特定任务成像设备的成像质量,更高重建质量的编码方式还有待进一步研究。

3.2 散射编码摄像

通常认为,散射介质会严重扰乱光的波前,破坏传统成像中的几何关系,从而严重影响图像质量。2007年,荷兰的Vellekoop等[59]研究人员突破性地发现,当散射介质的特性被预先测量后,它可以作为一个天然的光学器件,实现光的聚焦。在此之后,将散射介质作为编码器件对场景信息进行编码成为越来越常用的编码摄像方式。

与编码光圈不同,散射介质一般放在物体前或者物体后的位置,对从物体发出的波前进行编码。由于该编码大部分情况下不是位于光瞳处,即不具有线性位移不变特点,一般不能用PSF表示,而是一个对不同空间位置具有不同影响的扰动编码矩阵A,也被称为传输矩阵,有Eout=EinA,其中Ein为入射光场,Eout为出射光场。研究人员发现,这种编码方式可以实现原透镜10倍以上的聚焦能力[53],甚至可以实现100 nm以内的超衍射极限成像能力[54-55]。该编码装置的结构如

解码的方式通常有多种。第一种是将测量到的编码图像作为反馈,通过SLM迭代调制入射到散射介质前的波前,使光透过散射介质在焦面处聚焦。迭代算法一般使用遗传算法等启发式算法,然后通过二维振镜偏转入射光方向,在记忆效应[63-64]范围内,焦面处的焦点会随之进行线性平移,从而实现点扫描,最后重建拼接成一张图像。

利用记忆效应,甚至可以不使用SLM对入射波前进行预调制解码,也能够实现高质量成像。2012年,Bertolotti等[65]用散斑自相关的方法,最先实现了对一个完全不透明的散射介质后的荧光物体成像。但该方法需要采集多组图像,采集时间很长,无法处理动态物体。2014年,Katz等[18]提出了单张图片进行重建的方法,该方法成为之后基于记忆效应和散斑自相关算法做散射成像解码的基本步骤。但该方法同样受到记忆效应范围的限制,导致视场很小。Wang等[20]提出了一种基于能量分配的单次拍摄超记忆效应范围重建的解码算法,能将视场提高到原来的3倍。

为进一步提高视场,实现非相干光成像,Yilmaz等[66]提出一种新的方法,如

利用传输矩阵来近似散射介质对场景的编码过程也是一种常用的方法[19],实验装置如

![传输矩阵散射成像实验装置[19]](/richHtml/gxxb/2020/40/1/0111012/img_8.jpg)

图 8. 传输矩阵散射成像实验装置[19]

Fig. 8. Experimental setup of scattering imaging through transmission matrix[19]

以上散射介质编码摄像方法的优点有:1)收集更多的高频信息,提高成像的分辨率。实际分辨率与照到散射介质上的入射光面积正相关,不受透镜的数值孔径限制;2)没有焦距的概念,可以在任意深度进行全清晰成像;3)如果采用传输矩阵的方法进行解码,可以获得更大的成像视场。但缺点有:基于记忆效应的视场很小;基于传输矩阵的测量时间长;因为测量噪声等原因导致图像散斑不会在重建过程中完全消除。除此之外,由于波前调制设备的分辨率有限,散射介质对信息的压缩和解压缩过程往往是有损的,所以虽然能够实现超衍射极限成像,但是整体成像质量通常不如传统方法。

散射介质还可以与传统方法相结合,完成传统方法无法完成的任务。比如可以实现无参考光全息成像[74],解决结构光照明成像中结构光图案不准确导致成像效果变差的问题[75]。如结合压缩感知的方法,可以做到用更少像素的传感器重建二维图像[68],或者从单张图像中重建出三维物体[76]。与编码光圈不同,散射介质虽然可以做到更有效的多模态数据耦合,比如实现编码光圈所无法做到的超衍射极限成像,但光在散射介质中的传播情况还有待进一步研究,一个更加完备的理论还尚未成型。

3.3 光场编码摄像

光场摄像也是一种典型的光路编码方法。考虑光线在自由空间无衰减的传播,其波长、方向、强度都不会发生变化,这时全光函数从七维降至四维L(x,y,θ,ϕ),光场相机需要采集的就是场景的四维信息。由于不同角度的光会在像面会聚到同一点,采集到的图像是场景降维后的二维信息。通过加入微阵列透镜,将不同方向的光线分散到传感器不同位置,把特定角度信息编码到特定的子图中[21,77],光路原理如

2014年,Prevedel等[82]成功将光场编码摄像用于动态观察三维神经冲动信号,实现了在20 Hz的帧率下对700 μm×700 μm×200 μm范围的神经冲动进行实时成像。这种方法的优点是可以对C. elegans这种蠕虫的大脑进行运动中的完整成像,从而更好地研究神经信号的相关性,理解生物大脑的运作方式。

虽然上述情况仍然是用单张图成像,但可以通过使用相机阵列而直接拓展成多张图的方式,提高系统的自由度,做到更好的成像效果[83-84],单张图只是将一个传感器分成很多个部分进行编码的小型化版本。通过对采集的图像进行3D反卷积操作[85],或额外再加入相位掩膜板对波前进行调制[12],同样可以提高重建的四维图像质量。不过,即便如此,光场重建三维图像的分辨率依然比不上传统高分辨率扫描成像方法,将新型硬件设备和成像系统与最新的光场重建算法进行结合是一个未来可行的解决方案。

4 传感编码摄像

传统的图像传感器受像元尺寸和曝光时间等固有因素的影响,存在动态范围有限、信息冗余、帧率限制等问题。为获得高动态范围,可使用不同的曝光时间捕捉场景的多张图像,然后通过算法将不同曝光图像的最佳部分结合起来。但该方法要求场景静态,对于快速移动的物体,就没有很好的方法来组合不同的图像。同时,由于多张图像中存在冗余的场景信息,会降低系统的信噪比,限制信息的信道容量。为打破动态范围和时间精度等的限制,研究者设计了编码图像传感器和基于神经编码的动态视觉传感器。

4.1 编码图像传感器

CMOS图像传感器的曝光由行重置和行选择信号控制,行重置信号发出后,行地址解码器发出的行选择信号使每一行变得光敏,行选择信号发出后停止收集光子并开始读出数据。由于只有一行读出电路,所以不同行的读出时间不能重叠。编码摄像中,可以通过地址发生器对复位时间ts(y)和读出时间tr(y)进行控制。因此,不同行的曝光时间te(y)也可以进行变化。用E(x,y,t)表示场景点(x,y)在t时刻的亮度,h(x,y,t)表示相机的快门函数。计算得到的图像I(x,y)表示为

在传统的传感器里面,相机的快门函数是一维矩形函数。而编码传感将单个积分时间分解为多个块,从而引入运动去模糊的高频分量,将曝光时间编码进相机传感器,不同的像素区域对应不同的积分时间,然后联合编码进单张图像中,实现曝光时间内单次图像捕捉的高动态范围成像,同时解决因目标运动引入的图像模糊问题。

1997年,Kemeny等[86]提出了一种具有可编程多分辨率读出能力的新型128×128 CMOS编解码器。图像传感器将信号处理电路置于成像焦平面上,可以输出不同分辨率的数据,减少了后续图像处理的计算量。该电路使用无源开关电容网络来平均任意大的像素邻域,然后可以通过配置一组数字移位寄存器读出任何用户定义的分辨率,可实现80 dB的动态范围。

编码曝光相机阵列下高速运动连续捕捉的相关研究[87-88],经历了一维阵列到二维阵列的不断发展,通过牺牲部分空间分辨率来换取高时间分辨率。2006年,Raskar等[23]提出了一种基于编码颤振快门的去运动模糊方法,在选定的曝光时间内以二进制伪随机序列分别打开和关闭相机快门,在运动模糊中保留了运动物体的可解码细节,简化了图像去模糊过程。最后使用反卷积来计算其中运动和静止部分的清晰图像。该方法虽然将单个积分时间分解为多个块,从而引入了用于运动去模糊的高频分量,但由于编码对所有像素都是固定的,所以它实际上是一个编码的全局快门,快门函数是时间t的一维函数。Gu等[24]在2010年提出一种基于编码卷帘快门的编码摄像方法,如

2013年,Portz等[89]提出了一种基于编码采样的用单台低速摄像机捕获高速、高动态范围视频的新方法。该方法使用随机像素曝光时间和偏移量,利用视频中的时间和空间冗余,编码输入重构高速视频。2019年,Antipa等[90]使用多路复用光学来压缩场景,使关于整个场景的信息可以从一排传感器像素中采样,这些像素可以通过滚动快门CMOS传感器快速读取。通过一个简单的无透镜、基于扩散器的成像系统,可方便地实现这种多路复用。使用稀疏恢复方法,能够以超过4500帧/s的速度恢复140个视频帧。

2019年,Wan等[25]提出一种通过传感器编码结合后处理解码的联合处理框架,成为解决图像比特深度扩展的典型方案,基本思想来源于多重描述理论。当接收到的信号包含多于一个描述值或观测值,且每个值均包含该信号的部分信息时,组合来自多个描述的信息可以提高信号的重建精度。但是直接通过多重量化实现多描述的方法会导致图像传感器带宽显著增加。而这种联合处理框架不会增加信号传输带宽,还能形成有效的多描述,提高信号采集的精度。该方案先将待量化的原始模拟信号和在图像传感器中的嵌入式预设偏置信号(EQB)相加,然后将结果输入量化器量化,得到数字信号。在重建阶段,相邻像素的灰度量化值被用于对单个像素灰度值的高比特精度重构。

基于编码传感的编码摄像方法通过控制传感器中不同像素区域的曝光时间,将时空信息编码到采集的图像中,可以解决运动模糊问题,实现高动态范围成像。

4.2 神经编码视觉传感器

人类所看到的一切都来源于视网膜上形成的图像,该图像由视网膜上的1.26亿个感光细胞记录,然后被编码成一系列数字脉冲,通过连接眼睛和大脑的100万个神经元传输。人类感知系统可以适应自然界中瞬息万变的信息,并对那些出现频率高的信号进行有效的处理。1954年,Attneave[91]指出视觉感知系统能对输入信号进行有效的表示。1959年,Barlow[92]提出了有效编码假说,并在1989年进行了扩展[93],从香农信息论出发,认为在神经计算的过程中,一个重要的约束就是信息(编码)的有效性。初级感知系统的作用就是去除输入信号的统计冗余,也就是说,人脑之所以能够对外界环境自适应,就是因为,人脑的神经元能有效去除复杂的外界刺激中的冗余信息,从而利用较少的资源尽可能有效地表达更多的信息。有效编码假说合理解决了复杂的外部环境和有限的神经元个数之间的矛盾,对昆虫和脊椎动物视网膜的一系列实验验证了有效编码假说的正确性,因而它成为一种有效理解人类神经系统的理论工具。

在有效编码假说的框架下,研究人员提出了许多不同的编码模型。虽然这些方法各不相同,但能产生类似的结果。这些方法包括稀疏编码[94-96]、主成分与独立成分分析[97-98]、信息最大化[99]、冗余度压缩[100]和预测编码[101-102]等,其中稀疏编码逐渐成为神经编码理论的主流。

人类大脑中的大多视神经元对来自外界的激励的响应较小,即只有少部分的神经元反应比较强烈,这种现象被称为神经响应的稀疏性。根据稀疏性对自然图像中的目标进行有效编码的过程称为稀疏编码。早在1968年,Perkel等[94]就已经提出神经编码理论,解释了如何通过来自视网膜神经节细胞的脉冲序列来编码视觉世界,将神经反应已知刺激的平均值作为特征。1991年,Bialek等[103]提出了基于单个脉冲序列的实时刺激估算算法,应用于果蝇视觉系统中运动敏感神经元的识别。神经元的解码结构如

随着人们对生物神经系统的深入研究[105-111],计算神经科学在21世纪获得了进一步的发展。生物视觉的特性是基于事件的稀疏表示,因此在神经形态编码摄像中,动态视觉信息采用事件流信号的编码方法,如Rate coding(用神经元的发放率来表示刺激的信息)和Spike count coding(用一个时间段内的脉冲输出来表示刺激的信息),可以显著提高信息传递效率。

超大规模集成电路(VLSI)技术提供了一个可行的解决方案[112-114],通过把神经元的带宽(一般在10~1000 Hz之间)提高5个数量级,把成千上万的点对点连接用较少的金属线和许多开关代替,使用时分复用这些线来传输数据包,也就是基于事件的数据,建立了一种名为地址事件表示(AER)的数据传输协议。第一个AER视觉传感器由Mahowald[115]在1994年制造出来,这款硅视网膜包括自适应光感受器、空间平滑网络和定时通信。但这只是一款演示设备,不能用于任何现实世界的任务。2003年,Ruedi等[116]提出一种低成本的快速视觉传感器。在一个全局帧积分周期后,按照空间对比度从高到低顺序传输事件,每个对比度事件后跟随一个编码梯度方向的事件。该装置对比敏感度为2%,动态范围可达120°,但不能减少时间冗余,同时时间分辨率受帧率限制。后续的进展还包括Harris团队[26]的TTFS(Time-to-first-spike)和Time-based成像仪[117],Hafliger团队[118]的中央凹AER视觉传感器和Delbruck设计的双线光学瞬态传感器[119]。

2008年,第一款可以实际应用的动态视觉传感器(DVS)由Delbruck的团队[27]设计,采用生物视网膜模型中的双极性细胞和运动感知功能。传感器的分辨率为128×128,每个像素在空间上不相关,但会检测各自时域上的光强变化,其响应时间可以达到μs级。放弃帧的传输方式使这一类传感器具有了和生物视觉相似的三点关键特性:稀疏且基于事件的输出;相对亮度变化的表示方式;输出整流成正负两路信号。同时,输出数据速率取决于场景的动态内容,通常比传统基于帧的传感器低几个数量级。传感器的动态范围为120 dB,芯片功耗为23 mW。通过提供高像素带宽、宽动态范围和精确计时的稀疏数字输出,这款硅视网膜为不受控制光照条件下低延迟和轻量化后处理应用提供了一种有效的解决方案。

2011年,Posch等[120]提出异步基于时间的图像传感器(ATIS),结合基于事件的时域成像、时间对比动态视觉、异步基于事件的信息编码和数据通信,提高了传感器的动态范围,获得了静态时143 dB和运动时125 dB的场景内动态范围。2014年,动态主动像素视觉传感器(DAVIS)通过同时输出异步DVS事件和同步全局快门帧来提供对目标识别和分类任务有用的绝对强度信息[121],同时将分辨率提高到240×180,动态范围可以达到130 dB。随着集成电路技术的发展,许多性能更加优越的设备被推出,如带RGBW四颜色通道的Color-DAVIS[122],具有640×480分辨率的Samsung DVS[123]。

通过构建模仿视网膜的采集系统和模仿神经连接的信号处理系统,利用神经形态信号编码,可以获得如生物神经系统一样高效的视觉神经形态传感系统。与传统摄像方式相比,神经形态编码摄像具备实时、异步、高灵敏与极高动态范围的特点,可实现灵活、智能的场景信息获取方式,为编码摄像提供了全新的扩展空间。目前神经形态编码摄像仍然处于发展的初级阶段,随着对人类视网膜和大脑神经元结构和工作机理的进一步探索,该方法将更接近人类的视觉感知,具有广阔的应用前景。

5 结论

编码摄像发展主要归功于电子信息技术与光学工程的进步。信息论给了编码摄像理论指导,制定了成像系统信道容量的理论上限;计算、优化理论的不断创新为寻找更好的编解码方式、逼近理论上限提供了具体的实现途径;光学技术、光学元件制造工艺的发展将系统的自由度不断提升,从而提高了系统的理论上限。这三者相辅相成,成就了编码摄像理论和实践在这30年的发展。另一方面,近些年来,基于人工智能的图像信号处理技术的兴起为编码摄像的发展提供新的重要支撑。

编码摄像通过充分利用成像系统自由度,并剔除冗余信息,可提高有效带宽和信噪比,增强场景成像能力,甚至扩展新维度的成像能力,成为弥补物理层面局限的理想方式。编码摄像目前还存在编码效率不高、编解码产生信息损失、重建不稳定等一系列问题,使其在很多领域的应用受到了限制,例如医学领域最常用的还是荧光、共聚焦显微镜等传统成像方法。未来,编解码方法本身将不断完善,同时,智能图像信号处理在编码摄像领域也将扮演越来越重要的角色,编码摄像技术与系统将会具有非常广阔的应用前景。

[1] Sendra-NadalE, Carbonell-Barrachina Á A. Sensory and aroma marketing[M]. The Netherlands: Wageningen Academic Publishers, 2017.

[2] Mait J N. A history of imaging: revisiting the past to chart the future[J]. Optics and Photonics News, 2006, 17(2): 22-27.

[3] Mait J N, Euliss G W, Athale R A. Computational imaging[J]. Advances in Optics and Photonics, 2018, 10(2): 409-483.

[4] Janesick JR. Scientific charge-coupled devices[M]. Bellingham, WA: SPIE, 2001.

[5] Cooley J W, Tukey J W. An algorithm for the machine calculation of complex Fourier series[J]. Mathematics of Computation, 1965, 19(90): 297-301.

[6] HIROX. Product history[EB/OL].[2019-09-28]. https:∥www.hirox-usa.com/AboutUs/.

[7] Dowski E R, Cathey W T. Single-lens single-image incoherent passive-ranging systems[J]. Applied Optics, 1994, 33(29): 6762-6773.

[8] Dowski E R, Cathey W T. Extended depth of field through wave-front coding[J]. Applied Optics, 1995, 34(11): 1859-1866.

[9] AdelsonE. H, Bergen J. R. The plenoptic function and the elements of early vision[M]. Cambridge, MA: MIT Press, 1991.

[10] Lohmann A W, Dorsch R G, Mendlovic D, et al. Space-bandwidth product of optical signals and systems[J]. Journal of the Optical Society of America A, 1996, 13(3): 470-473.

[11] Neifeld M A. Information, resolution, and space-bandwidth product[J]. Optics Letters, 1998, 23(18): 1477-1479.

[13] Tian L, Waller L. 3D intensity and phase imaging from light field measurements in an LED array microscope[J]. Optica, 2015, 2(2): 104-111.

[14] Zhang Y B, Cui Z, Ji X Y, et al. 3D Fourier ptychographic microscopy based on the beam propagation method and time-reversal scheme[J]. IEEE Access, 2019, 7: 129402-129410.

[15] Levin A, Fergus R, Durand F, et al. Image and depth from a conventional camera with a coded aperture[J]. ACM Transactions on Graphics, 2007, 26(99): 70.

[16] Gehm M E, John R, Brady D J, et al. Single-shot compressive spectral imaging with a dual-disperser architecture[J]. Optics Express, 2007, 15(21): 14013-14027.

[17] Lin J Y, Lin X, Ji X Y, et al. Separable coded aperture for depth from a single image[J]. IEEE Signal Processing Letters, 2014, 12(12): 1471-1475.

[19] Popoff S, Lerosey G, Fink M, et al. Image transmission through an opaque material[J]. Nature Communications, 2010, 1: 81.

[20] Wang X Y, Jin X, Li J Q, et al. Prior-information-free single-shot scattering imaging beyond the memory effect[J]. Optics Letters, 2019, 44(6): 1423-1426.

[21] Park J H, Hong K, Lee B. Recent progress in three-dimensional information processing based on integral imaging[J]. Applied Optics, 2009, 48(34): H77-H94.

[22] Levoy M, Ng R, Adams A, et al. Light field microscopy[J]. ACM Transactions on Graphics, 2006, 25(3): 924-934.

[23] Raskar R, Agrawal A, Tumblin J. Coded exposure photography: motion deblurring using fluttered shutter[J]. ACM Transactions on Graphics, 2006, 25(3): 795-804.

[24] Gu JW, HitomiY, MitsunagaT, et al. Coded rolling shutter photography: flexible space-time sampling[C]∥2010 IEEE International Conference on Computational Photography (ICCP), March 29-30, 2010, Cambridge, MA, USA. New York: IEEE, 2010: 11553751.

[25] Wan P F, Tan J X, Lian X C, et al. High bit-depth image acquisition framework using embedded quantization bias[J]. IEEE Transactions on Computational Imaging, 2019, 5(4): 556-569.

[26] QiX, GuoX, Harris JG. A time-to-first spike CMOS imager[C]∥2004 IEEE International Symposium on Circuits and Systems (IEEE Cat. No. 04CH37512), May 23-26, 2004, Vancouver, BC, Canada. New York: IEEE, 2004: 824- 827.

[27] Lichtsteiner P, Posch C, Delbruck T. A 128×128 120 dB 15 μs latency asynchronous temporal contrast vision sensor[J]. IEEE Journal of Solid-State Circuits, 2008, 43(2): 566-576.

[28] Faulkner H M L, Rodenburg J M. Movable aperture lensless transmission microscopy: a novel phase retrieval algorithm[J]. Physical Review Letters, 2004, 93(2): 023903.

[29] Fienup J R. Phase retrieval algorithms: a comparison[J]. Applied Optics, 1982, 21(15): 2758-2769.

[31] Tian L, Waller L. Quantitative differential phase contrast imaging in an LED array microscope[J]. Optics Express, 2015, 23(9): 11394-11403.

[32] Guo K K, Dong S Y, Nanda P, et al. Optimization of sampling pattern and the design of Fourier ptychographic illuminator[J]. Optics Express, 2015, 23(5): 6171-6180.

[33] Tian L, Li X, Ramchandran K, et al. Multiplexed coded illumination for Fourier Ptychography with an LED array microscope[J]. Biomedical Optics Express, 2014, 5(7): 2376-2389.

[34] van Roey J, van der Donk J, Lagasse P E. Beam-propagation method: analysis and assessment[J]. Journal of the Optical Society of America, 1981, 71(7): 803-810.

[35] Sidorenko P, Cohen O. Single-shot ptychography[J]. Optica, 2016, 3(1): 9-14.

[36] Gustafsson M G L. Nonlinear structured-illumination microscopy: wide-field fluorescence imaging with theoretically unlimited resolution[J]. Proceedings of the National Academy of Sciences of the United States of America, 2005, 102(37): 13081-13086.

[37] Schermelleh L, Carlton P M, Haase S, et al. Subdiffraction multicolor imaging of the nuclear periphery with 3D structured illumination microscopy[J]. Science, 2008, 320(5881): 1332-1336.

[38] Goodman JW. Introduction to Fourier optics[M]. 3rd ed. Greenwood Village, Colorado: Roberts and Company Publishers, 2005.

[39] Machine Intelligence. PAMI-[J]. Pentland A P. A new sense for depth of field. IEEE Transactions on Pattern Analysis, 1987, 9(4): 523-531.

[40] ChakrabartiA, ZicklerT. Depth and deblurring from a spectrally-varying depth-of-field[M] ∥Fitzgibbon A, Lazebnik S, Perona P, et al. Computer vision-ECCV 2012. Lecture notes in computer science. Berlin, Heidelberg: Springer, 2012, 7576: 648- 661.

[41] Haim H, Elmalem S, Giryes R, et al. Depth estimation from a single image using deep learned phase coded mask[J]. IEEE Transactions on Computational Imaging, 2018, 4(3): 298-310.

[42] Golay M J E. Multi-slit spectrometry[J]. Journal of the Optical Society of America, 1949, 39(6): 437-444.

[43] Ibbett R N, Aspinall D, Grainger J F. Real-time multiplexing of dispersed spectra in any wavelength region[J]. Applied Optics, 1968, 7(6): 1089-1093.

[44] Gehm M E. McCain S T, Pitsianis N P, et al. Static two-dimensional aperture coding for multimodal, multiplex spectroscopy[J]. Applied optics, 2006, 45(13): 2965-2974.

[45] Candes E J, Romberg J, Tao T. Robust uncertainty principles: exact signal reconstruction from highly incomplete frequency information[J]. IEEE Transactions on Information Theory, 2006, 52(2): 489-509.

[46] Mooney J M, Vickers V E, An M, et al. High-throughput hyperspectral infrared camera[J]. Journal of the Optical Society of America A, 1997, 14(11): 2951-2961.

[47] Descour M R, Volin C E, Dereniak E L, et al. Demonstration of a high-speed nonscanning imaging spectrometer[J]. Optics Letters, 1997, 22(16): 1271-1273.

[48] Wagadarikar A, John R, Willett R, et al. Single disperser design for coded aperture snapshot spectral imaging[J]. Applied Optics, 2008, 47(10): B44-B51.

[49] Arce G R, Brady D J, Carin L, et al. Compressive coded aperture spectral imaging: an introduction[J]. IEEE Signal Processing Magazine, 2013, 31(1): 105-115.

[50] Wagadarikar A A, Pitsianis N P, Sun X, et al. Video rate spectral imaging using a coded aperture snapshot spectral imager[J]. Optics Express, 2009, 17(8): 6368-6388.

[52] Ji X Y, Miao C L, Zhang Y B, et al. Separating reflective and fluorescent components for dynamic scenes[J]. Optics Communications, 2017, 404: 11-17.

[53] Rueda H, Fu C, Lau D L, et al. Single aperture spectral+ToF compressive camera: toward hyperspectral+depth imagery[J]. IEEE Journal of Selected Topics in Signal Processing, 2017, 11(7): 992-1003.

[54] Rueda H, Arguello H, Arce G R. DMD-based implementation of patterned optical filter arrays for compressive spectral imaging[J]. Journal of the Optical Society of America A, 2015, 32(1): 80-89.

[55] Marcia RF, Willett RM. Compressive coded aperture superresolution image reconstruction[C]∥2008 IEEE International Conference on Acoustics, Speech and Signal Processing, March 31-April 4, 2008, Las Vegas, NV, USA. New York: IEEE, 2008: 833- 836.

[56] Vijayakumar A, Rosen J. Interferenceless coded aperture correlation holography-a new technique for recording incoherent digital holograms without two-wave interference[J]. Optics Express, 2017, 25(12): 13883-13896.

[57] Brady D J, Mrozack A. MacCabe K, et al. Compressive tomography[J]. Advances in Optics and Photonics, 2015, 7(4): 756-813.

[58] Asif M S, Ayremlou A, Sankaranarayanan A, et al. FlatCam: thin, lensless cameras using coded aperture and computation[J]. IEEE Transactions on Computational Imaging, 2017, 3(3): 384-397.

[59] Vellekoop I M, Mosk A P. Focusing coherent light through opaque strongly scattering media[J]. Optics Letters, 2007, 32(16): 2309-2311.

[60] Vellekoop I M, Lagendijk A, Mosk A P. Exploiting disorder for perfect focusing[J]. Nature Photonics, 2010, 4(5): 320-322.

[61] van Putten E G, Akbulut D, Bertolotti J, et al. Scattering lens resolves sub-100 nm structures with visible light[J]. Physical Review Letters, 2011, 106(19): 193905.

[62] Choi Y, Yang T D, Fang-Yen C, et al. Overcoming the diffraction limit using multiple light scattering in a highly disordered medium[J]. Physical Review Letters, 2011, 107(2): 023902.

[63] Feng S C, Kane C, Lee P A, et al. Correlations and fluctuations of coherent wave transmission through disordered media[J]. Physical Review Letters, 1988, 61(7): 834-837.

[64] Freund I, Rosenbluh M, Feng S C. Memory effects in propagation of optical waves through disordered media[J]. Physical Review Letters, 1988, 61(20): 2328-2331.

[66] Yilmaz H, van Putten E G, Bertolotti J, et al. Speckle correlation resolution enhancement of wide-field fluorescence imaging[J]. Optica, 2015, 2(5): 424-429.

[67] Popoff S M, Lerosey G, Carminati R, et al. Measuring the transmission matrix in optics: an approach to the study and control of light propagation in disordered media[J]. Physical Review Letters, 2010, 104(10): 100601.

[68] Liutkus A, Martina D, Popoff S, et al. Imaging with nature: compressive imaging using a multiply scattering medium[J]. Scientific Reports, 2015, 4: 5552.

[69] Yoon J, Lee K, Park J, et al. Measuring optical transmission matrices by wavefront shaping[J]. Optics Express, 2015, 23(8): 10158-10167.

[70] Drémeau A, Liutkus A, Martina D, et al. Reference-less measurement of the transmission matrix of a highly scattering material using a DMD and phase retrieval techniques[J]. Optics Express, 2015, 23(9): 11898-11911.

[71] Metzler CA, Sharma MK, NageshS, et al. Coherent inverse scattering via transmission matrices: efficient phase retrieval algorithms and a public dataset[C]∥2017 IEEE International Conference on Computational Photography (ICCP), May 12-14, 2017, Stanford, CA, USA. New York: IEEE, 2017: 16969263.

[72] Sharma M, Metzler C A, Nagesh S, et al. Inverse scattering via transmission matrices: broadband illumination and fast phase retrieval algorithms[J]. IEEE Transactions on Computational Imaging, 2019, 1.

[73] Butterweck H J. General theory of linear, coherent optical data-processing systems[J]. Journal of the Optical Society of America, 1977, 67(1): 60-70.

[74] Lee K, Park Y. Exploiting the speckle-correlation scattering matrix for a compact reference-free holographic image sensor[J]. Nature Communications, 2016, 7: 13359.

[76] Antipa N, Kuo G, Heckel R, et al. DiffuserCam: lensless single-exposure 3D imaging[J]. Optica, 2018, 5(1): 1-9.

[77] Ng R, Levoy M, Brédif M, et al. Light field photography with a hand-held plenoptic camera[J]. Computer Science Technical Report CSTR, 2005, 2(11): 1-11.

[78] LevoyM, HanrahanP. Light field rendering[C]∥Proceedings of the 23rd annual conference on Computer graphics and interactive techniques-SIGGRAPH '96, August 4-9, 1996, New Orleans, LA, USA. New York: ACM, 1996: 31- 42.

[80] Bishop TE, ZanettiS, FavaroP. Light field superresolution[C]∥2009 IEEE International Conference on Computational Photography (ICCP), April 16-17, 2009, San Francisco, CA, USA. New York: IEEE, 2009: 11499060.

[81] Fahringer T W, Lynch K P, Thurow B S. Volumetric particle image velocimetry with a single plenoptic camera[J]. Measurement Science and Technology, 2015, 26(11): 115201.

[83] Wilburn B, Joshi N, Vaish V, et al. High performance imaging using large camera arrays[J]. ACM Transactions on Graphics, 2005, 24(3): 765-776.

[84] Lin X, Wu J M, Zheng G A, et al. Camera array based light field microscopy[J]. Biomedical Optics Express, 2015, 6(9): 3179-3189.

[86] Kemeny S E, Panicacci R, Pain B, et al. Multiresolution image sensor[J]. IEEE Transactions on Circuits and Systems for Video Technology, 1997, 7(4): 575-583.

[87] ShechtmanE, CaspiY, IraniM. Increasing space-time resolution in video[M] ∥Heyden A, Sparr G, Nielsen M, et al. Computer vision-ECCV 2002. Lecture notes in computer science. Berlin, Heidelberg: Springer, 2002, 2350: 753- 768.

[88] Shechtman E, Caspi Y, Irani M. Space-time super-resolution[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2005, 27(4): 531-545.

[89] PortzT, ZhangL, JiangH. Random coded sampling for high-speed HDR video[C]∥IEEE International Conference on Computational Photography (ICCP), April 19-21, 2013, Cambridge, MA, USA. New York: IEEE, 2013: 13580210.

[90] AntipaN, OareP, BostanE, et al. Video from stills: lensless imaging with rolling shutter[C]∥2019 IEEE International Conference on Computational Photography (ICCP), May 15-17, 2019, Tokyo, Japan. New York: IEEE, 2019: 18793743.

[91] Attneave F. Some informational aspects of visual perception[J]. Psychological Review, 1954, 61(3): 183-193.

[92] Barlow HB. Sensory mechanisms, the reduction of redundancy, and intelligence[M]. London: Her Majesty’s Stationary Office, 1959: 535- 539.

[93] Barlow H B, Kaushal T P, Mitchison G J. Finding minimum entropy codes[J]. Neural Computation, 1989, 1(3): 412-423.

[94] Perkel D H, Bullock T H. Neural coding[J]. Neurosciences Research Program Bulletin, 1968, 3: 221-348.

[95] FoldiakP. Sparse coding in the primate cortex[M]. Cambridge, MA: MIT Press, 2003.

[96] Vinje W E. Sparse coding and decorrelation in primary visual cortex during natural vision[J]. Science, 2000, 287(5456): 1273-1276.

[97] Bell A J, Sejnowski T J. An information-maximization approach to blind separation and blind deconvolution[J]. Neural Computation, 1995, 7(6): 1129-1159.

[98] Stone JV. Independent component analysis: a tutorial introduction[M]. Cambridge, MA: MIT Press, 2004.

[99] Linsker R. Self-organization in a perceptual network[J]. Computer, 1988, 21(3): 105-117.

[100] Atick J J, Redlich A N. Towards a theory of early visual processing[J]. Neural Computation, 1990, 2(3): 308-320.

[101] Rao R P N, Ballard D H. Predictive coding in the visual cortex: a functional interpretation of some extra-classical receptive-field effects[J]. Nature Neuroscience, 1999, 2(1): 79-87.

[102] Srinivasan M V, Laughlin S B, Dubs A. Predictive coding: a fresh view of inhibition in the retina[J]. Proceedings of the Royal Society of London Series B Biological Sciences, 1982, 216(1205): 427-459.

[103] Bialek W. Rieke F, van Steveninck R D R, et al. Reading a neural code[J]. Science, 1991, 252(5014): 1854-1857.

[104] Berry M J, Warland D K, Meister M. The structure and precision of retinal spike trains[J]. Proceedings of the National Academy of Sciences of the United States of America, 1997, 94(10): 5411-5416.

[105] McKeown M J, Makeig S, Brown G G, et al. Analysis of fMRI data by blind separation into independent spatial components[J]. Human Brain Mapping, 1998, 6(3): 160-188.

[106] van Hateren J H, van der Schaaf A. Independent component filters of natural images compared with simple cells in primary visual cortex[J]. Proceedings of the Royal Society of London Series B: Biological Sciences, 1998, 265(1394): 359-366.

[107] Schwartz E P S O. Modeling surround suppression in V1 neurons with a statistically-derived normalization model[C]∥Advances in Neural Information Processing Systems 11: Proceedings of the 1998 conference, November 29-December 4, 1999, Denver, Colorado, USA. Canada: NIPS, 1999: 153- 159.

[108] Meister M. Berry M J II. The neural code of the retina[J]. Neuron, 1999, 22(3): 435-450.

[110] Zaghloul K A, Boahen K. A silicon retina that reproduces signals in the optic nerve[J]. Journal of Neural Engineering, 2006, 3(4): 257-267.

[111] Gollisch T, Meister M. Rapid neural coding in the retina with relative spike latencies[J]. Science, 2008, 319(5866): 1108-1111.

[112] Boahen K A. Point-to-point connectivity between neuromorphic chips using address events[J]. IEEE Transactions on Circuits and Systems II: Analog and Digital Signal Processing, 2000, 47(5): 416-434.

[113] Zaghloul K A, Boahen K A. An on-off log domain circuit that recreates adaptive filtering in the retina[J]. IEEE Transactions on Circuits and Systems I: Regular Papers, 2005, 52(1): 99-107.

[114] Roska B, Molnar A, Werblin F S. Parallel processing in retinal ganglion cells: how integration of space-time patterns of excitation and inhibition form the spiking output[J]. Journal of Neurophysiology, 2006, 95(6): 3810-3822.

[115] MahowaldM. An analog VLSI system for stereoscopic vision[M]. Boston, MA: Springer, 1994.

[116] Ruedi P F, Heim P, Kaess F, et al. A 128×128 pixel 120-dB dynamic-range vision-sensor chip for image contrast and orientation extraction[J]. IEEE Journal of Solid-State Circuits, 2003, 38(12): 2325-2333.

[117] LuoQ, Harris JG. A time-based CMOS image sensor[C]∥2004 IEEE International Symposium on Circuits and Systems (IEEE Cat. No. 04CH37512), May 23-26, 2004, Vancouver, BC, Canada. New York: IEEE, 2004: 840- 843.

[118] AzadmehrM, Abrahamsen JP, HafligerP. A foveated AER imager chip [address event representation][C]∥2005 IEEE International Symposium on Circuits and Systems, May 23-26, 2005, Kobe, Japan. New York: IEEE, 2005: 2751- 2754.

[119] Costas-Santos J, Serrano-Gotarredona T, Serrano-Gotarredona R, et al. A spatial contrast retina with on-chip calibration for neuromorphic spike-based AER vision systems[J]. IEEE Transactions on Circuits and Systems I: Regular Papers, 2007, 54(7): 1444-1458.

[120] Posch C, Matolin D, Wohlgenannt R. A QVGA 143 dB dynamic range frame-free PWM image sensor with lossless pixel-level video compression and time-domain CDS[J]. IEEE Journal of Solid-State Circuits, 2011, 46(1): 259-275.

[122] Li CH, BrandliC, BernerR, et al. Design of an RGBW color VGA rolling and global shutter dynamic and active-pixel vision sensor[C]∥2015 IEEE International Symposium on Circuits and Systems (ISCAS), May 24-27, 2015, Lisbon, Portugal. New York: IEEE, 2015: 718- 721.

[123] SonB, SuhY, KimS, et al. A 640×480 dynamic vision sensor with a 9 μm pixel and 300 Meps address-event representation[C]∥2017 IEEE International Solid-State Circuits Conference (ISSCC), February 5-9, 2017, San Francisco, CA, USA. New York: IEEE, 2017: 66- 67.

Article Outline

季向阳. 编码摄像[J]. 光学学报, 2020, 40(1): 0111012. Xiangyang Ji. Coded Photography[J]. Acta Optica Sinica, 2020, 40(1): 0111012.

![FPM的迭代重建过程[12]](/richHtml/gxxb/2020/40/1/0111012/img_2.jpg)

![3D FPM重建效果图[13]](/richHtml/gxxb/2020/40/1/0111012/img_3.jpg)

![光谱成像的结构图[17]](/richHtml/gxxb/2020/40/1/0111012/img_4.jpg)

![SD-CASSI装置结构图[49]](/richHtml/gxxb/2020/40/1/0111012/img_5.jpg)

![“散射透镜”系统结构图[61]](/richHtml/gxxb/2020/40/1/0111012/img_6.jpg)

![宽视场高分辨散斑扫描显微[66]](/richHtml/gxxb/2020/40/1/0111012/img_7.jpg)

![光场编码摄像的原理示意图[21]](/richHtml/gxxb/2020/40/1/0111012/img_9.jpg)

![编码卷帘快门摄影原理[34]](/richHtml/gxxb/2020/40/1/0111012/img_10.jpg)

![神经元解码结构[103]](/richHtml/gxxb/2020/40/1/0111012/img_11.jpg)