基于残差通道注意力和多级特征融合的图像超分辨率重建  下载: 1231次

下载: 1231次

1 引言

随着数字化时代的来临,高清移动设备得到迅速普及,人们对图像清晰度的要求越来越高。通过硬件设备实现图像分辨率的提高,面临着难度大、成本高、实用性不强等问题。图像的超分辨率重建技术就是基于一幅或者多幅低分辨率图像采用软件重建出一幅高分辨率图像[1-3],一直是计算机视觉领域的研究热点,并已被广泛应用到医学影像、**侦查、视频监控等领域。本文主要研究单幅图像的超分辨率重建(SISR)。超分辨率重建技术可以分为三类:基于插值[4]的方法;基于重建[5]的方法;基于学习[6-7]的方法。近几年,随着人工智能的迅速发展,基于卷积神经网络(CNN)的图像超分辨率由于端对端学习的效果好,正逐步成为主流方法。Dong等[8]率先提出了超分辨率卷积神经网络(SRCNN),仅使用三层卷积就可实现重建,但由于其速度慢,网络层数不够深,不能充分提取图像的特征。之后,Dong等[8]对SRCNN进行改进,提出了快速超分辨率卷积神经网络(FSRCNN)[9],该网络不需要将原始低分辨率图像进行插值放大,减小了模型的复杂度,并使用PReLU激活函数代替ReLU,最后使用反卷积进行图像的放大。Shi等[10]提出了亚像素卷积神经网络(ESPCN),用高效的亚像素卷积实现图像的放大,使速度得到很大提升。Kim等[11]提出了VDSR(Very Deep Super Resolution),将网络层数加深到20层,使用3×3的卷积核,借鉴ResNet[12]在网络中加入残差,加速网络的收敛。之后,Kim等[13]又提出了深层递归卷积网络(DRCN),该网络中一共使用16个递归结构;同时,为了减轻训练难度,Kim等引入了递归监督和跳跃连接。

对于浅层的网络模型SRCNN[8]、FSRCNN[9]、ESPCN[10],由于其卷积层数比较少,不能得到很好的重建效果;而对于VDSR[11],由于其使用残差网络,在精度和速度上相对浅层网络都有很大提升。但是,上述网络模型仍然存在一些问题:首先,这些模型未考虑特征通道之间不同的重要性,缺乏对不同类型信息的判别能力,且平等地处理不同的信息,导致网络的表现能力受到限制。SENet(Squeeze-and-Exciation Networks)[14]证明,通过显式的建模特征通道的相互联系,自适应地校正信道的特征响应,对重要性不同的信息区别处理,可以提高网络的表征能力。其次,神经网络提取的特征分为原始特征、浅层特征和深层特征,上述方法未能充分利用层级特征。最后,在加深网络层数的过程中,也会带来模型参数量和计算复杂度过大等问题。为了解决上述问题,本文提出了一种基于残差通道注意力和多级特征融合的图像超分辨率重建的网络模型。首先通过低层特征提取模块来提取图像的低层特征,然后在递归块内使用残差通道注意力和多级特征融合的方式,充分利用通道间的联系和层级之间的图像特征信息,最后将提取到的多级特征进行融合,使用亚像素卷积实现图像的重建。

本文算法的优点:1)网络整体采用递归结构,由于递归块内参数共享,在增加深度的同时可以控制模型的参数数量不增加;2)网络中使用残差通道注意力,对重要性不同的特征进行区别处理,可以提高网络的表征能力;3)使用多级特征融合的方式提取图像特征,充分利用了层级特征,并且引入分组卷积代替传统卷积,进一步减少了参数数量。

2 相关工作

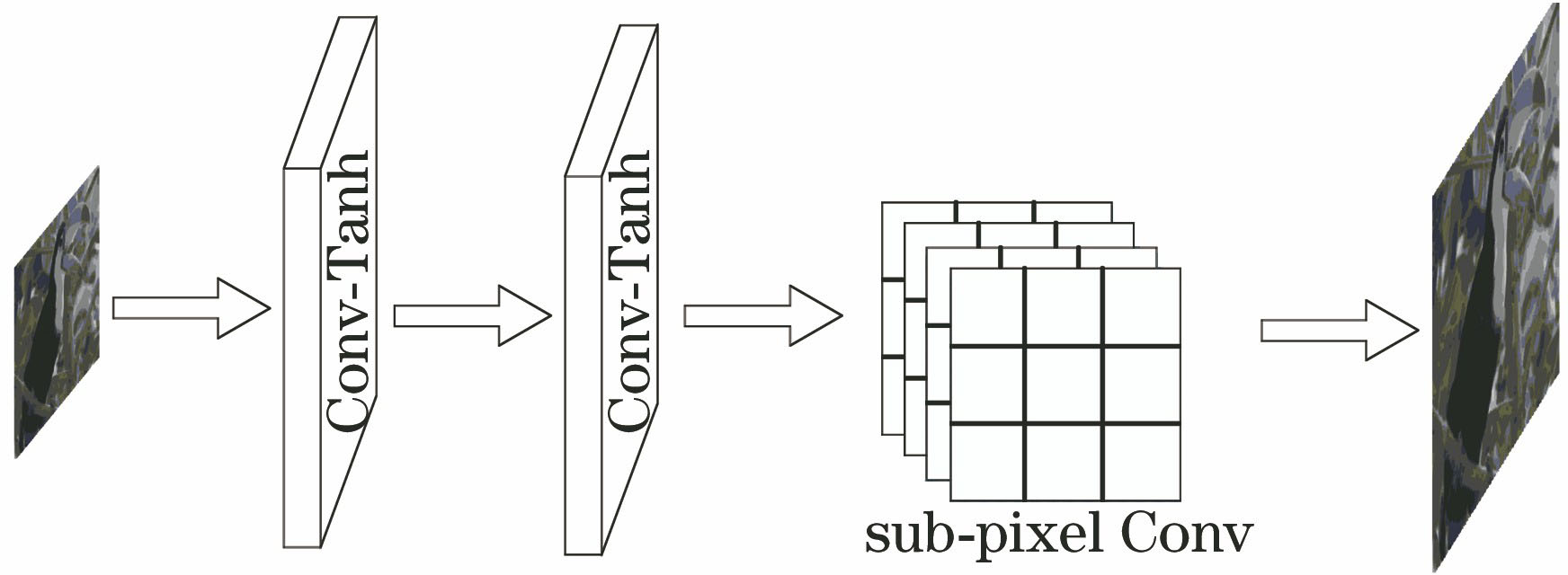

2.1 ESPCN

Shi等[10]提出了一种高效的亚像素卷积神经网络ESPCN,如

2.2 VDSR

VDSR[11]借鉴了ResNet[12]的思想,使用了残差学习,在防止梯度消失的同时加快了网络的收敛速度。该网络的结构如

3 本文算法

如

3.1 低层特征提取模块

首先借鉴牛津大学VGG小组提出的基于卷积神经网络的视觉识别算法采用的VGG-ILSVRC- 16-layers模型[15],使用3×3卷积核进行低层特征的提取。卷积层可以表示为

式中:ILR表示输入的原始的低分辨率图像;W1表示一组数量为n1、大小为k1×k1×c的滤波器;b1为偏移项;f(·)表示激活函数,本文采用PReLU作为激活函数;F1(Y)表示通过特征提取模块得到的n1张特征图。这里,k1取为3,n1取为80。此外,由于人眼对图像的亮度信息最敏感,所以c取为1。为了保持特征图的大小不变,在每次卷积前都对边界都进行补零填充,以充分利用图像的边界信息。

3.2 递归单元模块

文献[

14]表明,在神经网络中,不同通道的卷积核所提取到的特征图是不同的,这些特征图在超分辨率重建中恢复高频细节信息的重要程度也不一样。通过使用残差通道注意力,可以直接建模通道之间的关系,强调特征通道中有用的信息,从而可以更好地恢复图像的高频信息。

式中: Sc为校准后的特征图;n=(1,2,…,4)代表残差通道注意力模块的数量;Fn为卷积后的输出;fga为全局平均池化;w1、w2为两个全连接层的权重;σ和ε分别代表sigmoid和PReLU激活函数;rn为残差注意力的输出,为简单起见此处省略了偏移项。

图 4. 递归单元模块。(a)递归单元模块的组成;(b)残差通道注意力;(c)多级特征融合

Fig. 4. Recursive unit module. (a) Recursive unit module composition; (b) residual channel attention; (c) multilevel feature fusion

VDSR[11]将每层的特征映射无差别地发送给下面的卷积层,为了充分利用分层的特征并加强卷积层之间的信息流,可使用多级特征融合的方式。

式中:k=1,…,4代表多级特征融合模块的数量;Dk-1为经过一层卷积后的信息分流;Ca代表分别经过分组卷积和卷积处理;

3.3 重建网络

在重建网络中,首先将提取到的多种特征融合,包括低层特征和每个递归单元模块的输出特征,然后使用亚像素卷积对图像进行最终的重建。重建过程分可为两部分:首先经过亚像素卷积层时,输出特征图的大小保持不变,特征通道数变为原来的h2倍(h表示放大倍数);然后将h2个特征通道按照特定的顺序排列成一个大小为h×h的区域,该区域对应高分辨率图像中一个h×h的一个子块,那么一个大小为h2×H×W的低分辨率的特征图就重新排列一个1×hH×hW的高分辨率图像。相比使用插值函数放大图像,卷积过程是针对低分辨率图像进行的,所以使用亚像素卷积效率会更高,用公式可表示为

式中:FHR表示最终重建的高分辨率图像;A(x)表示排列函数;

3.4 损失函数和评价标准

为了达到更好的重建效果,本文使用重建图像与原始高分辨率图像的均方误差(MSE)作为损失函数。使用均方误差作为损失函数可以得到更高的峰值信噪比(PSNR)。均方误差的计算公式为

式中:L(θ)表示均方误差;F(Yi;θ)和Xi代表重建图像和原始高分辨率图像;n'代表训练样本的总数目。在训练过程中,通过计算重建图像和原始高分辨率图像的均方误差,更新各层参数θ=(W1,W2,…,Wi,B1,B2,…,Bi),得到最小化损失函数,从而获得最佳网络参数模型。本文使用PSNR和结构相似度(SSIM)[16]作为客观评价指标。PSNR的值越大,说明重建的图像失真越小,效果越好;SSIM[16]的值越接近于1,说明重建图像和原始图像的相似度越高,重建图像的质量越高。

4 实验结果与分析

4.1 实验环境

本实验的实验环境如下:ubuntu 16.04LTS操作系统;应用的深度学习框架是caffe[17],搭建cuda和cudnn用于实验的加速;使用MATLAB R2014a进行测试,计算机CPU为 I7 8700,显卡是NVDIA Geforce 1050TI。

4.2 数据集及优化方法

本实验采用的是公开的Timofte dataset[18]和Berkeley Segmentation Datasets[19]数据集,将Timofte dataset里面的91张图片以及Berkeley Segmentation Datasets[18]里面BSD200作为训练集,将Set5、Set14及Berkeley Segmentation Datasets[19]里面的BSD100作为测试集。为了充分利用数据集,本文对训练集使用了两种数据增强方法:1)将图像分别旋转90°、180°和270°;2)将图像进行缩放,缩放因子分别为0.5、0.6、0.7、0.8、0.9。将得到的训练集图像进行f倍下采样,得到低分辨率图像,再将图像裁剪成子图像块,最后将裁剪后的图像块作为训练网络的输入。

本文使用Adam作为优化方法。Adam利用梯度的一阶矩估计和二阶矩估计动态调整每个参数的学习率,其优点在于经过偏置校正后,每一次迭代学习率都有一个确定的范围,使得参数比较平稳。公式为

式中:t为时间;mt和nt分别是对梯度的一阶矩估计和二阶矩估计;

4.3 网络参数的设置

4.3.1 层数设置

有研究表明[20],网络深度是影响网络性能的重要因素之一。适当增加网络层数可以提升重建效果,但层数过深也会带来参数量和计算成本增加以及训练时间过长等问题。本文开展了三组实验,以f=4为例,采用Set5作为测试集,分别用3个RUB对应20层网络,4个RUB对应26层网络,5个RUB对应32层网络。从

图 5. Set5测试集下不同层数时PSNR均值随迭代次数的变化

Fig. 5. Variation of mean PSNR with the number of iterations for different layers at Set5 test set

4.3.2 模型参数及计算复杂度

深层的网络需要庞大的计算量和更大的存储空间,不利于实际应用。本文采用递归结构和分组卷积,引入这两种结构对降低模型的参数量和计算复杂度都有很大帮助。分组卷积最早出现在Alexnet[21]中,受当时硬件资源的影响,Alexnet[21]不能在一个GPU下进行训练,作者把输出的特征通道特征分给多个GPU分别进行处理,最后把多个GPU特征通道的特征进行融合。分组卷积使模型变得更加紧凑高效。假设一个输入的图像数据为Df×Df×M,Df代表输入的宽和高,M代表输入的通道数,卷积核为Dk×Dk×N,Dk代表卷积核的宽和高,N代表卷积核的数量。如果不采用分组卷积,那么得到的输出图像数据为Do×Do×H;如果加入分组卷积,假设将组数设定为s组,那么每组中输入图像的数据变为Df×Df×(M/s),卷积核的大小变为Dk×Dk×(N/s),最后将每一组的输出特征通道数进行连接,输出数据变为Do×Do×(H/s),即为原来参数量的1/s。模型的计算复杂度公式为

式中:fi表示第i层滤波器的大小,i=1,2,…,L;ni表示第i层滤波器的个数,i=1,2,…,L;Sinput代表输入图像的大小。本文在底层特征提取模块中使用的卷积核大小是80×3×3,RUB中六层卷积核的大小分别是80×3×3、64×3×3、32×3×3、64×3×3,48×3×3、80×3×3。其中,32×3×3和48×3×3均使用分组卷积,组数为4。RB的卷积核大小是f2×3×3,f2代表放大的倍数。由公式可知计算复杂度不仅与参数的数量有关,还与输入图片的大小成正比。对比于VDSR[11]使用插值后的图片作为网络的输入,本模型采用原始未经过插值放大的图片作为模型的输入,以f=4为例,采用Set5做测试集,经计算得模型的计算复杂度约为VDSR[11]的0.02。本文在每一个递归单元中实现参数共享,并且引入了分组卷积,极大减少了参数量,模型参数量如

图 6. Set5测试集下不同网络结构的参数数量与PSNR均值的关系

Fig. 6. Relationship between number of parameters of different network structures and mean PSNR at Set5 test set

4.3.3 网络结构

为了研究多级特征融合和残差通道注意力对网络性能的影响,本文以f=4为例,采用Set5作为测试集,进行了4组实验,分别比较了有无多级特征融合和有无残差通道注意力时的PSNR均值。从

表 1. 在Set5测试集下不同RCAF模型组件的PSNR均值

Table 1. Means PSNR of different RCAF model components at Set 5 test set

|

4.3.4 运行时间

本文在相同的环境下进行了4组实验,比较了不同模型的运行时间。以f=4为例,采用Set5作为测试集,分别测试了RCAF、SRCNN[8]、FSRCNN[9]、ESPCN[10]、VDSR[11]的运行时间。从

图 7. Set5测试集下不同方法的运行时间与PSNR均值之间的关系

Fig. 7. Relationship between run time of different methods and mean PSNR at Set5 test set

4.4 实验结果分析

为了测试本文算法的性能,将其与Bicubic、SRCNN[8]、FSRCNN[9]、ESPCN[10]、VDSR[11]方法进行比较,测试集采用图像超分辨重建领域常用的数据集Set5、Set14和BSD100(三个测试集分别包括5,14,100张图片),并从中选取了图像边缘细节丰富的两张图像进行测试,然后对比了图像放大后的细节。受实验环境和迭代次数的影响,FSRCNN[9]与VDSR[11]与原文结果略有不同。

图 8. 采用不同算法恢复出来的斑马图像

Fig. 8. Comparison of zebra image recovered with different algorithms

图 9. 采用不同算法恢复出来的ppt图像的对比

Fig. 9. Comparison of ppt image recovered with different algorithms

表 2. 测试集Set5、Set14、BSD100下不同算法的PSNR均值

Table 2. Mean PSNR of different algorithms at Set5, Set14, and BSD100 test sets

|

表 3. 测试集Set5、Set14、BSD100下不同算法的SSIM均值

Table 3. Mean SSIM of different algorithms at test sets Set5, Set14, and BSD100

|

5 结论

本文针对现有模型不能区别对待不同特征通道的重要程度,不能充分利用卷积层之间的特征信息,以及模型计算复杂度高,参数数量多等问题,提出了一种基于残差通道注意力和多级特征融合的图像超分辨率重建方法。该方法具有以下特点:通过使用残差通道注意力自适应校正通道的特征响应,提高了网络的表现能力;使用多级特征融合的方式,充分利用层间信息,促进了网络中的数据流通;网络整体采用递归结构,递归块内的参数共享,并引入了分组卷积,进一步降低了模型的计算复杂度以及参数的数量。下一步计划进一步提高重建图像的质量,同时缩短模型的运行时间。

[1] Zhang H Y, Zhang L P, Shen H F. A blind super-resolution reconstruction method considering image registration errors[J]. International Journal of Fuzzy Systems, 2015, 17(2): 353-364.

[2] Chen H G, He X H, Teng Q Z, et al. Single image super resolution using local smoothness and nonlocal self-similarity priors[J]. Signal Processing: Image Communication, 2016, 43: 68-81.

[3] 李素梅, 雷国庆, 范如. 基于卷积神经网络的深度图超分辨率重建[J]. 光学学报, 2017, 37(12): 1210002.

[4] BatzM, EichenseerA, SeilerJ, et al. Hybrid super-resolution combining example-based single-image and interpolation-based multi-image reconstruction approaches[C]∥2015 IEEE International Conference on Image Processing (ICIP), September 27-30, 2015, Quebec City, QC, Canada. New York: IEEE, 2015: 58- 62.

[5] Kim K I, Kwon Y. Single-image super-resolution using sparse regression and natural image prior[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(6): 1127-1133.

[6] 练秋生, 张伟. 基于图像块分类稀疏表示的超分辨率重构算法[J]. 电子学报, 2012, 40(5): 920-925.

Lian Q S, Zhang W. Image super-resolution algorithms based on sparse representation of classified image patches[J]. Acta Electronica Sinica, 2012, 40(5): 920-925.

[7] 肖进胜, 刘恩雨, 朱力, 等. 改进的基于卷积神经网络的图像超分辨率算法[J]. 光学学报, 2017, 37(3): 0318011.

[8] Dong C, Loy C C, He K M, et al. Image super-resolution using deep convolutional networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(2): 295-307.

[9] 郑向涛, 袁媛, 卢孝强. 自外而内的单幅图像超分辨率复原算法[J]. 光学学报, 2017, 37(3): 0318006.

[10] Shi WZ, CaballeroJ, HuszarF, et al. Real-time single image and video super-resolution using an efficient sub-pixel convolutional neural network[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1874- 1883.

[11] KimJ, Lee JK, Lee KM. Accurate image super-resolution using very deep convolutional networks[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1646- 1654.

[12] He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 770- 778.

[13] KimJ, Lee JK, Lee KM. Deeply-recursive convolutional network for image super-resolution[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1637- 1645.

[14] HuJ, ShenL, AlbanieS, et al. ( 2019-05-16)[2019-07-17]. https:∥arxiv.org/abs/1709. 01507.

[15] Qu Y Y, Lin L, Shen F M, et al. Joint hierarchical category structure learning and large-scale image classification[J]. IEEE Transactions on Image Processing, 2017, 26(9): 4331-4346.

[16] Ye Y X, Shan J, Bruzzone L, et al. Robust registration of multimodal remote sensing images based on structural similarity[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(5): 2941-2958.

[17] Jia YQ, ShelhamerE, DonahueJ, et al. ( 2014-06-20)[2019-07-17]. https:∥arxiv.org/abs/1408. 5093.

[18] MartinD, FowlkesC, TalD, et al. A database of human segmented natural images and its application to evaluating segmentation algorithms and measuring ecological statistics[C]∥Proceedings Eighth IEEE International Conference on Computer Vision. ICCV 2001, July 7-14, 2001, Vancouver, BC, Canada. New York: IEEE, 2001: 416- 423.

[19] TimofteR, de SmetV, van GoolL. A+: adjusted anchored neighborhood regression for fast super-resolution[M] ∥Cremers D, Reid I, Saito H, et al. Computer vision -- ACCV 2014. Lecture notes in computer science. Cham: Springer, 2015, 9006: 111- 126.

[20] Du B, Wang Z M, Zhang L F, et al. Robust and discriminative labeling for multi-label active learning based on maximum correntropy criterion[J]. IEEE Transactions on Image Processing, 2017, 26(4): 1694-1707.

[21] KrizhevskyA, SutskeverI, Hinton GE. ImageNet classification with deep convolutional neural networks[C]∥Advances in Neural Information Processing Systems, December 3-6, 2012, Lake Tahoe, Nevada, United States. Canada: NIPS, 2012: 1097- 1105.

Article Outline

席志红, 袁昆鹏. 基于残差通道注意力和多级特征融合的图像超分辨率重建[J]. 激光与光电子学进展, 2020, 57(4): 041504. Zhihong Xi, Kunpeng Yuan. Super-Resolution Image Reconstruction Based on Residual Channel Attention and Multilevel Feature Fusion[J]. Laser & Optoelectronics Progress, 2020, 57(4): 041504.