基于高斯输出约束的上下文相关滤波跟踪  下载: 838次

下载: 838次

1 引言

计算机视觉被广泛应用于人脸识别、车辆或行人检测、目标跟踪和图像生成等领域[1]。由于视频目标跟踪在视频监控、智能交通和**制导等领域有广泛的应用,视频目标跟踪已成为计算机视觉中最为重要的研究内容之一[2]。近年来,视频目标跟踪算法的研究取得了长足进展,但依然面临着诸多挑战,例如光照变换、目标遮挡、快速运动、形变和复杂背景等[3-5]。虽然目前许多算法在处理其中某些问题时取得了一定的效果,但仍有一些问题尚未得到有效的解决[6]。因此,视频目标跟踪的研究依然具有一定的理论研究意义和实践应用价值。

由于相关滤波可以将在时域上的计算转换到频域上进行计算,从而降低了算法的计算量,引起了科学研究者的广泛关注,并将其应用到视觉目标跟踪中[7-8]。Bolme等[9]首先将相关滤波的方法应用到目标跟踪中,并提出一种最小平方误差相关滤波算法(MOSSE),该算法通过计算实际输出与期望输出之间的最小平方误差来确定相关滤波参数并完成目标的检测与跟踪。受MOSSE算法的启发,Danelljan等[10]提出在相关滤波算法的基础上引入颜色空间特征,利用多通道的颜色属性将其嵌入到核空间中进行学习,并得到一个自适应的相关滤波跟踪器。Henriques等[11]将梯度直方图(HOG)特征应用到相关滤波的目标跟踪中,并提出核相关滤波(KCF)跟踪算法,该算法通过引入线性核函数来完成线性相关滤波器的快速多通道扩展,极大地提升了计算效率和跟踪性能。为了能够同时利用颜色特征和HOG特征的优点,Bertinetto等[12]提出一种互补特征融合(Staple)算法,该算法使用融合互补因子将颜色和HOG特征融合成一个新的特征。上述相关滤波算法在一定程度上提高了跟踪性能,但是在处理一些特殊环境下的目标时,仍不能满足人们对目标跟踪性能的要求。为了进一步提高目标跟踪精度,Mueller等[13]提出一种结合上下文感知相关滤波(CACF)算法,该算法同时利用目标及其周围的背景信息:首先利用前一帧的目标位置,通过相关滤波器计算出当前帧的目标置信图;然后将置信图中最高的幅值点对应的位置作为目标的位置;最后用当前帧的目标位置在线更新上下文相关滤波模型。但是此算法在处理目标形变和目标快速移动等复杂背景目标的过程中容易出现跟踪目标漂移,从而导致跟踪失败,因此,依然需要对CACF算法进行深入研究。

针对CACF算法跟踪过程中容易出现的漂移问题,本文提出约束输出的方法来减少漂移情况的发生。一方面,将输出的结果约束在一定的范围内,以减少模型更新的错误;另一方面,根据约束条件,利用可变的更新速率和原有固定不变的更新速率进行选择性更新,从而减少目标的漂移。

2 研究方法

2.1 CACF分类器

上下文感知滤波器是在相关滤波的基础上设计的,它不仅将目标区域作为样本集的唯一样本,还采集了目标区域周围的背景信息作为辅助。上下文感知算法分类器的训练和相关滤波算法分类器的训练相同,即利用岭回归的方法得到一个新的分类器。上下文感知滤波器的目标函数为

式中:A0为目标区域循环采样后的样本集;Ai为上下文区域循环采样后的样本集;ω为相关滤波器;λ1、λ2为系统的正则项系数。

为了构建一个循环矩阵,设A为一个循环矩阵,则A可由特殊矩阵F构建,表示为

式中:

利用(3)式可将目标函数(1)式转化为关于ω、B的函数:

对(4)式求最值可得

把(3)式代入(5)式,并把结果频域化可得到

式中:

由相关滤波知识可知,假设输出f(z)=z·ω,将ω=BTα代入f(z)中,可得

2.2 约束输出的滤波器更新

CACF跟踪器在处理有遮挡的目标时容易出现漂移现象,为了解决CACF跟踪中易出现的漂移问题,本文通过引入输出约束来减少跟踪过程中产生的漂移问题。为了获得更加准确的模型,并避免一些错误的输出,假设输出响应为一个独立统计量,根据中心极限定理,输出响应服从高斯分布。

2.2.1 无约束输出的滤波器更新

设y为期望输出,f(z)为实际输出,则跟踪问题可表示为

式中:f(z)=ωTφ(x);B为很小的常量。将(11)式转化为拉格朗日函数求解问题,得到拉格朗日函数为

利用拉格朗日求解方法,可以得到α、ω:

对于无约束输出的滤波器更新,一般采用的是固定的更新系数η,模型更新x(t)和滤波器更新α(t) 可表示为

式中:t为视频图像的第t帧。

2.2.2 高斯分布下的约束输出滤波器更新

假设跟踪目标的输出响应服从高斯分布,则目标函数可以表示为

式中:yi表示第i个样本φ的高斯表示;ωT为此帧的相关滤波参数;μ(t)、σ(2,t)分别为高斯分布的均值和方差;

由于

由高斯分布可知,均值μ(t)的更新为

将(17)式代入(16)式,可得

对(18)式两端同时加(-ω(T,t)x(t)),然后对其两端同乘(-1),可得

将ω(T,t)x(t)-

又因为

当相邻两帧无明显差异时,x(t)与

对(22)式进行化简处理,可得

由(23)式可知,当‖ω(t)-ω(t-1)‖取最小值时,‖ω(T,t)x(t)-μ(t)‖同样取得最小值,则只要求出‖ω(t)-ω(t-1)‖的最优解,即可求出‖ω(T,t)x(t)-μ(t)‖的最优解。

由于

利用(24)式可以把对

对(26)式中的参数λ求偏导数,可得:

对(27)式进行傅里叶变换,得到

对(28)式进行化简,可得

令τ=

式中:λ=λ1+λ2

令输出y(t)约束符合

式中:R为约束参数。在本文提出的跟踪器中,根据(30)式对跟踪过程的滤波参数进行选出性更新。

2.3 算法的实现步骤

1)根据(9)式和(10)式可以计算出目标的最大响应值,根据最大响应值可以得到目标的位置。

2)如果处理的序列在前6帧之内,选择(14)式进行模型和滤波器的更新。

3)计算出前6帧目标位置的均值和方差,计算第n(n>6)帧的最大输出响应并得到目标位置。

4)将步骤3)中求得均值和方差代入(31)式,如果输出响应满足(31)式的约束条件,则选择(30)式进行滤波器更新;不满足约束条件,则选择(14)式进行滤波器更新。

3 实验结果与分析

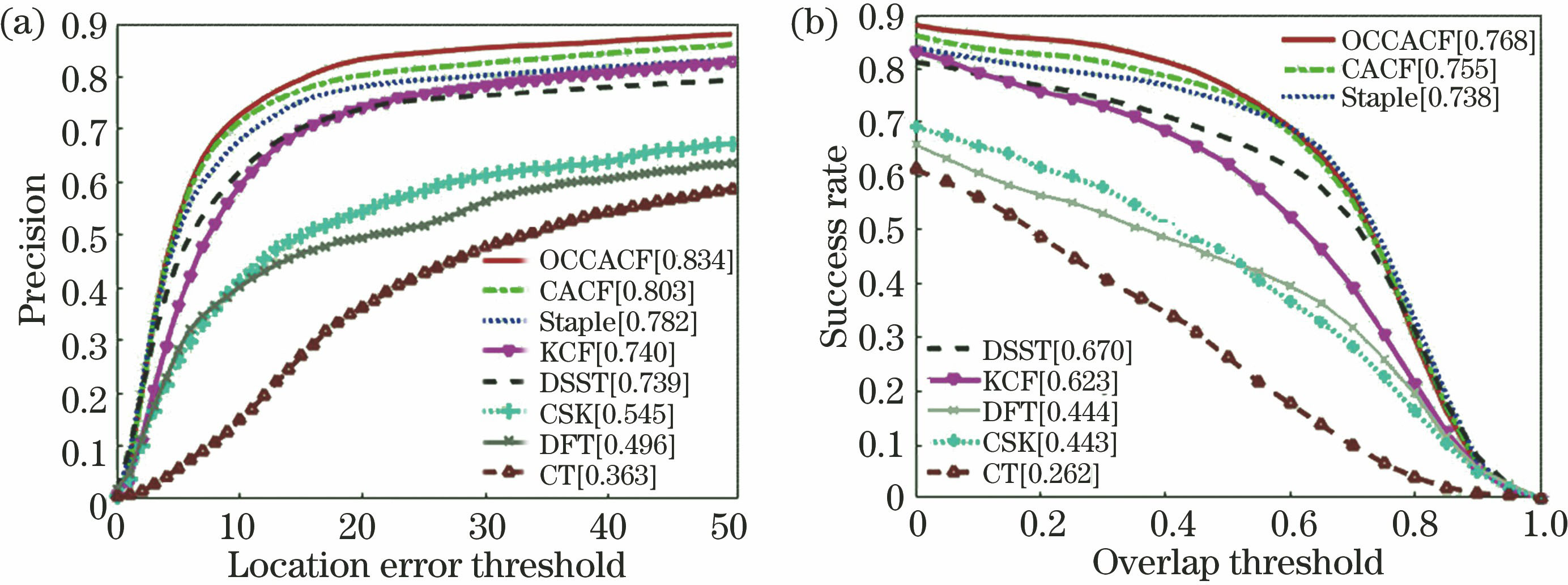

将本文设计的基于高斯约束输出的上下文相关滤波跟踪算法(OCCACF)在跟踪标准测试集OTB-2013上与多种优秀跟踪算法进行对比,对比算法包括KCF算法[11]、Staple算法[12]、CACF算法[13]、CSK算法[14]、DSST算法[15]、DFT算法[16]和CT算法[17]。采用精度和成功率作为本文的评价标准。实验平台为Intel© CoreTM i5-4200 M CPU @2.5 Hz的个人计算机,在软件MATLAB 2016b上进行仿真实验。

3.1 参数设置

在本实验中核函数选择线性核函数,固定学习率设为η=0.01,正则参数λ1=10-4,λ2=0.4。约束参数R=1.2,μ=0,σ2=0.2,其他参数设置与文献[ 13]的参数保持一致。

3.2 结果与分析

本小节将重点分析OCCACF算法和其他7种对比算法在标准测试集OTB-2013的不同属性下的精度和成功率,并抽取4组测试序列的实时跟踪结果进行分析。

表 1. 8种算法在不同属性下的成功率对比

Table 1. Success rate of eight algorithms under different attributes

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

图 1. 8种算法的测试结果对比。(a)精度;(b)成功率

Fig. 1. Comparison of test results of eight algorithms. (a) Precision; (b) success rate

图 2. 不同属性下测试的平均精度和成功率。(a)(b)尺度变化;(c)(d)平面外旋转;(e)(f)快速运动

Fig. 2. Average precision and success rate under different attributes. (a)(b) Scale variation; (c)(d) out of plane rotation; (e)(f) fast motion

图 3. 部分视频序列的实际跟踪情况。(a) Couple;(b) jogging;(c) jumping;(d) lemming

Fig. 3. Actual tracking results of part of video sequences. (a) Couple; (b) jogging; (c) jumping; (d) lemming

4 结论

设计了一种高斯约束输出的目标跟踪算法,该跟踪算法针对不同的输出结果选取不同的学习率更新滤波器。该算法可减少在传统目标算法中采用固定更新参数导致的模型更新错误,并在一定程度上减少目标跟踪过程中因目标的快速移动、形变和遮挡等情况产生的漂移。实验表明,本文设计的OCCACF算法在遮挡、快速移动、形变、尺度变化等复杂背景的干扰下均能取得稳定的跟踪结果。

[1] 侯志强, 韩崇昭. 视觉跟踪技术综述[J]. 自动化学报, 2006, 32(4): 603-617.

Hou Z Q, Han C Z. A survey of visual tracking[J]. Acta Automatica Sinica, 2006, 32(4): 603-617.

[2] 王艳川, 黄海, 李邵梅, 等. 基于在线检测和尺度自适应的相关滤波跟踪[J]. 光学学报, 2018, 38(2): 0215002.

[3] Hare S, Golodetz S, Saffari A, et al. Struck: structured output tracking with kernels[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(10): 2096-2109.

[4] YaoR, ShiQ, ShenC, et al. Part-based visual tracking with online latent structural learning[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2013, Portland, Oregon. New York: IEEE, 2013: 2363- 2370.

[6] 宋日成, 何小海, 王正勇. 基于方向可靠性的互补跟踪算法[J]. 光学学报, 2018, 38(10): 1015001.

[7] Nithin K, Bremond F. Globality-locality-based consistent discriminant feature ensemble for multicamera tracking[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2017, 27(3): 431-440.

[8] Cong Y, Fan B J, Liu J, et al. Speeded up low-rank online metric learning for object tracking[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2015, 25(6): 922-934.

[9] Bolme DS, Beveridge JR, Draper BA, et al. Visual object tracking using adaptive correlation filters[C]∥2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, June 13-18, 2010, San Francisco, CA, USA. New York: IEEE, 2010: 2544- 2550.

[10] DanelljanM, Khan FS, FelsbergM, et al. Adaptive color attributes for real-time visual tracking[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus, OH, USA. New York: IEEE, 2014: 1090- 1097.

[11] Henriques J F, Caseiro R, Martins P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583-596.

[12] BertinettoL, ValmadreJ, GolodetzS, et al. Staple: complementary learners for real-time tracking[C]∥IEEE Conference on Computer Vision and Pattern Recognition, June 26-July 1, 2016, Las Vegas, Nevada. New York: IEEE, 2016: 1401- 1409.

[13] MuellerM, SmithN, GhanemB. Context-aware correlation filter tracking[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 1387- 1395.

[14] Henriques JF, CaseiroR, MartinsP, et al. Exploiting the circulant structure of tracking-by-detection with kernels[M] ∥Fitzgibbon A, Lazebnik S, Perona P, et al. Computer vision-ECCV 2012. Lecture notes in computer science. Heidelberg: Springer, 2012, 7575: 702- 715.

[15] DanelljanM, HägerG, Shahbaz KF, et al.Accurate scale estimation for robust visual tracking[C]∥Proceedings of the British Machine Vision Conference, September 1-5, 2014, Nottingham, University of Nottingham.UK: BMVA Press, 2014.

[16] Sevilla-LaraL, Learned-MillerE. Distribution fields for tracking[C]∥2012 IEEE Conference on Computer Vision and Pattern Recognition, June 16-21, 2012, Providence, RI, USA. New York: IEEE, 2012: 1910- 1917.

[17] Zhang KH, ZhangL, Yang MH. Real-time compressive tracking[M] ∥Fitzgibbon A, Lazebnik S, Perona P, et al. Computer vision - ECCV 2012. Lecture notes in computer science. Heidelberg: Springer, 2012, 7574: 864- 877.

许敬祥, 伍雪冬, 杨开运. 基于高斯输出约束的上下文相关滤波跟踪[J]. 激光与光电子学进展, 2020, 57(4): 041508. Jingxiang Xu, Xuedong Wu, Kaiyun Yang. Context-Aware Correlation Filter Tracking Based on Gaussian Output Constraint[J]. Laser & Optoelectronics Progress, 2020, 57(4): 041508.