基于目标提取与引导滤波增强的红外与可见光图像融合  下载: 1056次

下载: 1056次

1 引言

图像融合是将取自同一区域的不同光谱与空间细节信息的两幅或多幅图像通过一定的算法融合到单幅图像中[1]。红外图像依据物体的热辐射特性成像,虽然它可以突出目标信息,但其主要呈现的是场景的概貌。可见光图像根据物体的光谱反射特性成像,可准确地展现边缘、纹理细节,并能捕获到图像的背景信息,但其易受照明、气候等外部因素影响。红外与可见光图像融合可综合地利用红外图像与可见光图像背景细节清晰的互补特性,在多源信息挖掘、大数据分析、地质资源勘探等领域有着重要应用[2]。

图像融合方法主要可划分为基于空间域和基于变换域两类方法。基于变换域的图像融合方法当前受到的关注较多,这类方法大多是基于拉普拉斯金字塔(LP)变换、主成分分析(PCA)变换、小波(WT)变换、Contourlet变换等多尺度分解的融合方法[3-5]。其中,基于小波变换的方法是较为典型的多尺度分解融合方法。而小波变换受方向数的限制无法更稀疏地表示图像的边缘、纹理细节信息。为此,人们相继提出了Contourlet变换、非下采样Contourlet变换(NSCT)[6]、Shearlet变换[7]等更稀疏的信号表示方法。Shearlet变换作为一种高维信号稀疏表示方法,能更有效地捕获图像的细节信息。非下采样Shearlet变换(NSST)[8]由Shearlet变换改进而来,且具备移不变性。吴一全等[9-10]证实了其融合结果比其他多尺度分解融合方法包含更多的细节信息。图像融合中,NSST变换虽可较好地实现源图像的多尺度分解与重建,但如何设计融合规则对融合效果也甚为关键。郭明等[11]先分割红外图像以提取目标区域,再采用替代法融合低频分量,所得融合图像目标较为突出,但目标区域不够准确,含有一些非目标区域和噪声点。高颖等[12]结合区域生长法与Canny算子,提取的目标较为完整、准确,但未充分发掘可见光图像隐藏的背景细节。邢素霞等[13]依据Renyi熵分割出目标区域,并在NSCT域对可见光图像进行自适应增强,但其存在对图像细节过增强和噪声放大的问题,导致融合图像某些区域过亮,掩盖了一些细节。Kong等[14]提出了基于NSCT变换的图像融合方法,避免了伪Gibbs现象,在捕捉背景信息方面表现较好,但目标不够突出,融合图像的对比度低。

本文针对以往融合方法在光线昏暗、背景和目标灰度相近时,融合图像易出现背景细节信息没有充分发掘和目标不够准确、突出的问题,提出了一种基于目标提取与引导滤波增强的红外与可见光图像融合方法。首先依据二维Tsallis熵和基于图的视觉显著性(GBVS)模型提取红外图像中的目标区域;然后分别对红外和可见光图像进行NSST变换,并对两幅源图像的低频分量进行引导滤波增强,融合图像的低频分量目标区域系数选自增强后的红外图像目标区域的低频分量,而非目标区域系数选自增强后的可见光图像对应区域的低频分量;融合图像的高频分量采用方向子带信息和取大的方法选取融合系数。最后,将本文方法与基于LP变换、基于WT、基于平稳小波变换(SWT)、基于NSCT变换[15]、基于目标提取与NSCT变换[13]等5种融合方法的实验结果进行了比较,验证了本文方法的优越性。

2 非下采样Shearlet变换

Shearlet变换是一种新的多尺度分解方法,可通过对基本函数的一系列仿射变换生成基函数。当维数等于2时,根据能量有限函数生成的合成膨胀仿射系统形式为

式中

相较于Shearlet变换,NSST具有移不变性,能够更准确地捕获图像中的纹理、边缘、细节信息。NSST变换包括多尺度分解和方向局部化两部分,具体步骤如下:1)采用非下采样金字塔分解源图像,获得低频、高频分量;2)高频分量的方向局部化则通过改进的剪切滤波器实现。它能够将Shearlet中的标准剪切滤波器从Pseudo-Polar坐标系映射到Cartesian坐标系,免去了降采样操作,使得NSST分解后图像尺寸不变;最后,通过傅里叶逆变换进行二维卷积,得到NSST系数。

3 基于Tsallis灰度熵和GBVS模型的红外图像目标提取

3.1 基于二维Tsallis灰度熵的红外图像分割

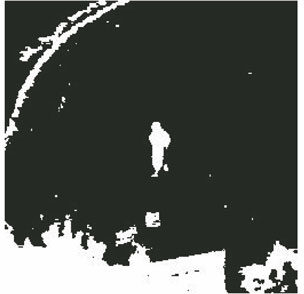

红外图像依据热辐射进行成像,具有良好的目标指向性。首先采用二维Tsallis灰度熵[16]对红外图像进行阈值分割实现目标的粗提取。然而使用二维Tsallis熵对红外图像进行分割提取出来的区域不仅包括目标区域,还包括一些背景区域和孤立的噪声点等非目标区域,如

图 1. 基于二维Tsallis灰度熵的分割结果

Fig. 1. Segmentation result based on two-dimensional Tsallis gray entropy

3.2 基于GBVS模型的红外图像目标提取

给定一幅图像,视觉注意模型根据特定显著度衡量方法提取图像中的显著性区域。GBVS模型[17]是对经典视觉注意模型Itti的改进。该模型首先使用高斯金字塔低通滤波器组和Gabor金字塔滤波器组对源图像进行滤波,分别得到多尺度下的亮度特征图和方向特征图。GBVS显著度衡量方法如下:特征图

式中

式中

式中

图 2. 精确目标提取示意图。(a)显著图阈值分割结果;(b)最终提取的目标区域

Fig. 2. Schematic of accurate target extraction. (a) Threshold segmentation result of significant map; (b) final extracted target region

4 NSST域低频分量及高频分量的融合

红外图像反映热目标信息,可见光图像体现场景的背景细节信息。图像融合的最终目的是使目标突出、背景细节清晰,故在图像融合前对红外图像进行了目标提取。在此基础上,将红外图像与可见光图像分别进行NSST变换,得到各自对应的低频分量与高频分量;然后对低频分量的目标区域、背景区域分别进行融合,高频分量则根据方向子带信息和取大来确定;最后进行NSST反变换得到红外与可见光融合图像。

4.1 基于引导滤波增强与目标提取的NSST域低频分量融合

一般来说,低频分量包含图像的绝大部分能量。可见光图像具有背景信息丰富的特点,但其对比度往往不高,隐藏了较多细节信息,因此对可见光图像进行增强可有效发掘其细节特征。与此同时,对红外图像进行增强可突出热目标信息,使其能够在背景增强的前提下保持目标与背景的对比度。引导滤波[18]作为一种新型的图像滤波算法,在滤掉噪声的同时,能更好地保护图像边缘。为了增强可见光图像中的细节信息、突出红外图像的热目标,在图像融合前分别对可见光图像和红外图像进行引导滤波增强。引导滤波增强算法的原理是源图像与其经引导滤波后输出的图像相减得到细节图像,将此细节图像与滤波后图像经加权得到增强图像。若在空域上直接采用引导滤波增强算法增强图像,较易引起图像噪声放大,且考虑到绝大部分噪声集中在图像的高频分量,故仅对两幅源图像NSST域的低频分量利用引导滤波进行增强。

令待滤波图像为

式中

约束条件为在满足(5)式线性变换关系的同时,最小化输入输出图像之间差的平方为

式中

式中

将

式中

式中

鉴于红外图像主要反映目标信息,而可见光图像的背景信息相对更为丰富,利用二维Tsallis熵和GBVS模型对红外图像进行目标提取,得到目标区域和背景区域。并分别对可见光图像及红外图像NSST域上的低频分量进行引导滤波增强,以发掘更多背景细节、凸显目标和保持目标与背景的对比度。融合后图像低频分量的目标区域系数选自增强后红外图像目标区域低频分量,背景区域系数选择对应区域的增强后可见光图像低频分量,这样得到的融合图像低频分量可以完整地保留红外图像的显著目标和可见光图像的背景细节。

4.2 基于方向子带信息和的NSST域高频分量融合

图像经NSST分解得到的高频分量反映了图像的细节信息。对高频分量的处理直接影响了融合图像的清晰程度以及边缘细节信息的保持程度。NSST系数模值大的地方,说明该处存在明显的细节。由于高频带通分量的稀疏性,显著特征在同一尺度所有方向子带上系数模值都较大,而其他非显著特征系数模值接近于零。所以,根据每个像素同一尺度上的方向子带信息足以区分并提取该像素上的细节。此外,高频分量数据量较大,基于区域特征的融合规则所需时间较长,而所提出的高频融合规则既可较好地融合可见光图像与红外图像互补的边缘及纹理细节,又可加快高频分量的融合速度。源图像在尺度

式中2

4.3 本文融合方法的流程图及具体步骤

基于目标提取与引导滤波增强的红外与可见光图像融合方法的流程如

融合方法的具体步骤如下:

1) 对红外图像通过二维Tsallis熵和基于GBVS的视觉注意模型提取目标区域;

2) 对红外图像及可见光图像分别进行NSST分解;

3) 对于两幅源图像NSST域的低频分量和高频分量,使用不同的融合规则进行处理:先进行引导滤波增强,对增强后的低频分量采用基于引导滤波增强与目标提取的融合规则进行融合,而高频分量利用方向子带信息和取大的方法进行融合;

4) 对处理后的低频分量和高频分量进行NSST逆变换,获得最终的融合结果。

5 实验结果与分析

为了验证本文方法的有效性,针对大量红外图像和可见光图像进行了融合实验,并与基于LP变换、基于WT、基于SWT、基于NSCT[15]和文献[

13]中基于目标提取与NSCT变换等5种方法的融合结果进行了比较。其中,WT方法、SWT方法的小波基函数为“bior3.7”,分解层数为2。为了更为合理地比较融合结果,对前3种方法,即LP方法、WT方法、SWT方法均采用常用的低频求平均、高频取大的融合规则。其中的实验图像均来源于常用红外与可见光图像融合测试数据集“UN Camp”。由于篇幅限制,现以3组大小均为256×256且已进行过配准的红外图像和可见光图像融合为例进行说明。

图 4. 3组可见光图像和红外图像。(a)第1组可见光图像;(b)第1组红外图像;(c)第2组可见光图像;(d)第2组红外图像;(e)第3组可见光图像;(f)第3组红外图像

Fig. 4. Three groups of visible images and infrared images. (a) Visible image of group 1; (b) infrared image of group 1; (c) visible image of group 2; (d) infrared image of group 2; (e) visible image of group 3; (f) infrared image of group 3

![本文方法和文献[13]方法从2幅红外图像中提取的目标。(a)本文方法从图4(b)提取的目标;(b)本文方法从图4(d)提取的目标;(c)本文方法从图4(f)提取的目标;(d)文献[13]方法从图4(b)提取的目标;(e)文献[13]方法从图4(d)提取的目标;(f)文献[13]方法从图4(f)提取的目标](/richHtml/gxxb/2017/37/8/0810001/img_5.jpg)

图 5. 本文方法和文献[ 13]方法从2幅红外图像中提取的目标。(a)本文方法从图4(b)提取的目标;(b)本文方法从图4(d)提取的目标;(c)本文方法从图4(f)提取的目标;(d)文献[ 13]方法从图4(b)提取的目标;(e)文献[ 13]方法从图4(d)提取的目标;(f)文献[ 13]方法从图4(f)提取的目标

Fig. 5. Targets extracted from two infrared images by the proposed method and the method in Ref. [13]. (a) Targets extracted from the Fig. 4(b) by the proposed method; (b) targets extracted from the Fig. 4(d) by the proposed method; (c) targets extracted from the Fig. 4(f) by the proposed method; (d) targets extracted from the Fig. 4(b) by the method in Ref. [13]; (e) targets extracted from the Fig. 4(d) by the method in Ref. [13] ; (f) targets extracted from the Fig. 4(f) by the method in Ref. [13]

从

![第1组图像的融合结果。 (a) LP方法;(b) WT方法;(c) SWT方法;(d) NSCT方法;(e)文献[13]方法;(f)本文方法](/richHtml/gxxb/2017/37/8/0810001/img_6.jpg)

图 6. 第1组图像的融合结果。 (a) LP方法;(b) WT方法;(c) SWT方法;(d) NSCT方法;(e)文献[ 13]方法;(f)本文方法

Fig. 6. Fusion results on the images of group 1. (a) LP method; (b) WT method; (c) SWT method;(d) NSCT method; (e) method in Ref. [13]; (f) proposed method

![第2组图像的融合结果。 (a) LP方法;(b) WT方法;(c) SWT方法;(d) NSCT方法;(e)文献[13]方法;(f)本文方法](/richHtml/gxxb/2017/37/8/0810001/img_7.jpg)

图 7. 第2组图像的融合结果。 (a) LP方法;(b) WT方法;(c) SWT方法;(d) NSCT方法;(e)文献[ 13]方法;(f)本文方法

Fig. 7. Fusion results on the images of group 2. (a) LP method; (b) WT method; (c) SWT method;(d) NSCT method; (e) method in Ref. [13]; (f) proposed method

左下部树叶与中部灌木丛处的纹理细节较模糊;SWT方法所得融合图像的边缘较模糊,目标与背景对比度不强、目标不清晰;NSCT方法较好地保留了可见光图像的地物轮廓,但仍存在图像对比度不高、背景较模糊的问题。与前面4种方法相比,文献[

13]方法所得融合图像对比度有所提高,包含的细节信息也更丰富,但

![第3组图像的融合结果。 (a) LP方法;(b) WT方法;(c) SWT方法;(d) NSCT方法;(e)文献[13]方法;(f)本文方法](/richHtml/gxxb/2017/37/8/0810001/img_8.jpg)

图 8. 第3组图像的融合结果。 (a) LP方法;(b) WT方法;(c) SWT方法;(d) NSCT方法;(e)文献[ 13]方法;(f)本文方法

Fig. 8. Fusion results on the images of group 3. (a) LP method; (b) WT method; (c) SWT method; (d) NSCT method; (e) method in Ref. [13]; (f) proposed method

为了进一步对上述6种不同融合方法所得到的实验结果进行客观定量评价,选取信息熵、平均梯度、相关系数、空间频率、扭曲度和标准差等作为客观定量评价指标[19]。信息熵用来衡量图像所包含的信息量,其值越大,融合图像所含的信息越多;平均梯度可以反映图像微小细节反差及纹理变化,用来评价图像的清晰度,其值越高,图像越清晰;相关系数反映了融合图像与可见光图像的相关程度,其值越大,则融合图像保持可见光图像的结构信息越好;空间频率是反映图像的总体活跃程度,其值越大,图像越活跃;扭曲度反映了图像的失真程度,其值越小,则说明图像失真越轻微;标准差反映了图像灰度相对于灰度平均值的离散情况,图像的标准差越大,则图像的灰度级越分散,图像反差越大,所含的信息更丰富。

表 1. 6种图像融合方法的定量评价结果

Table 1. Quantitative evaluation results of six image fusion methods

|

从

6 结论

提出了一种基于目标提取与引导滤波增强的红外与可见光图像融合方法。该方法充分利用了NSST的多分辨率分析等性质,通过目标提取与引导滤波增强算法处理原始红外图像与可见光图像,从而对经NSST分解后的高低频分量设计不同的融合规则,更好地完成了红外和可见光图像的融合。大量实验结果表明,该图像融合方法在主观视觉效果和客观定量评价指标上均优于基于LP变换、基于WT变换、基于SWT变换、基于NSCT变换、基于目标提取与NSCT变换等方法,不仅能够有效突出目标,而且发掘了更多背景细节信息,是一种行之有效的红外和可见光图像融合方法。

[1] Wang R, Du L. Infrared and visible image fusion based on random projection and sparse representation[J]. International Journal of Remote Sensing, 2014, 35(5): 1640-1652.

Wang R, Du L. Infrared and visible image fusion based on random projection and sparse representation[J]. International Journal of Remote Sensing, 2014, 35(5): 1640-1652.

[2] Zhao J, Gao X, Chen Y, et al. Multi-window visual saliency extraction for fusion of visible and infrared images[J]. Infrared Physics & Technology, 2016, 76: 295-302.

Zhao J, Gao X, Chen Y, et al. Multi-window visual saliency extraction for fusion of visible and infrared images[J]. Infrared Physics & Technology, 2016, 76: 295-302.

[3] 夏余, 曲仕茹, . 改进. 2D) 2PCA的彩色图像融合框架 [J]. 光学学报, 2014, 34(10): 1010001.

夏余, 曲仕茹, . 改进. 2D) 2PCA的彩色图像融合框架 [J]. 光学学报, 2014, 34(10): 1010001.

[4] 张肃, 付强, 段锦, 等. 基于提升小波的低对比度目标偏振识别技术[J]. 光学学报, 2015, 35(2): 0211002.

张肃, 付强, 段锦, 等. 基于提升小波的低对比度目标偏振识别技术[J]. 光学学报, 2015, 35(2): 0211002.

[5] 刘坤, 郭雷, 常威威. 基于Contourlet变换的区域特征自适应图像融合算法[J]. 光学学报, 2008, 28(4): 681-686.

刘坤, 郭雷, 常威威. 基于Contourlet变换的区域特征自适应图像融合算法[J]. 光学学报, 2008, 28(4): 681-686.

[6] Cunha A L, Zhou J P, Do M N. The non-subsampled contourlet transform: theory, design, and applications[J]. IEEE Transactions on Image Processing, 2006, 15(10): 3089-3101.

Cunha A L, Zhou J P, Do M N. The non-subsampled contourlet transform: theory, design, and applications[J]. IEEE Transactions on Image Processing, 2006, 15(10): 3089-3101.

[7] Guo K, Labate D. Labate D. Optimally sparse multidimensional representation using shearlets[J]. SIAM Journal on Mathematical Analysis, 2007, 39(1): 298-318.

Guo K, Labate D. Labate D. Optimally sparse multidimensional representation using shearlets[J]. SIAM Journal on Mathematical Analysis, 2007, 39(1): 298-318.

[8] Easley G, Labate D, Lim W Q. Sparse directional image representations using the discrete shearlet transform[J]. Applied & Computational Harmonic Analysis, 2008, 25(1): 25-46.

Easley G, Labate D, Lim W Q. Sparse directional image representations using the discrete shearlet transform[J]. Applied & Computational Harmonic Analysis, 2008, 25(1): 25-46.

[9] 吴一全, 陶飞翔. 改进投影梯度NMF的NSST域多光谱与全色图像融合[J]. 光学学报, 2015, 35(4): 0410005.

吴一全, 陶飞翔. 改进投影梯度NMF的NSST域多光谱与全色图像融合[J]. 光学学报, 2015, 35(4): 0410005.

[10] Kong W W. Technique for gray-scale visual light and infrared image fusion based on non-subsampled shearlet transform[J]. Infrared Physics & Technology, 2014, 63(11): 110-118.

Kong W W. Technique for gray-scale visual light and infrared image fusion based on non-subsampled shearlet transform[J]. Infrared Physics & Technology, 2014, 63(11): 110-118.

[11] 郭明, 王书满. 基于区域和方向方差加权信息熵的图像融合[J]. 系统工程与电子技术, 2013, 35(4): 720-724.

郭明, 王书满. 基于区域和方向方差加权信息熵的图像融合[J]. 系统工程与电子技术, 2013, 35(4): 720-724.

Guo Ming, Wang Shuman. Image fusion based on region and directional variance weighted entropy[J]. Systems Engineering & Electronics, 2013, 35(4): 720-724.

Guo Ming, Wang Shuman. Image fusion based on region and directional variance weighted entropy[J]. Systems Engineering & Electronics, 2013, 35(4): 720-724.

[12] 高颖, 王阿敏, 支朋飞, 等. 基于区域分割与提升小波变换的图像融合算法[J]. 西北工业大学学报, 2014, 32(4): 569-575.

高颖, 王阿敏, 支朋飞, 等. 基于区域分割与提升小波变换的图像融合算法[J]. 西北工业大学学报, 2014, 32(4): 569-575.

Gao Ying, Wang Amin, Zhi Pengfei, et al. Image fusion algorithm based on region segmentation and lifting wavelet transform[J]. Journal of Northwestern Polytechnical University, 2014, 32(4): 569-575.

Gao Ying, Wang Amin, Zhi Pengfei, et al. Image fusion algorithm based on region segmentation and lifting wavelet transform[J]. Journal of Northwestern Polytechnical University, 2014, 32(4): 569-575.

[13] 邢素霞, 肖洪兵, 陈天华, 等. 基于目标提取与NSCT的图像融合技术研究[J]. 光电子·激光, 2013, 24(3): 583-588.

邢素霞, 肖洪兵, 陈天华, 等. 基于目标提取与NSCT的图像融合技术研究[J]. 光电子·激光, 2013, 24(3): 583-588.

Xing Suxia, Xiao Hongbing, Chen Tianhua, et al. Study of image fusion technology based on object extraction and NSCT[J]. Journal of Optoelectronics·Laser, 2013, 24(3): 583-588.

Xing Suxia, Xiao Hongbing, Chen Tianhua, et al. Study of image fusion technology based on object extraction and NSCT[J]. Journal of Optoelectronics·Laser, 2013, 24(3): 583-588.

[14] Kong W, Lei Y, Ni X. Fusion technique for grey-scale visible light and infrared images based on non-subsampled contourlet transform and intensity-hue-saturation transform[J]. IET Signal Processing, 2011, 5(1): 75-80.

Kong W, Lei Y, Ni X. Fusion technique for grey-scale visible light and infrared images based on non-subsampled contourlet transform and intensity-hue-saturation transform[J]. IET Signal Processing, 2011, 5(1): 75-80.

[15] 郭明, 符拯, 奚晓梁. 基于局部能量的NSCT域红外与可见光图像融合算法[J]. 红外与激光工程, 2012, 41(8): 2229-2235.

郭明, 符拯, 奚晓梁. 基于局部能量的NSCT域红外与可见光图像融合算法[J]. 红外与激光工程, 2012, 41(8): 2229-2235.

Guo Ming, Fu Zheng, Xi Xiaoliang. Novel fusion algorithm for infrared and visible images based on local energy in NSCT domain[J]. Infrared & Laser Engineering, 2012, 41(8): 2229-2235.

Guo Ming, Fu Zheng, Xi Xiaoliang. Novel fusion algorithm for infrared and visible images based on local energy in NSCT domain[J]. Infrared & Laser Engineering, 2012, 41(8): 2229-2235.

[16] 李积英, 党建武, 王阳萍. 融合量子克隆进化与2维Tsallis熵的医学图像分割算法[J]. 计算机辅助设计与图形学学报, 2014, 26(3): 465-471.

李积英, 党建武, 王阳萍. 融合量子克隆进化与2维Tsallis熵的医学图像分割算法[J]. 计算机辅助设计与图形学学报, 2014, 26(3): 465-471.

Li Jiying, Dang Jianwu, Wang Yangping. Medical image segmentation algorithm based on quantum clonal evolution and two-dimensional Tsallis entropy[J]. Journal of Computer-Aided Design & Computer Graphics, 2014, 26(3): 465-471.

Li Jiying, Dang Jianwu, Wang Yangping. Medical image segmentation algorithm based on quantum clonal evolution and two-dimensional Tsallis entropy[J]. Journal of Computer-Aided Design & Computer Graphics, 2014, 26(3): 465-471.

[17] HarelJ, KochC, PeronaP. Graph-based visual saliency[C]. Advances in Neural Information Processing Systems, 2007, 19: 545- 552.

HarelJ, KochC, PeronaP. Graph-based visual saliency[C]. Advances in Neural Information Processing Systems, 2007, 19: 545- 552.

[18] He K, Sun J, Tang X. Guided image filtering[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2013, 35(6): 1397-1409.

He K, Sun J, Tang X. Guided image filtering[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2013, 35(6): 1397-1409.

[19] 尹雯, 李元祥, 周则明, 等. 基于稀疏表示的遥感图像融合方法[J]. 光学学报, 2013, 33(4): 0428003.

尹雯, 李元祥, 周则明, 等. 基于稀疏表示的遥感图像融合方法[J]. 光学学报, 2013, 33(4): 0428003.

Article Outline

吴一全, 王志来. 基于目标提取与引导滤波增强的红外与可见光图像融合[J]. 光学学报, 2017, 37(8): 0810001. Yiquan Wu, Zhilai Wang. Infrared and Visible Image Fusion Based on Target Extraction and Guided Filtering Enhancement[J]. Acta Optica Sinica, 2017, 37(8): 0810001.