基于掩模重构与动态注意力的跨模态行人重识别  下载: 682次【增强内容出版】

下载: 682次【增强内容出版】

1 引言

近年来,随着计算机视觉技术的不断发展,行人重识别(Re-ID)[1]在视频监控、安保和智慧城市等领域得到越来越多的关注和应用,其目标是在多个不重叠的相机之间检索同一身份的行人。可见光相机在夜间的成像能力不足,在黑暗条件下无法收集具有区别性的图像。为解决这一问题,跨模态行人重识别使用红外相机来拍摄夜间图像,通过对两种相机收集的图像进行匹配,实现跨可见光模态和红外模态的行人检索。但由于不断变化的相机和背景环境,模态差异和背景杂波对跨模态匹配影响较大。此外,由于遮挡、光照和姿态变化等因素的存在,网络容易提取到过多无关信息,从而无法进行准确的跨模态匹配。

针对以上问题,Wu等[2]提出了一种单流深度零填充网络来提取模态共享特征,缓解了跨模态差异。Gao等[3]提出了一种新的交叉模态知识蒸馏(CMKD)损失,在特征提取阶段缩小了特定模态特征间的差异。Sun等[4]提出了一种水平划分网络PCB(part-based convolutional baseline),将特征水平划分为若干个局部特征,隐式地利用行人身体部位来削弱背景杂波的影响。Dai等[5]提出了一种跨模态生成对抗网络(cmGAN),从两个不同的模态图像中生成交叉模态图像,将所生成的图像和真实的图像组合以产生混合的多光谱图像,并结合身份损失和跨模态三元组损失来最小化类间差异并最大化跨模态相似性。Zhao等[6]提出了Spindle Net,该网络分别捕获来自行人不同身体区域的语义特征,将来自不同语义区域的特征进行合并,有效地保留了判别特征。这些方法通常侧重于通过对卷积网络提取到的特征进行处理来缓解背景杂波的影响,忽视了网络源头对输入图像的处理,不能较好地解决遮挡、光照和姿态变化等因素引起的模态内差异问题,同时特征划分和对齐会破坏图像的原有结构,从而产生额外的噪声。

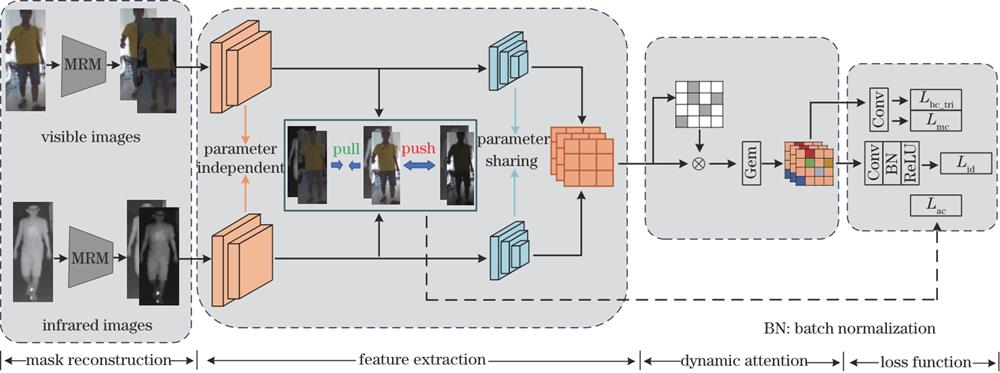

本文提出了一种基于掩模重构与动态注意力(MRDA)的网络,旨在消除背景干扰影响并动态提取判别特征。由于相机环境不断变化,图像背景复杂多样,因此提出掩模重构模块(MRM),在图像输入端构造掩模,通过掩模重构人体区域和背景区域,以此来消除背景杂波的影响,增强网络对背景变化的鲁棒性。然后将来自不同模态的特征对齐投影到公共子空间中。针对遮挡、光照和姿态变化等因素引起的模态内差异较大的问题,设计了一种动态注意力模块(DAM),动态挖掘并增强人体占比权重较大的区域,以此获得具有辨别力的判别特征。在两个公共数据集上验证了MRDA网络的优越性。在SYSU-MM01数据集的all-search模式下,与当前性能表现较好的MCLNet[7]相比,该网络的第一个检索结果匹配成功的概率(Rank-1)和均值平均精度(mAP)分别高出5.15和1.91个百分点。在RegDB数据集的visible-to-infrared检索模式下,该网络的Rank-1和mAP比MCLNet分别高出11.49和9.01个百分点,证明了相对于当前跨模态行人重识别方法,该网络具有较大优势。

2 方法

2.1 网络总体框架

可见光相机和红外相机的光谱特性及拍摄环境不同,导致模态差异和背景杂波的影响较大,并且低分辨率、遮挡和人体姿态不同等原因会使网络无法提取到具有辨别力的特征,因此,提出了一种适用于跨模态的MRDA网络,其网络结构如

2.2 掩模重构模块

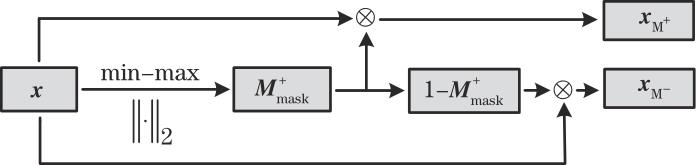

随着深度学习在图像分割领域的应用迅速发展,出现了全卷积网络(FCN)[8]、条件随机区域(CRF)算法[9]、基于区域的卷积神经网络(Mask R-CNN)[10]以及大规模人类分割数据集[11],它们可以较好地获得人体掩模。所提掩模重构模块通过最大-最小归一化来计算人体掩模,相对于复杂的FCN和Mask R-CNN网络结构来说简单且易于实现,无须进行复杂的模型训练或使用大规模数据集;相对于CRF等迭代算法来说,该模块计算复杂度较低、耗费时间短、所需计算资源更少。所提掩模重构模块通过在输入端生成掩模来重新构造图像的人体区域和背景区域,并在浅层卷积层约束原始图像特征与人体区域特征之间的距离,以缓解背景杂波的影响,其结构如

在数据加载时,随机抽取

式中:

将这对掩模应用于原始输入图像

式中:

2.3 特征提取模块

将ResNet50[13]作为骨干网络(ResNet50具有较深的网络结构,能够提取丰富的语义信息,有助于区分不同行人的特征),通过引入残差结构[13]来解决深层网络训练中的梯度消失问题。相对于ResNet18和ResNet34等低层次的网络结构,ResNet50拥有更多的层级和参数,可以提取更丰富和多样化的特征;相对于ResNet101和ResNet152等更深层次的网络结构,ResNet50具有较少的参数量,可以更快地进行训练和推理,并且网络层次过深会产生过拟合的风险,使网络模型的泛化性能下降。

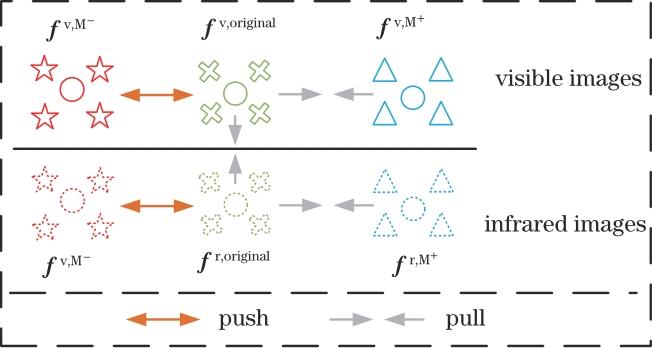

采用双流网络的结构,如

式中:

式中:

如

式中,

2.4 动态注意力模块

由于遮挡、光照和姿态变化等模态内差异因素的影响,网络难以提取到具有辨别力的重要特征。对此,文献[14-15]提出利用辅助姿态估计器和语义解析技术来对齐图像间的语义相关区域。但这些方法需要额外的数据集,并且计算开销大。文献[16]和文献[17]分别提出瓶颈注意力模块(BAM)和卷积块注意力模块(CBAM),以不同的方式将空间注意力和通道注意力相结合,在空间和通道两个维度计算注意力权重,以获取全局与局部之间的联系,在全局中增强局部特征。文献[18]提出模态内加权局部注意力模块(IWPAM),以学习局部聚合特征,自适应地为不同特征分配不同权重。但这些方法均需要对全部特征进行运算,这会导致网络计算过多无用信息,浪费计算资源。对此,本研究提出了动态注意力模块,动态地寻找全局中权重较大的局部区域,挖掘并增强具有辨别力的特征。动态注意力模块的结构如

首先将ResNet50网络提取到的特征

通过求

式中,

式中:

式中,

如

式中:

式中:

式中:

与其他注意力模块的对比结果如

表 1. DAM与其他注意力模块的对比

Table 1. Comparison of DAM and other attention modules

|

2.5 目标函数

使用交叉熵损失和中心三元组损失[19]对MRDA网络进行约束,以优化实例级上的特征分布;通过标签平滑运算[20]防止模型训练过拟合。给定一个图像,

式中:

式中:

式中,

3 实验结果与分析

3.1 数据集和评估协议

SYSU-MM01数据集[2]是中山大学提出的大规模跨模态行人重识别数据集,共采集了491个行人的图像,其中包含由4个可见光相机拍摄的287628幅可见光行人图像以及2个红外相机拍摄的15792幅红外行人图像。训练集有395个行人图像,测试集有96个行人图像。SYSU-MM01数据集包含all-search和indoor-search两种模式。在all-search模式下,gallery集由4个可见光相机拍摄的图像组成,query集由2个红外相机拍摄的图像组成;在indoor-search模式下,gallery集只包含2个可见光相机拍摄的图像,query集包含2个红外相机拍摄的图像。测试阶段包括mutil-shot和single-shot两种检索模式,在mutil-shot模式下的gallery集中,每个行人包含多张图像,而在sing-shot模式下的gallery集中,每个行人仅包含一张图像。对于all-search和indoor-search两种模式,均采用single-shot模式设置进行实验。

RegDB数据集[22]是一个小规模数据集,包含一个可见光相机和一个远红外相机采集的412个行人的图像,每个行人都有10张可见光图像和10张红外图像。为确保实验的科学性,利用10次交叉验证法将数据集进行随机划分,训练集和测试集各包含2060张可见光图像和2060张红外图像。测试阶段包括visible-to-infrared和infrared-to-visible两种检索模式,研究采用visible-to-infrared模式进行实验。

利用累积匹配特征(CMC)[23]和mAP作为评估指标,其中CMC指前R个检索结果中匹配成功的概率,用Rank-R表示。

3.2 实验设置

实验环境配置为GeForce RTX 2080TI、CUDA10和PyTorch1.7。在开始训练前,batch size设置为36,包含3个行人的18张可见光图像和18张红外图像。对每一个行人,随机选择6张可见光图像和6张红外图像。在训练阶段,使用随机梯度下降(SGD)算法进行优化,动量参数设置为0.9。采用预热学习率策略,学习率初始值为0.1,经过20和50个epoch后分别衰减至0.10和0.01。

3.3 消融实验

在SYSU-MM01数据集的all-search模式下进行消融实验,以验证MRDA网络及所提模块的有效性。

1)特征提取模块。将输入数据进行预处理后输入到特征提取模块中,以此作为实验的基线网络(baseline)。如

表 2. 在SYSU-MM01数据集all-search single-shot模式下的实验结果

Table 2. Experimental results in all-search single-shot mode of the SYSU-MM01 dataset

|

2)掩模重构模块。如

3)动态注意力模块。如

综上所述,各个模块都能有效地帮助模型提升其性能,掩模重构模块与动态注意力模块在协同工作时效果最好,Rank-1和mAP达到了70.55%和63.89%,较baseline分别提升了7.34和4.02个百分点。说明MRDA网络能够有效地消除光照、背景及姿态变化等因素的影响,缩小模态差异。

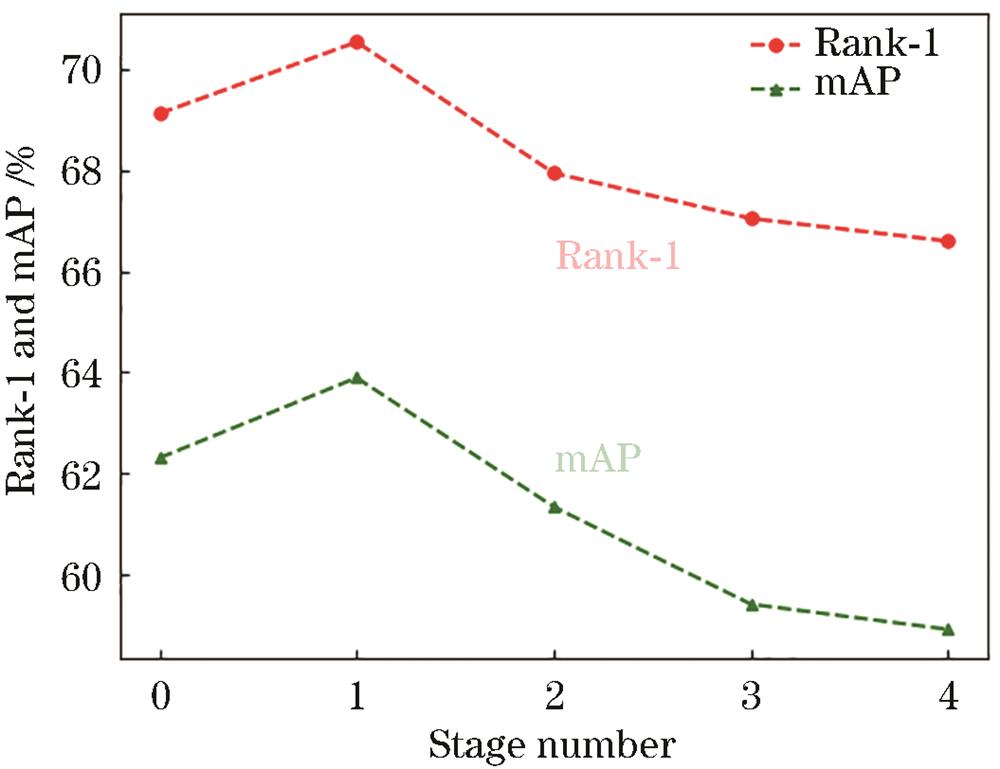

为探索在双流网络中进行掩模重构约束学习的具体位置,在ResNet50的若干个stage之后分别进行实验,以实现更好的掩模重构约束学习,构建具有独立参数的模态特定特征提取器和具有共享参数的模态共享特征提取器。

对卷积模块stage 0到stage 4后的特征分别进行实验,实验结果如

图 6. 在不同stage进行约束学习的实验结果

Fig. 6. Experimental results of constraint learning at different stages

3.4 可视化分析

为进一步分析MRDA网络的有效性,在SYSU-MM01数据集上对特征分布进行可视化实验。通过T-SNE算法[24]将高维特征向量转化为二维特征向量,

图 7. 特征分布可视化。(a)Baseline特征降维结果;(b)MRDA网络特征降维结果;(c)baseline特征距离分布;(d)MRDA网络特征距离分布

Fig. 7. Feature distribution visualization. (a) Baseline feature dimensionality reduction results; (b) MRDA network feature dimensionality reduction results; (c) baseline feature distance distribution; (d) MRDA network feature distance distribution

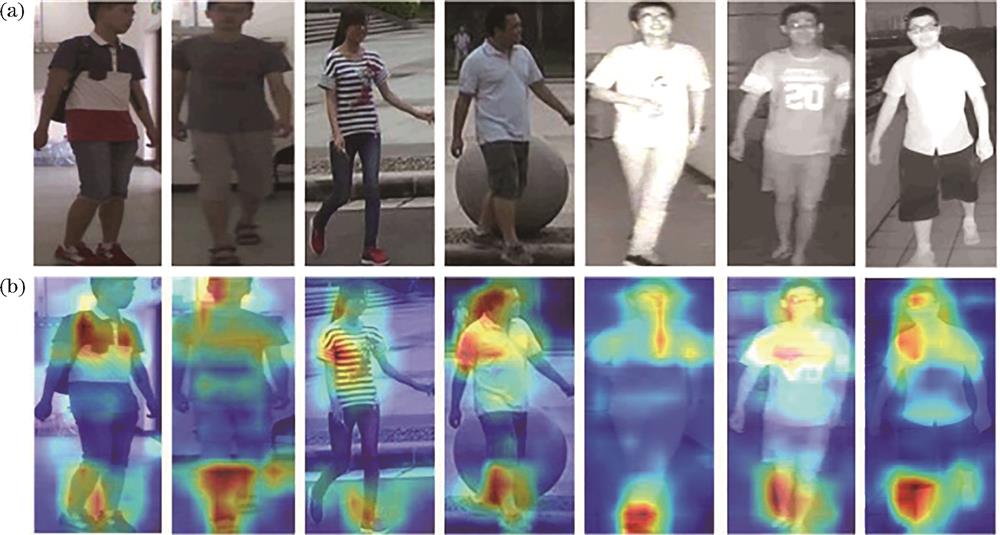

为了验证MRDA网络能挖掘并增强重要判别特征,通过Grad-CAM[25]绘制热力图来可视化图像特征(热力图反映了网络所关注的区域)。

图 8. Grad-CAM可视化结果。(a)输入图像;(b)MRDA网络可视化结果

Fig. 8. Grad-CAM visualization results. (a) Input images; (b) MRDA network visualization results

为验证网络的检索能力,将检索结果进行可视化,

图 9. 在SYSU-MM01数据集上获得的top-10检索结果。(a)Baseline检索结果;(b)MRDA网络检索结果

Fig. 9. Top-10 retrieval results obtained on the SYSU-MM01 dataset. (a) Baseline retrieval results; (b) MRDA network retrieval results

3.5 与其他方法的对比

为验证MRDA网络的先进性,在SYSU-MM01和RegDB两个公共数据集上与近几年研究出的网络进行对比。加入对比的网络有Zero-Pad[2]、cmGAN[5]、D2RL[26]、Hi-CMD[27]、DDAG[18]、AGW[1]、MCLNet[7]、DML[28]、MAUMG[29]和MSFF[30]。

表 3. 在SYSU-MM01数据集all-search模式下与其他网络的对比结果

Table 3. Comparison results with other networks in the all-search mode of the SYSU-MM01 dataset

|

表 4. 在SYSU-MM01数据集indoor-search模式下与其他网络的对比结果

Table 4. Comparison results with other networks in the indoor-search mode of the SYSU-MM01 dataset

|

表 5. 在RegDB数据集上visible-to-infrared检索模式下与其他网络的对比结果

Table 5. Comparison results with other networks in the visible-to-infrared mode of the RegDB dataset

|

4 结论

针对跨模态行人重识别存在的模态内差异和背景干扰问题,提出了一种新颖的MRDA网络,该网络致力于通过掩模重构人体区域特征,动态提取具有辨别力的重要特征。一方面,通过掩模重构约束学习促使网络学习到更多的身体区域特征,减小背景区域的影响。另一方面,动态地寻找网络所关注的区域,挖掘并增强具有辨别力的特征。在两个公共数据集上进行消融实验和对比实验,实验结果验证了MRDA网络的先进性以及网络中各组成部分的有效性。下一步工作将对来自不同模态的特征进行特征匹配和对齐,进一步提升模型性能。

[1] Ye M, Shen J B, Lin G J, et al. Deep learning for person re-identification: a survey and outlook[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 44(6): 2872-2893.

[2] WuA C, ZhengW S, YuH X, et al. RGB-infrared cross-modality person re-identification[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE Press, 2017: 5390-5399.

[3] Gao G W, Shao H, Wu F, et al. Leaning compact and representative features for cross-modality person re-identification[J]. World Wide Web, 2022, 25(4): 1649-1666.

[4] SunY F, ZhengL, YangY, et al. Beyond part models: person retrieval with refined part pooling (and a strong convolutional baseline)[M]∥FerrariV, HebertM, SminchisescuC, et al. Computer vision-ECCV 2018. Lecture notes in computer science. Cham: Springer, 2018, 11208: 501-518.

[5] DaiP Y, JiR R, WangH B, et al. Cross-modality person re-identification with generative adversarial training[C]∥Proceedings of the 27th International Joint Conference on Artificial Intelligence, July 13-19, 2018, Stockholm, Sweden. New York: ACM Press, 2018: 677-683.

[6] ZhaoH Y, TianM Q, SunS Y, et al. Spindle Net: person re-identification with human body region guided feature decomposition and fusion[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE Press, 2017: 907-915.

[7] HaoX, ZhaoS Y, YeM, et al. Cross-modality person re-identification via modality confusion and center aggregation[C]∥2021 IEEE/CVF International Conference on Computer Vision (ICCV), October 10-17, 2021, Montreal, QC, Canada. New York: IEEE Press, 2022: 16383-16392.

[8] ShelhamerE, LongJ, DarrellT. Fully convolutional networks for semantic segmentation[C]∥IEEE Transactions on Pattern Analysis and Machine Intelligence, May 24, 2016, New York: IEEE Press, 2016: 640-651.

[9] Chen L C, Papandreou G, Kokkinos I, et al. DeepLab: semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834-848.

[10] HeK M, GkioxariG, DollárP, et al. Mask R-CNN[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE Press, 2017: 2980-2988.

[11] WuZ F, HuangY Z, YuY N, et al. Early hierarchical contexts learned by convolutional networks for image segmentation[C]∥2014 22nd International Conference on Pattern Recognition, August 24-28, 2014, Stockholm, Sweden. New York: IEEE Press, 2014: 1538-1543.

[12] DengJ, DongW, SocherR, et al. ImageNet: a large-scale hierarchical image database[C]∥2009 IEEE Conference on Computer Vision and Pattern Recognition, June 20-25, 2009, Miami, FL, USA. New York: IEEE Press, 2009: 248-255.

[13] HeK M, ZhangX Y, RenS Q, et al. Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE Press, 2016: 770-778.

[14] MiaoJ X, WuY, LiuP, et al. Pose-guided feature alignment for occluded person re-identification[C]∥2019 IEEE/CVF International Conference on Computer Vision (ICCV), October 27-November 2, 2019, Seoul, Korea (South). New York: IEEE Press, 2020: 542-551.

[15] KalayehM M, BasaranE, GökmenM, et al. Human semantic parsing for person re-identification[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE Press, 2018: 1062-1071.

[17] WooS, ParkJ, LeeJ Y, et al. CBAM: convolutional block attention module[M]∥FerrariV, HebertM, SminchisescuC, et al. Computer vision-ECCV 2018. Lecture notes in computer science. Cham: Springer, 2018, 11211: 3-19.

[18] YeM, ShenJ B, CrandallD J, et al. Dynamic dual-attentive aggregation learning for visible-infrared person re-identification[M]∥VedaldiA, BischofH, BroxT, et al. Computer vision-ECCV 2020. Lecture notes in computer science. Cham: Springer, 2020, 12362: 229-247.

[19] Liu H J, Tan X H, Zhou X C. Parameter sharing exploration and hetero-center triplet loss for visible-thermal person re-identification[J]. IEEE Transactions on Multimedia, 2021, 23: 4414-4425.

[20] LuoH, GuY Z, LiaoX Y, et al. Bag of tricks and a strong baseline for deep person re-identification[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPRW), June 16-17, 2019, Long Beach, CA, USA. New York: IEEE Press, 2020: 1487-1495.

[21] FuC Y, HuY B, WuX, et al. CM-NAS: cross-modality neural architecture search for visible-infrared person re-identification[C]∥2021 IEEE/CVF International Conference on Computer Vision (ICCV), October 10-17, 2021, Montreal, QC, Canada. New York: IEEE Press, 2022: 11803-11812.

[22] Nguyen D T, Hong H G, Kim K W, et al. Person recognition system based on a combination of body images from visible light and thermal cameras[J]. Sensors, 2017, 17(3): 605.

[23] Moon H, Phillips P J. Computational and performance aspects of PCA-based face-recognition algorithms[J]. Perception, 2001, 30(3): 303-321.

[24] Laurens V D M, Hinton G. Visualizing data using T-SNE[J]. Journal of Machine Learning Research, 2008, 9(2605): 2579-2605.

[25] SelvarajuR R, CogswellM, DasA, et al. Grad-CAM: visual explanations from deep networks via gradient-based localization[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE Press, 2017: 618-626.

[26] WangZ X, WangZ, ZhengY Q, et al. Learning to reduce dual-level discrepancy for infrared-visible person re-identification[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 15-20, 2019, Long Beach, CA, USA. New York: IEEE Press, 2020: 618-626.

[27] ChoiS, LeeS M, KimY, et al. Hi-CMD: hierarchical cross-modality disentanglement for visible-infrared person re-identification[C]∥2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 13-19, 2020, Seattle, WA, USA. New York: IEEE Press, 2020: 10254-10263.

[28] Zhang D M, Zhang Z Z, Ju Y, et al. Dual mutual learning for cross-modality person re-identification[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2022, 32(8): 5361-5373.

[29] LiuJ L, SunY F, ZhuF, et al. Learning memory-augmented unidirectional metrics for cross-modality person re-identification[C]∥2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 18-24, 2022, New Orleans, LA, USA. New York: IEEE Press, 2022: 19344-19353.

[30] 王凤随, 闫涛, 刘芙蓉, 等. 融合子空间共享特征的多尺度跨模态行人重识别方法[J]. 电子与信息学报, 2023, 45(1): 325-334.

Wang F S, Yan T, Liu F R, et al. Multi-scale cross-modal pedestrian re-recognition method integrating subspace sharing features[J]. Journal of Electronics & Information Technology, 2023, 45(1): 325-334.

Article Outline

张阔, 范馨月, 李嘉辉, 张干. 基于掩模重构与动态注意力的跨模态行人重识别[J]. 激光与光电子学进展, 2024, 61(10): 1015001. Kuo Zhang, Xinyue Fan, Jiahui Li, Gan Zhang. Cross-Modal Person Re-Identification Based on Mask Reconstruction with Dynamic Attention[J]. Laser & Optoelectronics Progress, 2024, 61(10): 1015001.