多元信息聚合的人群密度估计与计数  下载: 811次

下载: 811次

1 引 言

随着我国人口的快速增长和城市化进程加快,大型人群聚集活动日益增多,这同时也带来了诸如人员拥挤导致踩踏事故、上班高峰交通调度压力等各种问题。因此,人群密度估计与计数已经成为公共安全领域的一个重要研究课题[1]。

目前,图像人群计数方法可分为基于检测的方法[2-3]和基于回归的方法[4-5]。基于检测的方法主要通过类似滑动窗口探测器检测图像中人员全身或者诸如脸、头等局部位置实现人群的计数,但随着图像中人员数量及遮挡现象的逐步加剧,检测效果明显下降[6-7]。基于回归的方法通过学习图像特征到人群数量之间的映射关系建立回归模型,预测人群数量[8]。进一步划分,可分为传统回归方法与深度学习回归方法。传统回归方法仅采用整体图像特征,导致图像空间和语义信息缺失,特征提取能力弱,无法满足密度逐渐增长的计数任务对精度的要求[9]。

近年来,卷积神经网络(Convolutional Neural Network,CNN)凭借出色的深层特征获取能力,在计算机视觉领域发展迅速[10-11],研究人员也将其应用于人群计数领域,并取得了较好的效果[12-13]。2015年,Wang等[14]首次提出适用于高密度人群的端到端CNN回归模型,但所提模型未考虑人群规模的变化,无法兼顾高低密度人群,导致在将该模型部署于新场景中时,计数精度明显下降。Zhang等[15]对算法模型跨场景使用时性能大幅度下降问题进行了研究,提出了一种多列结构人群计数网络,通过多列CNN结构,利用不同大小感受野并行提取行人多尺度信息,从而提高计数的准确性;在此基础上,MCNN[16]、Switching CNN[17]、MSCNN[18]等多列结构相继被提出,然而,由于多列结构每一列具有相似的学习功能,使其存在结构冗余现象,造成尺度信息提取效率及精度不尽人意。相较于多列结构,文献[19-22]提出利用单列结构获取图像特征的方法,在保证精度的同时提升网络的运算速度;但单列结构对空间信息和深层特征提取能力相对较弱,不能很好地适应视角变化带来的空间信息丢失以及遮挡带来的语义信息不足的问题,导致其在高密、多视角的人群场景下检测效果不稳定。

信息聚合是解决视角变化与遮挡问题的有效途径。文献[20]利用上下文空间金字塔对图像的局部和整体进行信息聚合,将全局上下文信息引入特征图中,提升密度图生成质量;但该方法并不能有效处理人数分布变化及图像特征信息丢失问题。Liu等[21]提出可感知尺度上下文网络(Context-Aware Network, CAN),通过聚合从多个不同大小感受野中提取的特征,获取了丰富的空间位置信息;但其特征提取能力及特征融合效率较低,应用于较密场景时效果不佳。文献[22]将主干网络的高低层特征直接融合,辅以通道注意力模块优化特征融合过程,利用空洞卷积扩大感受野、回归密度图;有效解决了透视导致的尺度多样性问题,但在特征融合时未考虑高低层特征之间的语义差距,精度仍有进一步提升的空间。文献[23]利用从“上-左-右-下”方向对视角变化进行信息编码,通过递进聚合方式捕获深层次全局上下文信息,同步提取多维度视角的尺度关系特征;在有效地解决视角问题的同时取得了较高的精度,但过于冗余的网络结构造成模型复杂度上升,网络运行速度减慢。

基于上述分析,本文提出了一种多元信息聚合的人群密度估计方法(Multivariate information aggregation,MIA)。首先,在特征提取部分,采用VGG-19作为骨架网络提取初始特征,利用多层语义监督策略提升低层特征质量,采用空间信息嵌入策略优化高层特征空间表征能力。其次,在信息聚合部分,设计双步长卷积轻量空洞空间金字塔池化结构(Simplify-atrous spatial pyramid pooling,S-ASPP)增大网络感受野,捕获丰富的上下文关系,利用逐点卷积与具有不同扩张率的步长卷积在保留ASPP特征聚合能力的同时降低网络冗余。最后,网络末端采用步长卷积进行上采样回归密度图,在保证精度的同时降低计算量。

2 多元信息聚合人群密度估计与计数

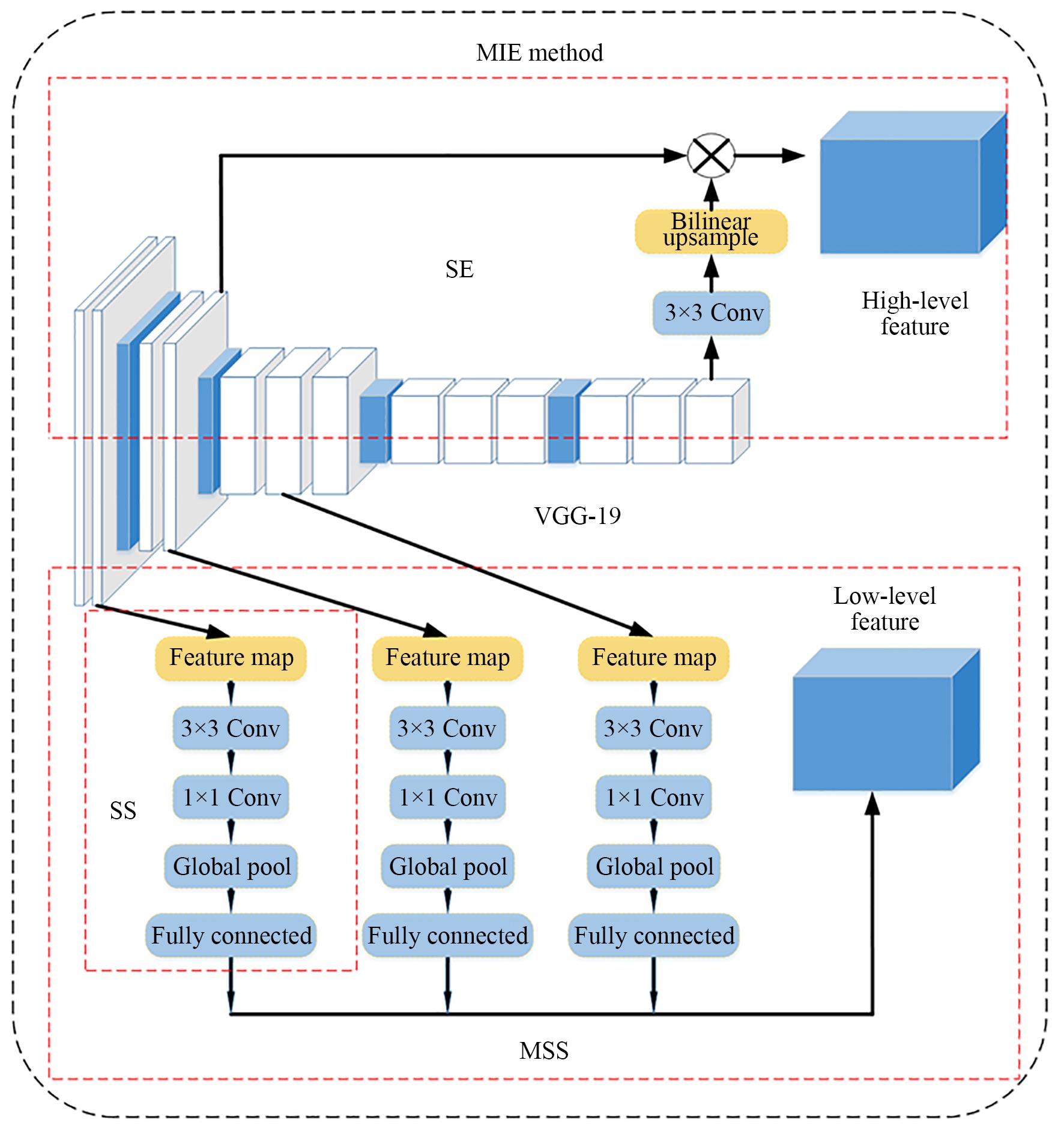

高效多语义空间信息聚合人群密度估计网络结构如图1所示,包括多元信息提取(Multivariate information extraction,MIE)部分、多尺度上下文信息聚合(Multi-scale context information aggregation,MCIA)部分及密度图回归部分。多元信息提取部分用于高低层特征的优化;多尺度上下文信息聚合部分用于丰富感受野,实现高低层特征的有效融合。

图 1. 高效多语义空间信息聚合人群密度估计网络结构

Fig. 1. Network structure of efficient multi-semantic spatial information aggregation crowd density estimation

2.1 多元信息提取网络

通常,低层特征含有丰富的空间细节但缺乏语义信息,高层特征含有丰富的语义信息但缺乏空间信息。将高低层特征进行直接融合是获得空间、语义信息全面性表达的常用手段。然而,这种直接融合的方式忽略了高低层特征之间语义层次和空间层次的差异,融合效果不佳,特征利用率较低。文献[24]证明,通过将更多语义信息引入低层特征或将更多空间信息嵌入高层特征可有效增强特征融合效果。基于此,本文提出一个如图2所示的高效多语义特征提取网络,用于强化高低层特征,为后续特征融合奠定基础。主要包括三部分:骨架网络VGG-19、多层语义监督策略(Multi Semantic Supervision,MSS)与空间信息嵌入策略(Spatial Embedding,SE)。

VGG-16网络架构对大部分物体检测提供了较为合适的感受野且易于捕获细节信息,是目前人群密度估计常用骨架网络之一。但对于高密度图像,VGG-16细节特征挖掘能力略显不足。因此,本文选择与VGG-16网络结构类似但有着更深网络层数的VGG-19网络获取更优的初始特征。实验证明,去除VGG-19网络全连接层对人群计数精度影响不大,且可有效降低网络参数,故本文采用去除全连接层的VGG-19作为骨架网络,在获取深层特征的同时缓解网络冗余。

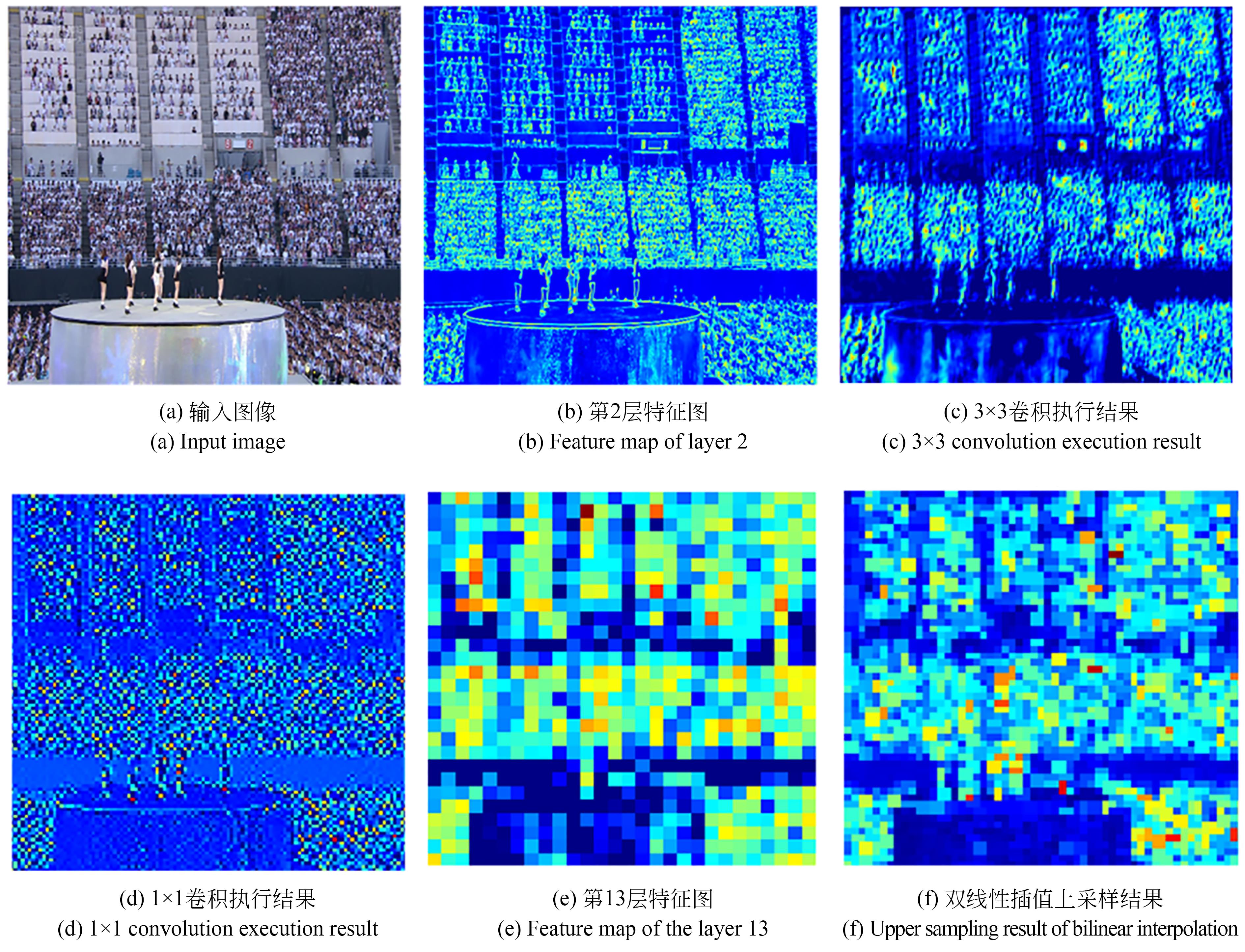

低层特征含有较多的位置、细节信息,但语义性低、噪声较多。针对此问题,本文提出如图2所示的多层语义监督策略MSS处理低层特征,设计三个语义监督模块(Semantic Supervision,SS)附着在VGG-19骨干网络的第2、4、6层,实现对骨干网络低层特征的优化。MSS和SE执行结果如图3所示,将图1中的示意图像作为输入,以其第2层特征图为例,说明SS模块的执行过程。首先通过一个3×3卷积和一个1×1卷积细化特征图输出,输出的特征图分别如图3(c)、3(d)所示,降低特征映射维数,增强特征细节表达;之后通过一个全局平均池化降低参数量,整合全局空间信息,形成语义边界约束,降低噪声干扰,生成带有部分语义信息的高质量低层特征。对其他层采取相似操作,组合各层输出,形成最终富含语义信息的高质量低层特征。

随着卷积层数加深,网络在获取富含语义信息的高层特征的同时也损失了较多的空间信息。如本文使用的VGG-19网络在第13层时特征图尺寸仅为输入图像的1/16。融合低层特征是为高层特征补充空间信息的有效途径之一,但直接融合的方式会因为特征图空间分辨率重叠度低带来部分语义信息损失。因此,为强化高层特征的空间表征能力,本文提出如图2中所示的空间信息嵌入策略SE。通过对VGG-19第13层特征采用双线性插值上采样,如图3(f)所示,将通道尺寸缩放至与第6层相同维度,进而将第6层特征与上采样后的特征逐元素相乘,优化特征融合方式,为高层特征补充空间信息的同时缓解因融合带来的语义信息损失,获取强化高层特征(High-level feature)。

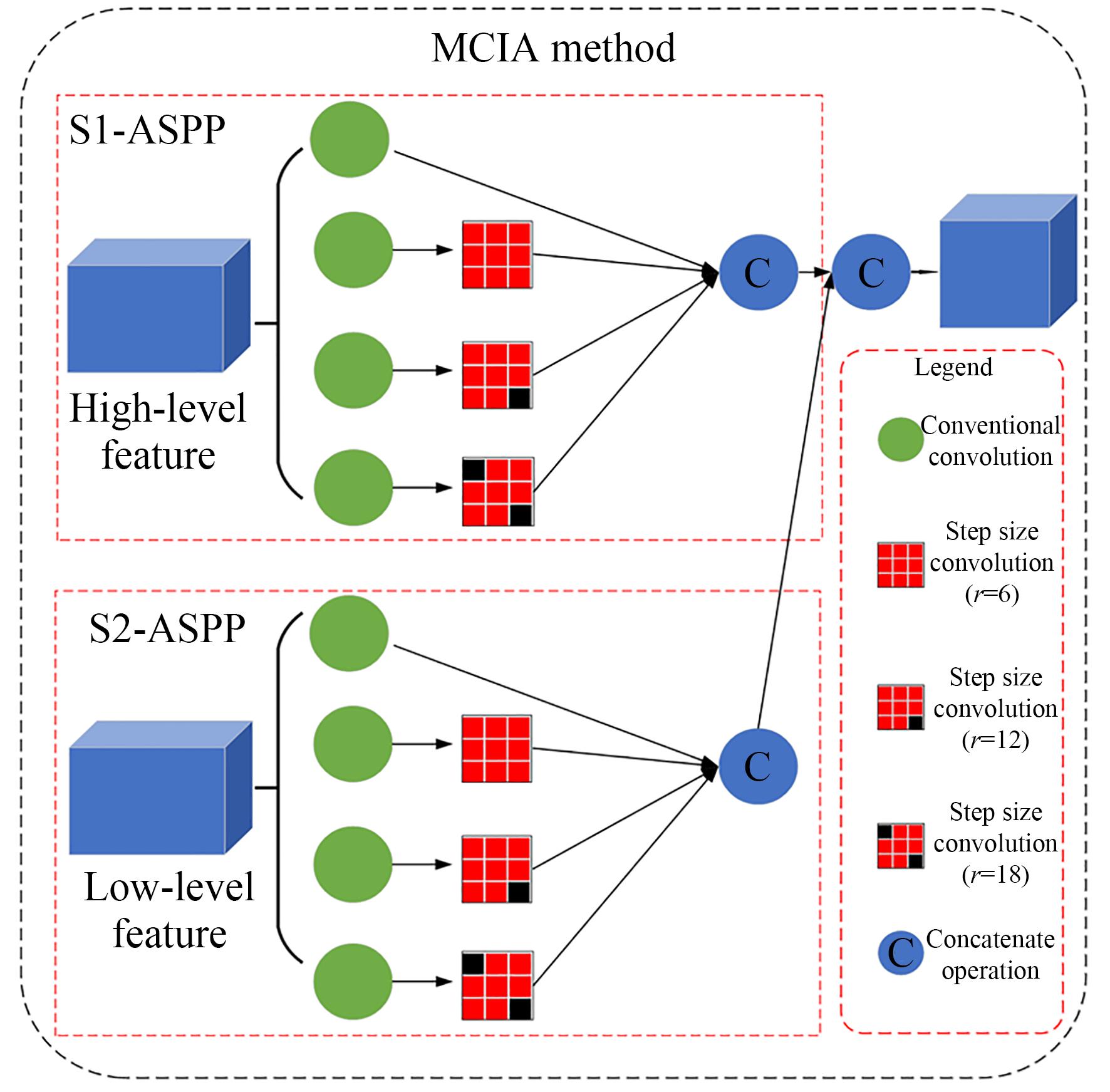

2.2 全局多尺度上下文信息聚合网络

捕捉丰富的上下文关系有助于网络对复杂场景的理解,是缓解人群密度估计中视角多变、遮挡以及尺度变换问题的有效途径。但在高密人群图像中,随着目标数量的增多,图像之间关联剧增,上下文信息在提升回归精度的同时,也无法避免地增加了模型计算量,制约了算法的实际应用部署与落地。因此,如何高效聚合多尺度上下文信息是实现高密人群密度估计的核心。本文提出如图4所示全局多尺度上下文信息聚合网络,通过两个轻量级空洞空间金字塔池化(Simplify-atrous spatial pyramid pooling,S-ASPP)模块逐级渐进捕获并融合低、高层特征不同尺度的上下文信息,在保证有限计算成本的前提下增强特征的全局性表达。为方便表述,将两个S-ASPP模块分别记作S1-ASPP、S2-ASPP。

2.2.1 S-ASPP模块

文献[25]提出空洞空间金字塔池化(Atrous spatial pyramid pooling,ASPP)思想,通过不同采样率的空洞卷积对特征图并行采样,扩张感受野,获取不同尺度的上下文信息。但ASPP在特征映射过程中信道占比较大,造成计算量高,模型冗余。基于此,本文设计轻量化空洞空间金字塔池化S-ASPP结构,以S1-ASPP为例:首先通过4个核大小为1的逐点卷积层,对多元信息提取网络得到的高层特征进行通道降维,执行信道信息交互;其次,采用类Inception结构,采用步长卷积(章节2.2.2予以详述)减小模型冗余,以1、6、12、18扩张率方式丰富特征图感受野,捕获更多上下文信息;最后,对处理后的特征图进行融合操作,增强特征的全局性表达。

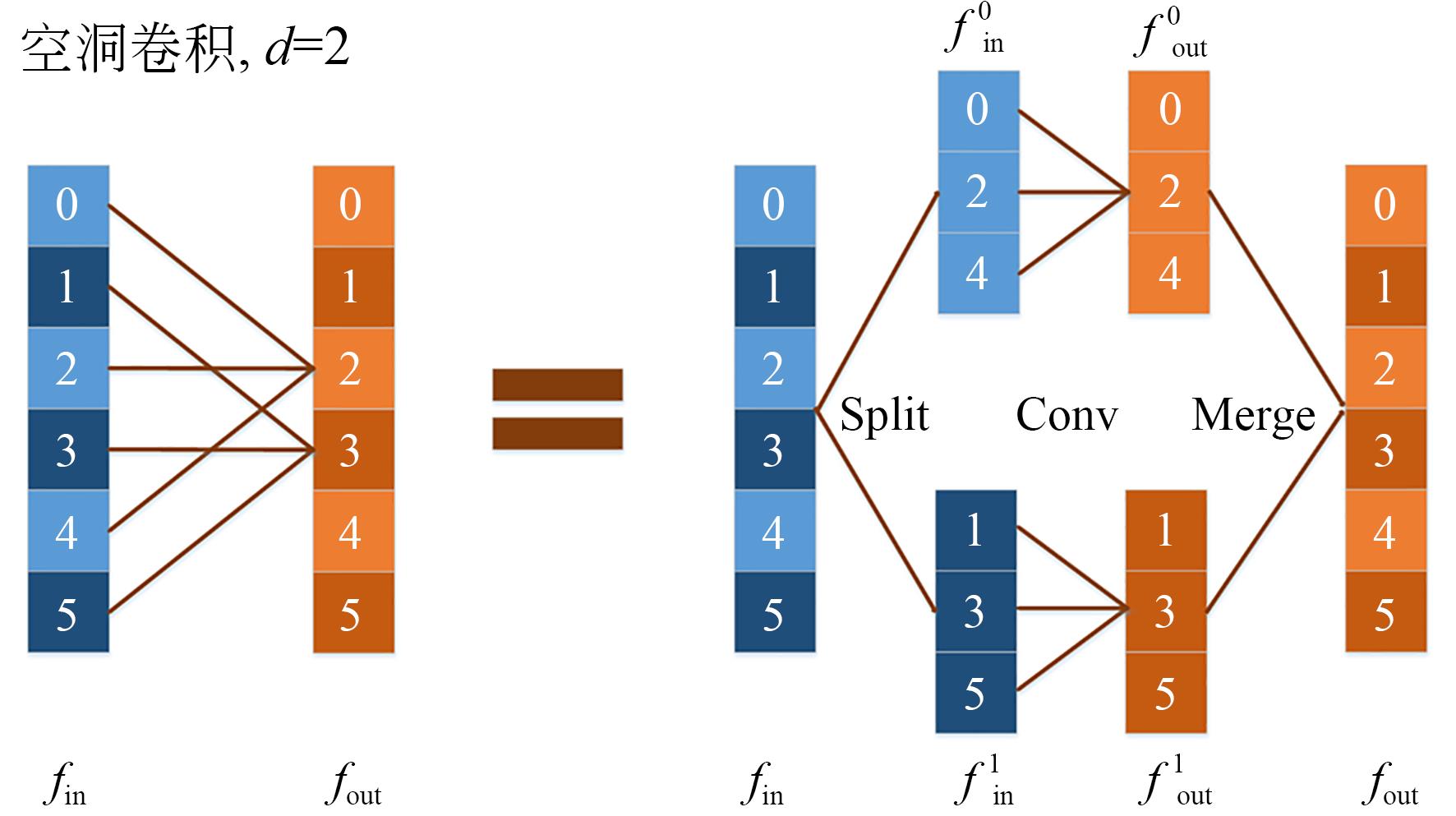

2.2.2 步长卷积

空洞卷积(Atrous Convolution)是常用的上采样方法之一,常规空洞卷积计算复杂度与计算代价较大。本文采用一种改进的空洞卷积,简化空洞卷积计算步骤,降低运行步长,其可被称作“步长卷积”。本文对具有同等空洞率的空洞卷积与步长卷积进行对比分析,验证步长卷积在卷积运算上的优势。

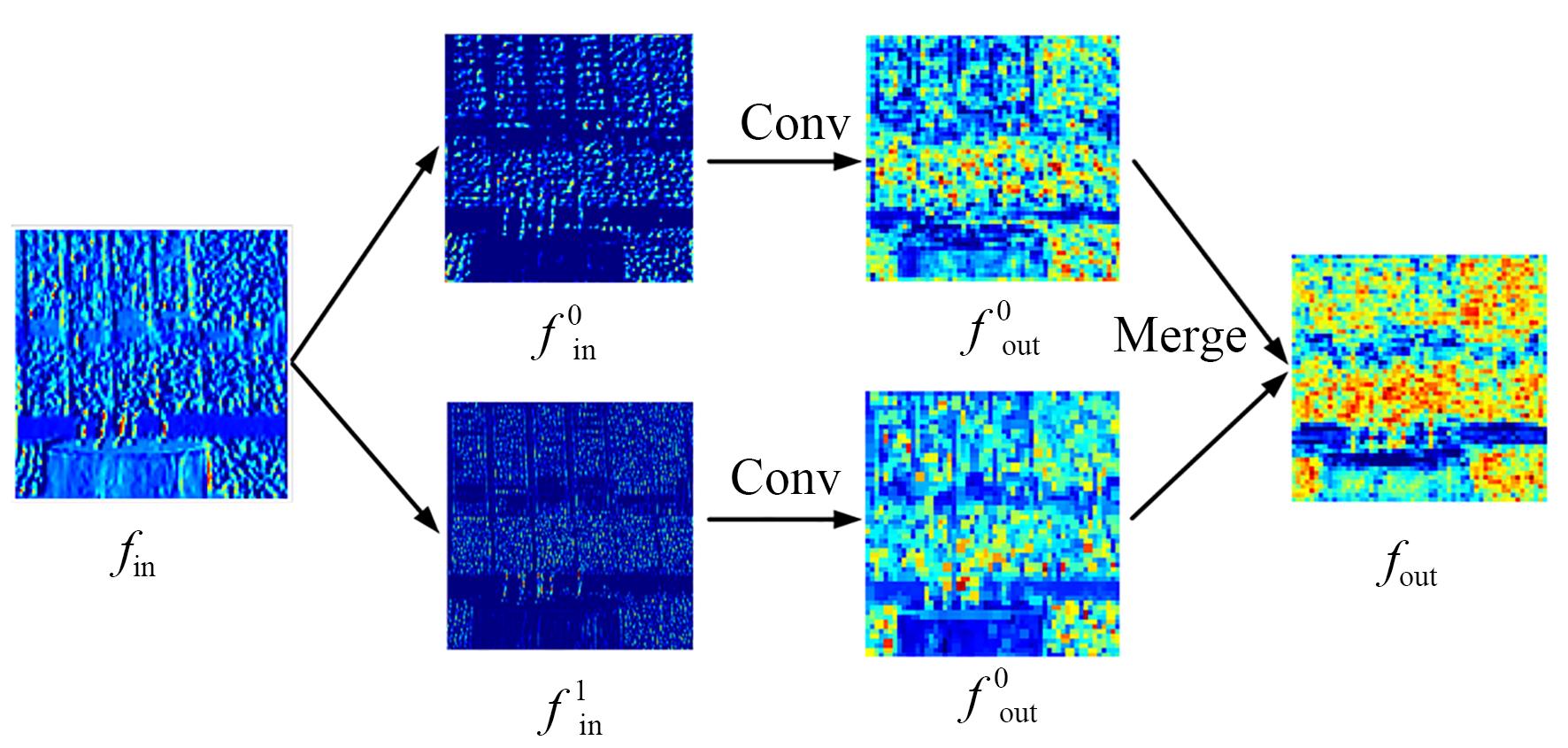

空洞卷积(以空洞率为2举例)在计算的过程中可以分为图5中所示的三步,图1中的示意图像执行空洞卷积操作的结果如图6所示。

(1)根据输入特征图像的奇偶性,将其分为两部分输入特征、;

(2)利用相同的卷积层处理特征、,得到两部分输出特征、;

(3)合并两部分输出特征,得到最终的输出结果。

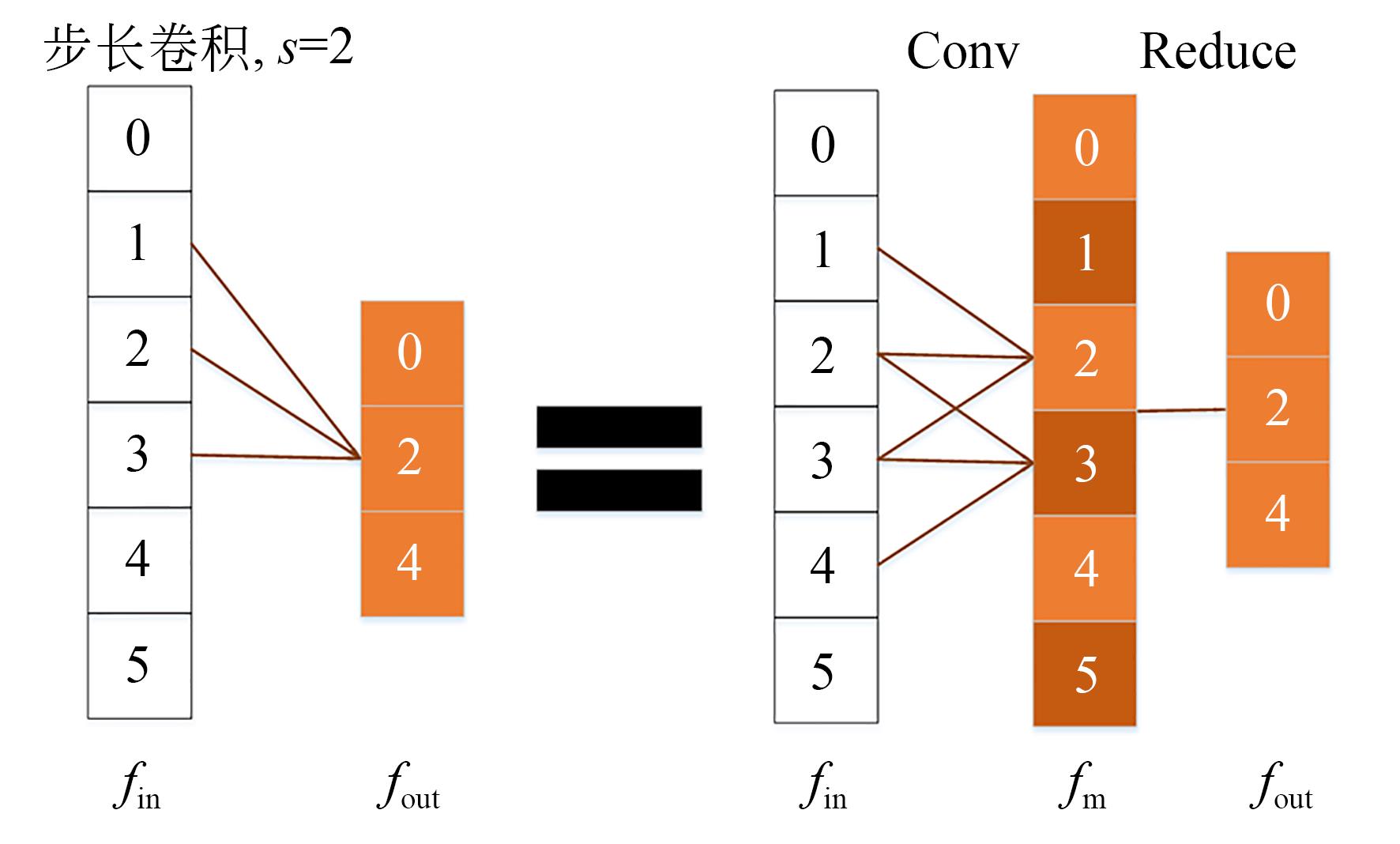

步长卷积计算过程等效于如图7中两步:

(1)对输入特征进行正则卷积,得到中间特征;

(2)移除带有奇数的元素,得到输出特征。

由上述步骤描述可知,步长卷积相较于常规空洞卷积有着参数量少的优点,且步长卷积在此过程中并未因参数量降低而影响密度图输出质量,只是等效的简化了空洞卷积的计算过程,因此在S-ASPP模块中使用步长卷积进行上采样操作,有效缓解了网络的冗余。

在网络末端进行密度图回归时,也需要进行上采样操作回归密度图,为进一步降低网络冗余,本文使用步长卷积执行密度图回归中的上采样任务。因方法一致,此处不再进行赘述。

3 实验结果与分析

本文及对比算法实验均在Ubuntu系统下进行,GPU型号为GTX2080Ti,实验软件环境配置为CUDA10.2+anaconda3.7+Python3.7+pytorch1.8。本文算法所有层均使用标准差为0.01的高斯分布初始化,网络初始训练学习率为10-4,迭代次数为1 200。

3.1 评价指标

人群密度估计领域的大部分研究均采用平均绝对误差(Mean Absolute Error,MAE)和均方误差(Mean Square Error,MSE)作为评价指标。为了能够较好地进行实验对比分析,本文也使用平均绝对误差和均方误差作为评价指标。

MAE反映网络预测人数与图像真值人数之间的误差,MSE描述网络预测人数与图像真值人数之间的差异程度,其定义分别为:

其中:为测试图像数量,为第幅测试图像的预测人数,为第幅测试图像的真实人数。

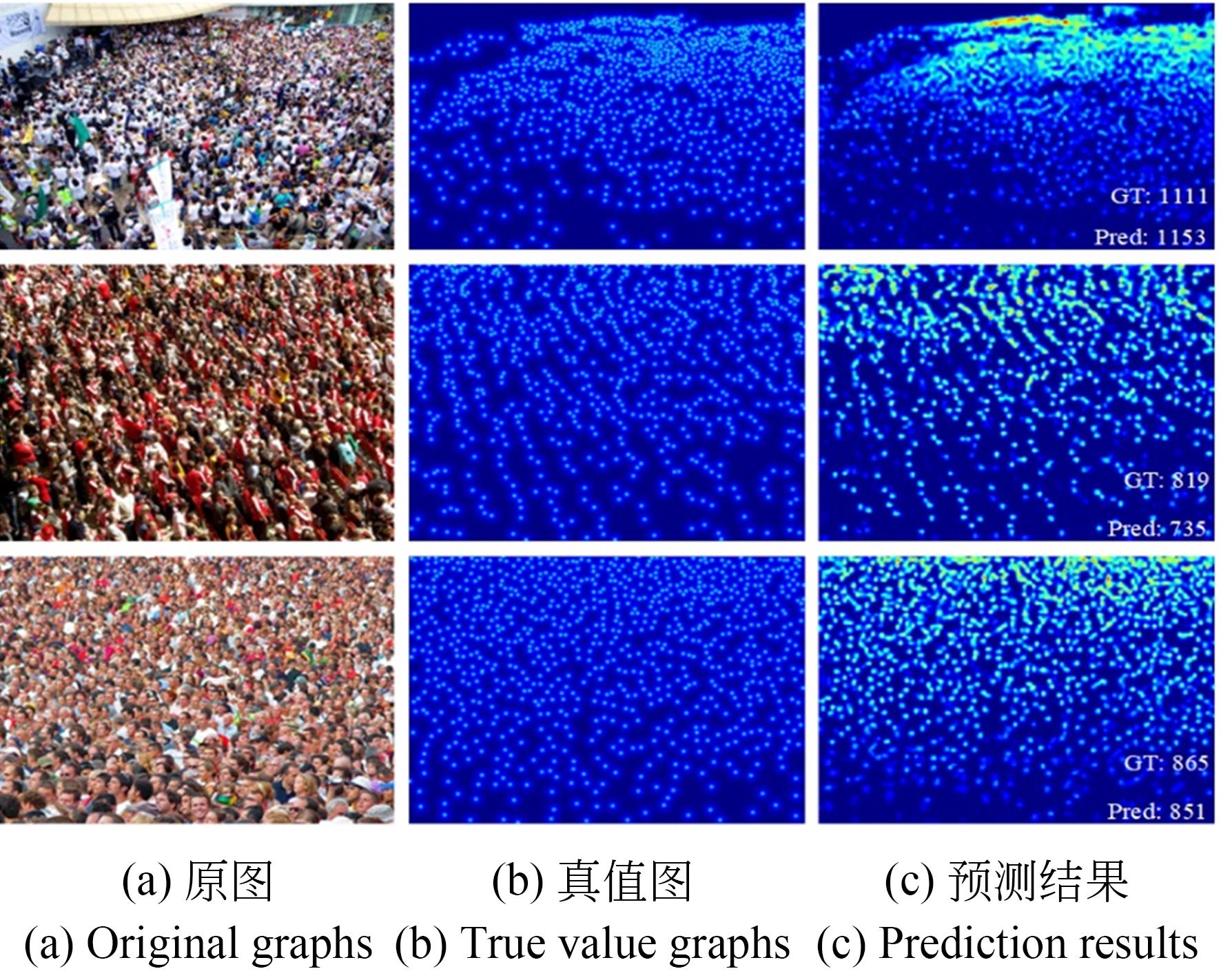

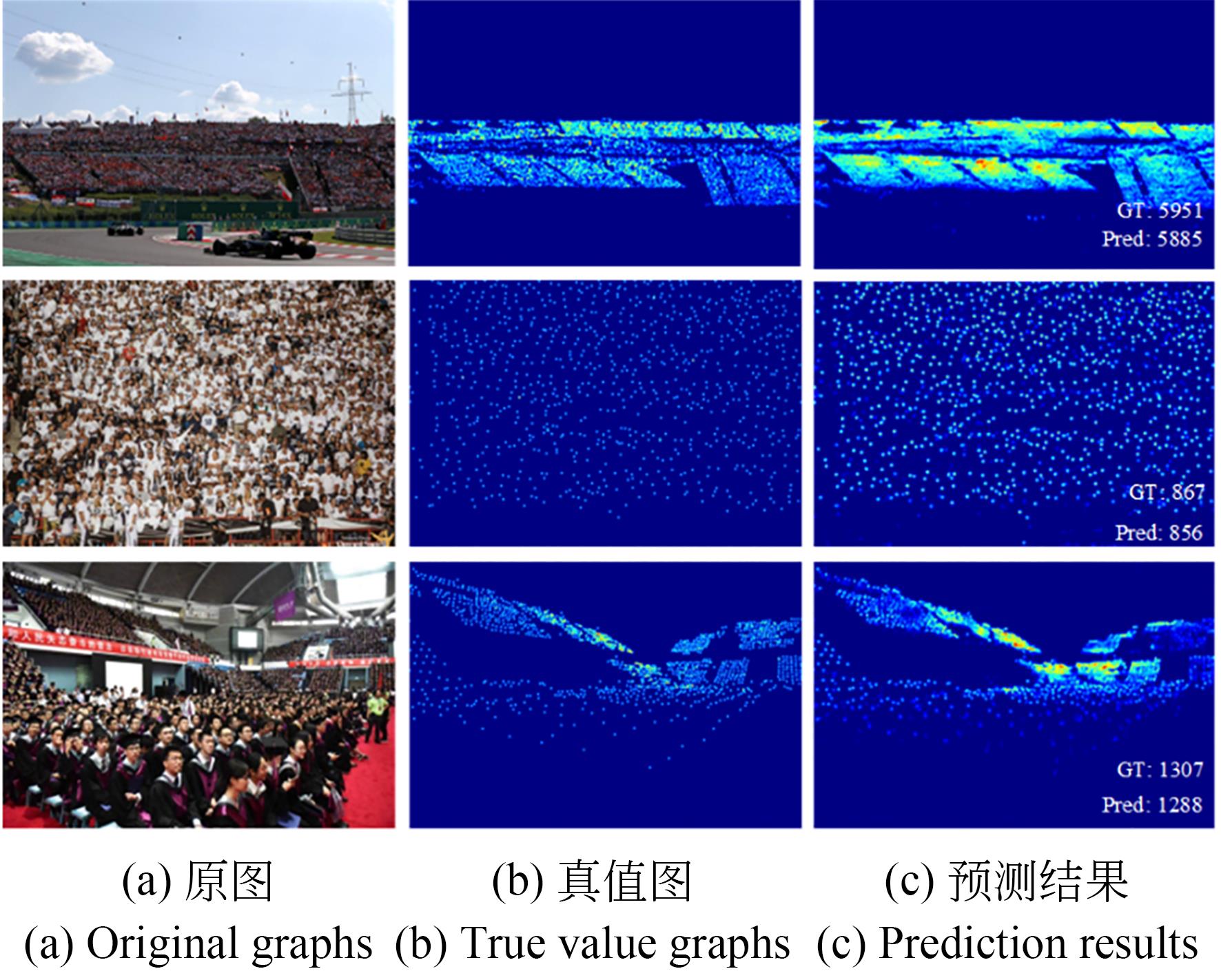

3.2 ShanghaiTech数据集实验与分析

ShanghaiTech数据集[16]是人群密度估计与计数领域的典型数据集,包含1 198幅图像,共计330 165个已标记人头。数据集共分为两部分,Part_A和Part_B。Part_A包含482幅图像,来源于互联网;Part_B包含716幅图像,来源于上海的街道,含有较多稀疏人群场景。本文将Part_A的300幅和Part_B的400幅图像用于训练,其余用于测试。ShanghaiTech数据集单幅图像实验结果如图8所示,多算法性能指标结果对比如表1所示。

表 1. ShanghaiTech数据集多算法性能指标结果对比

Table 1. Comparison of performance index results of multiple algorithm on ShanghaiTech

| |||||||||||||||||||||||||||||||||||||||||||||||||

由ShanghaiTech数据集实验结果可知,在Part_A中,本文算法MAE与文献[21]方法相比下降了2.9,MSE下降了3.8;在Part_B部分,与文献[21]方法相比,MAE下降了0.1,MSE下降了0.3,提升幅度较Part_A小。这主要由于本文多元信息提取方法侧重提升高密场景特征捕获能力,故在以密集人群为主的Part_A部分效果较好,而在以稀疏人群为主的Part_B部分检测精度虽有所提升,但提升幅度略小。

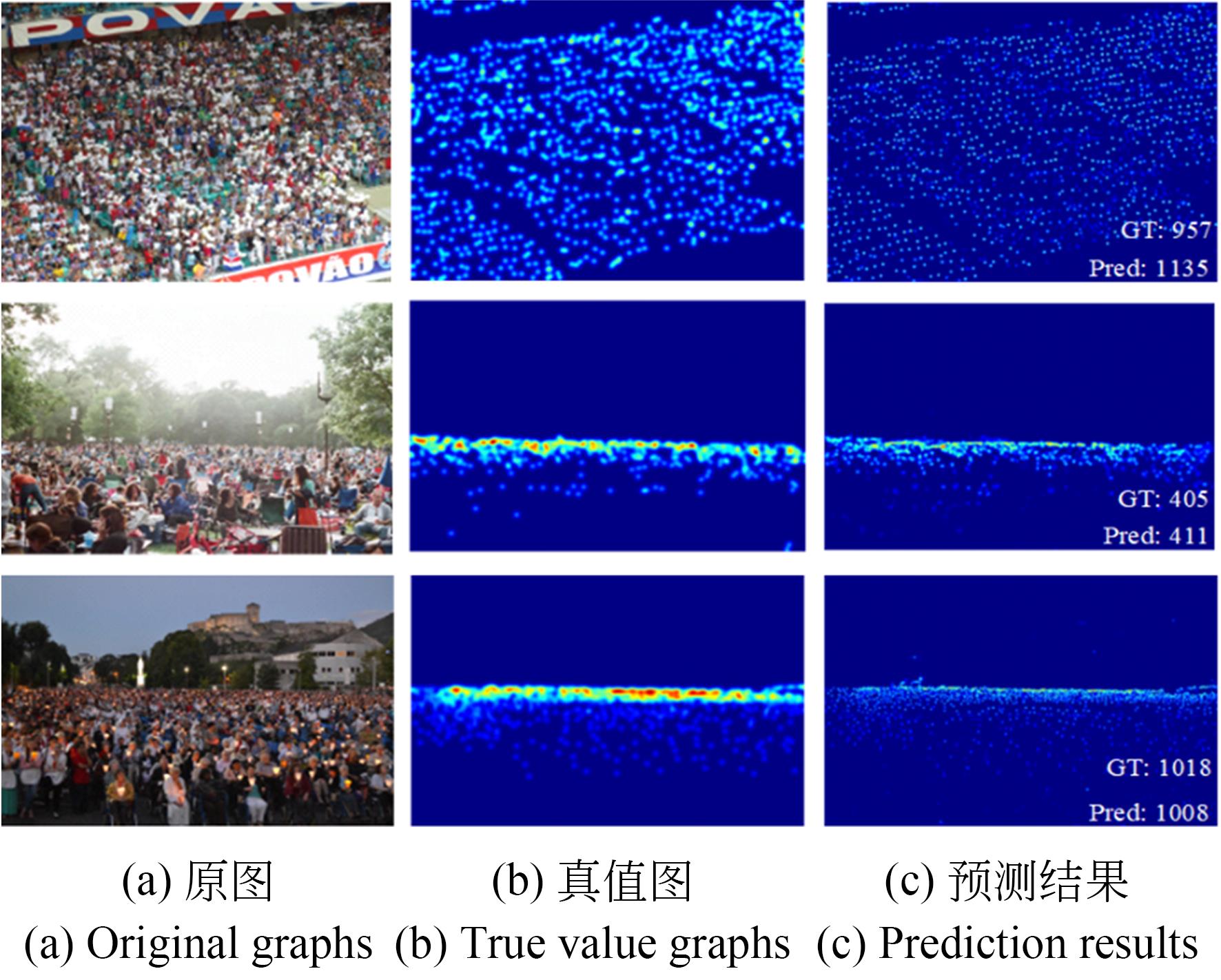

3.3 UCF-QNRF数据集实验与分析

近年来,人们越来越关注高密度场景的计数性能,用于超高密度场景计数性能评价的数据集UCF-QNRF[27]随之被提出。UCF-QNRF数据集拍摄于真实场景,包含建筑、植被、天空和道路等多样化背景,同时具有视角、密度、光照变化多样的特点。UCF-QNRF数据集包含1 535张图像,本文将其中1 201张用于训练和334张用于测试。UCF-QNRF数据集单幅图像实验结果如图9所示,多算法性能指标结果对比如表2所示。

表 2. UCF-QNRF数据集多算法性能指标结果对比

Table 2. Comparison of performance index results of multiple algorithms in UCF-QNRF

|

由实验结果可知,在UCF-QNRF数据集中,本文所提方法与文献[28]方法相比,MAE降低12.7、MSE降低6.9,相较于其他算法均有提升。此外,UCF-QNRF数据集包含多元场景,导致视角、密度、光照变化多样,而实验结果表明,本文所提信息聚合方法能有效缓解上述因素带来的影响,对多元复杂场景具有较好的鲁棒性。

3.4 NWPU数据集实验与分析

NWPU数据集[29]是由Wang等人公开,目前为止在人群密度估计领域数据量最大、密度等级最高的数据集,拥有5 109张图片和2 133 238个标注实体;内含部分负样本,比如极高密度的人群,这样可以提高训练模型的鲁棒性;图片的分辨率相比其他数据集更高,且单张图片的标注实体数量范围非常大,区间是[0,200 33]。本文将NWPU的4 100张图片用于进行训练,其余用于测试。NWPU数据集单幅图像实验结果如图10所示,多算法性能指标结果对比如表3所示。

表 3. NWPU数据集多算法性能指标结果对比

Table 3. Comparison of performance index results of multiple algorithms in the NWPU

| ||||||||||||||||||||||||||||||||||||||||||||

由表3可知,本文方法较对比方法均有一定提升。与文献[23]方法相比,本文方法在Val验证集下的MAE降低1.4、MSE降低14.0,Test测试集下的MAE降低1.8、MSE降低14.7。验证了本文方法对NWPU数据集中密度等级较高的场景保持有较好的检测能力,且对于NWPU数据集中较高分辨率图像同时具有稳定的检测效果,表明本文算法在高密、高分辨率数据下具有良好鲁棒性。

3.5 消融实验与速度对比分析

本文在人群密集程度较高、数据量较大、代表性强的NWPU数据集上进行MIE消融实验、MCIA消融实验、模型大小与算法速度对比实验。

通过不采用MIE、单独采用多层语义监督策略MSS、单独采用空间信息嵌入策略SE、同时采用两种策略这四个实验,验证MIE及其各模块的有效性,实验结果如表4所示。可以看出,采用多层语义监督策略MSS,Val验证集MAE、MSE分别降低1.7、12.9,Test测试集MAE、MSE分别降低2.4、15.1,验证了多层语义监督策略的有效性;采用空间信息嵌入策略SE,Val验证集MAE、MSE分别降低1.2、11.0,Test测试集MAE、MSE分别降低0.6、11.4,验证了空间信息嵌入策略的有效性;同时采用MSS、SE策略,Val验证集MAE、MSE分别降低了4.0、44,Test测试集MAE、MSE分别降低9.1、52.3,计数精度提升幅度明显,说明多层语义监督策略、空间信息嵌入策略从不同角度提高了特征的表达能力,证明了本文多元信息提取网络MIE的有效性。

表 4. MIE消融实验结果

Table 4. Ablation results of MIE

| |||||||||||||||||||||||||||||

令S-ASPP模块分别采用步长卷积、同等扩张率的空洞卷积,通过对比算法精度、速度的差异,验证多尺度上下文信息聚合MCIA与步长卷积的有效性;同时,从训练模型参数量大小、模型运行速度两方面与先进算法进行对比实验,验证本文算法在速度上的优势,实验结果如表5所示。

表 5. MCIA消融实验、模型大小与算法速度实验结果

Table 5. Results of MCIA ablation experiment, model size and algorithm speed

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

本文在表5后三行分析对比了空洞卷积、步长卷积及步长卷积单S-ASPP模块三种不同情况嵌入至MCIA的精度与模型复杂度差异,由“Ours(空洞卷积)”与“Ours(步长卷积)”两种情况的对比结果可知,相比空洞卷积,使用步长卷积后MAE和MSE变化不大,但模型大小降低了约48.0%,运行速度增加了24%,验证了步长卷积在降低算法冗余上的优势;由“Ours (步长卷积)”与“Ours (步长卷积单S-ASPP)”两种情况的对比结果可知,可以发现,通过增加一个S-ASPP模块,算法MAE和MSE下降程度明显,模型大小上升幅度较小,验证了双S-ASPP结构的有效性,证明了本文MCIA特征聚合方法的优势。

由表5总体可知,MCNN模型采用了多列结构,导致模型参数量高,运行速度较慢。相较而言,采用单列结构的CSRNet网络,结构简单,运行速度较快。文献[23]所提的HLMMNet虽然也是单列结构,但其信息聚合的方式在提升网络精度的同时也带来了模型的冗余。相比之下,本文方法在信息聚合部分采取更加高效轻量的步长卷积,有效降低了特征聚合时带来的冗余参数,且采用双S-ASPP结构,在速度与精度上均取得了较好的结果。

进一步地,以图1中的示意图像为输入图像,分析图11所示S1-ASPP、S2-ASPP捕获到的多尺度特征,验证全局多尺度上下文信息聚合网络MCIA逐级渐进捕获并融合低、高层特征不同尺度上下文信息的有效性。

图11中,P1、P2、P3、P4为S1-ASPP获得的具有不同感受野的特征图,P5为融合P1至P4得到高层特征图;C1、C2、C3、C4为S2-ASPP各层级输出结果,C5为融合C1至C4得到特征图,获取过程与S1-ASPP类似。可以看出,S1-ASPP、S2-ASPP通过多扩张率方式丰富了感受野,获得了更多的上下文信息;S1-ASPP各级特征更关注图像整体的变化,偏重深层语义信息的挖掘,S2-ASPP各级特征则更侧重图像局部细节的表征,对空间位置信息较为敏感。融合特征P5、C5,得到的特征图M包含丰富的全局多尺度上下文信息,可提升算法对人群密度的估计能力。

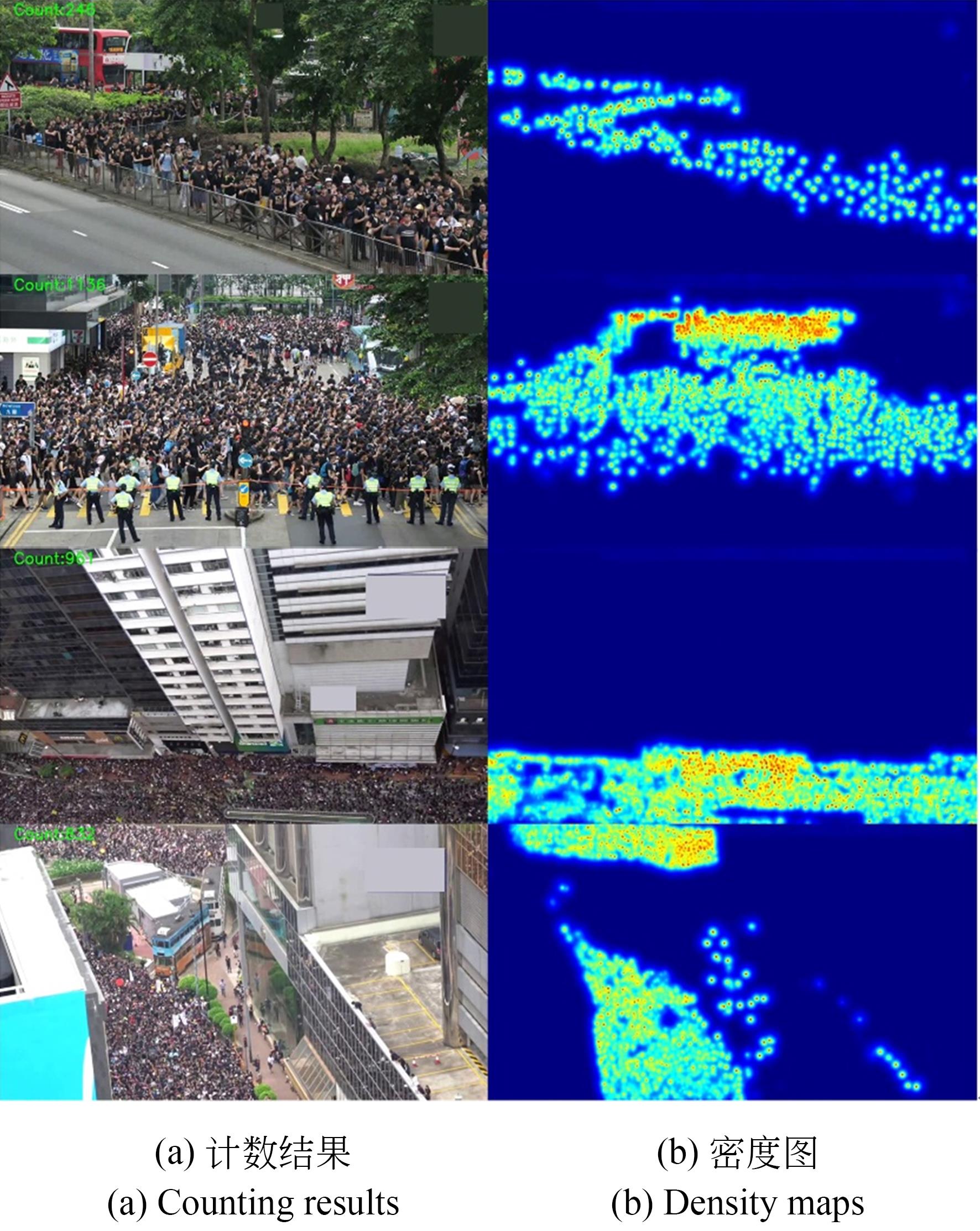

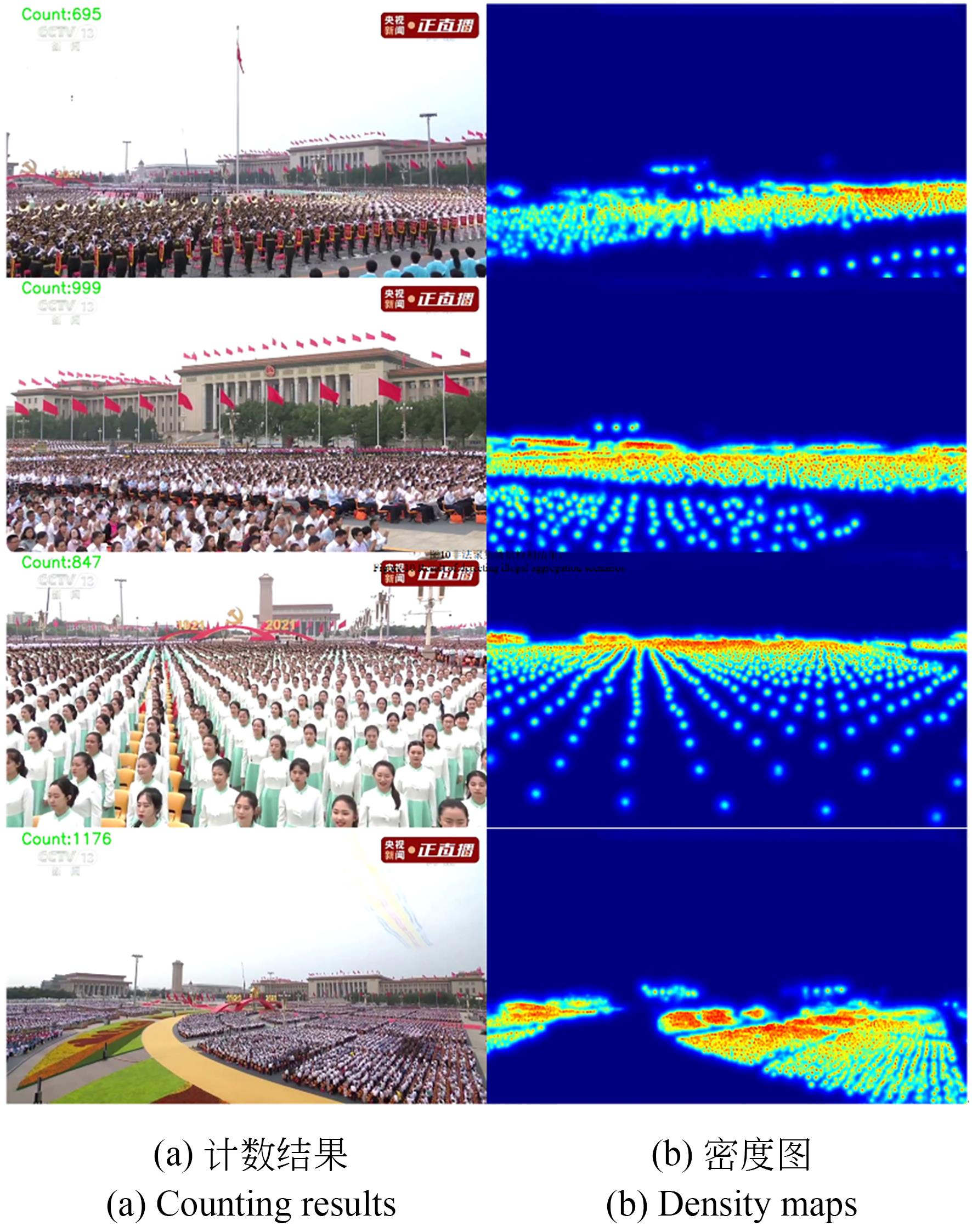

3.6 实际应用实验

人群密度估计与计数在公共安全领域有着极大的应用价值,对于突发性聚集活动,如非法抗议、节日活动、疫情防控、车站人流控制等场景发挥着巨大的作用,为验证本文算法的泛化能力与实际应用效果,本文对现实生活中实际聚集性场景进行实验与分析,实验结果如图12和图13所示。

由图12可知,本文算法在密度区域划分及人数统计方面均表现优异,且对于不同的拍摄高度、角度均效果稳定。在此类异常聚集活动中,人数及密度区域准确高效检测可为维护公共安全提供有力的数据支撑,为快速高效的应急处理提供助力。

由图13可知,本文算法对不同密度区域的大型活动场景保持较好的稳定性,同时,可利用人群计数结果,为会场高效分配资源。并且,通过密度图人群分布结果可较好的反映出相应的队列整齐程度,为大型表演的彩排提供助力。

4 结 论

针对人群密度较高且有大量的背景干扰、多语义空间信息及人群特征提取困难的问题,本文设计多元信息聚合的人群密度估计方法,以VGG-19作为骨架网络,利用多层语义监督策略及空间信息嵌入策略提升高低层特征质量;而后,设计双S-ASPP结构捕获全局多尺度上下文信息;最终,在网络后端使用步长卷积进行密度图回归,进一步减少网络参数,提升网络运行速度。实验结果证明:典型数据集ShanghaiTech的Part_A部分MAE为59.4,MSE为96.2;Part_B部分MAE为7.7,MSE为11.9。超高密度多视角场景数据集UCF-QNRF的MAE为89.3,MSE为164.5。高密度等级数据集NWPU的MAE为87.9,MSE为417.2。此外,本文在现实场景中进行了实际应用实验,算法稳定性良好。实验结果表明,本文模型在不同人群场景、视角、密度等级下都具有较好的性能,泛化能力较强。

[2] LIN S F, CHEN J Y, CHAO H X. Estimation of number of people in crowded scenes using perspective transformation[J]. IEEE Transactions on Systems, Man, and Cybernetics - Part A: Systems and Humans, 2001, 31(6): 645-654.

[3] ZHAO T, NEVATIA R, WU B. Segmentation and tracking of multiple humans in crowded environments[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2008, 30(7): 1198-1211.

[4] VIOLA P, JONES M J, SNOW D. Detecting pedestrians using patterns of motion and appearance[J]. International Journal of Computer Vision, 2005, 63(2): 153-161.

[5] KILAMBI P, RIBNICK E, JOSHI A J, et al. Estimating pedestrian counts in groups[J]. Computer Vision and Image Understanding, 2008, 110(1): 43-59.

[6]

[7]

[10]

[11]

[12] REN S Q, HE K M, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[25] CHEN L C, PAPANDREOU G, KOKKINOS I, et al. DeepLab: semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834-848.

[26] OH M H, OLSEN P, RAMAMURTHY K N. Crowd counting with decomposed uncertainty[J]. Proceedings of the AAAI Conference on Artificial Intelligence, 2020, 34(7): 11799-11806.

[29] WANG Q, GAO J Y, LIN W, et al. NWPU-crowd: a large-scale benchmark for crowd counting and localization[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 43(6): 2141-2149.

Article Outline

刘光辉, 王秦蒙, 陈宣润, 孟月波. 多元信息聚合的人群密度估计与计数[J]. 光学 精密工程, 2022, 30(10): 1228. Guanghui LIU, Qinmeng WANG, Xuanrun CHEN, Yuebo MENG. A multivariate information aggregation method for crowd density estimation and counting[J]. Optics and Precision Engineering, 2022, 30(10): 1228.