空间位姿测量中面阵点云CPD方法的优化及验证  下载: 589次

下载: 589次

0 引 言

随着太空技术的发展,空间非合作目标的高精度探测、跟瞄及对接等技术受到国内外研究机构的广泛重视[1-2]。激光成像雷达通过发射高重频激光脉冲并接收其散射信号,快速构建目标三维轮廓,是开展此类任务的重要光电载荷。已报道的空间三维成像雷达主要依赖于单元或线列推扫式,其优势在于灵活的视场配置和较高的点云密度,由于扫描速率限制,在开展动态平台或非合作目标观测时,其测量结果与实际轮廓存在较大差异[3-4]。近年来,基于阵列传感器的非扫描激光雷达正在成为国内外三维成像领域的研究热点[5-6]。基于高灵敏度APD阵列的面阵激光雷达,可实现单脉冲瞬时成像,有效解决了运动扫描导致的时间同步问题和条带错位现象[7]。受限于像元规模,当视场有效重叠面积较小,或目标存在自遮挡时,其点云数据将变得稀疏,呈现出交替变形的分布特征。此外,阵列探测器内部像元串扰特性引起的边缘模糊现象,也对在轨点云处理带来了较大挑战[8]。因此,有必要研究面向典型非合作目标、具有鲁棒性的空间面阵多视角点云配准算法进行位姿测量。

目前,工业界点云配准方法主要由粗配准和精配准两个阶段组成。粗配准方法基于随机一致性采样思想,通过建立关键点对或特征描述符,降低随机匹配过程的运算量,例如快速点特征直方图[9](Fast Point Feature Histograms, FPFH)、视点特征直方图[10]、3D形状上下文特征[11]等信息。此外,包括主成分分析[12](Principal Component Analysis, PCA)、四元数法[13]、正态分布变换[14](Normal Distribution Transform, NDT)等方法也展现出粗配准能力。在此基础上,Mellado等人针对四元数法运算时效进行了改进,提出了使用智能索引将计算复杂度从

针对空间非合作目标阵列成像点云特性,文中提出了一种改进相干点漂移算法对位姿测量中相邻帧点云进行配准。在单次源点云漂移后,对点集之间的距离残差进行排序,根据重叠比率得到参与运算的最优变换点云对,对迭代参量增加局部扰动量,并在迭代过程中引入重叠测度对权值因子进行自适应调整。此外,为避免陷入局部最优点,对均方误差更新率进行监督,通过变换点集属性提高鲁棒性,降低初始位姿差异较大时的误配准现象。最后,通过建立两种典型空间非合作目标多视角阵列成像工况,验证了所采用配准算法的精确度和鲁棒性。

1 配准方法与原理

1.1 面阵点云配准问题分析

基于二维焦平面阵列的激光成像雷达通过测量各像元回波的光子飞行时间,实现非扫描全视场同步成像。设接收视场角为

由于不同视角下的面阵点云轮廓具有较大差异,为了建立其位姿变换关系,需要对相邻帧阵列点云配准。其映射关系由旋转矩阵

即min[

1.2 基于改进的相干点漂移配准方法

相干点漂移方法是一种基于全局概率拓扑的多维数据点集匹配算法,不仅适用二维图像的拼接,也可用于三维点云的刚性/非刚性配准,在图像融合、影像匹配等领域展现出较强的鲁棒性[25]。它通过计算点云在GMM模型下的负对数似然函数,将点集之间的映射作为概率分布关系而求解。

1.2.1 点云相干点漂移的配准原理

基于相干点漂移配准方法将多维空间点集最优匹配问题视作为混合高斯分布模型下概率密度参数的估计问题。为了避免变换点集属性混淆,对点集定义予以区分,设参考点集为

式中:

式中:

两边同取对数后,即极小化负对数似然函数:

由于集合

1.2.2 文中的自适应配准算法流程

相干点漂移对重叠度及噪声特性等有较高要求,当相对初始位姿差异较大时算法易陷入失能。本节针对空间非合作目标阵列点云,基于相干点漂移方法收敛特性,对每次漂移后源点云使用局部空间最近邻估计方法进行正向推测,并通过反刚性变换调整点云姿态。对迭代后的点云对,监督均方误差更新率直至陷入局部值,依次交替待源点云与目标点云的属性,跳出局部最优变换矩阵,提高全局配准收敛性。配准流程如图1所示,其主要步骤如下:

图 1. 文中针对空间阵列点云的自适应改进相干点漂移配准算法流程图

Fig. 1. Diagram of the proposed adaptive CPD registration strategy for spatial planar-array-based point clouds

(1)对目标点云

(2)根据贝叶斯公式,利用初始方差计算混合高斯模型下点集

根据公式(3)和公式(4),可以得到:

针对式中权重

式中:

当迭代过程中权值

(3)根据凸函数Jesson不等式,GMM模型负对数似然函数

对该式进行简化,最终得到:

其中

该步骤的求解依赖于EM算法[25],其求解过程使得该下界值最大化,等效于最大化GMM模型的似然函数,得到最佳参数对

对于所选点对

其最优旋转变换矩阵和平移向量为:

(4)上述步骤中单次迭代的空间变换参量为:

所得的更新点集为:

通过不断迭代求解,直至两点云之间

(5)考虑到初始位姿差异过大可能导致运行时迅速陷入局部值,使

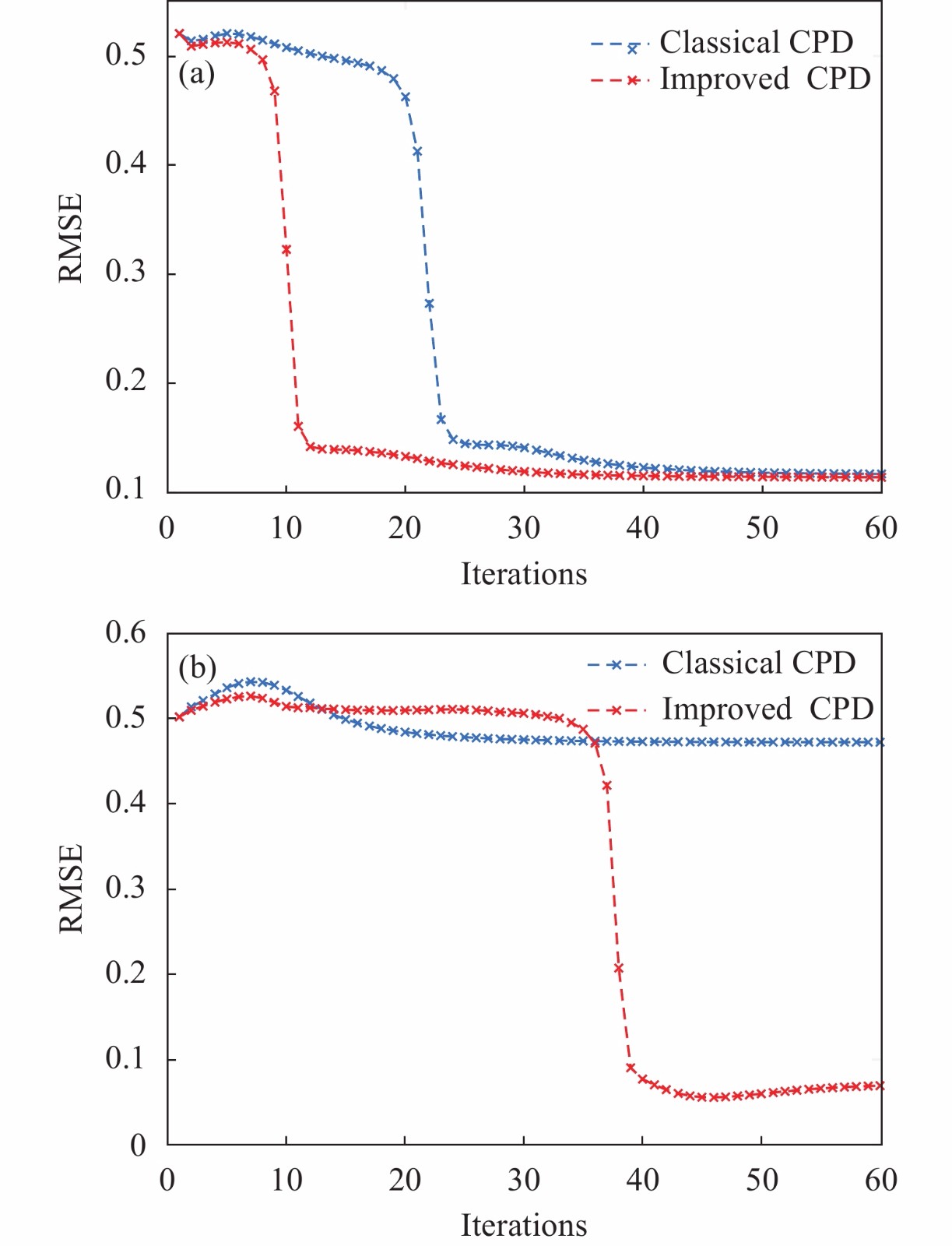

在初始位姿差异较大,特别是待配准点云内非重合点比率较大时,耗时量有所增加,而鲁棒性明显提升。图2(a)为该算法运行过程中配准误差随着迭代次数的收敛曲线,相比于标准相干点漂移方法,其单次迭代过程中收敛程度具有显著提升。如图2(b)所示,当GMM模型参数求解陷于局部值时,该算法具有跳出局部解并实现收敛的能力。

图 2. (a) 均方误差随迭代次数的变化; (b) 陷入局部值后的收敛曲线

Fig. 2. (a) Variation of RMSE with the iterations ; (b) Convergence curve of RMSE under local minimum

2 试验分析与讨论

空间非合作目标运动主要由绕自旋轴和绕进动轴的两个旋转分量决定,采用环绕伴飞或进动等方式可获得不同视角的轮廓。为明确文中研究目的,即位姿测量中不同视角阵列点云拼接配准问题,对此类目标低姿态分量加以简化,建立多视角空间探测仿真工况。采用组合式粗+精配准算法作为对比,结合文中改进相干点漂移方法,对所采集的不同工况下空间非合作目标阵列式点云进行配准验证。

为了定量化评价匹配结果,采用LCP测度(重叠系数)及RMSE均方误差这两个常用指标作为衡量最终配准效果的依据。LCP定义如上节所述,即对变换后点云

式中:

2.1 空间非合作目标面阵成像点云仿真工况

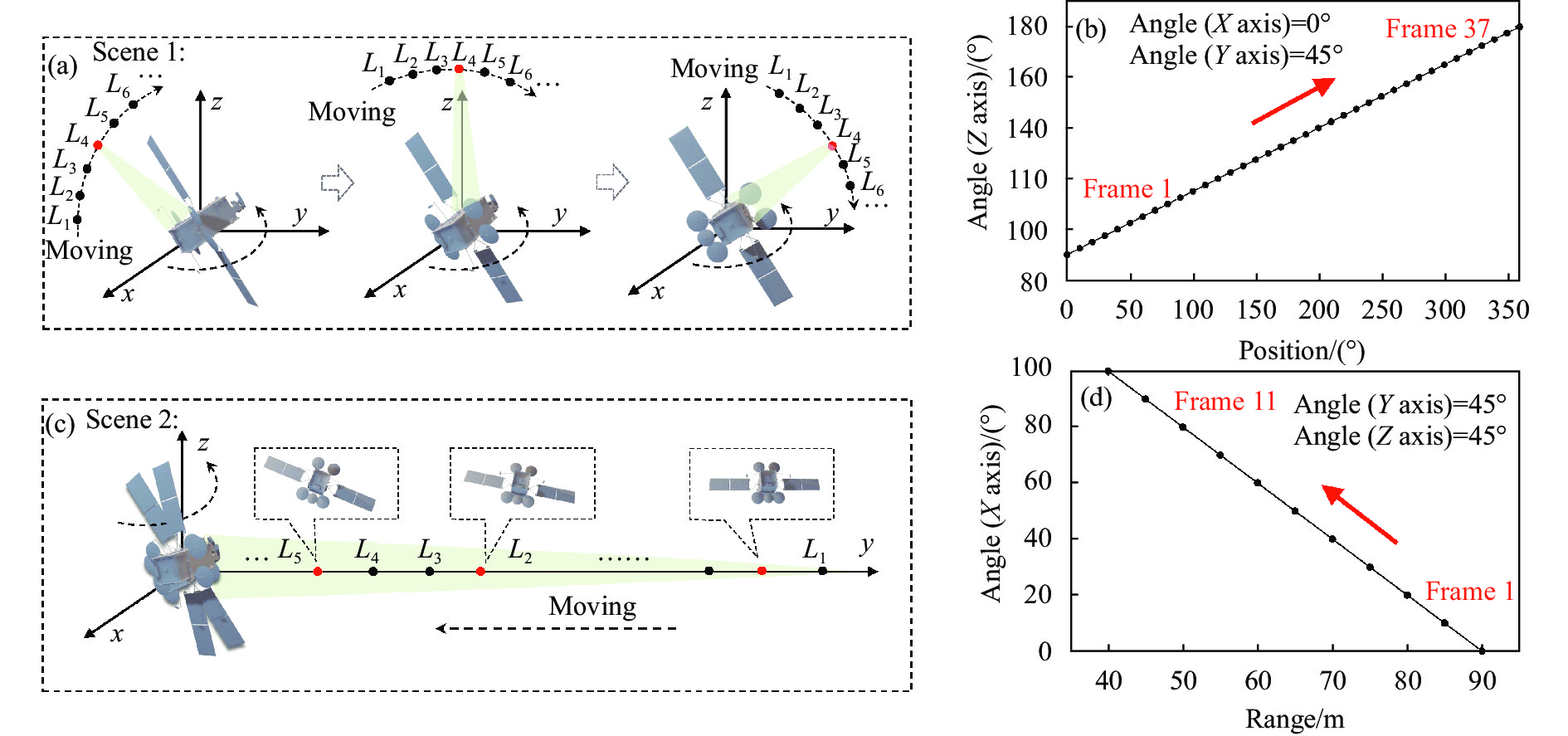

结合当前大规模盖格/线性APD焦平面阵列的研制进展,仿真像元规模为

(1)成像平台环绕以某姿态分量不断变化的卫星目标进行全视角采集。在近似圆周运动下,假设平台运动的线速率为

采用某卫星三维模型,其外接矩体包围框约

(2)成像平台向非合作目标连续进动。目标的

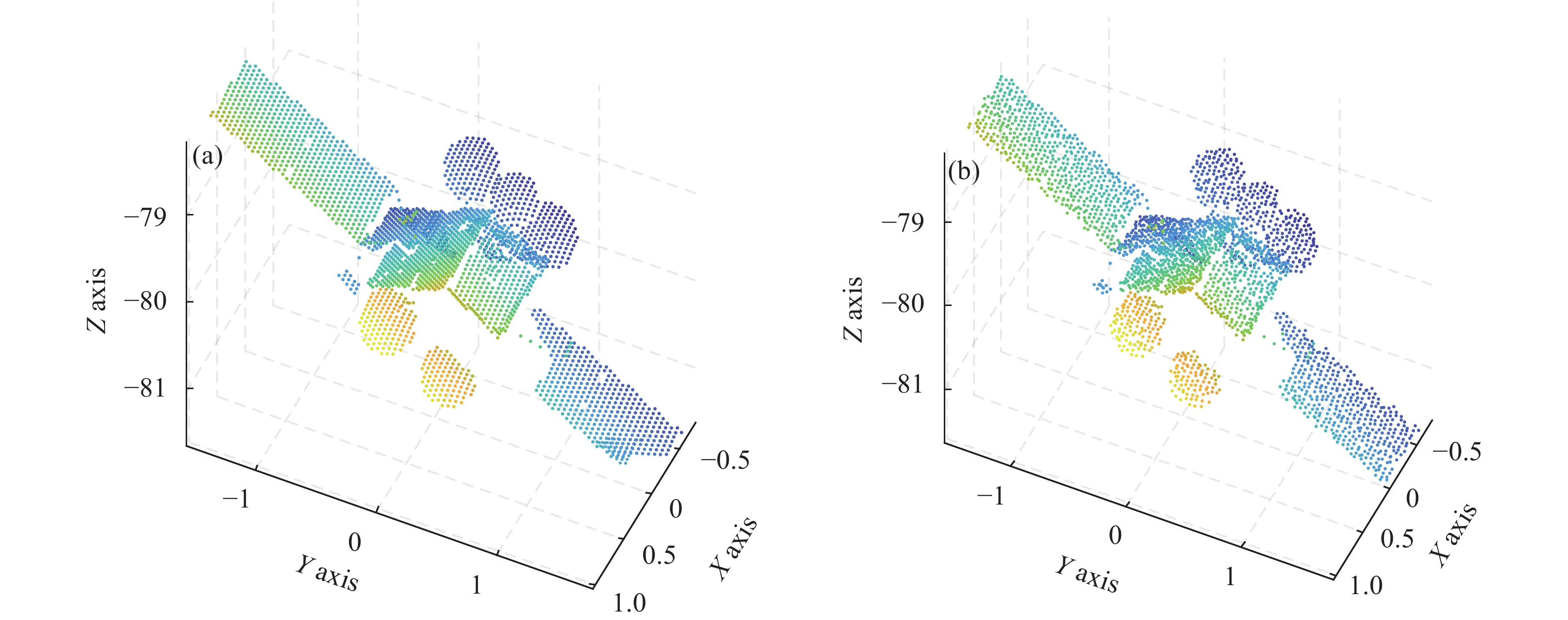

在空间探测场景下,受环境背景噪声、探测器串扰以及时间测量板的量化精度等因素影响,焦平面测距值无法达到绝对仿真距离。主要包括两点:一是实际点云通常以随机偏差分布在绝对真实值点云的周围;二是尽管多数离散噪点可以通过体素滤波等进行预处理,但环境背景及串扰导致的边缘模糊,使得分布在正确点云周围的噪点无法有效滤除,并参与配准运算。因此,需要对以上两种仿真工况下得到的绝对点云进行退化,约束其精度及信噪比。

假设激光脉冲波形及探测器内部响应造成的系统误差呈高斯分布,在绝对点云的各个维度上,加入均值为理论值,标准差

式中:

此外,针对面阵探测器的串扰模糊效应,对上述步骤处理后的含噪点云,按照指定比率将选定点周围点集进行随机替换:坐标点集规模为

图 3. (a) 工况1:成像平台围绕80 m处目标Y 轴旋转,卫星绕Z 轴运动;(b)为目标姿态与观测角对应关系;(c) 工况2:成像平台沿Y 轴自90 m处到40 m处进动,卫星绕X 轴运动;(d)为目标姿态与探测距离的对应曲线

Fig. 3. (a) Case 1: The platform rotates around the Y axis of the 80 m target, and the satellite moves around the Z axis; (b) is the correspondence between the target attitude and the observation angle; (c) Case 2: The platform moves along the Y axis from 90 m to 40 m, and the satellite moves around the X axis; (d) is the link between the target attitude and the detection distance

图 4. (a) 某姿态角下绝对仿真点云; (b)含有噪声扰动的退化仿真点云

Fig. 4. (a) Absolute simulation point cloud at a certain pose; (b) Degraded simulation point cloud with noise perturbation

2.2 两种工况下算法配准效果验证及讨论

为了验证算法性能,使用以上含噪仿真数据集进行配准分析。对于初始位姿差异较大的点云,直接使用ICP方法极易陷入局部最小值,导致配准结果可靠性较差。因此本节分别采用基于FPFH特征匹配的随机采样一致性SAC算法、基于正态分布变换算法和基于主成分分析方法的初始粗配准算法,结合ICP方法进行精配准,以及文中方法,对指定相邻帧点云进行配准分析。

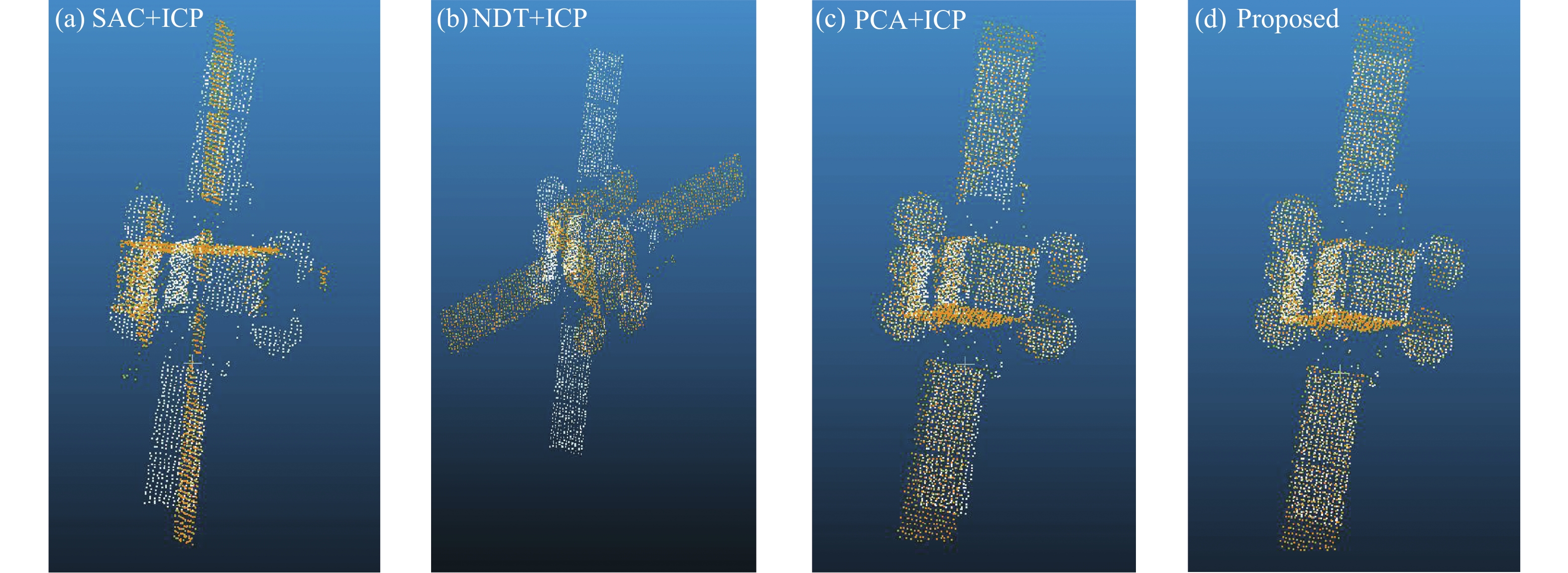

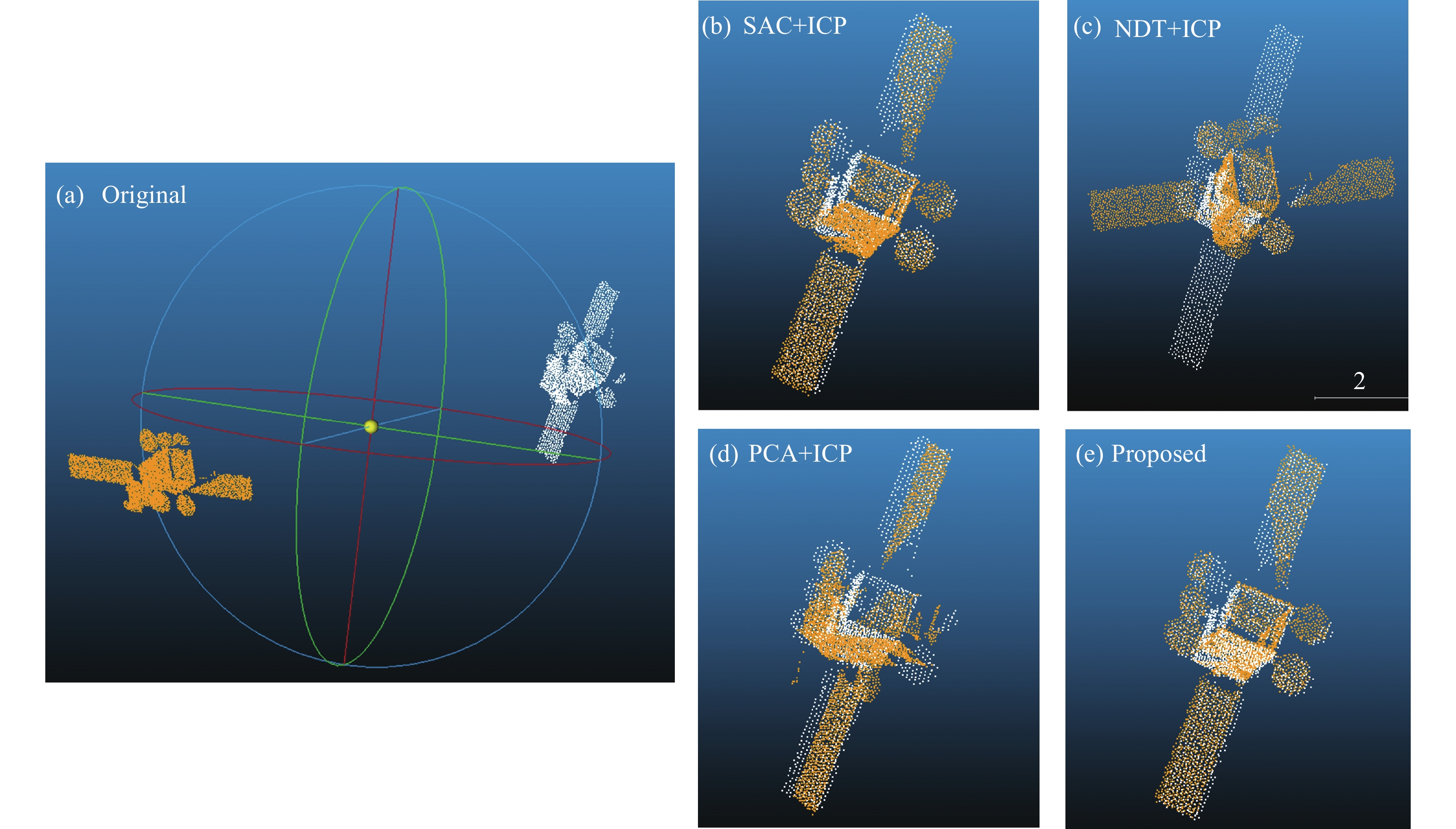

原始点云的初始位姿差异大小是检验鲁棒性的重要因素。对于工况1,相邻两帧待配准点云间姿态差异由系统成像帧频决定,反映于成像平台绕目标的观测角。图5所示为初始状态下相邻观测角间隔

对于PCA+ICP方法而言,正适用于此类主成分分量明显的目标,其初始配准的LCP测度和RMSE分别为32%和0.131。需要注意,由于PCA方法对各主轴方向具有极性两向性,因此不同场合下对ICP精配的初始输入姿态差异较大,导致精配过程中可能朝错误方向收敛。针对文中的优化相干点漂移方法,相对PCA+ICP配准算法而言,在RMSE近似相同的情况下的耗时量略有提高,重叠度提升了约9%,在后续相邻帧连续配准实验中,其匹配可靠性优势较显著。

图 5. 在工况1下相邻帧点云的视角差为90°时配准结果: (a) SAC+ICP; (b) NDT+ICP; (c) PCA+ICP; (d) 文中方法

Fig. 5. Registration results when the difference between the viewing angles of adjacent point cloud is 90 °under Case 1: (a) SAC+ ICP; (b) NDT + ICP; (c) PCA + ICP; (d) Proposed method

表 1. 工况1下点云视角分别为0°和90°时的配准结果评价

Table 1. Evaluation of registration results when the viewing angles are 0° and 90° respectively in Case 1

| ||||||||||||||||||||||||||||||||

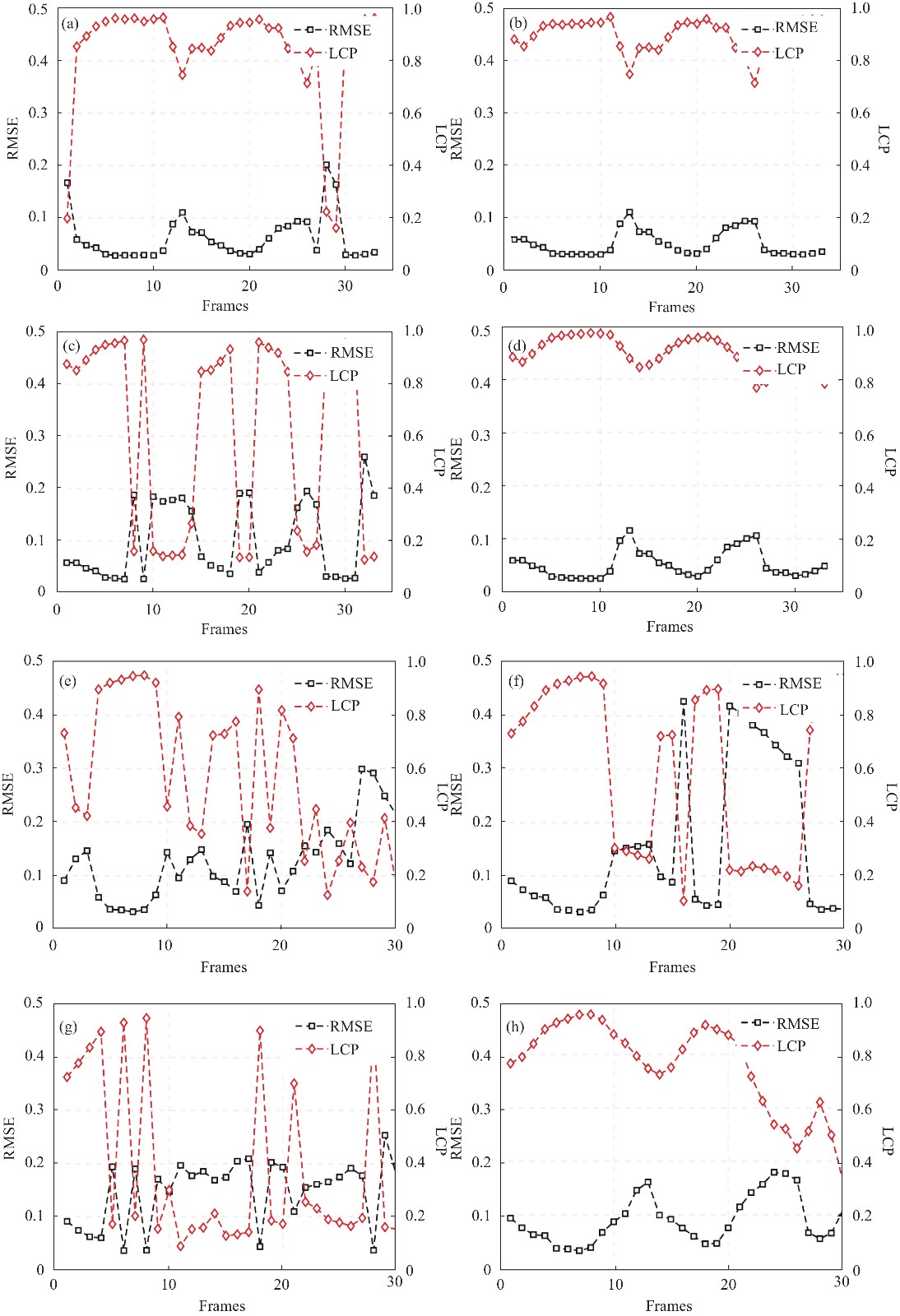

此外,针对工况1数据集,指定绕飞成像帧频使得相邻待配准点云帧视角差

图 6. 工况1下相邻点云帧视角差为30°和60°时的连续配准:(a)~(d)对应于30°视角差时的两两配准结果,分别为SAC+ICP、NDT+ICP、PCA+ICP以及文中的配准方法,同理(e)~(f)对应于60°视角差下的配准结果

Fig. 6. Registration results when the viewing angle difference is 30° and 60° in Case 1: (a)-(d) are the results of SAC+ICP, NDT+ICP, PCA+ICP and the proposed method when the viewing angle difference is 30°. Similarly, (e)-(f) correspond to the 60° viewing angle difference

在工况2下,相邻待配准点云之间的差异不仅体现在不断变化的目标姿态上,其重叠度和分布密度也随探测距离的降低而产生差异。图7(a)为探测距离为90 m和60 m时的待配准点云,两者相对于X轴位姿差为60°。图7(b)~(e)及表2分别为以上配准框架的结果。该视角下点云所含特征信息量较大,基于特征匹配的方法表现出了较强的配准能力,其重叠度和RMSE分别达到了58.8%和0.105,但耗时量有所增加。对于主成分分析方法,极性模糊造成的姿态差异过大使得精配准中出现误配准现象。文中的改进相干点漂移算法在耗时量和RMSE上,相对SAC+ICP方法较高,其重叠度提升了约34%,从图(b)和图(e)的配准结果可以看到,两种方法配准结果的重叠度具有明显提升。

图 7. 在工况2下相邻点云距离为30 m时的配准结果:(a)初始位姿; (b) SAC+ICP; (c) NDT+ICP ;(d) PCA+ICP; (e)文中方法

Fig. 7. Registration results when the distance between adjacent point cloud is 30 m under Case 2: (a) Initial position; (b) SAC + ICP; (c) NDT + ICP; (d) PCA + ICP; (e) Proposed method

表 2. 工况2下探测距离分别为90 m和60 m时的配准结果评价

Table 2. Evaluation of registration results in Case 2 when the detection distance is 90 m and 60 m respectively

|

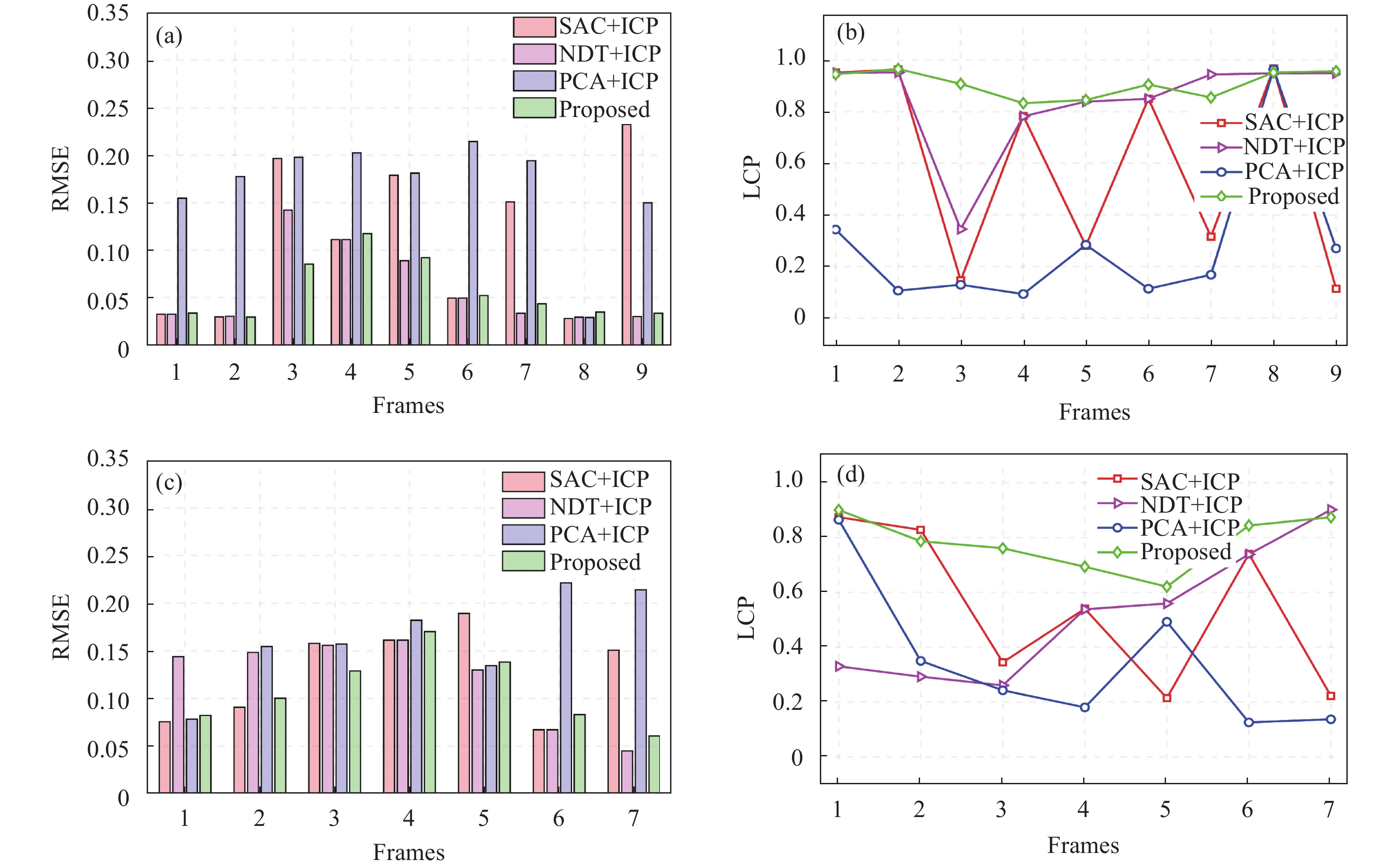

此外,仍然采用相邻两帧点云连续相互配准的方式对算法进行测试。为了使点云间差异更加直观,采用相邻点云的距离间隔作为衡量依据。在距离差分别为10 m (X轴视角差为20°)和20 m (X轴视角差为40°)时,使用上述方法进行配准,其结果如图8所示。由此可以看出,文中方法在均方误差以及重叠度上均表现出较稳定的变化趋势,其结果可靠性优于其他粗+精组合配准方法。

图 8.

Fig. 8. Continuous registration results for the point cloud with the distance difference between adjacent frames of 10 m and 20 m in Case 2: (a)-(b) corresponds to ∆d =10 m, (c)-(d) corresponds to ∆d =20 m

工况2下点云相邻帧距离差为10 m和20 m时的连续配准结果:(a)~(b)对应于

10 m,(c)~(d) 对应于

20 m

2.3 强背景噪声扰动下的算法鲁棒性验证

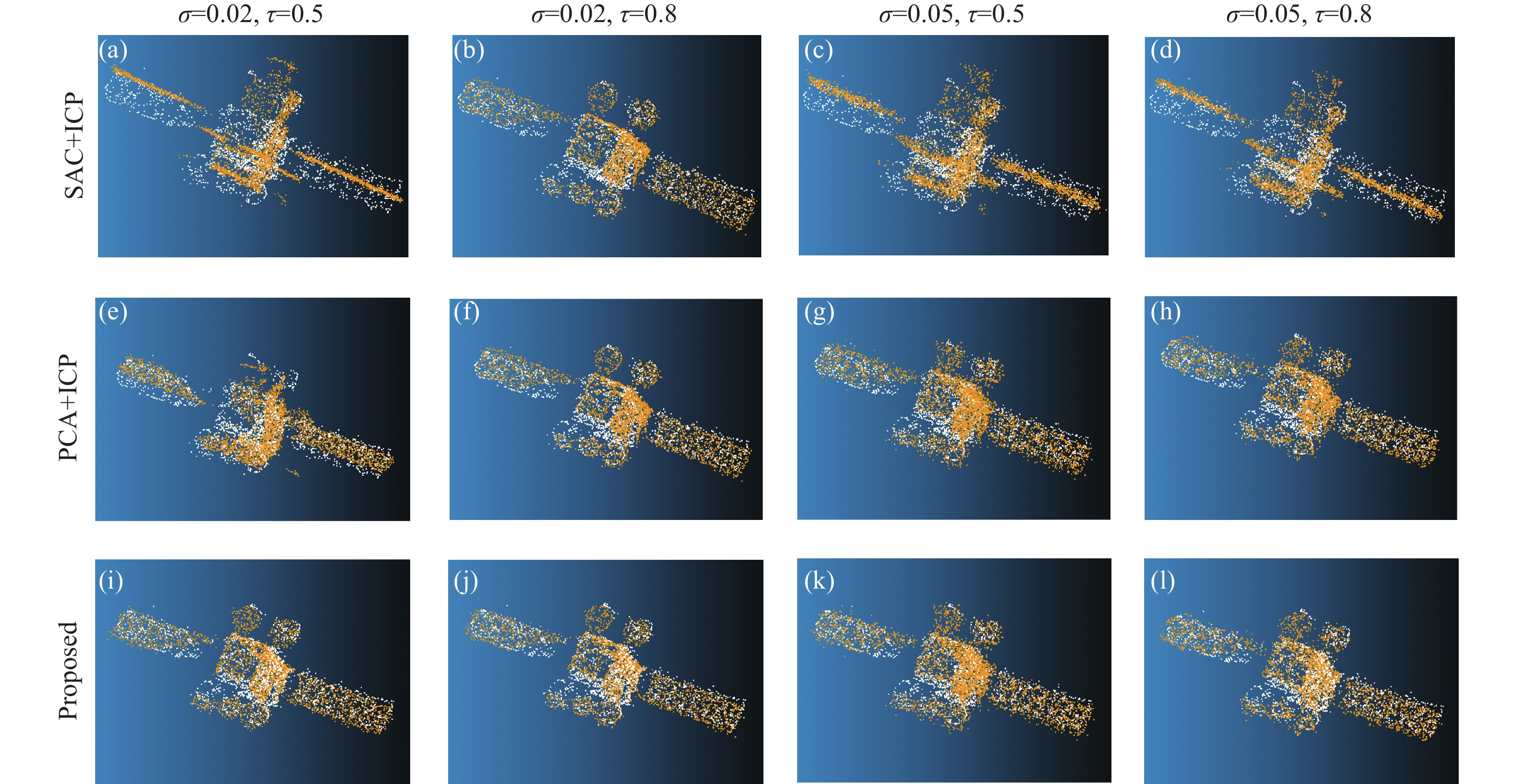

考虑到在真实空间探测场景中存在情况:受某些背景辐射源的影响造成点云信噪比过低;焦平面阵列或激光器性能裂化,使得光电探测能力随着载荷服务时长出现不同程度地下降,导致点云数据变得稀疏。本节针对该类极限扰动场景下点云进行仿真与配准验证。 采用上节工况2中探测距离为90 m的仿真数据作为目标点云,源点云为平台向前进动30 m后,待配准点云相对X轴的视角差为60度。在原退化点云的噪声基础上,依次叠加标准差

表 3. 工况2中强噪声扰动下探测距离分别为90 m和60 m时的配准结果评价

Table 3. Evaluation of results when the distance is 90 m and 60 m respectively under strong noise disturbance in Case 2

|

从图9可以看到,前面两种配准框架在点云数据质量发生剧烈下降后,均出现了不同程度的误配准,特别是噪声标准差

图 9. 在强噪声干扰情况下的点云配准结果:(a)~(d)为SAC+ICP框架在不同噪声水平下的配准结果; (e)~(h)为PCA+ICP框架;(i)~(l)为对应于文中配准算法的配准结果

Fig. 9. Registration results under extreme strong noise : (a) - (d) are the results of SAC-ICP framework under different noise level; (e)-(h) is PCA + ICP; (i) - (l) Correspond to the registration method in this paper

3 结 论

面阵激光雷达可以有效地解决空间探测场景下运动导致的距离同步问题,文中针对空间位姿测量任务,提出了一种改进相干点漂移方法对空间非合作目标阵列点云进行配准。通过建立简化后的空间运动目标面阵三维成像仿真工况,得到不同视角的阵列点云,验证了该配准算法的精度和可靠性。

在空间探测应用中,阵列式点云相对于推扫点云而言,更容易受到视场配置引起的背景噪声干扰。试验结果表明,即使在受到不同程度及特性的噪声干扰情况下,该方法仍然可以准确地完成配准任务,其结果优于包括特征匹配、正态分布以及主成分分析等粗+精配准组合框架。此外,对于地面或其它廓线特性差异较大的配准目标,仍需深入地考虑系统成像特性、探测目标几何特征及匹配指标等因素,综合不同算法框架的优势来解决多视角点云配准问题。后续工作将致力于该配准方法的轻量化实现及运算资源优化问题,对片上移植的实时性及动态范围等指标着重关注。

[1] Peng J, Xu W, Liang B, , et al. Pose measurement and motion estimation of space non cooperative targets based on laser radar and stereo-vision fusion[J]. IEEE Sensors Journal, 2019, 19(8): 3008-3019.

[2] Yin F, Wu Y. Model reconstruction and pose optimization of non-cooperative rotating space target[J]. Optics and Precision Engineering, 2019, 27(8): 1852-1860.

[3] do Carmo J P, Moebius B, Pfennigbauer M, et al. Imaging LIDARs f space applications[C]SPIE, 2008, 7061: 180191.

[5] He Y, Liang B, He J, , et al. Non-cooperative spacecraft pose tracking based on point cloud feature[J]. Acta Astronautica, 2017, 139: 213-221.

[6] Zhao G, Xu S, Bo Y. LiDAR-based non-cooperative tumbling spacecraft pose tracking by fusing depth maps and point clouds[J]. Sensors, 2018, 18(10): 3432.

[9] Rusu R B, Blodow N, Beetz M. Fast point feature histograms (FPFH) f 3D registration[C]2009 IEEE International Conference on Robotics Automation, 2009: 32123217.

[10] Rusu R B, Bradski G, Thibaux R, et al. Fast 3D recognition pose using the viewpoint feature histogram[C]2010 IEEERSJ International Conference on Intelligent Robots Systems, 2010: 21552162.

[11] Kim G, Kim A. Scan context: Egocentric spatial de f place recognition within 3D point cloud map[C]2018 IEEERSJ International Conference on Intelligent Robots Systems (IROS), 2018: 48024809.

[12] Chen X, Chen C H. Modelbased point cloud alignment with principle component analysis f robot welding[C]2017 International Conference on Advanced Robotics Intelligent Systems (ARIS), 2017: 8387.

[13] Aiger D, Mitra N J, Cohen D. 4points congruent sets f robust pairwise surface registration[M]ACM SIGGRAPH 2008, 2008: 110.

[14] Biber P, Straßer W. The nmal distributions transfm: A new approach to laser scan matching[C]Proceedings 2003 IEEERSJ International Conference on Intelligent Robots Systems, 2003, 3: 27432748.

[15] Mellado N, Aiger D, Mitra N J. Super 4 pcs fast global pointcloud registration via smart indexing[C]Computer Graphics Fum, 2014, 33(5): 205215.

[16] Brenner C, Dold C, Ripperda N. Coarse orientation of terrestrial laser scans in urban environments[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2008, 63(1): 4-18.

[17] Besl P J, McKay N D. Method f registration of 3D shapes[C]SPIE, 1992, 1611: 586606.

[18] Chen Y, Medioni G. Object modelling by registration of multiple range images[J]. Image and Vision Computing, 1992, 10(3): 145-155.

[19] Du S, Zheng N, Ying S, , et al. Affine iterative closest point algorithm for point set registration[J]. Pattern Recognition Letters, 2010, 31(9): 791-799.

[20] Fitzgibbon A W. Robust registration of 2D and 3D point sets [J]. Image and Vision Computing, 2003, 21(13-14): 1145-1153.

[21] Serafin J, Grisetti G. NICP: Dense nmal based point cloud registration[C]2015 IEEERSJ International Conference on Intelligent Robots Systems (IROS), 2015: 742749.

[22] Qi C R, Su H, Mo K, et al. Point: Deep learning on point sets f 3D classification segmentation [C]Proceedings of the IEEE Conference on Computer Vision Pattern Recognition. 2017: 652660.

[23] Zhang A, Min Z, Zhang Z, et al. Generalized 3D rigid point set registration with anisotropic positional err based on bayesian coherent point drift[C]2022 International Conference on Robotics Automation (ICRA), 2022: 37903796.

[24] Zang Y, Lindenbergh R, Yang B, , et al. Density-adaptive and geometry-aware registration of TLS point clouds based on coherent point drift[J]. IEEE Geoscience and Remote Sensing Letters, 2019, 17(9): 1628-1632.

[25] Myronenko A, Song X. Point set registration: Coherent point drift[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(12): 2262-2275.

Article Outline

谭长生, 黄庚华, 王凤香, 孔伟, 舒嵘. 空间位姿测量中面阵点云CPD方法的优化及验证[J]. 红外与激光工程, 2023, 52(2): 20220367. Changsheng Tan, Genghua Huang, Fengxiang Wang, Wei Kong, Rong Shu. Optimization and validation of coherent point drift for planar-array-based point cloud in space pose measurement[J]. Infrared and Laser Engineering, 2023, 52(2): 20220367.