基于深度强化学习的量子奥托循环性能优化【增强内容出版】

0 引言

能量转化是研究物质热力学性质的主要切入点之一。随着纳米技术的发展, 微观量子系统下热能的高效利用逐渐受到人们的关注, 推动了量子热机的理论和实验研究。量子热机是研究微观系统下能量转换与控制的重要平台, 能够促进人们对微观量子系统下能量转换物理机制的深入认识。这对纳米器件、分子马达以及超大规模集成电路领域的能量传输、转换控制等方面具有实际应用价值。

量子奥托循环(QOC)是热机循环的一种重要循环方式。与经典奥托循环类似, 一个理想的QOC包括两个等容热化过程和两个准静态绝热做功过程。在理想的QOC中, 准静态绝热膨胀/压缩过程在保证量子奥托热机获得最高效率的同时, 也会导致其平均输出功率趋于零。因此, 研究如何获得较高QOC效率的同时又提升其输出功率是必要的。近年来, 学者们提出了一种加速系统绝热演化的方法—绝热捷径(STA) 技术[1-5], 其中反向透热补偿驱动法[6-10] 是较常见的一种, 被应用于一维谐振子系统[6,7]、单/双比特[8]和多体自旋链系统[9,10] 等构造的QOC。在理论上, STA技术已被证明对QOC性能的提升是有效的。但是, 绝热捷径方案下的控制场函数通常为高阶非线性的复杂函数, 在实验上不便于操控。近年来, 机器学习作为数据处理与计算的强大工具, 已被广泛应用于统计、控制等多学科。近期, 机器学习也开始被应用于量子物理领域, 执行某些特定的任务, 如量子态制备[11,12]、非平衡量子系统动力学演化路径调控[13]以及量子热机性能优化[14,15]等。然而, 机器学习算法在量子热机中的应用研究目前尚处于初步探索阶段, 相关的研究成果较少。基于不同特征的量子热机模型如何借助机器学习实现性能优化是值得探索的课题。

本文以单自旋量子比特系统为工质, 研究了热机在便于调控的线性驱动场下执行膨胀/压缩过程的有限时间内的QOC的性能。结合基于策略函数的深度强化学习算法, 分析了QOC膨胀和压缩过程中附加驱动场的最优驱动策略(附加驱动场强度的优化分布), 探讨了优化附加驱动方案下QOC的性能特征。

1 QOC模型

本研究以单量子比特系统为工质, 研究其在磁场调控下执行QOC的热力学性能。考虑工质满足 Landau-Zener模型, 则其哈密顿量可表示为

式中

为了简化研究, 设定

式中:

1.1 理想绝热QOC

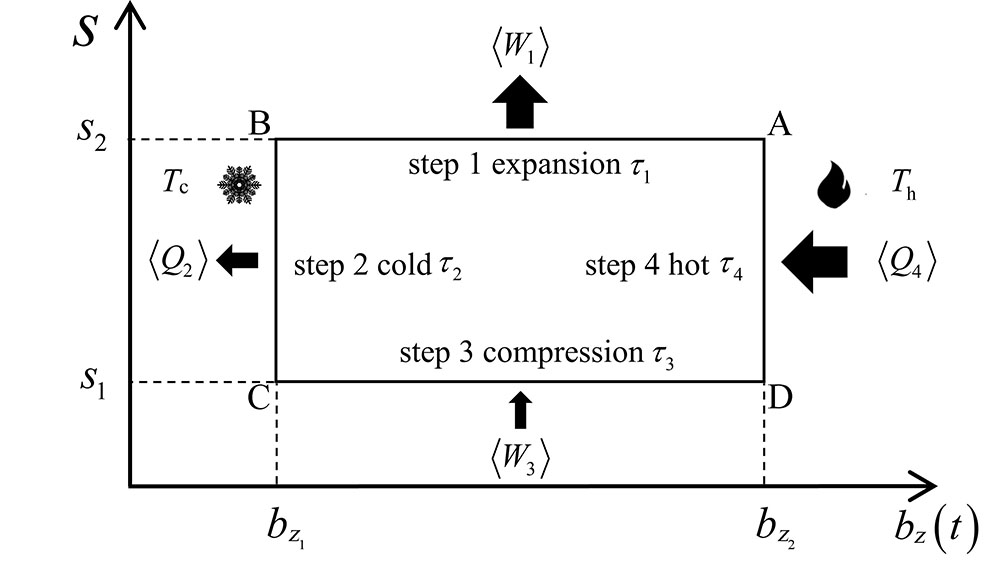

在不考虑施加附加驱动场的理想QOC中, 整个循环由两个量子绝热过程和两个等容热化过程构成(如

第一步: 绝热膨胀过程(A→B)。工质与温度为

式中:

第二步: 等容冷却过程 (B→C)。在该过程中保持控制参数

式中:

第三步: 绝热压缩过程 (C→D)。工质与温度为

式中

第四步: 等容加热过程 (D→A)。此过程与第二步中的热交换过程类似, 工质在保持能级不变的情形下与温度为

考虑到绝热膨胀与压缩过程互为逆过程, 其哈密顿量满足

QOC的平均输出功率和效率可分别表示为

和

另外, QOC绝热膨胀与压缩过程经历的时长

1.2 非理想绝热QOC

为实现非零的高功率热循环, 重点研究了(2) 式描述的附加驱动场的循环方案和无附加驱动场的自由演化方案。对于附加驱动方案下的QOC, 附加场的添加必然会导致外界驱动系统在热机输出功的过程中存在额外能量的消耗。通常, 这部分能量消耗也被称为能量成本。在膨胀/压缩过程中外界 (附加场) 的能量成本可表示为[13]

式中

式中

式中

相应的平均输出功率和效率可分别表示为

类似地, 在自由演化方案下, QOC的净输出功为

平均输出功率和效率为

另外, 值得说明的是, 关于自由演化方案下QOC的不可逆功

2 基于深度强化学习的附加驱动场优化策略

施加附加驱动场对QOC性能的影响程度与外界驱动场强度随时间分布 (或驱动场强度序列) 密切相关。这里, 考虑通过引入基于策略函数的深度强化学习来寻找最优驱动场的分布特征, 从而获得最优驱动循环方案。

强化学习的本质是智能体与环境进行交互, 得到环境的反馈奖励, 然后使用从环境中获得的长期累计回报奖励来指导智能体改善行为, 找到可以使环境奖励最大化的策略。使用策略函数

式中

将工质在

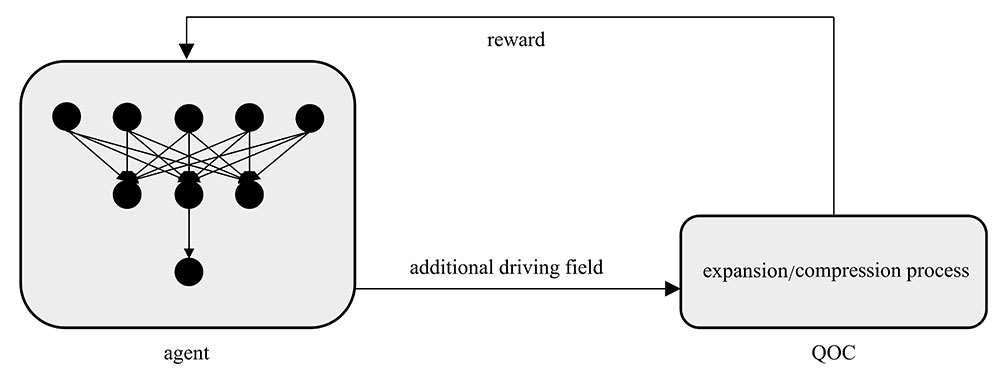

图 2. 强化学习优化附加驱动场示意图

Fig. 2. Diagram of optimization of the additional driving field by reinforcement learning

首先, 给agent的网络输入端输入QOC膨胀/压缩时的初始热态, 神经网络基于策略的深度学习算法, 预测工质在接下来

式中

在选择

利用以上算法, 分别对QOC的膨胀和压缩过程的附加驱动场强度分布进行优化。在算法中, 分别设置

本文搭建的神经网络由

epoch=100, 高斯函数参数

3 数值分析与讨论

接下来, 通过数值模拟对附加驱动方案和自由演化方案下QOC的性能特征进行分析。为方便研究, 固定热机在膨胀/压缩过程中

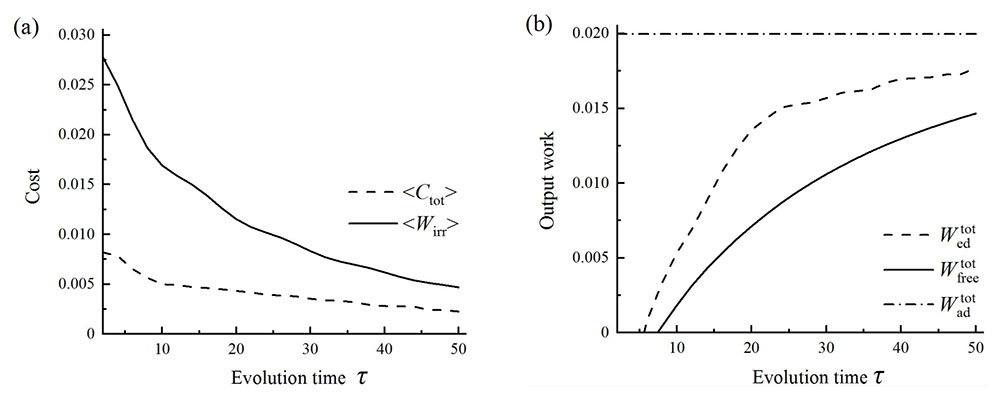

3.1 能量成本和输出功

基于本文考虑的热机模型, 通过施加附加驱动场, 可以有效抑制QOC过程中不可逆功的产生, 从而提高热机功的输出。但是, 附加驱动场的添加通常会产生一定能量的消耗或能量成本。

图 3. 优化附加驱动方案与自由演化方案下的能量消耗与输出功对比。(a) 能量成本

Fig. 3. Comparison of energy cost and output work in the optimization additional driving and free evolution schemes.(a) Energy cost

3.2 QOC的效率和功率

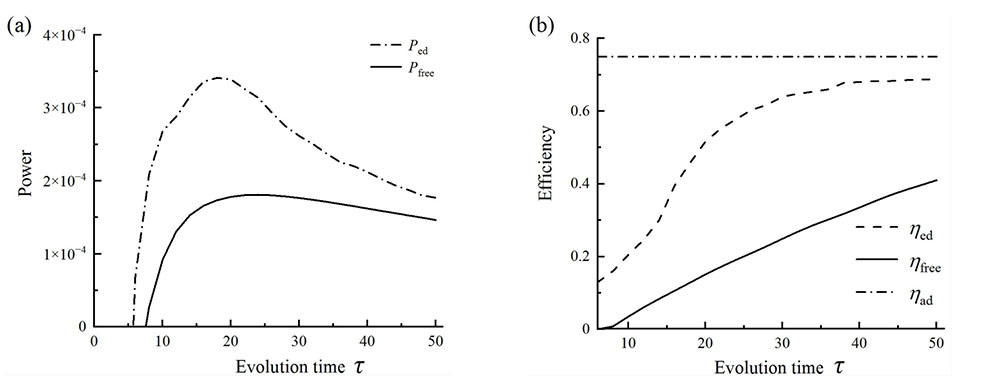

除输出功之外, 功率和效率也是反映热机性能的另外两个核心指标。下面将对优化附加驱动和自由演化两种方案下QOC的功率和效率进行对比分析, 对比情况如

图 4. 优化附加驱动方案与自由演化方案下QOC性能的对比。(a) 功率

Fig. 4. Comparison of performance of QOC of the optimization additional driving and free evolution schemes.(a) Power

从

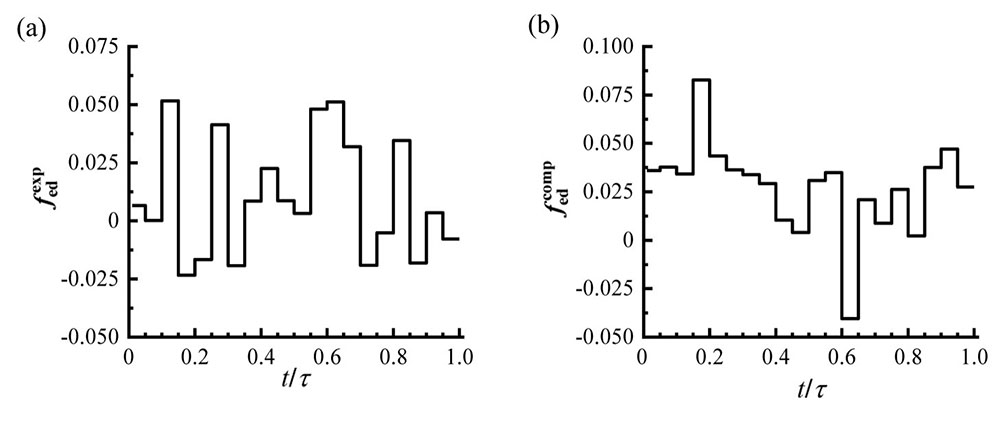

图 5. 在

Fig. 5. Optimization distribution of additional driving field with

4 结论

本文以单量子比特系统为工质, 构造了基于策略函数的深度强化学习优化方案下的有限时间内的QOC。对比分析了热机在线性驱动场中执行自由演化和机器学习优化附加驱动场演化下的热机性能。结果表明: 利用深度强化学习优化QOC膨胀和压缩过程的附加驱动场, 其整体性能明显优于自由演化方案下的情形。特别地, 优化附加驱动方案下的QOC在较短循环周期下仍可有效运行, 而自由演化方案则失效 (无正功输出)。此外, 优化附加驱动方案下的QOC的最大功率和效率也均显著优于自由演化方案下的最大功率与效率。本研究可为深度强化学习在相关量子热力学问题中的深入应用提供参考。

[1] Prielinger L, Hartmann A, Yamashiro Y, et al. Two-parameter counter-diabatic driving in quantum annealing[J]. Physical Review Research, 2021, 3(1): 013227.

[2] Guéry-Odelin D, Ruschhaupt A, Kiely A, et al. Shortcuts to adiabaticity: Concepts, methods, and applications[J]. Reviews of Modern Physics, 2019, 91(4): 045001.

[3] Hegade N N, Paul K, Ding Y C, et al. Shortcuts to adiabaticity in digitized adiabatic quantum computing[J]. Physical Review Applied, 2021, 15(2): 024038.

[4] Iram S, Dolson E, Chiel J, et al. Controlling the speed and trajectory of evolution with counterdiabatic driving[J]. Nature Physics, 2021, 17(1): 135-142.

[5] Patra A, Jarzynski C. Semiclassical fast-forward shortcuts to adiabaticity[J]. Physical Review Research, 2021, 3(1): 013087.

[6] Abah O, Paternostro M, Lutz E. Shortcut-to-adiabaticity quantum Otto refrigerator[J]. Physical Review Research, 2020, 2(2): 023120.

[7] Dupays L, Egusquiza I L, del Campo A, et al. Superadiabatic thermalization of a quantum oscillator by engineered dephasing[J]. Physical Review Research, 2020, 2(3): 033178.

[8] Funo K, Lambert N, Karimi B, et al. Speeding up a quantum refrigerator via counterdiabatic driving[J]. Physical Review B, 2019, 100(3): 035407.

[9] Li L N, Li H, Yu W L, et al. Shortcut-to-adiabaticity quantum tripartite Otto cycle[J]. Journal of Physics B: Atomic, Molecular and Optical Physics, 2021, 54(21): 215501.

[10] Hartmann A, Mukherjee V, Niedenzu W, et al. Many-body quantum heat engines with shortcuts to adiabaticity[J]. Physical Review Research, 2020, 2(2): 023145.

[11] Zhang X M, Wei Z Z, Asad R, et al. When does reinforcement learning stand out in quantum control? A comparative study on state preparation[J]. npj Quantum Information, 2019, 5: 85.

[12] He R H, Wang R, Nie S S, et al. Deep reinforcement learning for universal quantum state preparation via dynamic pulse control[J]. EPJ Quantum Technology, 2021, 8(1): 29.

[13] Sgroi P, Palma G M, Paternostro M. Reinforcement learning approach to nonequilibrium quantum thermodynamics[J]. Physical Review Letters, 2021, 126(2): 020601.

[14] Khait I, Carrasquilla J, Segal D. Optimal control of quantum thermal machines using machine learning[J]. Physical Review Research, 2022, 4(1): L012029.

[15] Erdman P A, Noé F. Identifying optimal cycles in quantum thermal machines with reinforcement-learning[J]. npj Quantum Information, 2022, 8: 1.

[16] Plastina F, Alecce A, Apollaro T, et al. Irreversible work and inner friction in quantum thermodynamic processes[J]. Physical Review Letters, 2014, 113(26): 260601.

[17] Ahmadi B, Salimi S, Khorashad A S. Irreversible work and Maxwell demon in terms of quantum thermodynamic force[J]. Scientific Reports, 2021, 11: 2301.

[18] Sivak V V, Eickbusch A, Liu H, et al. Model-free quantum control with reinforcement learning[J]. Physical Review X, 2022, 12: 011059.

Article Outline

李建松, 李海, 于文莉, 郝亚明. 基于深度强化学习的量子奥托循环性能优化[J]. 量子电子学报, 2025, 42(1): 70. Jiansong LI, Hai LI, Wenli YU, Yaming HAO. Performance optimization of quantum Otto cycle via deep reinforcement learning[J]. Chinese Journal of Quantum Electronics, 2025, 42(1): 70.