基于循环神经网络的图像特定文本抽取方法  下载: 1186次

下载: 1186次

1 引言

相对于颜色、大小、纹理等特征信息,图像中的文字信息包含了高层次的语义信息。这些信息广泛应用于证件录入、拍照翻译、图像理解等领域[1]。实际应用中所需的信息往往是图像中部分特定的文本信息,而在一些自然应用场景图像中,直接通过光学字符识别(OCR)技术对图像进行识别,识别出来的文本信息往往包含大量的非特定的文本(噪声文本)信息。因此如何从图像中进行特定文本抽取,仍然是业内广泛研究者关注的重点。

早期关于图像的特定文本抽取主要是通过OCR中的版面分析来实现,即首先利用版面分析的方法得到图像中特定的文本区域,然后对特定文本区域进行文字识别。其中版面分析的方法可以归结为三大类[2]:1)自顶向下分析法[3];2)自底向上分析法[4];3)混合分析法[5]。其中:自顶向下主要以整幅图像或较大的区域块为基础,逐渐细分,得到各种类别区域;自底向上的思路与自顶向上相反,视每个像素为独立的单位;混合分析法则是综合以上两种思路。这些方法对文档图像的依赖性较强, 且其分析过程包含大量复杂的图像处理技术,导致不能很好地泛化到其他类型的图像上。

近年来OCR研究主要集中在解决背景复杂、拍摄角度和光线不均、低分辨率的自然场景图像上,其方法也逐渐应用到端到端的场景文字检测和场景文字识别[6-7]中。场景文字检测的方法主要包括基于连通域法[8-9]、滑窗法[10]和深度学习法[11],其中基于连通域与基于滑窗的方法通常计算量较小,但难点在于如何提取一个较好的特征来训练分类器以应对背景复杂、文字旋转等情况。近年来,深度学习法在手写识别[12]、目标检测[13-14]等领域取得了较好的效果。典型的代表为Jaderberg等[15]与Liao等[16]提出的基于生成文本候选区的文字检测模型,该模型在任意方向文本的检测上表现出色。Zhou等[17]则是采用全卷积网络(FCN)的结构设计模型,在英文文本检测上达到了当时最好的检测效果。Tian等[18] 利用更深的网络VGG16来提取特征,结合双向长短时记忆(BLSTM)网络学习文字空间的上下文信息,有效地排除了非文字区域,从而使得文字检测更加稳健。有关场景文本识别的研究有很多。Jaderberg等[19]通过合成的9×106数据来训练卷积神经网络(CNN),达到了出色的识别效果,但是其全连接层限定了单词识别的种类,无法识别语种之外的样本。为了解决上述问题,Liao等[20]借鉴语义分割的思想,利用FCN结构直接识别字符级别的文本。Shi等[21]设计一种基于序列建模的端到端的模型来识别文字,由CNN提取特征,BLSTM对序列建模,CTC(Connectionist Temporal Classification)转录,最终取得较好的识别效果,因此该模型目前也成为了文字识别领域主流的识别框架。

上述端到端的OCR技术通常无法对特定文本进行识别,其整体识别结果常包含大量的噪声文本,场景图像的复杂性,导致难以通过确定的规则来排除噪声文本。例如:特定文本为自然场景下身份证图像中的姓名部分,虽然可以通过OCR技术来检测和识别图像中的所有文字,但是由于场景图像的复杂性,易检测出噪声文本,识别结果对应于一串可编辑文本(姓名、噪声文本等),很难确定其中究竟哪一部分为姓名部分。为了解决该问题,受自然语言处理领域序列标注任务的启发[22],本文提出一种新的特定文本抽取思路,即双向长短时记忆-条件随机场 (BLSTM-CRF)模型。将该问题类比于序列标注的问题。首先,通过BLSTM网络捕获OCR输出结果序列的上下文信息,为其建立内在的联系;然后通过CRF显式的内容,根据整个序列的标签进行决策,得到最佳的标签结果;最后根据标签即可得到特定的文本。通过模型直接对OCR结果进行处理可以避免对图像进行复杂的版面分析。利用云南省普洱澜沧供电局提供的无约束自然场景下的身份证图像数据集YNIDREAL进行方法验证。实验结果表明,本文方法可以达到88.52%的准确率,且相较于传统CRF模型,准确率提高了16.39个百分点,在含有大量噪声文本的图像中仍可以很好地进行抽取,由此表明该方法具有较好的稳健性。

2 基本原理

本文从序列标注的角度设计实现OCR特定文本的抽取。BLSTM-CRF模型主要由两部分构成:第一部分为BLSTM网络,用于捕获上下文信息并编码序列;第二部分为CRF,用于统计分析得到最后的标签。

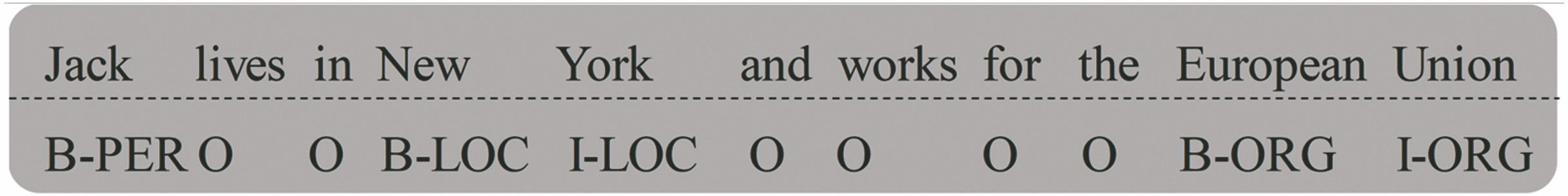

2.1 序列标注

序列标注任务是自然语言处理(NLP)领域里典型的任务之一,通常是给定一串输入序列

2.2 长短时记忆网络单元

经典的RNN模型在训练过程中会存在梯度消失和梯度爆炸等问题,导致其难以获得长距离依赖。针对该问题,文献[

25]中提出RNN的一类变种——长短时记忆(LSTM)网络。其构成单元如

式中:☉为点乘操作;

2.3 双向长短时记忆网络

如

2.4 条件随机场

传统的序列标注的任务,通常独立考虑每个标签,采用类似于集束搜索的求解标签分布的方法[27-28]进行标签预测,但这种方法没有考虑到序列之间的整体关系。CRF为基于统计的序列标签预测模型,以整个序列的标签为单位,结合序列的整体信息,来考虑序列标签的最佳路径,这种方法可以避免一些歧义。如

在标准BIO的命名实体识别任务中,I-LOC后面的标签为I-ORG是不合理的。

设

式中:

2.5 BLSTM-CRF模型

本文将双向长短时记忆网络与条件随机场组合成一个BLSTM-CRF模型来对OCR识别结果进行序列标注。如

式中:

2.6 场景文字检测与识别

近年来,自然场景文本检测和识别大多是基于深度学习的端到端的方法,为了验证本文针对OCR特定文本抽取方法的有效性,采用的OCR检测与识别为当下的主流框架,其中检测部分为CTPN[18],该模型借鉴了目标检测领域的Faster R-CNN[29]模型中的建议区域提取的思想,设计了针对文字特点的文本建议区域提取,在ICDAR2013数据集中精确率和召回率的调和平均值

3 实验结果及分析

3.1 实验数据集

监督学习模型的训练要以大量带标签的训练集为基础,但由于缺乏标准的数据集训练本研究提出的模型,且人工标定数据耗时耗力,因此本文以身份证图像数据集作为研究对象,分析身份证的结构内容,设计算法,自动生成带标签数据,进行训练。部分生成数据如

为测试本模型在自然场景下对特定文本的抽取效果,利用云南省普洱澜沧供电局提供的数据集YNIDREAL来进行实际测试,该数据集由数位供电局工作人员通过不同拍照设备采集,采集环境各不相同。从中筛选出61张背景复杂、光线不均、分辨率不一和含有大量噪声文本的代表性的作业场景样本,旨在较全面地测试本文方法在实际场景图像中的效果。图像样例如

图 7. IDTRAIN和IDVAL中生成的文本数据及标签示例。(a)样例a;(b)样例b

Fig. 7. Samples of text data and label generated in IDTRAIN and IDVAL. (a) Sample a; (b) sample b

表 1. 实验数据集的分布

Table 1. Distribution of experimental data set

|

3.2 模型训练

本实验所用的深度学习框架为Tensorflow1.8(Google Inc),字嵌入采用均匀分布初始化,范围为[-0.25,0.25) ,维度为300维,优化器为Adam,初始学习率为0.001,梯度裁剪为0.5,批量大小为64,批次内随机打乱输入数据,共迭代40次。实验所有操作环节在64位Ubuntu18.04 LST系统下运行,CPU配置为8线程Corei7-7700CPU 3.6 GHz,显卡为GTX1050,显存为2 GB。

按照字符进行标注,实体的标签完整、识别正确计为正确识别,以

式中:

图 9. IDVAL上6种实体准确率。 (a) F 1值;(b) P 值;(c) R 值

Fig. 9. Accuracy of six entities on IDVAL. (a) F 1-score; (b) P value; (c) R value

3.3 模型测试

模型整体框架包含两部分,分别为OCR部分[30]和特定文本抽取部分。其中OCR部分已在2.6节所述,即首先通过对图像进行文字检测,然后进行文字识别,最后进行特定文本抽取。文本抽取分别比较了CRF、BLSTM-CRF模型在YNIDREAL数据集上的测试效果。其中CRF模型的人工干预特征为字符的词性和词边界。

表 2. CRF模型与BLSTM-CRF模型系统性能

Table 2. System performances of CRF and BLSTM-CRF models

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

图 10. YNIDREAL测试结果示例图。(a)文字检测结果;(b)文字识别结果;(c) BLSTM-CRF模型特定文本抽取结果;(d) CRF模型特定文本抽取结果

Fig. 10. Test results on YNIDREAL dataset. (a) Text detection results; (b) text recognition results; (c) result of interest text extraction using BLSTM-CRF model; (d) result of interest text extraction using CRF model

表 3. 特定文本抽取完整性测试结果

Table 3. Test results of integrity of interest text extraction

| |||||||||||||||||||||

4 结论

借鉴自然语言处理中序列标注的思想,提出基于递归神经网络的BLSTM-CRF模型,对OCR进行特定文本抽取。仅利用生成的数据集对模型进行训练即可在YNIDREAL数据集上达到88.52%的准确率,相对于仅利用条件随机场模型,效果提升了16.39个百分点,为OCR特定文本抽取提供了一个全新的思路。本文模型通过BLSTM编码OCR识别结果的上下文信息,对噪声文本有一定的过滤作用,证明了本文算法的稳健性。其中OCR部分与本文模型相对独立,证明方法具有一定的模块灵活性。

由于目前比较缺乏针对自然场景图像进行特定文本抽取的标准数据集,而且标准数据集对自然场景下特定文本抽取的研究至关重要,后续将考虑如何制备一个规范的标准数据集以供研究。另外,在实验过程中发现在对一些自然场景图像进行特定文本抽取时,仍然存在由于识别错误引发的抽取失败的例子,因此在未来的工作中,如何改进并提高文本识别的准确率将是一个重点。

[1] Oliveira D AB, Viana MP. Fast CNN-based document layout analysis[C]∥2017 IEEE International Conference on Computer Vision Workshops (ICCVW), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 1173- 1180.

[2] Le VP, NayefN, VisaniM, et al. Text and non-text segmentation based on connected component features[C]∥2015 13th International Conference on Document Analysis and Recognition (ICDAR), August 23-26, 2015, Tunis, Tunisia. New York: IEEE, 2015: 1096- 1100.

[3] OkunO, DoermannD, PietikainenM. Page segmentation and zone classification: the state of the art[R]. Fort Belvoir: Defense Technical Information Center, 1999.

[5] Bukhari SS, Al Azawi M I A, Shafait F, et al. Document image segmentation using discriminative learning over connected components[C]∥Proceedings of the 8th IAPR International Workshop on Document Analysis Systems-DAS '10, June 9-11, 2010, Boston, Massachusetts, USA. New York: ACM, 2010: 183- 190.

[6] Ye Q X, Doermann D. Text detection and recognition in imagery: a survey[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(7): 1480-1500.

[7] Liu X Y, Meng G F, Pan C H. Scene text detection and recognition with advances in deep learning: a survey[J]. International Journal on Document Analysis and Recognition (IJDAR), 2019, 22(2): 143-162.

[8] EpshteinB, OfekE, WexlerY. Detecting text in natural scenes with stroke width transform[C]∥2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, June 13-18, 2010, San Francisco, CA, USA. New York: IEEE, 2010: 2963- 2970.

[9] NeumannL, MatasJ. A method for text localization and recognition in real-world images[M] ∥Kimmel R, Klette R, Sugimoto A. Computer vision-ACCV 2010. Lecture notes in computer science. Berlin, Heidelberg: Springer, 2011, 6494: 770- 783.

[10] WangK, BabenkoB, BelongieS. End-to-end scene text recognition[C]∥2011 International Conference on Computer Vision, November 6-13, 2011, Barcelona, Spain. New York: IEEE, 2011: 1457- 1464.

[11] Huang WL, QiaoY, Tang XO. Robust scene text detection with convolution neural network induced MSER trees[M] ∥Fleet D, Pajdla T, Schiele B, et al. Computer vision-ECCV 2014. Lecture notes in computer science. Cham: Springer, 2014, 8692: 497- 511.

[12] 方定邦, 冯桂, 曹海燕, 等. 基于多特征卷积神经网络的手写公式符号识别[J]. 激光与光电子学进展, 2019, 56(7): 072001.

[13] 王旭, 刘毅, 李国燕. 基于改进视觉背景提取算法的运动目标检测方法[J]. 激光与光电子学进展, 2019, 56(1): 011007.

[14] 赵恒, 安维胜. 结合深度学习的图像显著目标检测[J]. 激光与光电子学进展, 2018, 55(12): 121003.

[15] JaderbergM, VedaldiA, ZissermanA. Deep features for text spotting[M] ∥Fleet D, Pajdla T, Schiele B, et al. Computer vision-ECCV 2014. Lecture notes in computer science. Cham: Springer, 2014, 8692: 512- 528.

[16] LiaoM, ShiB, BaiX, et al.Textboxes: a fast text detector with a single deep neural network[C]∥Thirty-First AAAI Conference on Artificial Intelligence (AAAI-17), February 4-10, 2017, San Francisco, California, USA. USA: AAAI Press, 2017: 4161- 4167.

[17] Zhou XY, YaoC, WenH, et al. EAST: an efficient and accurate scene text detector[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 2642- 2651.

[18] TianZ, Huang WL, HeT, et al. Detecting text in natural image with connectionist text proposal network[M] ∥Leibe B, Matas J, Sebe N, et al. Computer vision-ECCV 2016. Lecture notes in computer science. Cham: Springer, 2016, 9912: 56- 72.

[19] JaderbergM, SimonyanK, VedaldiA, et al. Synthetic data and artificial neural networks for natural scene text recognition[J/OL]. ( 2014-12-09)[2019-05-04]. https:∥arxiv.org/abs/1406. 2227.

[20] LiaoM, ZhangJ, WanZ, et al.Scene text recognition from two-dimensional perspective[C]∥Proceedings of the AAAI Conference on Artificial Intelligence, January 27-February 1, 2019, Hilton Hawaiian Village, Honolulu, Hawaii, USA.USA: AAAI Press, 2019, 30( 1): 8714- 8721.

[21] Shi B G, Bai X, Yao C. An end-to-end trainable neural network for image-based sequence recognition and its application to scene text recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(11): 2298-2304.

[22] Huang ZH, XuW, Yu K. Bidirectional LSTM-CRF models for sequence tagging[J/OL]. ( 2015-08-09) [2019-05-04]. https:∥arxiv.org/abs/1508. 01991.

[23] Lafferty JD, McCallum A, Pereira F C N. Conditional random fields: probabilistic models for segmenting and labeling sequence data[C]∥Proceedings of the Eighteenth International Conference on Machine Learning, June 28-July 1, 2001, Williams College, Williamstown, MA, USA. USA: ACM, 2001: 282- 289.

[24] Chiu J P C, Nichols E. Named entity recognition with bidirectional LSTM-CNNs[J]. Transactions of the Association for Computational Linguistics, 2016, 4: 357-370.

[25] Hochreiter S, Schmidhuber J. Long short-term memory[J]. Neural Computation, 1997, 9(8): 1735-1780.

[26] GravesA, Mohamed AR, HintonG. Speech recognition with deep recurrent neural networks[C]∥2013 IEEE International Conference on Acoustics, Speech and Signal Processing, May 26-31, 2013, Vancouver, BC, Canada. New York: IEEE, 2013: 6645- 6649.

[27] RatnaparkhiA. A maximum entropy model for part-of-speech tagging[C]∥Conference on Empirical Methods in Neural Language Processing, May 17-18, 1996, Philadelphia, PA, USA. [S.l.: s.n.], 1996.

[28] McCallumA, FreitagD, Pereira F CN. Maximum entropy Markov models for information extraction and segmentation[C]∥Proceedings of the Seventeenth International Conference on Machine Learning, June 29-July 2, 2000, Stanford, CA, USA. USA: ACM, 2000: 591- 598.

[29] RenS, He KM, GirshickR, et al. Faster R-CNN: towards real-time object detection with region proposal networks[C]∥Neural Information Processing Systems (NIPS), December 7-12, 2015, Palais des Congrès de Montréal, Montréal Canada. Canada: NIPS, 2015: 91- 99.

[30] Shi X F.CHINESE-OCR[EB/OL]. ( 2018-04-14)[2019-05-04]. https:∥github.com/xiaofengShi/CHINESE-OCR.

Article Outline

杨恒杰, 闫铮, 邬宗玲, 方定邦, 段放. 基于循环神经网络的图像特定文本抽取方法[J]. 激光与光电子学进展, 2019, 56(24): 241501. Hengjie Yang, Zheng Yan, Zongling Wu, Dingbang Fang, Fang Duan. Extraction Method of Interest Text in Image Based on Recurrent Neural Network[J]. Laser & Optoelectronics Progress, 2019, 56(24): 241501.