基于改进引导滤波和双通道脉冲发放皮层模型的红外与可见光图像融合算法  下载: 1168次

下载: 1168次

1 引言

随着图像传感器技术的发展,图像融合技术在**、航空、遥感等领域均具有较好的应用前景[1]。红外与可见光图像融合作为图像融合中的重要分支,因其自身存在的信息互补特性,日渐成为图像融合中的热点问题。

目前,针对红外与可见光图像融合算法的研究比较多,其中基于多尺度分解的方法在图像融合中应用最为广泛。常用的多尺度分解方法包括小波变换(WT)、Contourlet变换、非降采样Contourlet变换(NSCT)等[2]。但小波变换受限于方向特性,对高度奇异的图像边缘无法给出最优解。Contourlet变换克服了小波在这一方面的缺陷,能够很好地捕捉到图像的边缘信息,但不具备平移不变性,容易使图像产生伪吉布斯现象。 杨立新等[3]提出的非降采样Contourlet变换可以克服伪吉布斯现象的产生并充分地保留源图像的有效信息,但其计算复杂度较高,不能够应用到图像实时融合场景中[4]。相对于NSCT,非降采样Shearlet变换(NSST)不仅运算简单,而且对剪切后的方向数没有限制,是在各个方向和各个尺度上对图像的真正稀疏表示,可以在图像融合中取得更好的融合结果。吴一全等[5-6]将NSST应用于图像融合中,并针对高低频子带各自特性设计相应的融合策略,取得了理想的融合结果。刘健等[7]采用冗余提升不可分离小波替换NSST中的非降采样金字塔分解,在增强NSST捕获图像细节的能力的同时也提高了其运算效率。吴冬鹏等[8]分析了NSST高频系数间的关联性和差异性,构造了一种方向性基本一致的改进型NSST变换,可以进一步保留融合图像的细节信息。在图像融合中,选择合适的融合策略同样至关重要。脉冲耦合神经网络 (PCNN)作为一种新型神经网络,因其同步脉冲发放和全局耦合等特性,目前被广泛应用于图像处理中。Ganasala等[9]采用图像方向梯度特征作为PCNN的链接系数,增强了算法的自适应性。Wang等[10]则提出了一种双通道PCNN模型,并将其应用于图像融合中。但PCNN存在内部计算复杂、参数较多、迭代次数无法确定等问题。脉冲发放皮层模型(SCM)的提出弥补了PCNN存在的诸多不足。赵杰等[11]将SCM模型与NSST相结合,有效地抑制了图像在变换域中的像素失真。Kong等[12]对SCM模型进行进一步改进,使SCM更加适用于图像处理,并取得了较好的融合结果。

本文提出了一种基于改进引导滤波和双通道脉冲发放皮层模型(DCSCM)的红外与可见光图像融合算法,即对源图像进行NSST分解,得到相应的高低频分量。为了充分保留源图像的有用信息,采用改进的引导滤波算法对低频分量进行融合。为了使融合图像更加符合人眼视觉观感,采用DCSCM模型对高频分量进行融合。最后,对融合得到的高低频分量进行NSST逆变换,从而得到最终的融合结果。实验结果表明,本文算法相比其他方法,具备较为明显的优势。

2 引导滤波

引导滤波[13-15]是一种基于局部线性模型的边缘保持算法,已被广泛应用于图像去雾、抠图等领域。引导滤波利用引导图像指导滤波过程,使得输出图像在保留输入图像整体特征的同时,充分获取引导图像的变化细节。

将输入图像记作

式中

式中

式中

考虑到一个像素点会被多个窗口包含,于是对所有情况下的

式中

3 SCM基本原理与DCSCM模型

3.1 SCM基本原理

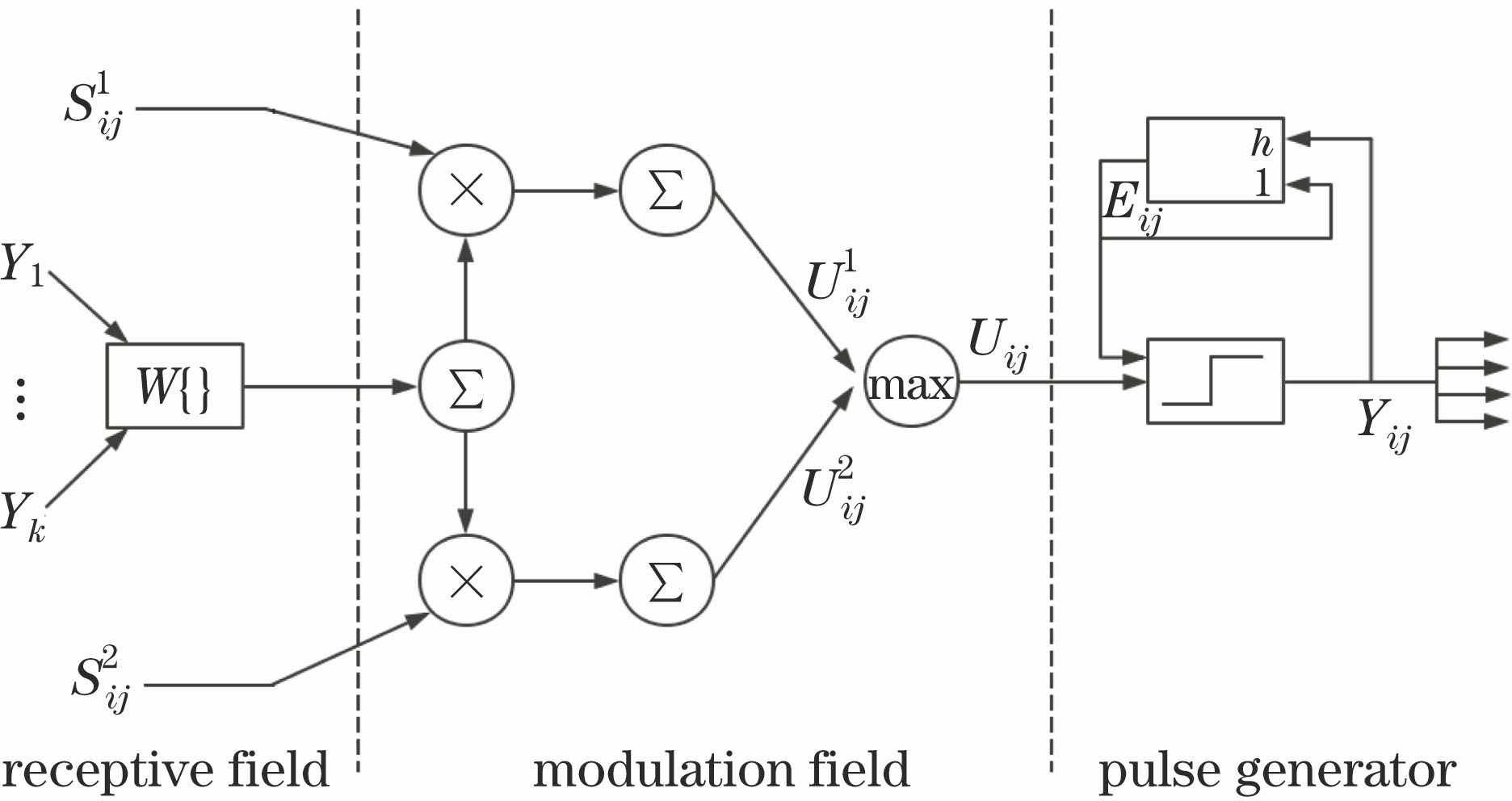

PCNN是一种通过模拟猫的视觉系统而构建的神经网络模型,因此PCNN更加符合人眼视觉观感要求[16]。SCM作为一种改进的PCNN模型,具备参数设置少、计算复杂度低等优势,非常适合应用于图像处理领域。SCM神经元通常由三部分组成:接收域、调制域和脉冲产生域。

在接收域中,SCM神经元通过

式中

调制域对接收到的输入信号进行调制,产生内部调制结果。接收域与调制域的关系为

式中

SCM神经元的脉冲产生部分为

式中

3.2 DCSCM模型

SCM模型因其自身特性对图像的细节信息具有很强的表示能力,对图像中的偏暗区域却不够敏感。为了增强SCM对图像中偏暗区域的捕捉能力,本文对SCM模型进行改进,提出了一种双通道SCM模型,改进点如下。

1) 由于之前的内部活动项

式中

2) 为了尽可能减少参数设置带来的影响,将动态门限

式中

3) 由于传统SCM的输出采用硬限幅函数,不能反映出神经元点火脉冲的幅度差异,将Sigmoid函数作为DCSCM的输出,可以更好地刻画同步脉冲激发时在点火幅度上的差异。DCSCM的输出定义为

DCSCM结构如

4 本文融合算法

4.1 融合步骤

本文融合算法的流程如

4.2 低频子带融合规则

引导滤波模型具备较好的边缘保持特性。为了更多地保留图像的边缘信息,本文采用文献[ 14]中的引导滤波模型对低频分量进行融合。首先对低频图像进行均值滤波,得到基础图像与细节图像,然后根据图像的显著性、清晰度、标准差信息获取初步融合权重,再采用改进的引导滤波对融合权重进行修正,最后对低频系数进行加权融合,得到融合图像的低频分量。具体步骤如下。

1) 图像分解

对低频图像进行均值滤波得到基础图像。细节图像由低频图像减去基础图像后得到[13],即

式中

2) 构建初始融合权重

分别计算待融合图像的显著性、清晰度、标准差信息,得到对应的融合权重矩阵。图像显著性定义为

式中

式中

图像的空间频率反映了图像空间域总体活跃程度,也可以用于表示图像的清晰度。本文采用一种改进的空间频率来表示图像清晰度,可以更加准确地表示图像的清晰度信息。其定义为

式中

从而可以根据清晰度获得融合权重矩阵

式中

图像的标准差可以表示图像对比度信息,图像标准差越大,对比度越高,其定义为

式中

式中

初始融合权重

3) 融合权值修正

初始融合权重通常包含噪声,并且边缘不够对齐,容易使融合图像产生伪影。采用改进的引导滤波算法对初始融合权值进行修正,得到引导滤波后基础图像和细节图像的融合权重分别为

式中

4) 低频图像融合

采用加权平均的融合方式分别对基础图像

进行融合,融合图像的低频分量

4.3 高频子带融合规则

图像高频部分包含了主要的边缘、轮廓等细节信息。为了使融合图像更加符合人眼视觉特性,采用DCSCM模型对NSST高频子带进行融合,并将图像的拉普拉斯能量和信息作为DCSCM模型的反馈输入。为了更好地表示图像的细节信息,采用了一种改进的拉普拉斯能量和(SML)。SML定义为

式中

式中

5 实验与分析

5.1 实验设置

为了验证本文算法的有效性,选取三组红外与可见光图像进行融合实验,图像灰度级均为256,并将本文算法与文献[

1]、文献[

10]、文献[

13]方法进行对比。实验计算机为DELL PRECISION系列,CPU主频为3.20 GHz,内存为8.00 GB,实验环境为MATLAB 2013b。本文NSST分解层数为4层,采用“maxflat”滤波器进行多尺度分解,shear滤波器大小与方向级数分别设置为[30,30,36,36]和[3,3,4,4]。DCSCM模型的幅度增益

5.2 UNcamp图像集实验

UNcamp图像集实验结果如

![UNcamp图像集与融合结果。(a)红外图像;(b)可见光图像;(c)文献[1]方法;(d)文献[10]方法;(e)文献[13]方法;(f)本文方法](/richHtml/gxxb/2018/38/2/0210002/img_3.jpg)

图 3. UNcamp图像集与融合结果。(a)红外图像;(b)可见光图像;(c)文献[ 1]方法;(d)文献[ 10]方法;(e)文献[ 13]方法;(f)本文方法

Fig. 3. UNcamp image set and fusion results. (a) Infrared image; (b) visible image; (c) method in Ref. [1]; (d) method in Ref. [10]; (e) method in Ref. [13]; (f) proposed method

为了更加客观地对实验结果进行评价,采用平均梯度、空间频率、图像标准差和信息熵作为客观评价标准。平均梯度可以反映图像微小细节差异以及纹理变化,信息熵则反映了图像信息量大小。从

表 1. UNcamp图像集实验结果对比

Table 1. Comparison results of the UNcamp image set

| |||||||||||||||||||||||||||||||||||

5.3 其他测试集实验

为了进一步验证本文算法的有效性,选取另外两组图像测试集进行实验对比,实验结果如

![第一组图像及融合结果。(a)红外图像;(b)可见光图像;(c)文献[1]方法;(d)文献[10]方法;(e)文献[13]方法;(f)本文方法](/richHtml/gxxb/2018/38/2/0210002/img_4.jpg)

图 4. 第一组图像及融合结果。(a)红外图像;(b)可见光图像;(c)文献[ 1]方法;(d)文献[ 10]方法;(e)文献[ 13]方法;(f)本文方法

Fig. 4. First set of images and fusion results. (a) Infrared image; (b) visible image; (c) method in Ref. [1]; (d) method in Ref. [10]; (e) method in Ref. [13]; (f) proposed method

![第二组图像及融合结果。(a)红外图像;(b)可见光图像;(c)文献[1]方法;(d)文献[10]方法;(e)文献[13]方法;(f)本文方法](/richHtml/gxxb/2018/38/2/0210002/img_5.jpg)

图 5. 第二组图像及融合结果。(a)红外图像;(b)可见光图像;(c)文献[ 1]方法;(d)文献[ 10]方法;(e)文献[ 13]方法;(f)本文方法

Fig. 5. Second set of images and fusion results. (a) Infrared image; (b) visible image; (c) method in Ref. [1]; (d) method in Ref. [10]; (e) method in Ref. [13]; (f) proposed method

表 2. 第一组图像实验结果对比

Table 2. Comparison results of the first set of images

|

表 3. 第二组图像实验结果对比

Table 3. Comparison results of the second set of images

|

5.4 融合结果分析

本文融合图像的清晰度相对其他方法要高。值得一提的是,文献[ 1]、文献[ 10]方法在图像清晰度方面有时也有不错的表现,但文献[ 1]方法采用局部能量对高频子带进行融合,文献[ 10]方法在低频融合部分单纯采用像素值取大的融合策略。这两种方法均容易引入噪声,造成图像平均梯度值偏高的假象。NSST能够更加稀疏地表示图像,产生较好的融合结果,本文方法采用NSST作为多尺度分解工具,低频部分采用改进的引导滤波算法进行融合,可以有效地保留红外图像的目标信息与可见光图像的背景信息。在引导滤波中引入图像的显著度、空间频率、标准差信息,可以使融合图像具备较好的视觉显著性、清晰度、对比度。DCSCM模型对图像的细节特征具有较强的敏感度,并且能够捕捉到图像的偏暗区域。将DCSCM模型应用到图像高频融合中,不仅能够增强融合图像的边缘、纹理特征,而且可以缓解文献[ 13]方法中引导滤波带来的阴影问题。综上所述,低频部分采用改进的引导滤波算法进行融合,高频部分采用DCSCM模型加以融合,可以使最终的融合图像保留丰富的目标、背景信息和突出细节特征,融合效果最好。

6 结论

提出了一种基于改进引导滤波和DCSCM的红外与可见光图像融合算法,在对红外与可见光源图像进行NSST分解后,采用改进的引导滤波算法对低频分量进行融合。并且,为了使融合图像具备较好的细节信息和视觉观感,采用DCSCM模型对图像高频分量进行融合。实验结果表明,本文方法在图像清晰度、对比度、信息熵等方面表现均好于其他算法,可以应用于森林防火、遥感监测等领域,是一种切实可行的融合方法。

[1] 陈木生. 结合NSCT和压缩感知的红外与可见光图像融合[J]. 中国图象图形学报, 2016, 21(1): 39-44.

陈木生. 结合NSCT和压缩感知的红外与可见光图像融合[J]. 中国图象图形学报, 2016, 21(1): 39-44.

Chen M S. Image fusion of visual and infrared image based on NSCT and compressed sensing[J]. Journal of Image and Graphics, 2016, 21(1): 39-44.

[3] 杨立新, 杨建坤, 贾辉, 等. 一种基于非采样Contourlet变换的遥感图像融合算法[J]. 中国激光, 2012, 39(s1): s109005.

杨立新, 杨建坤, 贾辉, 等. 一种基于非采样Contourlet变换的遥感图像融合算法[J]. 中国激光, 2012, 39(s1): s109005.

[5] 吴一全, 王志来. 基于目标提取与引导滤波增强的红外与可见光图像融合[J]. 光学学报, 2017, 37(8): 0810001.

吴一全, 王志来. 基于目标提取与引导滤波增强的红外与可见光图像融合[J]. 光学学报, 2017, 37(8): 0810001.

[6] 吴一全, 陶飞翔. 改进投影梯度NMF的NSST域多光谱与全色图像融合[J]. 光学学报, 2015, 35(4): 0410005.

吴一全, 陶飞翔. 改进投影梯度NMF的NSST域多光谱与全色图像融合[J]. 光学学报, 2015, 35(4): 0410005.

[7] 刘健, 雷英杰, 邢雅琼, 等. 基于改进型NSST变换的图像融合方法[J]. 控制与决策, 2017, 32(2): 275-280.

刘健, 雷英杰, 邢雅琼, 等. 基于改进型NSST变换的图像融合方法[J]. 控制与决策, 2017, 32(2): 275-280.

Liu J, Lei Y J, Xing Y Q, et al. Innovative image fusion method based on improved NSST[J]. Control and Decision, 2017, 32(2): 275-280.

[8] 吴冬鹏, 毕笃彦, 何林远, 等. 基于NSSCT的红外与可见光图像融合[J]. 光学学报, 2017, 37(7): 0710003.

吴冬鹏, 毕笃彦, 何林远, 等. 基于NSSCT的红外与可见光图像融合[J]. 光学学报, 2017, 37(7): 0710003.

[11] 赵杰, 温馨, 刘帅奇, 等. 基于NSST域的自适应区域和SCM相结合的多聚焦图像融合[J]. 计算机科学, 2017, 44(3): 318-322.

赵杰, 温馨, 刘帅奇, 等. 基于NSST域的自适应区域和SCM相结合的多聚焦图像融合[J]. 计算机科学, 2017, 44(3): 318-322.

Zhao J, Wen X, Liu S Q, et al. Multi-focus image fusion using adaptive region and SCM based on NSST domain[J]. Computer Science, 2017, 44(3): 318-322.

[14] Li Z, Zheng J, Zhu Z, et al. Weighted guided image filtering[J]. IEEE Transactions on Image Processing, 2015, 24(1): 120-129.

Li Z, Zheng J, Zhu Z, et al. Weighted guided image filtering[J]. IEEE Transactions on Image Processing, 2015, 24(1): 120-129.

[15] 谢伟, 周玉钦, 游敏. 融合梯度信息的改进引导滤波[J]. 中国图象图形学报, 2016, 21(9): 1119-1126.

谢伟, 周玉钦, 游敏. 融合梯度信息的改进引导滤波[J]. 中国图象图形学报, 2016, 21(9): 1119-1126.

Xie W, Zhou Y Q, You M. Improved guided image filtering integrated with gradient information[J]. Journal of Image and Graphics, 2016, 21(9): 1119-1126.

[16] CaiM, YangJ, CaiG. Multi-focus image fusion algorithm using LP transformation and PCNN[C]. IEEE International Conference on Software Engineering and Service Science, 2015: 237- 241.

CaiM, YangJ, CaiG. Multi-focus image fusion algorithm using LP transformation and PCNN[C]. IEEE International Conference on Software Engineering and Service Science, 2015: 237- 241.

Article Outline

江泽涛, 吴辉, 周哓玲. 基于改进引导滤波和双通道脉冲发放皮层模型的红外与可见光图像融合算法[J]. 光学学报, 2018, 38(2): 0210002. Zetao Jiang, Hui Wu, Xiaoling Zhou. Infrared and Visible Image Fusion Algorithm Based on Improved Guided Filtering and Dual-Channel Spiking Cortical Model[J]. Acta Optica Sinica, 2018, 38(2): 0210002.