基于核相关滤波的长时间目标跟踪  下载: 1095次

下载: 1095次

1 引言

目前许多单目标跟踪方法只能解决慢动作和轻微遮挡等简单环境下目标跟踪的问题[1]。对于动态环境中的实时应用,如光照变化、尺度变化、变形和遮挡带来的视觉跟踪挑战,单目标跟踪方法仍然未得到解决。因此,为了开发能够用于实际应用的跟踪方法,需要具有高精度和高效率的稳健跟踪器。

目前,对视觉跟踪方法的研究主要集中在生成式跟踪方法,它使用搜索窗口或模板,根据相似度的最高值定位目标。在生成式跟踪器中,目标通常由一系列模板表示,这些模板不包括限制跟踪器在复杂环境中实现可靠结果的背景信息。另一种常用的方法是判别式跟踪方法,该方法能够使用分类器将对象与图像背景区分开来。相关滤波器,作为最新的判别式跟踪器,已被证明比大多数生成式跟踪器具有更强大的性能。相关滤波器由于能够按照元素的乘法将运算转换到复数域,因此在计算上也是有效的。基于在线对象跟踪基准,核相关滤波(KCF)[2]算法比传统方法,如Struck[3]和TLD[4],具有更高的速度。研究人员进一步改进了最初的KCF方法,以提其高准确性和可靠性。例如,蔡玉柱等[5]在KCF算法的基础上,提出了自适应多特征融合目标跟踪算法,提高了算法的跟踪精度和稳健性。文献[ 6]中采用基于KCF的跟踪器,可以实现尺度自适应变换,以提高跟踪器的性能。但是,对于上述两种方法而言,为了提高整体性能,跟踪速度都会有所降低。

当目标被遮挡时,KCF分类器的更新会产生不可逆误差,导致跟踪结果的漂移失败。本文通过改进KCF跟踪器,提出一种新的视觉跟踪器。考虑建立相关峰的锐度和置信度图的平滑约束组合置信度,以便获得更稳健的相关响应。均值漂移(MS)[7]算法对目标遮挡具有稳健性,同时,针对潜在跟踪误差修正了MS算法的局部模板。也就是说,当KCF算法的置信映射表明跟踪结果需要校正时,则引入修正的MS算法,用于校正跟踪结果。

2 KCF跟踪器

KCF跟踪算法利用岭回归训练一组样本{

式中:

式中:

训练完成后,KCF算法在以上一帧目标位置为中心,在图像块

为了更好地适应目标外观的变化,采用线性插值的方式对滤波器系数

式中:

3 基于KCF的长时间目标跟踪

本文提出的算法是在传统的KCF跟踪算法上增加了遮挡判断和重新检测机制,利用组合置信图响应值判断跟踪结果是否需要修正。同时,针对潜在跟踪误差修正MS算法的局部模板。也就是说,当KCF算法的置信映射表明跟踪结果需要校正时,使用MS算法来校正跟踪结果。

3.1 组合置信度测量

从(3)式的检测结果中得到的置信度图

式中:

时间平滑性

式中:

当目标处于部分或完全遮挡时,在置信图中会有更多的负响应。在这种情况下,使用以下评价:

式中:

式中:

3.2 稳健性更新

对于目标跟踪,跟踪模板应该每帧都更新,以处理由于尺度、光照变化或形变引起的物体外观的变化。为了节约内存,KCF模型用前一帧中的模板对所获得的模板进行线性插值。该模板更新方法包括关于当前帧和先前帧的信息,例如变换后的目标外观和对偶空间系数。然而,KCF使用的是不适应外观变化的固定学习速率,如(4)式和(5)式所示。一旦目标跟踪失败,模型模板将被污染。

为了解决这个问题,需使更新过程适应组合置信度测量。当发生遮挡时应该停止模型模板更新以避免引入错误。通过组合置信度测量可以自适应地控制更新的学习速率,即有

式中:

3.3 块MS算法

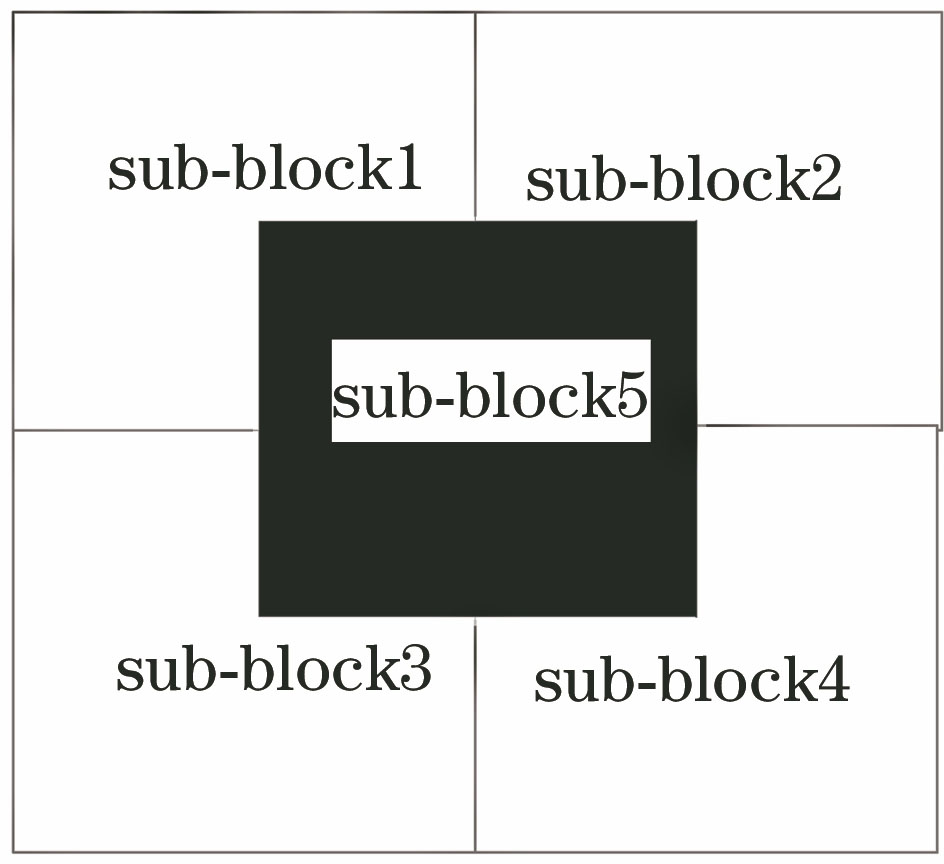

使用块MS算法迭代来提高算法的抗遮挡能力。在初始化过程中,如

式中:

在确定目标模板之后,必须通过MS迭代找到与目标模板最相似的候选块,用Bhattacharyya系数来测量目标

式中:

式中:

基于当前子块的中心位置,可以获取全局目标的新坐标,即

式中:

3.4 改进算法

针对上述问题,提出了一种自适应局部目标跟踪算法。为了改进MS的计算,利用统计直方图特征保存目标局部信息。KCF算法使用模型跟踪目标,并保存目标的全局信息,将目标的局部和全局信息结合起来,提高跟踪精度。

1) 初始化算法并读取图像序列;2) 运行KCF来估计目标位置并获取当前帧的置信图;3) 判断目标位置的置信度。如果当前帧的组合置信度

遮挡发生后即对所有子块实施MS跟踪算法。本文使用置信度最高的子块来确定整体目标的最终位置,而子块的置信度由Bhattacharyya系数和背景区分度两方面决定。

块MS算法将图像块划分为5块,如

在每个子块中同时迭代运行MS算法。利用颜色直方图作为目标模板,根据每个块中直方图的结果以及该块的中心位置,计算出具有最大相似度的块作为最终结果和新的目标坐标。本文算法具体步骤为:

Input:跟踪图像块

Output:当前帧

Step 1 初始化参数,读取视频序列;

Step 2 由(9)式训练KCF分类器;

Step 3 由(13)式获得KCF的初始位置;

Step 4 用置信度图判断位置;

Step 5 由(18)式,如果当前帧的组合置信度小于遮挡置信度阈值,运行块MS算法获取各子块;

Step 6 按(22)式和(23)式输出目标位置,或者输出KCF的位置;

Step 7 更新目标模型;

Step 8 重复Step4, Step5;

Step 9 视频序列结束;

Step 10 返回

4 分析与讨论

为了评估本文算法的性能,在计算机视觉跟踪的标准数据基准(Benchmark-tracking)[10]中选用8组视频序列验证本文算法,视频序列参数如

表 1. 视频序列

Table 1. Video sequence

|

4.1 评价标准

根据文献[ 10],通过使用精确度和成功率两种方式来测试跟踪算法的性能。首先是精确度。CLE(Center Location Error)为预估跟踪目标位置的中心点坐标与标记位置之间的欧氏距离取平均值。以视频序列中所述的中心位置误差小于一定阈值的相对数为精确度,该值越大越好(阈值通常设置20)。其次是成功率。假设跟踪目标框的重叠率超过一定阈值(通常取0.5),就可以认为当前目标跟踪成功。所有跟踪成功的视频帧占总视频帧数的百分比为成功率。视觉对象类率(VOR)重叠率计算公式为

式中:

4.2 总体性能实验

本节主要是在8组具有复杂属性的视频序列上,采用一次性评估(OPE)方法,即跟踪算法在每段视频上运行一次,得到4种对比算法的精确曲线和成功率曲线如

图 2. 4种跟踪器的精确度曲线和成功率曲线对比图。(a)精确度;(b)成功率

Fig. 2. Precision curves and success rate curves of four trackers. (a) Precision; (b) success rate

图 3. 4种对比算法在遮挡条件下的精确度曲线和成功率曲线。(a)精确度曲线;(b)成功率曲线

Fig. 3. Precision curves and success rate curves of four contrast algorithms under occlusion condition. (a) Precision; (b) success rate

表 2. 不同跟踪算法的性能比较

Table 2. Performance comparison of different tracking algorithms

|

由

由

4.3 遮挡条件下实验

当目标受严重遮挡时,在快速运动的3个视频序列上进行对比实验,目标跟踪的精确度图和成功率图如

Jogging视频中,当目标发生了严重的遮挡后,其他算法全部出现跟踪漂移现象,目标再次出现时,只有本文方法可以实现准确的跟踪;David3视频中,当目标被轻微遮挡时(#28),在#86帧左右目标被树木遮挡,KCF与本文算法的表现较好,但KCF算法跟踪由于缺少判断模型的更新机制,其跟踪框偏离了目标,引入过多的背景信息导致跟踪失败。本文算法采用组合置信度的判断机制更新模型,在遮挡条件下采用块均值漂移算法,实现了目标的长时间稳健跟踪。

5 结论

提出了一种基于KCF稳健更新和自适应局部均值滤波的长时间视觉跟踪算法。算法利用KCF在目标跟踪中的优势,引入组合置信度测量,分析当前帧中的跟踪结果,并将其用于稳健更新。如果跟踪目标被遮挡,则在算法中引入块MS算法来校正KCF的结果。该方法克服了KCF模型不能充分利用局部信息处理遮挡信息的缺点,使得跟踪更加稳健,实现了目标长时间跟踪。在视频序列中的实验结果表明,本文所提出的算法在处理严重遮挡时有较好的跟踪效果,但当目标出现运动模糊和尺度变化时,算法的性能会有所下降,需要进一步研究。

[1] 邹焱飚, 周卫林, 陈向志. 基于深度分层特征的激光视觉焊缝检测与跟踪系统研究[J]. 中国激光, 2017, 44(4): 0402009.

[3] HareS, SaffariA, Torr P H S. Struck: structured output tracking with kernels[C]∥2011 International Conference on Computer Vision, November 6-13, 2011, Barcelona, Spain. New York: IEEE, 2011: 263- 270.

[5] 蔡玉柱, 杨德东, 毛宁, 等. 基于自适应卷积特征的目标跟踪算法[J]. 光学学报, 2017, 37(3): 0315002.

[6] 高美凤, 张晓玄. 尺度自适应核相关滤波目标跟踪[J]. 激光与光电子学进展, 2018, 55(4): 041501.

[8] LiuT, WangG, Yang QX. Real-time part-based visual tracking via adaptive correlation filters[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition, June 7-12, 2015, Boston, MA, USA. NewYork: IEEE, 2015: 4902- 4912.

[9] LiY, ZhuJ. A scale adaptive kernel correlation filter tracker with feature integration[C]∥Agapito L, Bronstein M, Rother C. ECCV 2014: Computer Vision: ECCV 2014 Workshops. Cham: Springer, 2014, 8926: 254- 265.

[10] WuY, LimJ, Yang MH. Online object tracking: a benchmark[C]∥2013 IEEE Conference on computer Vision and Pattern Recognition, June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 2411- 2418.

[11] Henriques JF, CaseiroR, MartinsP, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C]∥Fitzgibbon A, Lazebnik S, Perona P, et al. Computer Vision: ECCV 2012, Berlin, Heidelberg: Springer, 2012, 7575: 702- 715.

[12] DanelljanM, Khan FS, FelsbergM, et al. Adaptive color attributes for real-time visual tracking[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus, OH, USA. New York: IEEE, 2014: 1090- 1097.

Article Outline

杨剑锋, 张建鹏. 基于核相关滤波的长时间目标跟踪[J]. 激光与光电子学进展, 2019, 56(2): 021502. Jianfeng Yang, Jianpeng Zhang. Long Time Target Tracking Based on Kernel Correlation Filtering[J]. Laser & Optoelectronics Progress, 2019, 56(2): 021502.