基于特征融合与软判决的遥感图像飞机检测  下载: 1008次

下载: 1008次

1 引言

随着高分辨率卫星遥感技术的快速发展,遥感图像的分辨率变得越来越高,获取方式也更加方便、多样,这推动了遥感图像中目标检测的发展[1]。飞机作为典型的**和民用目标,在战场监视、航空管制和交通运输等领域发挥着重要作用。然而,由于飞机类型、姿态、尺寸和复杂背景的不确定性,在遥感图像中检测飞机目标一直是一个具有挑战性的研究课题。

为了解决这个难题,前人不断提出了各种方法。Li等[2]提出了将视觉显著性和对称性相结合的方法,利用形状匹配进行飞机分类。Bo等[3]提出了一种基于区域分割的飞机检测方法。Liu等[4]基于稀疏编码提出了一种飞机特征表达的方法。上述方法均采用人工设计特征结合分类器训练的传统固定模式,存在着滑动窗口冗余、特征表征不足等局限性,导致了飞机检测的准确率不高。近年来,深度学习被广泛用于自动学习目标特征,这是因为卷积神经网络(CNN)在图像目标分类和检测领域中的性能遥遥领先于传统方法。Chen等[5]将深度置信网络(DBN)用于飞机检测,但也只是将DBN作为目标分类器,其检测性能不高且时间成本过高。Wu等[6]提出了一种二值化梯度(BING)结合CNN的检测方法,但BING产生2000~3000个候选区域,导致计算成本很高,严重影响了算法的速度。辛鹏等[7]融合了CNN中的多层特征来进行飞机检测,但存在易漏检相邻目标的缺陷。Li等[8]提出了一种基于强化学习和CNN的飞机检测架构,但是与前沿的算法相比,这种方法的检测时间过长。

由于飞机的姿态具有多方向性,学习旋转不变性对于分类器是至关重要的。针对飞机的这种特点,Zhang等[9]使用扩展直方图的梯度来获得具有旋转不变性的特征;Wang等[10]使用一个旋转不变矩阵来获得旋转不变性;Liu等[4]提出了一种基于稀疏编码的特征提取方法,虽然能在一定程度上提取旋转不变性,但对其他目标的适用性不强。本文利用数据增强的旋转、翻转技术来实现飞机姿态的多方向性,正如CNN学习图像的其他特征一样,直接学习这个特性。

由于大数据的出现和软硬件平台性能的不断提升,在自然图像中,基于深度学习的目标检测技术的性能也不断提升,并持续处于领先水平。然而,遥感图像的数据采集相对困难且人工标注的数据集较少,因此遥感图像中的目标检测技术水平一直滞后于自然图像。而迁移学习技术[11]的出现,为将深度学习中的目标检测模型应用到遥感图像上提供了可能。因此,本文以更快的区域卷积神经网络[12](Faster R-CNN)为基本架构,针对飞机目标的特点对网络模型进行改进和优化,提出了一种特征融合结合软判决的飞机检测方法。

2 更快的区域卷积神经网络

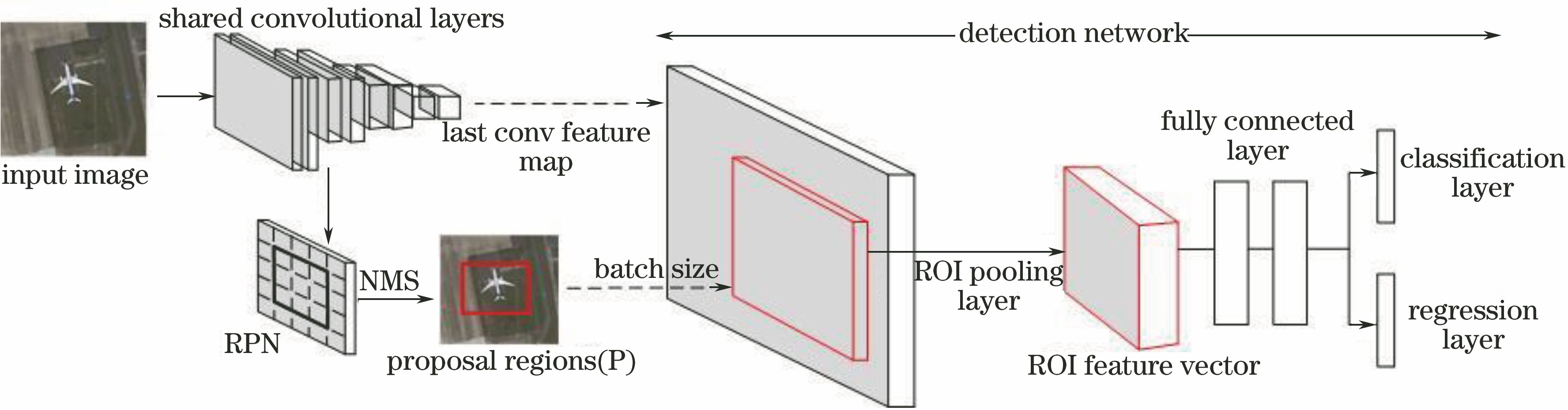

Faster R-CNN结构主要由两部分组成,分别为区域建议网络[12](RPN)和检测网络,这两个网络共享卷积层,如

2.1 区域建议网络

RPN利用CNN来生成候选框,并与后续的检测网络共享卷积层,这大大缩短了候选区域的生成时间。共享卷积层输出的最后一层卷积特征图作为RPN的输入,RPN的具体结构如

RPN使用一个3×3的滑动窗口在输入的特征图上进行卷积运算,将每个位置的计算结果映射到一个低维向量。候选框的参数化表示称为anchor,即每个anchor以滑动窗口的中心为中心对应一组尺寸和长宽比。对于卷积特征图上的每个位置,考虑3种尺寸和3种长宽比的anchors,以适应多尺度的目标。将低维向量同时输入到分类层和回归层,以进行分类和位置回归。

2.2 检测网络

检测网络主要由感兴趣区域[13](ROI)池化层、全连接层以及分类与回归层组成。对于来自同一幅图像的候选区域,如果进行全部特征的提取,将导致网络的计算成本很高。由于候选区域对应的特征图与完整特征图存在固定的映射关系,可以先对整幅图像进行特征提取,然后通过ROI池化层从完整特征图上直接得到不同候选区域对应的特征矢量,实现候选区域的特征共享。由于全连接层需要固定尺寸的输入,因此ROI池化层采用最大池化,将特征矢量固定为同一尺寸(512×7×7)。

3 多层特征融合与软判决

3.1 多层特征融合

在选取的实验图像中,飞机目标的尺寸很小,大致像素范围为32 pixel×32 pixel~64 pixel×64 pixel。经过一系列的卷积层处理后,32 pixel×32 pixel大小的飞机在最后一层卷积特征图上大概只有2 pixel×2 pixel。这样的特征图是很粗糙的,同时相邻区域可能会相互重叠,不利于飞机的检测。高层特征包含丰富的语义信息,更利于目标分类;低层特征空间分辨率较大,更利于目标定位。目标检测可以理解为分类加定位,因此一个好的目标检测系统应该同时利用低层和高层特征,尤其针对小目标物体时。

Kong等[14]从不同的卷积层提取了同一个位置的特征矢量,其中较低层特征的激活响应明显高于较高层,表明同一特征在不同层通常具有不同的响应尺度。因此融合多层特征,不能简单直接地将多层特征进行相加或合并。融合多层特征首先是利用ROI池化层从不同卷积层(“conv3”、“conv4”和“conv5”)提取候选区域对应的固定特征向量,然后依次进行L2范数归一化以及各层特征连接、尺度变换和特征降维,最后将融合后的特征输入到全连接层,如

首先使用L2范数对每层卷积层输出的第

式中

将不同层的归一化特征

进行融合连接,由于各层特征融合后的特征尺度很小,不利于网络的训练[15],因此有必要对特征进行缩放处理:

式中

利用预训练模型VGG16网络在遥感数据上进行迁移学习,融合后的特征大小需与原网络保持一致。使用1×1卷积核进行降维,使输入到全连接层的特征大小为512×7×7。1×1卷积核已在GoogLeNet、ResNet等网络中得到广泛应用,它不仅能在保持特征尺度不变的前提下实现降维,而且能利用后续非线性激活函数来增加网络的非线性特性,最终实现跨通道的特征信息融合。

3.2 软判决的非极大值抑制

由于没有强制要求检测网络只产生唯一检测框,因此会出现多个检测框包围同一目标的情况。为了避免产生误检,利用非极大值抑制[16](NMS)来剔除多余的检测框,从而留下最优的检测框,如

NMS实现流程为:1)将集合

传统的NMS算法对邻近检测框的判决函数可表示为

(5)式设置一个硬性阈值

引入软判决对判决函数式进行改进,改进后的判决函数可表示为

当邻近检测框

(6)式减小了

4 实验与结果分析

所提算法的实验环境为:处理器为i7-7700,主频为3.6 GHz,内存为16 G,显卡为NVIDIA GTX1060,操作系统为Ubuntu14.04,网络框架为Caffe。实验中采用检测率(DR)、虚警率(FAR)和平均运行时间作为评价指标。

4.1 实验数据

所有的实验数据均来自Google Earth中的机场遥感影像,比如北京首都国际机场、美国波士顿国际机场等共300个机场,空间分辨率为1.19 m。选取150个机场中的飞机图像作为训练和验证集,图像大小范围为375 pixel×375 pixel~400 pixel×400 pixel,共1500张。将剩余150个机场中的飞机图像作为测试集,图像大小范围为900 pixel×800 pixel~1000 pixel×900 pixel,共150张。为了避免出现过拟合和学习飞机的旋转不变性特征,在此采用数据增强来扩充训练验证集图片的数量。将1500张图片随机旋转90°、180°和270°,同时以0.5的概率进行水平或垂直翻转,最终使得训练验证集的图片数量为5000张,其中训练集和验证集的图片各2500张。所有的图片标签均为手工标注,

4.2 网络训练

虽然遥感图像相对于自然图像具有尺度多样、多方向、目标小、背景复杂等特点,但其含有的边缘、颜色等低级语义特征和抽象的高级语义特征等目标特征是类似的。卷积神经网络同样可以从遥感图像中学习和提取低级或高级语义特征。对于尺度多样性、多方向性、背景复杂等特点,卷积神经网络可以通过模型训练从实验数据中学习得到,就如同学习边缘颜色等语义特征一样。深度学习模型的目标检测需要大规模的数据训练,而目前的遥感数据样本有限,且数据的标注也需要大量的人工成本,这就是深度学习在遥感图像领域应用较少的主要原因,因此从Google Earth搜集遥感图像并进行人工标注数据。使用飞机遥感数据重新训练一个新的CNN是低效的,甚至可能会导致过拟合。低层卷积层学到的都是边缘纹理以及颜色等低级语义特征,飞机遥感图像和普通自然图像上的这些特征是一致的,如

4.3 结果分析

为了分析融合不同层的特征对实验结果的影响,在其他条件不变的情况下,采用控制变量法进行对比实验,结果如

由

表 1. 特征融合的结果

Table 1. Results of feature fusion

|

后,在最后一层即第5层卷积特征图上飞机的特征尺度很小,这样不利于飞机的定位。粗糙、高语义的高层特征有利于目标的分类,而精细、高分辨率的低层特征有利于目标的定位,因此融合多层特征能够结合不同层的优势,从而提高针对飞机这样的小目标的网络检测能力。逐渐增加融合的层数能不断提高DR,但融合层数增加到第2层时,DR并没有继续提高,这表明融合3,4,5层特征的DR最优,继续融合其他层的特征无法提供额外的有用信息,即网络性能的提升已经饱和。以下实验中若无特殊说明,默认融合3,4,5层特征。为了更直观地说明特征融合的重要性,给出不同方法的检测结果对比图,如

图 8. 不同方法的网络检测结果。(a)第5层的结果; (b)融合3,4,5层的结果

Fig. 8. Network detection results by different methods. (a) Results of 5th layer; (b) results after fusion of 3, 4, 5 layers

为了说明改进NMS算法的有效性,在飞机测试集上进行对比实验。采用软判决NMS算法得到的DR为91.90%,所提算法得到的DR为94.25%。采用软判决NMS算法测试集时DR提高了约2%。这是因为传统的NMS算法将与检测框

图 9. NMS算法改进前后的飞机检测结果。(a)传统NMS算法; (b)改进NMS算法

Fig. 9. Airplane detection results before and after improvement of NMS algorithm. (a) Traditional NMS; (b) improved NMS

4.4 方法对比

为了说明所提方法的优越性,选取已有的飞机检测方法进行对比实验。在本文实验环境下使用网上公开的代码进行仿真,记录每种方法在测试集上的检测率、虚警率和平均运行时间,并进行比较,结果如

表 2. 不同飞机检测方法的结果对比

Table 2. Comparison among airplane detection results by different methods

|

由

5 结论

以更快的区域卷积神经网络为基本框架,提出了一种特征融合结合软判决的遥感图像飞机检测方法。依次采用L2范数归一化、特征连接、尺度缩放和特征降维来融合多层特征,引入软判决来改进传统的非极大值抑制方法。实验结果表明,所提方法能够提高小目标检测的性能,同时降低了网络在目标高度重叠时的漏检率,最终得到检测率为94.25%、虚警率为5.5%、平均运行时间为0.16 s的实验结果。所提方法优于现有的其他飞机检测方法,对于飞机的实时、精确检测具有较好的理论指导和实际意义。

[1] 宋明珠, 曲宏松, 金光. 含噪光学遥感图像海面弱小舰船目标检测[J]. 光学学报, 2017, 37(10): 1011004.

[2] LiW, Xiang SM, Wang HB, et al. Robust airplane detection in satellite images[C]. IEEE International Conference on Image Processing, 2011: 2821- 2824.

[3] Bo SK, Jing YJ. Region-based airplane detection in remotely sensed imagery[C]. International Congress on Image and Signal Processing, 2010: 1923- 1926.

[5] Chen XY, Xiang SM, Liu CL, et al. Aircraft detection by deep belief nets[C]. Asian Conference on Pattern Recognition, 2013: 54- 58.

[6] WuH, ZhangH, Zhang JF, et al. Fast aircraft detection in satellite images based on convolutional neural networks[C]. IEEE International Conference on Image Processing, 2015: 4210- 4214.

[7] 辛鹏, 许悦雷, 唐红, 等. 全卷积网络多层特征融合的飞机快速检测[J]. 光学学报, 2018, 38(3): 0315003.

[13] Girshick RB. Fast R-CNN[C]. International Conference on Computer Vision, 2015: 1440- 1448.

[14] KongT, YaoA, ChenY, et al. HyperNet: towards accurate region proposal generation and joint object detection[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2016: 845- 853.

[16] RotheR, GuillauminM, Van GoolL, et al. Non-maximum suppression for object detection by passing messages between windows[C]. Asian Conference on Computer Vision, 2014: 290- 306.

Article Outline

朱明明, 许悦雷, 马时平, 李帅, 马红强. 基于特征融合与软判决的遥感图像飞机检测[J]. 光学学报, 2019, 39(2): 0210001. Mingming Zhu, Yuelei Xu, Shiping Ma, Shuai Li, Hongqiang Ma. Airplane Detection Based on Feature Fusion and Soft Decision in Remote Sensing Images[J]. Acta Optica Sinica, 2019, 39(2): 0210001.