基于卷积神经网络的特征融合视频目标跟踪方法  下载: 1488次

下载: 1488次

1 引言

目标跟踪,也被称为对象跟踪,是指一种当目标对象在视频中移动时自动估计其轨迹的技术,被广泛应用在安全视频监控、人机交互和体育视频分析等诸多领域中。目标跟踪在实际应用中可能需要实时跟踪多个移动对象,但其典型的处理方式是分别跟踪每个目标。视频的第一帧手动或自动识别到要跟踪的目标之后,后续帧需自动跟踪对象的轨迹。虽然现有的计算机视觉技术可以在良好的控制环境下为这个问题提供令人满意的解决方案,但是也会存在一些问题,出现诸如部分遮挡、背景杂乱、快速和突然运动、照明变化剧烈等因素干扰,因而在许多实际的应用场景中存在着难点和挑战[1-5]。大体来说,目前目标跟踪技术存在着几方面的挑战:

1) 当受到许多外界因素干扰时,如光照变化、遮挡、背景噪声等,目标会发生不规则变化,从而会增加跟踪的难度;

2) 跟踪模型的构建在很大程度上会受到复杂背景变换的影响,从而使得跟踪的目标会受到复杂背景的影响;

3) 当跟踪的目标由于遮挡等原因消失在视野中后,到目标再次出现时,能准确重新初始化目标位置十分困难。

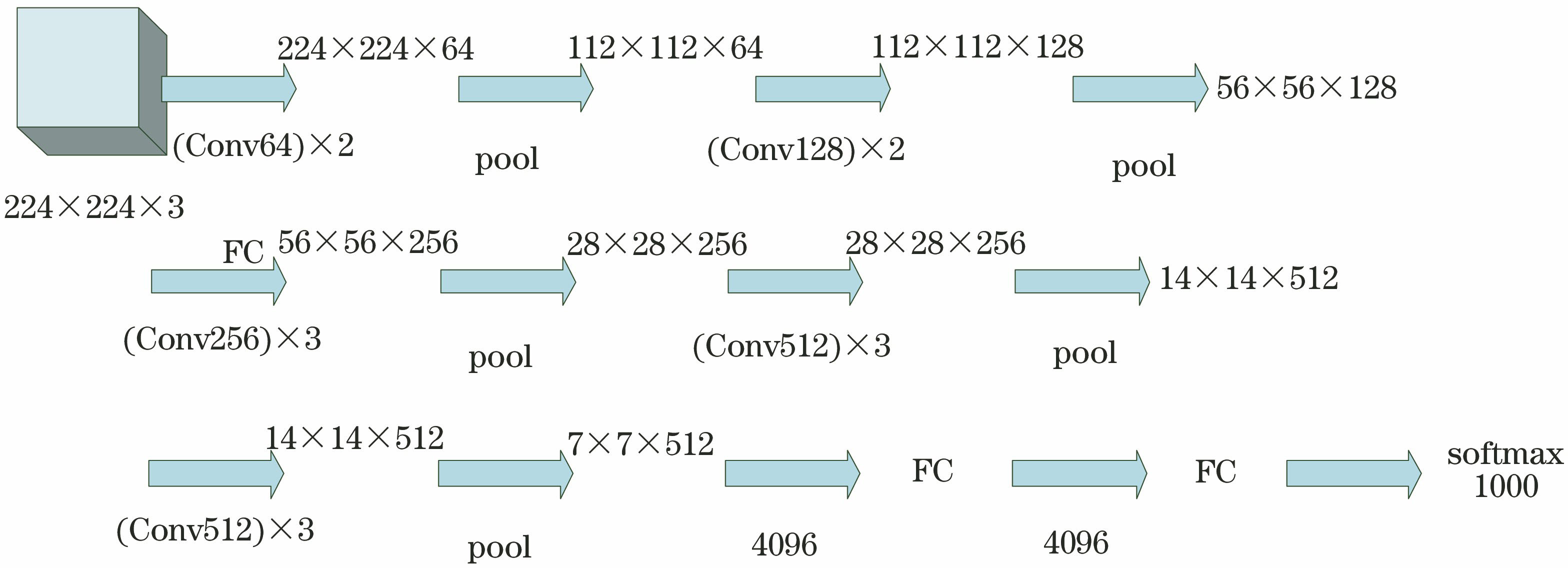

由此可见,一种理想的目标跟踪算法应具备处理复杂情况的能力,能够在不利因素下实现对目标的实时和准确跟踪。卷积神经网络(CNN)可以获得更具有稳健性的深度特征, 边缘检测能够在对噪声进行抑制的同时还能够将边缘定位精确,进而捕捉到亮度急剧变化的区域。将VGG16神经网络提取的深度特征与边缘特征作为两条独立的跟踪线索,通过特征不确定性的自适应融合的策略来实现两种特征的融合,在获得深度特征的同时实现对边缘更加精确的定位,从而达到对目标的准确跟踪的目的。

2 深度特征表达

VGGNet神经网络是牛津大学计算机课题组与Google DeepMind 共同研发的,主要探索神经网络性能与神经网络深度之间的关系。VGG16神经网络是VGGNet当中的一个版本,其框架如

随着深度CNN出现,网络的完全连接层(FC)已经被普遍用于图像表示[6-7]。深卷积层的信息更有利于图像分类[8-9],另一方面,与较深卷积层相比,浅卷积层更适合于视觉跟踪[10]。深卷积层具有辨别力,并具有高级视觉的信息,相比之下,浅卷积层包含了高空间分辨率的低级特征,有利于定位。因此采取的方案为提取VGG16神经网络Conv1-2、Conv2-2和Conv5-3卷积层上的深度特征与边缘特征,对它们进行自适应融合来达到跟踪目的。

2.1 相关滤波跟踪方法

记k通道的目标外观模板为x1,以

式中:λ为正则化参数;y为相关滤波器的期望输出;*为循环相关的操作。通过傅里叶变换快速求解,可以得到相关滤波器[11]为

式中:相关变量的频域描述用相应的大写字母表示,

式中:F-1为傅里叶逆变换。f的最大值即目标出现的新位置。为了消除目标外观变化造成的不利影响,滤波器需要在线更新才能持续对目标进行跟踪,采取的更新方式为将(2)式拆分成分子

式中:ζ为学习率;t为当前帧的序列号。

2.2 深度特征提取

在VGG16卷神经网络中,低层特征能更好地保留空间信息,深层特征能包含更多的语义信息。记目标的样本为x2,提取第m层的第k个通道的特征,m∈

3 边缘特征提取

边缘检测能对噪声进行抑制,同时还能够将边缘精确定位,因而在特征提取中应用十分广泛,已经成为了一个十分重要的研究领域。通常把极值点或者灰度值发生急剧变化的点定义为边缘点,当灰度不再连续变化时就是物体的边缘,那些与边缘方向垂直的像素的变化都相对比较剧烈,而那些沿着边缘方向的像素的变化则十分平缓[12-14]。

图像函数g(x,y)在点(x,y)的梯度是一个矢量,即

式中:i和j分别为x方向和y方向的单位矢量。θ方向上的变化率为

变化率的最大方向为

梯度值大小为

采用一阶有限差分法来近似获得图像的灰度值梯度,从而可以得到在x方向上的偏导数和y方向上的偏导数。近些年,许多科研工作者基于边缘检测提出了一系列的模板算子以及其相对应的算法。Prewitt算子、Sobel算子和Roberts算子是常用的边缘检测算子。边缘检测算子可产生图像边缘增强效果的运算单元,其作用就是提供边缘候选点。作为一阶微分算子,Roberts算子具有结构简单、计算量小、对细节反应敏感的特点,与其他算子相比,Roberts算子可不经过后处理就可以给出相对较细的边缘。因此本文采用Roberts算子来提取边缘特征。

4 特征融合策略

为了能够融合边缘特征跟深度特征,需计算二者之间的相似程度。采用Bhattacharyya系数作为特征相似性度量法[15],具体定义为

式中:P=

为了能够提高融合以后似然函数的鉴别能力以及噪声的影响,采用特征不确定性度量的方式来达到多特征的自适应融合[16]。特征的不确定性表达式为

式中:

式中:p(zi|xj)为第i种特征在第j个粒子状态下的观测概率值。K(pi)越大,则表明pi的不确定性也越大,估计的准确度就越低。

文献[ 16]提出的方法是基于特征不确定性的自适应融合,此自适应融合方式是将乘性融合方式和加性融合方式两种传统的方式统一到一个框架下,然后根据场景的变化,自适应地调节特征在跟踪中的不确定性,进而调整特征对跟踪结果的贡献。这个过程就是把每一种特征的观测概率值和一个正比于此特征不确定性的均匀分布通过加法运算进行归一化处理,然后取它们的乘积,公式为

式中:n为特征种类数。当

式中:T1为深度特征的不确定性;T2为边缘特征的不确定性;Ti=

此融合方式通过采取特征不确定性来改变它所在观测概率当中的比例,从而达到深度特征与边缘特征的融合。

5 算法的实现

本文算法在相关粒子滤波的框架下来实现对视频目标的跟踪,其具体流程如下。

1) 在初始帧状态下通过手动的方式来选择需要跟踪的目标,并且把目标框当成正样本,在它的周围选取一系列负样本并送入VGG16网络中;

2) 获取目标模型的边缘特征,并获取N个初始粒子

3) 由xt=Axt-1+N来获得当前帧的预测状态xt;

4) 计算深度特征和边缘特征的观测概率并将两者进行归一化处理,并求出这两个特征观测概率的熵;

5) 由粒子空间的位置坐标计算方差,并计算这两种特征各自的不确定性;

6) 计算似然函数p(z1,z2|xpresent),通过

7) 由粒子权值的分布情况来决定是否需要采样,当

8) 转到3),执行下一帧的跟踪。

6 实验结果及分析

在OTB100数据集上,将本文算法与目前比较主流的5个目标跟踪算法DLT(deep learning tracker)[17]、KCF(kernel correlation filter)[18]、CSK(circulant structure of tracking-by-detection with kernels)[19]、ORIA(online robust image alignment)[20]、CT(compressive tracking)[21]在100个测试视频序列上进行对比实验。采用一次性通过评估(OPE)[22]的精度曲线图和成功率曲线图来对算法的性能进行评判。

由

为了可以更加有效地验证本文算法的性能,在OTB100数据集上挑选了Car4、David、Dudek、Singer1、Soccer和Sylvester这6个复杂而具有挑战性的视频序列进行测试,并将本文算法与目前5个比较主流的目标跟踪算法进行比较。采取的方式是根据每一帧的中心位置误差跟重叠率来达到更直观的对比。中心位置误差的计算公式为

式中:(xp,yp)为跟踪结果的坐标位置;(xg,yg)为在原图像中真实的坐标位置。当d值小于20 pixel时,认为跟踪正确。重叠率的计算公式为

式中:DT为跟踪结果所获得的矩形边框;DG为原图像真实值所对应的矩形边框。在跟踪过程中,S的值大于0.5时,当前帧的跟踪效果满足要求,认为跟踪是成功的;若小于0.5,就认为当前帧的跟踪是失败的。

如

图 4. 中心位置误差对比结果(像素级)。(a) Car4;(b) David;(c) Dudek;(d) Singer1;(e) Soccer;(f) Sylvester

Fig. 4. Comparison of center position error (pixel level) . (a) Car4; (b) David; (c) Dudek; (d) Singer1; (e) Soccer; (f) Sylvester

图 5. 重叠率对比结果。(a) Car4;(b) David;(c) Dudek;(d) Singer1;(e) Soccer; (f) Sylvester

Fig. 5. Comparison of overlap rate. (a) Car4; (b) David; (c) Dudek; (d) Singer1; (e) Soccer; (f) Sylvester

7 结论

提出一种基于卷积神经网络与边缘特征相融合的策略来实现目标跟踪。对VGG16神经网络中Conv1-2、Conv2-2与Conv5-3卷积层获得的深度特征与边缘特征进行自适应融合来实现跟踪,能提高跟踪精度。在OTB100数据集上对本文算法进行测试,并将本文算法与其他相关跟踪算法在每一帧上进行算法性能对比,结果表明本文算法能够对目标实现更有效的跟踪,具有较高的跟踪效率。

[1] Wu Y, Lim J, Yang M H. Object tracking benchmark[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848.

[2] WuY, LimJ, Yang MH. Online object tracking: a benchmark[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, June 23-24, 2013, Portland, Oregon. New York: IEEE, 2013: 2411- 2418.

[3] 高美凤, 张晓玄. 尺度自适应核相关滤波目标跟踪[J]. 激光与光电子学进展, 2018, 55(4): 041501.

[4] 王艳川, 黄海, 李邵梅, 等. 基于在线检测和尺度自适应的相关滤波跟踪[J]. 光学学报, 2018, 38(2): 0215002.

[5] 仇春春, 李庆武, 王恬, 等. 一种改进的IVT目标跟踪算法[J]. 激光与光电子学进展, 2016, 53(1): 011002.

[6] OquabM, BottouL, LaptevI, et al. Learning and transferring mid-level image representations using convolutional neural networks[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus, Ohio. New York: IEEE, 2014: 1717- 1724.

[7] SimonyanK, Zisserman A. Very deep convolutional networks for large-scale image recognition[J/OL]. ( 2015-04-10)[2019-05-12]. https:∥arxiv.org/abs/1409. 1556.

[8] CimpoiM, MajiS, VedaldiA. Deep filter banks for texture recognition and segmentation[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, June 7-12, 2015, Boston, USA. New York: IEEE, 2015: 3828- 3836.

[9] LiuL, Shen C, van den Hengel A. The treasure beneath convolutional layers: cross-convolutional-layer pooling for image classification[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, June 7-12, 2015, Boston, USA. New York: IEEE, 2015: 4749- 4757.

[10] DanelljanM, HagerG, Shahbaz KhanF, et al. Convolutional features for correlation filter based visual tracking[C]∥Proceedings of the IEEE International Conference on Computer Vision Workshops, June 7-12, 2015, Boston, USA. New York: IEEE, 2015: 58- 66.

[11] 杨丽娟, 张白桦, 叶旭桢. 快速傅里叶变换FFT及其应用[J]. 光电工程, 2004, 31(s1): 1-3.

Yang L J, Zhang B H, Ye X Z. Fast Fourier transform FFT and its application[J]. Opto-Electronic Engineering, 2004, 31(s1): 1-3.

[12] 李志国, 顾鑫, 祝树生, 等. 基于特征确定性的目标跟踪算法[J]. 激光与红外, 2015, 45(5): 576-579.

Li Z G, Gu X, Zhu S S, et al. Target tracking algorithm based on certainty measurement of the feature[J]. Laser & Infrared, 2015, 45(5): 576-579.

[13] 段瑞玲, 李庆祥, 李玉和. 图像边缘检测方法研究综述[J]. 光学技术, 2005, 31(3): 415-419.

Duan R L, Li Q X, Li Y H. Summary of image edge detection[J]. Optical Technique, 2005, 31(3): 415-419.

[14] 李聪, 鹿存跃, 赵珣, 等. 特征融合的尺度自适应相关滤波跟踪算法[J]. 光学学报, 2018, 38(5): 0515001.

[16] 顾鑫, 王海涛, 汪凌峰, 等. 基于不确定性度量的多特征融合跟踪[J]. 自动化学报, 2011, 37(5): 550-559.

Gu X, Wang H T, Wang L F, et al. Fusing multiple features for object tracking based on uncertainty measurement[J]. Acta Automatica Sinica, 2011, 37(5): 550-559.

[17] WangN, Yeung DY. Learning a deep compact image representation for visual tracking[C]∥Advances in Neural Information Processing Systems, December 5-8, 2013, Lake Tahoe, Nevada, United States. Canada: NIPS, 2013: 809- 817.

[18] Henriques J F, Caseiro R, Martins P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE transactions on pattern analysis and machine intelligence, 2014, 37(3): 583-596.

[19] Henriques JF, CaseiroR, MartinsP, et al. Exploiting the circulant structure of tracking-by-detection with kernels[M] ∥Fitzgibbon A, Lazebnik S, Perona P, et al. Computer vision-ECCV 2012. Lecture notes in computer science. Berlin, Heidelberg: Springer, 2012, 7575: 702- 715.

[20] WuY, ShenB, LingH. Online robust image alignment via iterative convex optimization[C]∥2012 IEEE Conference on Computer Vision and Pattern Recognition, June 16-21, 2012, Providence, RI, USA. New York: IEEE, 2012: 1808- 1814.

[21] ZhangK, ZhangL, Yang MH. Real-time compressive tracking[M] ∥Fitzgibbon A, Lazebnik S, Perona P, et al. Computer vision-ECCV 2012. Lecture notes in computer science. Berlin, Heidelberg: Springer, 2012, 7574: 864- 877.

刘美菊, 曹永战, 朱树云, 杨尚奎. 基于卷积神经网络的特征融合视频目标跟踪方法[J]. 激光与光电子学进展, 2020, 57(4): 041502. Meiju Liu, Yongzhan Cao, Shuyun Zhu, Shangkui Yang. Feature Fusion Video Target Tracking Method Based on Convolutional Neural Network[J]. Laser & Optoelectronics Progress, 2020, 57(4): 041502.