基于多尺度卷积特征融合的行人重识别  下载: 1648次

下载: 1648次

1 引言

行人重识别是一项跨摄像机检索行人的任务,即给定一个感兴趣的行人进行查询,其目标是从其他多个摄像机收集的数据图像库中检索出这个行人的所有图片。在此任务中,行人在不同摄像机场景下的外观和所处环境会经历很多变化,比如人的姿势、环境光照和物体遮挡等,学习到更有稳健性的特征表示仍是行人重识别的一大挑战。行人重识别的精确度很大程度上取决于行人特征的表示,对于行人的特征信息获取得越全面,行人重识别的效果就越好。文献[ 1]中提出了一种基于卷积神经网络判别特征学习的模型,提升了对样本间距离关系的约束,可使网络得到判别性强的特征。文献[ 2]中采用增强聚合通道特征(ACF)算法检测行人,将直方图和纹理特征结合作为行人特征描述子,很好地提升了特征的表示能力。近几年,由于深度神经网络学习到的特征表示相比于传统手工提取特征的方法具有更高的辨识能力,因此深度学习方法在行人重识别研究领域占据主导地位。文献[ 3]中提出了一个新的网络模型,同时学习特征和对应的相似性度量,以提升特征的鉴别能力。文献[ 4]中提出了一个多任务深度网络,使用排序任务和分类任务在不同的网络层进行优化,得到更具有识别力的特征表示。由于这些方法仅利用行人的全局特征,当检测目标存在关键部分信息缺失的情况时,这些特征并不能提供良好的辨别能力。

为解决这个问题,研究者提出了一些专注于学习有判别力的部分特征表示,以增强行人重识别的稳健性。文献[ 5]中利用提取人体骨骼关键点的方法(GLAD)把行人图片分为头部、上身和下身三个部分,之后将整张行人图片与三个局部图片一起输入到一个参数共享的卷积神经网络(CNN)中,最后提取的特征融合了全局和局部的特征。但这种方法首先需要预先训练好骨骼关键点模型,其次,分块区域的参数共享使得局部有效信息不能被充分挖掘。针对这个问题,文献[ 6]中提出了一个基于部分的卷积基准模型(PCB),这种方法在特征提取层后的池化层对行人特征图进行水平切分,平均切分为6个小块,并分别送入不共享权重的全连接层进行预测。由于身体部分不对齐的问题会使得小分块预测不准确,作者又使用一个精确部分池化(RPP)网络来精炼每一分块的特征,但这个RPP网络属于后续处理操作,整个模型不能使用端到端的方式进行训练,而且单一固定的局部尺寸划分也不能充分地提取出有效的局部信息。

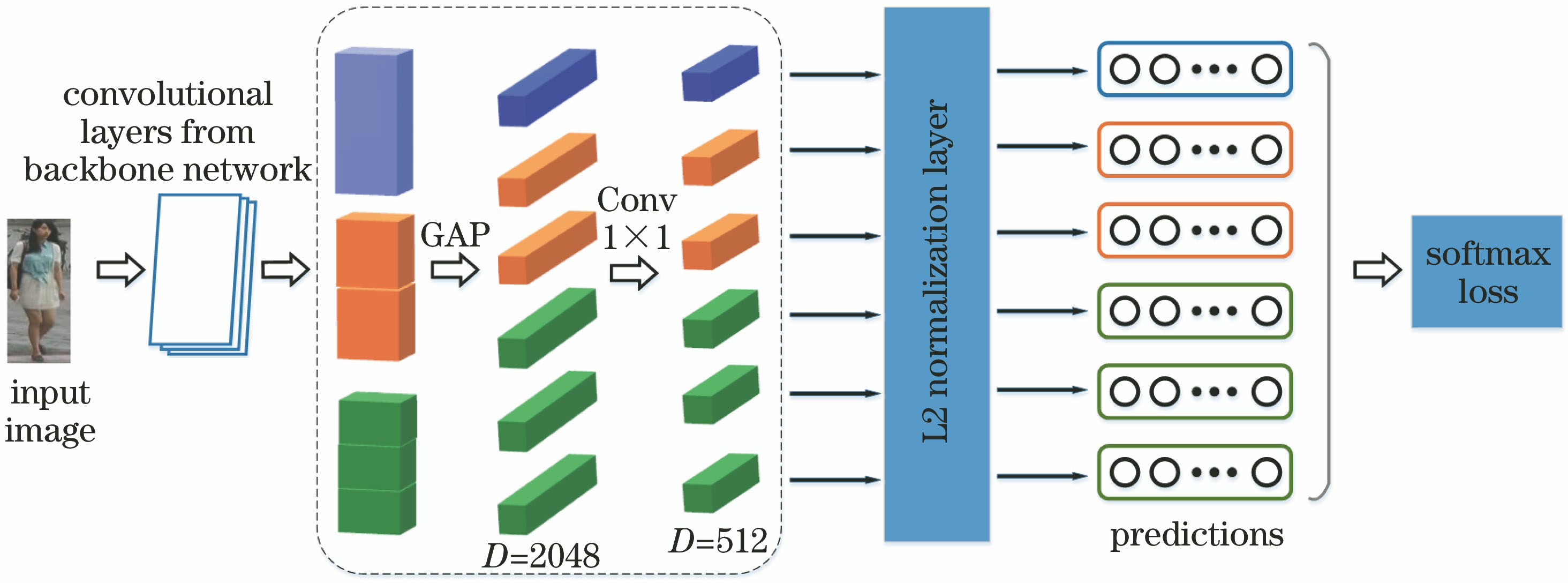

本文提出了一种多尺度卷积特征融合的方法,可解决全局特征判别信息不足的问题。采用金字塔池化方法将特征图切分为多个空间区域,然后对每个空间区域特征输出都独立地学习分类。在每一个分类器之前归一化特征向量和权重,以提升各个分类器的分类性能,在预测阶段将多个特征向量进行融合,以判别行人身份。在数据集Market1501[7]、DukeMTMC-reID[8]上对所提算法的有效性进行实验验证,结果表明,本文算法可以有效地提升行人的重识别精度。

2 基于多尺度特征融合的行人重识别

2.1 网络结构

如

2.2 金字塔池化的多尺度特征

提取局部特征的常用思路主要有图像切块、注意力机制、利用骨架关键点定位以及姿态校正等。图像切块是一种不依赖辅助模型、简单而又有效的方法。本文使用空间金字塔池化对图片进行水平分割和池化,获得全局特征和多尺度局部特征的特征向量。全局特征可以对行人进行快速识别,同时考虑了整幅行人图像各部件之间的联系。局部特征可以很好地解决遮挡和视角变化大引起的关键信息缺失问题[9],两者的有效融合可以增强特征的表示能力。

金字塔池化(SPP)是由He等[10]2015年提出的,主要是为了解决深度卷积网络中输入图片尺寸固定的问题。现有的CNN中对于结构已经确定的网络需要输入一张固定大小的图片,对于希望检测各种大小图片的时候,往往要经过裁剪或缩放等操作,这样会降低识别检测的精度,于是作者提出空间金字塔池化方法使现有的网络结构可以适应任意大小尺寸的图片。具体操作为:把输入图片的特征图复制为3份,对每一份采用1×1、2×2、4×4的网格划分,再对每个网格中的特征块使用最大池化方法进行处理,得到21个固定的特征向量,然后把这些向量平铺组成一个新的特征向量,并送入全连接层、softmax层进行预测分类。本文在以上金字塔池化策略的基础上做出修改:1) 固定网络输入图片的尺寸,因而骨干网络提取出的特征图尺寸也固定,使用金字塔池化的目的是产生多个包含不同局部信息的特征向量;2) 使用平均池化并修改池化的内核和步长,将产生的6个单维固定通道数的特征向量送入不共享参数的全连接层,目的是更充分地提取各种特征的关键信息。

图 2. 所提分块策略与PCB分块策略比较

Fig. 2. Comparison of our blocking strategy with PCB blocking strategy

在图片的分块策略上,PCB[6]方法也是把图片分成6个固定尺寸的矩形块,然后进行独立分类,如

2.3 L2归一化层

目前,深度卷积网络在分类问题中[11]使用softmax函数,因为其计算简单,对于类间距离优化效果显著。但是,由于权重向量和特征向量的尺度不一致,在少数情况下仍会出现两类之间的距离小于某一类的类间距离,softmax函数易发生误判。为了解决这个问题,使用L2归一化层对softmax的所有特征和权重向量做归一化处理,去除偏置向量,提升softmax的分类效果。传统的softmax损失函数公式为

式中:

从(2)式得到(

式中

图 3. 二分类的几何示意图。(a)原始的softmax loss;(b)归一化权重和特征后的softmax loss

Fig. 3. Geometric diagram of the second classification. (a) Original softmax loss; (b) softmax loss with normalized weights and features

3 实验分析

3.1 数据集和评估标准

为了验证本文所提算法的有效性,选择常用的行人重识别数据集Market-1501[7]和DukeMTMC-reID[8]评估该方法,并和几种最新的行人重识别算法进行比较。

Market-1501包含从6个摄像机视图中收集的1501个行人的32668张标记图像。这些图像是由目标检测算法——应变部件模型(DPM)[12]检测得出。数据集分为两部分:包含用来训练的751个行人的12936张图像和用于测试的包含750个行人的19732张图像。在训练集中平均每个行人有17.2张图像。在测试中,使用由750个行人组成的3368张样本用作查询对象,使用单查询方式评估检索数据库中的匹配行人。

DukeMTMC-reID是一个新发布的大规模行人重识别数据集,包括从8个摄像机采集的36411个标记图像,共包含1404个不同行人。与Market-1501类似,DukeMTMC-reID也把数据集平均分成两部分,使用包含702个行人的16522张图片用于训练,余下702个行人用于测试,抽去2228张图片用作查询图像,使用单查询方式在由17661张图片组成的数据库中匹配相似行人。对于这两个数据集,都使用rank-1精度和平均精确率mAP这两个指标作为评估标准。

3.2 实验细节

选用残差网络Resnet50作为提取特征的骨干网络,权重的初始化使用在数据集ImageNet上预训练好的参数,以便减少训练时间。调整输入行人图片的尺寸为384 pixel´192 pixel,并且对Resnet50网络的conv4_1层的步长设置为1,去除之后的平均池化层和全连接层,输入图片经过骨干网络得到的特征图大小为24 pixel×12 pixel×2048 pixel。特征图经过金字塔池化之后输出6个2048维的特征向量。

在训练过程中,设定骨干网络的初始学习率为0.01,其他网络层的学习率为0.1,在40代之后学习率呈指数衰减,衰减系数为0.01。模型总共训练60代,使用随机梯度下降(SGD)法对每一个mini-batch进行更新参数,mini-batch的大小设置为16,动量为0.9。对于池化后的每一个特征向量独立进行分类,模型的总损失为每个分类损失之和。在验证时,把输入图片经过卷积池化后得到的多个特征向量串联起来,获得一个12288长度的新特征向量,查询图像使用新特征向量与数据库中的每张图片的新特征向量进行欧式距离计算,按照距离从大到小进行排列。

实验平台是基于64位的Ubuntu16.04操作系统和NVIDIA GTX 1070 GPU,采用的深度学习框架为Pytorch,python版本为3.6,训练时间约为240 min。

3.3 实验结果分析

选用CamStyle[14]和PCB中使用的基准模型作为本文算法评估的基准模型,该模型精度比IDE[15]高很多,重新复现这个基准并对参数进行微调,所得结果与报道的结果稍有不同,在Market-1501数据集上rank-1精度为86.88%,平均精确率为69.59%。

为了测试本文算法的有效性,分别把多尺度金字塔池化层和L2归一化层与基准模型结合,观察所提算法对基准网络的提升效果,结果如

表 1. 两种方法对基准模型的提升效果

Table 1. Effects of two methods for improving baseline model

| ||||||||||||||||||||||||||||||||||

为了验证本文分块策略的合理性,复现了未使用RPP方法PCB模型的结果,并且改变金字塔池化策略,由之前分割的6个水平分块变成7个和9个水平分块,分块细化,实验结果如

表 2. 不同分块模型性能比较

Table 2. Performance comparison of different block models

| ||||||||||||||||||||||||||||||||||

3.4 与目前主流算法的比较

为了验证本文所提算法的优越性,将本文算法与目前主流的7种行人重识别算法进行对比,这几类算法分别是精准姿态嵌入(PSE)[17]、全局-局部特征描述子(GLAD)[5]、奇异向量分解(SVDNet)[18]、多尺度特征(MultiScale)[19]、多层特征融合(MLFN)[20]、注意力机制(HA-CNN)[21]和深度金字塔特征学习(DPFL)[19],都是基于卷积神经网络提取特征的算法,各类算法的rank-1精度和mAP如

图 4. 算法识别效果图。(a) Baseline;(b) PCB (out RPP);(c) baseline+SPP (1+2+6);(d) ours

Fig. 4. Results of recognition algorithm. (a) Baseline; (b) PCB (out RPP); (c) baseline+SPP (1+2+6); (d) ours

表 3. 本文算法与主流算法的性能比较

Table 3. Performance comparison of our algorithm with mainstream algorithms

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||

4 结论

本文所提的多尺度卷积特征融合方法具有如下特征:1) 把使用金字塔池化后得到的全局特征和多尺度局部特征向量独立分类,以弥补全局特征判别信息不足的缺陷;2) 归一化每个分类器的权重与特征,使得损失函数只优化权重与特征之间的角度,提升了分类性能;3) 融合多个不同特征向量预测行人身份。结果表明,所提方法取得了很好的行人重识别效果。下一步的研究工作是获取更加精细化的局部特征与全局特征融合,提升行人重识别性能。

[1] 陈兵, 查宇飞, 李运强, 等. 基于卷积神经网络判别特征学习的行人重识别[J]. 光学学报, 2018, 38(7): 0720001.

[2] 黄新宇, 许娇龙, 郭纲, 等. 基于增强聚合通道特征的实时行人重识别[J]. 激光与光电子学进展, 2017, 54(9): 091001.

[3] AhmedE, JonesM, Marks TK. An improved deep learning architecture for person re-identification[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 3908- 3916.

[4] Chen WH, Chen XT, Zhang JG, et al.A multi-task deep network for person re-identification[C]∥Proceedings of the Thirty-First AAAI Conference on Artificial Intelligence, February 12-17, 2016, Phoenix.New York: AAAI Press, 2016: 3988- 3994.

[5] WeiL, ZhangS, YaoH, et al. GLAD: global-local-alignment descriptor for pedestrian retrieval[C]∥Proceedings of the 25th ACM international conference on Multimedia, October 23-27, 2017, Mountain View, California. New York: ACM, 2017: 420- 428.

[6] Sun YF, ZhengL, YangY, et al. Beyond part models: person retrieval with refined part pooling (and a strong convolutional baseline)[M] ∥Ferrari V, Hebert M, Sminchisescu C, et al. Lecture notes in computer science. Cham: Springer, 2018, 11208: 501- 518.

[7] ZhengL, Shen LY, TianL, et al. Scalable person re-identification: a benchmark[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 1116- 1124.

[8] Zheng ZD, ZhengL, YangY. Unlabeled samples generated by GAN improve the person re-identification baseline in vitro[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 3774- 3782.

[9] 朱小波, 车进. 基于特征融合与子空间学习的行人重识别算法[J]. 激光与光电子学进展, 2019, 56(2): 021503.

[11] 吴敏, 查宇飞, 张园强, 等. 基于分类-验证模型的视觉跟踪算法研究[J]. 光学学报, 2018, 38(5): 0515003.

[12] Felzenszwalb F, Girshick B. McAllester D, et al. Object detection with discriminatively trained part-based models[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(9): 1627-1645.

[13] DengJ, DongW, SocherR, et al. ImageNet: a large-scale hierarchical image database[C]∥2009 IEEE Conference on Computer Vision and Pattern Recognition, June 20-25, 2009, Miami, FL, USA. New York: IEEE, 2009: 248- 255.

[14] ZhongZ, ZhengL, Zheng ZD, et al. Camera style adaptation for person re-identification[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 5157- 5166.

[15] Zheng Z D, Zheng L, Yang Y. A discriminatively learned CNN embedding for person reidentification[J]. ACM Transactions on Multimedia Computing, Communications, and Applications, 2018, 14(1): 13.

[16] ZhongZ, ZhengL, Cao DL, et al. Re-ranking person re-identification with k-reciprocal encoding[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 3652- 3661.

[17] Sarfraz MS, SchumannA, EberleA, et al. A pose-sensitive embedding for person re-identification with expanded cross neighborhood re-ranking[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 420- 429.

[18] Sun YF, ZhengL, Deng WJ, et al. SVDNet for pedestrian retrieval[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 3820- 3828.

[19] Chen YB, Zhu XT, Gong SG. Person re-identification by deep learning multi-scale representations[C]∥2017 IEEE International Conference on Computer Vision Workshops (ICCVW), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 2590- 2600.

[20] Chang XB, Hospedales TM, XiangT. Multi-level factorisation net for person re-identification[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 2109- 2118.

[21] LiW, Zhu XT, Gong SG. Harmonious attention network for person re-identification[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 2285- 2294.

Article Outline

徐龙壮, 彭力. 基于多尺度卷积特征融合的行人重识别[J]. 激光与光电子学进展, 2019, 56(14): 141504. Longzhuang Xu, Li Peng. Person Reidentification Based on Multiscale Convolutional Feature Fusion[J]. Laser & Optoelectronics Progress, 2019, 56(14): 141504.