结合卷积受限玻尔兹曼机的CV图像分割模型  下载: 816次

下载: 816次

1 引言

如何利用分割方法从图像中自动提取目标是图像处理中重要的研究方向。传统图像分割方法主要依赖灰度、颜色、边缘和纹理等底层特征,易受目标遮挡、阴影等影响,使得分割效果不佳。而遥感图像与普通光学图像在图像角度、场景特性、图像分辨率方面都不尽相同,其目标分割更为困难。按照分割原理,可将遥感图像的目标提取方法分为5类。1)基于像素的目标提取方法[1-2],如阈值法,此类方法原理简单,分割速度快,但用于高分辨率遥感图像目标提取时,易受目标遮挡等噪声的影响,因此应用较少。2)基于区域的目标提取方法[3-5],如区域生长法、区域分裂合并法和CV(Chan-Vest)模型分割方法等,此类方法对灰度均匀的图像具有较好的分割效果,缺点是对噪声敏感,容易造成错分。3)基于边缘和角点检测的目标提取方法[6-8],如采用Canny算子、Roberts算子和Harris角点检测等,此类方法是寻找遥感图像中灰度值突变的地方来确定边缘和较明显的角点信息,再根据空间关系对图像中提取的边缘线段及角点进行分组,通过适当的搜索方法构建目标的空间结构及轮廓,过程比较复杂。4)基于形状先验的目标提取方法[9-11],即通过不同的方法提取目标全局的形状信息,将此作为先验知识并结合传统的图像分割方法辅助分割。多数分割方法只采用底层特征,而目标全局特征的使用使得此类方法在目标遮挡及阴影等情况下也可以较好地提取目标,缺点是针对复杂的遥感图像,怎样灵活地建模和获取目标形状成为难点,且计算量增加。5)基于深度学习的目标分割方法[12-13],即采用深层的网络模型,将输入的训练数据映射到多个层次,逐层将较低层的特征抽象成更高层特征,自动完成特征的提取与分割。此类方法是目前研究热点,缺点是需要大量的样本、强大的计算能力来训练模型,且对于遮挡、阴影等复杂场景和不同尺度的目标如何提升其分割性能还有待进一步研究。

本文提出了一种结合深度学习形状先验信息的CV图像分割模型,即卷积受限玻尔兹曼机模型,对目标形状建模和生成目标形状,定义形状约束项,将形状约束项加入基于水平集方法的能量函数中,得到基于深度学习形状先验信息的新的能量函数,求解新的能量函数使其最小化,得到图像分割结果。该模型的新颖性主要体现为,采用基于深度学习的形状建模方法不仅可以自动提取训练集的目标形状特征,而且可以灵活地表达及生成形状。在训练数据有限、目标形态各异、目标尺度变化较大的遥感图像Satellite-2000[14]和Vaihigen[15]上进行实验,结果表明,与未加入形状信息的分割结果相比,即使初始分割结果不理想,由于形状信息的加入,模型即使在阴影、遮挡、背景复杂的情况下依然能够得到更为完整的目标。

2 结合卷积受限玻尔兹曼机的CV图像分割模型

2.1 CV模型

CV模型是由Chan和Vest提出的图像分割方法。该模型将图像分割表达为能量函数最小化问题,用I表示待分割的灰度图像,I(x,y)的值表示I中任意像素点(x,y)的灰度值。演化曲线C将I划分为两部分,C1、C2分别表示演化曲线C内部和外部的灰度信息均值。LC的值表示演化曲线C的长度,AC的值表示演化曲线C内部区域的面积,λ1、λ2、μ、v是各项的系数,Ω表示图像平面。得到CV模型的能量泛函为

式中:等号右边前两项使得演化曲线C不断向目标轮廓靠近,合称为保真项;第三项用于约束演化曲线C,确保获得的曲线足够短,称为长度约束项;第四项用于约束演化曲线C,避免曲线震荡,称为面积项。只有当保真项的值为零,即演化曲线在目标边界上时能量函数才能达到最小值,实现对图的分割。

将(1)式中演化曲线C表示为水平集函数ϕ(x,y),令ϕ(x,y)表示图像I中任意点(x,y)与演化曲线C的最小欧氏距离值。ϕ(x,y)在图像内部时,水平集函数ϕ(x,y)>0;ϕ(x,y)恰好在目标边界上时,ϕ(x,y)=0(即初始化水平集);其他情况下水平集函数ϕ(x,y)<0。则(1)式改写为

式中:μ0(x,y)为零水平集函数;Ñϕ(x,y)为演化曲线斜率;H(z)海氏(Heaviside)函数和δ(z)狄拉克(Dirac)函数分别为H(z)=

根据变分原理,使用欧拉-拉格朗日(Euler-Lagrange)方法推导出水平集函数的演化方程

式中∂ϕ/∂t为不同时刻t的演化曲线的水平函数偏微分方程;k为演化曲线的曲率。通过迭代水平集函数的演化方程使得CV模型的能量函数值最小,得到分割结果。

2.2 基于深度学习的形状模型

2.2.1 基于深度学习的形状模型结构

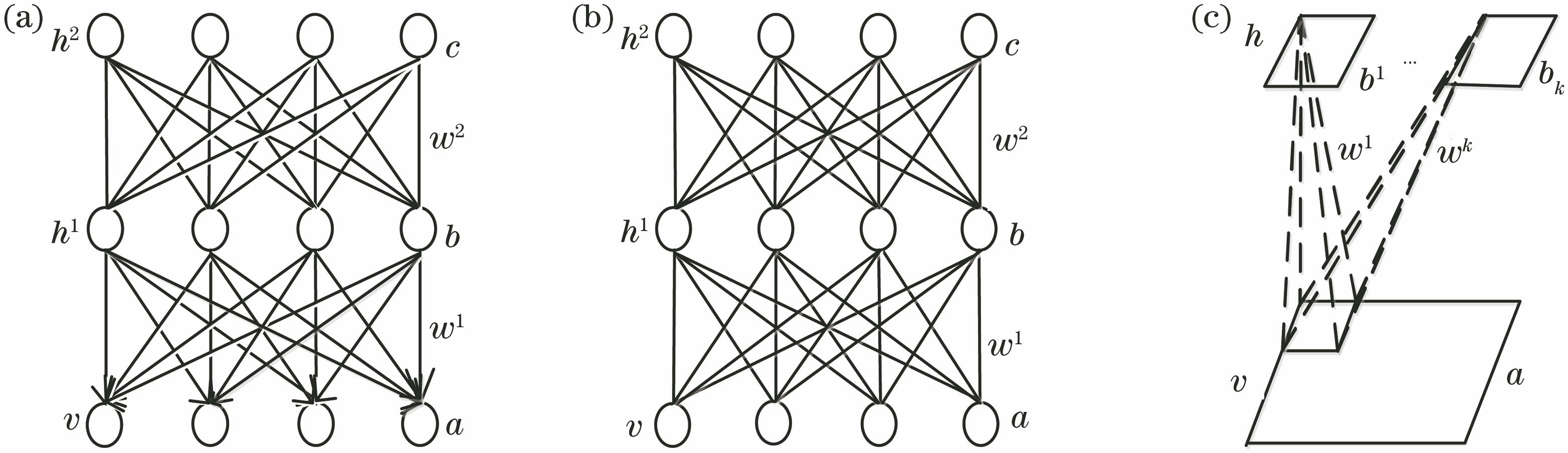

为了在CV分割模型中引入有效的目标形状先验知识,采用深度信念网络(DBN)[16]、深度玻尔兹曼机(DBM)[17]和卷积受限玻尔兹曼机(CRBM)[18]3种深度学习模型对目标形状特征进行建模。3种模型的结构如

3层DBN模型的结构如

如

图 1. 不同模型的结构。(a) DBN结构图;(b) DBM结构图;(c) CRBM结构图

Fig. 1. Structure of different models. (a) Structure of DBN; (b) structure of DBM; (c) structure of CRBM

2.2.2 基于深度学习的形状模型训练

模型结构确定后,利用训练样本训练模型,确定模型的参数。训练模型时以二值图像作为输入,0表示背景,1表示目标。DBN和DBM模型采用贪心逐层训练算法[19],该算法分为2个阶段,预训练阶段和微调阶段。预训练阶段模型通过自下逐上的顺序对模型逐层进行训练;微调阶段使用梯度优化算法对模型的全部参数进行全局调优,最终确定模型参数。

CRBM采用对比散度(CD)算法[20]训练模型,训练模型时将样本作为输入层的初始化状态,确定隐层单元的状态,即由P(h|v)求得h。再由得到的隐层单元状态,重构输入层单元的状态,即由P(v|h)求得v。不断重复,得到确定的隐层和重构输入层的单元状态,最终确定CRBM模型参数值。

2.2.3 基于深度学习的形状模型生成形状

确定模型参数后,采用多步Gibbs采样[21]方法在模型中生成形状。DBN模型的采样过程如

如

图 2. 不同模型采样过程。(a) DBN模型;(b) DBM模型;(c) CRBM模型

Fig. 2. Sampling processes of different models. (a) DBN model; (b) DBM model; (c) CRBM model

2.3 形状约束项

受到水平集图像分割中施加形状先验信息的启发[22],采用深度学习模型CRBM获取形状,并将形状信息表示为符号函数(特殊的水平集函数)[23]引入CV模型中。在图像平面Ω中,用水平集距离函数ϕ表示演化曲线,ϕS表示目标形状的符号距离函数,通过度量ϕ和ϕS的相似性来定义形状约束能量项

图 3. 距离变换示例。(a)生成形状;(b)轮廓;(c)符号距离函数

Fig. 3. Examples of distance transformation. (a) Generated shapes; (b) contour maps; (c) sign distance functions

2.4 CRBM-CV模型

CRBM-CV模型对传统的CV模型能量函数作了以下改进。1)由于面积约束项对图像分割精度影响不显著,为减少计算量,该模型舍弃了面积项。2)通过卷积受限玻尔兹曼机生成形状,以此为先验信息对演化曲线加以约束,并定义形状约束能量项ES。3)结合CV模型的能量项ECV和形状约束能量项ES得到新的能量泛函E,定义为

式中:λ为形状先验项系数。使用欧拉-拉格朗日方法推导出水平集函数的演化方程,即

最后,通过迭代水平函数的演化方程使得CV模型的能量函数值最小,得到分割结果。

2.5 CRBM-CV模型算法步骤

为了更好地分割图像,采用生成式模型CRBM对目标形状建模及生成目标形状,并以此为先验信息结合CV模型对演化曲线加以约束,指导图像分割。采用CRBM-CV模型分割图像的算法步骤如下。

1)给定待分割灰度图像I,建立CV模型所对应的能量函数ECV(ϕ),将其最小化,得到粗分割结果f1。

2)将一批已归一化至32 pixel×32 pixel大小的目标二值标记图像(Ground truth)作为训练集,送入CRBM模型中进行训练。

3)将f1归一化至32 pixel×32 pixel大小,并将其作为CRBM模型的输入,经过采样得到形状S,后将S扩大至待分割图像I的大小。

4)由(5)式计算得到形状约束项ES(ϕ,ϕS),并结合步骤1)得到的ECV(ϕ),得到新的CRBM-CV模型能量函数E。通过迭代水平集函数的演化方程使得模型的能量函数值最小,得到最终的分割结果f。

3 数据集、实验参数配置和评价指标

3.1 数据集

3.1.1 Satellite-2000数据集

Satellite-2000数据集中包含 Airplane、Dense Residential、Harbor、Intersection、Overpass和Parking Lot 6类卫星图像目标,图像大小为256 pixel×256 pixel。选取Airplane类中1000幅图像作为实验对象,数据集中的目标是飞机,其形态各异,飞机朝向不同的方向。手动制作二值标记图像,最终得到RGB图像、二值标记图像各1000幅,其中训练集图像800幅,测试集图像200幅。数据集中的部分图像如

3.1.2 Vaihigen数据集

Vaihigen数据集包含RGB图像、DSM图像和Ground-truth图像3类,图像尺寸大小不一,空间分辨率为9 cm。数据集中的目标是建筑物,建筑物的分布较为复杂且易受树木、汽车、马路等背景的干扰。在该数据集中仅有16幅图像包含二值标记图像,选择其中12幅图像作为模型训练集,其余4幅图像作为模型测试集。该数据集对训练深度学习生成模型来说图像尺寸过大,样本数量过少,因此采用3阶段方法扩充数据集。第1阶段,将所有图像按照不同比例放大、缩小至2048 pixel×2048 pixel、1536 pixel×1536 pixel。第2阶段将第1阶段中所有归一化的图像按顺时针旋转90°、180°和270°。第3阶段将所有图像按照178、256的步长进行裁剪,裁剪后每幅图像尺寸为256 pixel×256 pixel,最终得到RGB图像。二值标记图像共1971幅,其中训练集图像1700幅,测试集图像271幅。数据集中的部分图像如

3.2 实验参数配置

电脑配置为Intel(R)Xeon(R) CPU E5-2690,2.6 GHz,256 GB RAM,实验环境为Win10系统下安装的MATLAB R2016a。CV模型分割实验使用数据集中的灰度图像。设定初始演化曲线通过位于图像中心的矩形来表示,步长Δt=0.1,λ1与λ2取值均为1,迭代次数为500。

参考文献[ 24-25]并结合实际设置模型参数。对于Satellite-2000数据集,DBN模型的参数设置如下:输入层、第1个隐层和第2个隐层单元个数分别为1024、500和500,学习率为0.01,迭代次数为2000。DBM模型的参数设置如下:输入层、第1个隐层和第2个隐层单元个数分别为1024、500和500,学习率为0.01,迭代次数为2000。CRBM模型的参数设置如下:卷积核的大小为3 pixel×3 pixel,卷积核个数为20,学习率为0.01,迭代次数为2000。对于Vaihigen数据集,DBN模型的参数设置如下:输入层、第1个隐层和第2个隐层单元个数分别为1024、1500和500,学习率为0.005,迭代次数为3000。DBM模型的参数设置如下:输入层、第1个隐层和第2个隐层单元个数分别为1024、1500和500,学习率为0.005,迭代次数为3000。CRBM模型的参数设置如下:卷积核的大小为3 pixel×3 pixel,卷积核个数为20,学习率为0.005,迭代次数为3000。

3.3 评价指标

采用全局精度(Global acc)和交并比(IOU) 2个参数定量评价分割结果,其定义如下:

式中:TP为目标正确分类的像素数目;TN为背景正确分类的像素数目;FN为目标分类为背景的像素数目;FP为背景分类为目标的像素数目。

4 实验结果和分析

4.1 基于深度学习的生成形状实验

为了更好地比较DBN、DBM和CRBM 3种模型形状建模的能力,通过度量生成形状图像与原始形状图像之间的欧氏距离差异,定量分析3个模型形状建模的差异。欧氏距离值越小表明建模效果越好,建模得到的形状越接近原始形状,3个模型的训练时间及平均欧氏距离度量值见

Satellite-2000数据集和Vaihigen数据集的训练集和测试集中的4组图像生成形状结果如

表 1. 不同模型的训练时间及生成形状结果的平均欧氏距离度量值

Table 1. Training time of different models and average Euclidean distance measure of shape results

| |||||||||||||||||||||||||||||||||||||||

图 6. 不同模型的生成形状结果图。(a)(e) 二值标记图像;(b)(f) DBN模型生成形状结果;(c)(g) DBM模型生成形状结果;(d)(h) CRBM模型生成形状结果

Fig. 6. Shape results from different models. (a)(e) Ground-truth images; (b)(f) shapes from DBN model; (c)(g) shapes from DBM model; (d)(h) shapes from CRBM model

从

4.2 结合不同形状先验的CV分割模型

4.2.1 Satellite-2000数据集

结合不同形状先验的CV模型的分割结果如

图 7. 不同模型的分割结果。(a)原图像;(b) CV模型分割结果;(c) DBN-CV模型分割结果;(d) DBM-CV模型分割结果;(e) CRBM-CV模型分割结果;(f)二值标记图像

Fig. 7. Segmentation results of different models. (a) RGB images; (b) CV model segmentation results; (c) DBN-CV model segmentation results; (d) DBM-CV model segmentation results; (e) CRBM-CV model segmentation results; (f) ground-truth images

对应于

为了充分验证CRBM-CV模型在数据集Satellite-2000上的分割性能,测试数据集中所有的图像。如

图 8. 不同模型的分割评价结果。(a)全局精度;(b)交并比

Fig. 8. Segmentation evaluation results of different models. (a) Global acc values; (b) IOU values

图 9. 不同模型在Satellite-2000数据集的平均全局精度和平均交并比。(a)平均全局精度;(b)平均交并比

Fig. 9. Average Global acc and average IOU values of different models on the Satellite-2000 dataset. (a) Average Global acc; (b) average IOU

图 10. 不同模型的分割结果。(a)原图像; (b) CV分割结果; (c) DBN-CV分割结果; (d) DBM-CV分割结果; (e) CRBM-CV分割结果; (f)二值标记图

Fig. 10. Segmentation results of different models. (a) RGB images; (b) CV model segmentation results; (c) DBN-CV model segmentation results; (d) DBM-CV model segmentation results; (e) CRBM-CV model segmentation results; (f) ground-truth images

4.2.2 Vaihigen数据集

结合不同形状先验的CV模型的分割结果如

为了充分验证CRBM-CV模型在数据集Vaihigen上的分割性能,测试数据集中所有的图像。如

4.3 模型推广性验证

为了更好地验证CRBM-CV模型对复杂遥感图像的目标分割性能,从网络上采集一些遥感图像,送入模型进行测试,结果如

图 11. 不同模型的分割评价结果。(a)全局精度;(b)交并比

Fig. 11. Segmentation evaluation results of different models. (a) Global acc values; (b) IOU values

图 12. 不同模型在Vaihigen数据集的平均全局精度和平均交并比。(a)平均全局精度;(b)平均交并比

Fig. 12. Average Global acc and average IOU values of different models on the Vaihigen dataset. (a) Average Global acc values ; (b) average IOU values

图 13. 模型对其他图像的分割结果。(a)(d)原始图像;(b)(e) CV模型分割结果;(c)(f) CRBM-CV模型分割结果

Fig. 13. Segmentation results on other images. (a)(d) RGB images; (b)(e) CV model segmentation results; (c)(f) CRBM-CV model segmentation results

5 结论

为了解决传统CV模型分割图像时难以区分具有相似特征的目标和背景,且易受遮挡和阴影等影响的问题,提出了结合深度学习形状先验的CRBM-CV图像分割模型。分割实验结果表明,由于利用了目标的全局形状信息,该模型分割的目标更为完整,错分及漏分较少。即使测试图像与训练集图像在背景、目标大小、位置、数目上均有差别,该模型依然能够得到较好的分割结果,体现了该模型在遥感影像分割方面具有较好的推广价值。

[1] 阙昊懿, 黄辉先, 徐建闽. 基于双阈值SSDA模板匹配的遥感图像道路边缘检测研究[J]. 国土资源遥感, 2014, 26(4): 29-33.

Que H Y, Huang H X, Xu J M. Road edge detection based on dual-threshold SSDA template matching[J]. Remote Sensing for Land & Resources, 2014, 26(4): 29-33.

[2] 徐秋晔, 李玉, 林文杰, 等. 基于信息聚类的遥感图像分割[J]. 中国矿业大学学报, 2017, 46(1): 209-214.

Xu Q Y, Li Y, Lin W J, et al. Remote sensing image segmentation based on information clustering[J]. Journal of China University of Mining & Technology, 2017, 46(1): 209-214.

[3] 李建飞, 文志强, 胡永祥, 等. 基于改进区域生长的遥感影像道路提取[J]. 计算机工程与应用, 2016, 52(2): 209-213, 238.

Li J F, Wen Z Q, Hu Y X, et al. Road extraction from remote sensing images based on improved regional growth[J]. Computer Engineering and Applications, 2016, 52(2): 209-213, 238.

[4] 郎文辉, 沈杨, 昂安, 等. 带有区域分裂自适应细化过程的SAR海冰图像分割[J]. 遥感学报, 2015, 19(5): 864-872.

Lang W H, Shen Y, Ang A, et al. Segmentation of SAR sea ice image based on region splitting and adaptive refinement process[J]. Journal of Remote Sensing, 2015, 19(5): 864-872.

[5] 郭靖, 江洁, 曹世翔. 水平集分层分割遥感图像中的建筑物[J]. 红外与激光工程, 2014, 43(4): 1332-1337.

Guo J, Jiang J, Cao S X. Automatic building segmentation from remote sensing images using multi-layer level set framework[J]. Infrared and Laser Engineering, 2014, 43(4): 1332-1337.

[6] 石桂名, 索继东, 黄超, 等. 基于改进Canny算子的遥感图像边缘检测[J]. 大连交通大学学报, 2015, 36(3): 87-90, 108.

Shi G M, Suo J D, Huang C, et al. Remote sensing image edge-detection based on improved Canny operator[J]. Journal of Dalian Jiaotong University, 2015, 36(3): 87-90, 108.

[7] 谭媛, 黄辉先, 徐建闽, 等. 基于改进Sobel算子的遥感图像道路边缘检测方法[J]. 国土资源遥感, 2016, 28(3): 7-11.

Tan Y, Huang H X, Xu J M, et al. Road edge detection from remote sensing image based on improved Sobel operator[J]. Remote Sensing for Land & Resources, 2016, 28(3): 7-11.

[8] 戴进墩, 刘亚东, 毛先胤, 等. 基于NSCT域FAST角点检测的电气设备红外与可见光图像配准[J]. 电测与仪表, 2019, 56(1): 108-114.

Dai J D, Liu Y D, Mao X Y, et al. Registration based on NSCT-domain FAST corner detection for infrared and visible images of electrical equipment[J]. Electrical Measurement & Instrumentation, 2019, 56(1): 108-114.

[9] 姚红兵, 卞锦文, 丛嘉伟, 等. 基于局部稀疏形状表示的医学图像分割模型[J]. 激光与光电子学进展, 2018, 55(5): 051011.

[10] Wang B, Gao X B, Li J, et al. A level set method with shape priors by using locality preserving projections[J]. Neurocomputing, 2015, 170: 188-200.

[11] AmbergB, VetterT. Optimal landmark detection using shape models and branch and bound[C]∥2011 International Conference on Computer Vision, November 6-13, 2011, Barcelona, Spain. New York: IEEE, 2011: 455- 462.

[12] 谭光鸿, 侯进, 韩雁鹏, 等. 基于卷积神经网络的低参数量实时图像分割算法[J]. 激光与光电子学进展, 2019, 56(9): 091003.

[13] 裴亮, 刘阳, 谭海, 等. 基于改进的全卷积神经网络的资源三号遥感影像云检测[J]. 激光与光电子学进展, 2019, 56(5): 052801.

[14] 周明非, 汪西莉, 王磊, 等. 高分辨卫星图像卷积神经网络分类模型[J]. 中国图象图形学报, 2017, 22(7): 996-1007.

Zhou M F, Wang X L, Wang L, et al. Convolutional neural network models for high spatial resolution satellite imagery classification[J]. Journal of Image and Graphics, 2017, 22(7): 996-1007.

[15] GerkeM. Use of the stair vision library within the ISPRS 2D semantic labeling benchmark (Vaihingen)[R]. Netherlands: University of Twente, 2014.

[16] Hinton G E, Osindero S, Teh Y W. A fast learning algorithm for deep belief nets[J]. Neural Computation, 2006, 18(7): 1527-1554.

[17] SalakhutdinovR, Hinton GE. Deep Boltzmann machines[C]∥Proceedings of the 12th International Conference on Artificial Intelligence and Statistics, April 16-18, 2009, Clearwater Beach, Florida, USA.USA: MIT Press, 2009: 448- 455.

[18] NorouziM, RanjbarM, MoriG. Stacks of convolutional Restricted Boltzmann Machines for shift-invariant feature learning[C]∥2009 IEEE Conference on Computer Vision and Pattern Recognition, June 20-25, 2009, Miami, FL, USA. New York: IEEE, 2009: 2735- 2742.

[19] Salakhutdinov R. Learning deep generative models[J]. Annual Review of Statistics and Its Application, 2015, 2(1): 361-385.

[20] Hinton G E. Training products of experts by minimizing contrastive divergence[J]. Neural Computation, 2002, 14(8): 1771-1800.

[21] Walsh B. Markov chain Monte Carlo and Gibbssampling[J/OL]. ( 2004-01-01)[2019-07-28]. https:∥www.researchgate.net/publication/259088117_Markov_Chain_Monte_Carlo_and_Gibbs_Sampling.

[22] Li C M, Xu C Y, Gui C F, et al. Distance regularized level set evolution and its application to image segmentation[J]. IEEE Transactions on Image Processing, 2010, 19(12): 3243-3254.

[23] Chan T F, Sandberg B Y, Vese L A. Active contours without edges for vector-valued images[J]. Journal of Visual Communication and Image Representation, 2000, 11(2): 130-141.

[24] LiX, ZhaoF, GuoY. Conditional restricted Boltzmann machines for multi-label learning with incomplete labels[C]∥Proceedings of the 18th International Conference on Artificial Intelligence and Statistics (AISTATS)2015, May 9-12, 2015, San Diego, CA, USA.USA: MIT Press, 2015: 635- 643.

[25] 张娟, 汪西莉, 杨建功. 基于深度学习的形状建模方法[J]. 计算机学报, 2018, 41(1): 132-144.

Zhang J, Wang X L, Yang J G. Shape modeling method based on deep learning[J]. Chinese Journal of Computers, 2018, 41(1): 132-144.

Article Outline

李晓慧, 汪西莉. 结合卷积受限玻尔兹曼机的CV图像分割模型[J]. 激光与光电子学进展, 2020, 57(4): 041018. Xiaohui Li, Xili Wang. CV Image Segmentation Model Combining Convolutional Restricted Boltzmann Machine[J]. Laser & Optoelectronics Progress, 2020, 57(4): 041018.