数据驱动的空间目标图像信息感知技术  下载: 858次

下载: 858次

1 引言

随着人类航天技术的快速发展,太空成为了人类开拓的新疆域。随着人类对空间资源越来越多的利用,人造空间目标的数量也在飞速增长。为保证和平有序地利用空间资源、对数目庞大的空间目标实现管控,迫切需要建立快速的全自动人造空间目标信息感知系统。通过利用空间目标信息感知系统对空间目标观测数据的类别、载荷及载荷工作状态等信息进行感知,即可实现对空间目标的识别和管控。地基及空基光学成像设备是获取空间目标数据的重要手段,然而光学成像设备的探测数据与观测角度、目标特征、太阳角度和外界环境干扰等多种因素相关,这使探测结果具有极大的不确定性,给空间目标图像信息的全自动感知带来挑战[1]。

根据不同任务的需求,空间目标图像信息感知可分解为两个层次:空间目标检测和在空间目标类别及载荷状态检测基础上的空间目标信息感知。空间目标检测是指从空间目标图像中检测出其类别、主要载荷和载荷工作状态;空间目标信息感知是在分析检测结果的基础上给出空间目标的当前状态信息。一般来说,空间目标检测是基础,也是实现空间目标信息感知的关键。

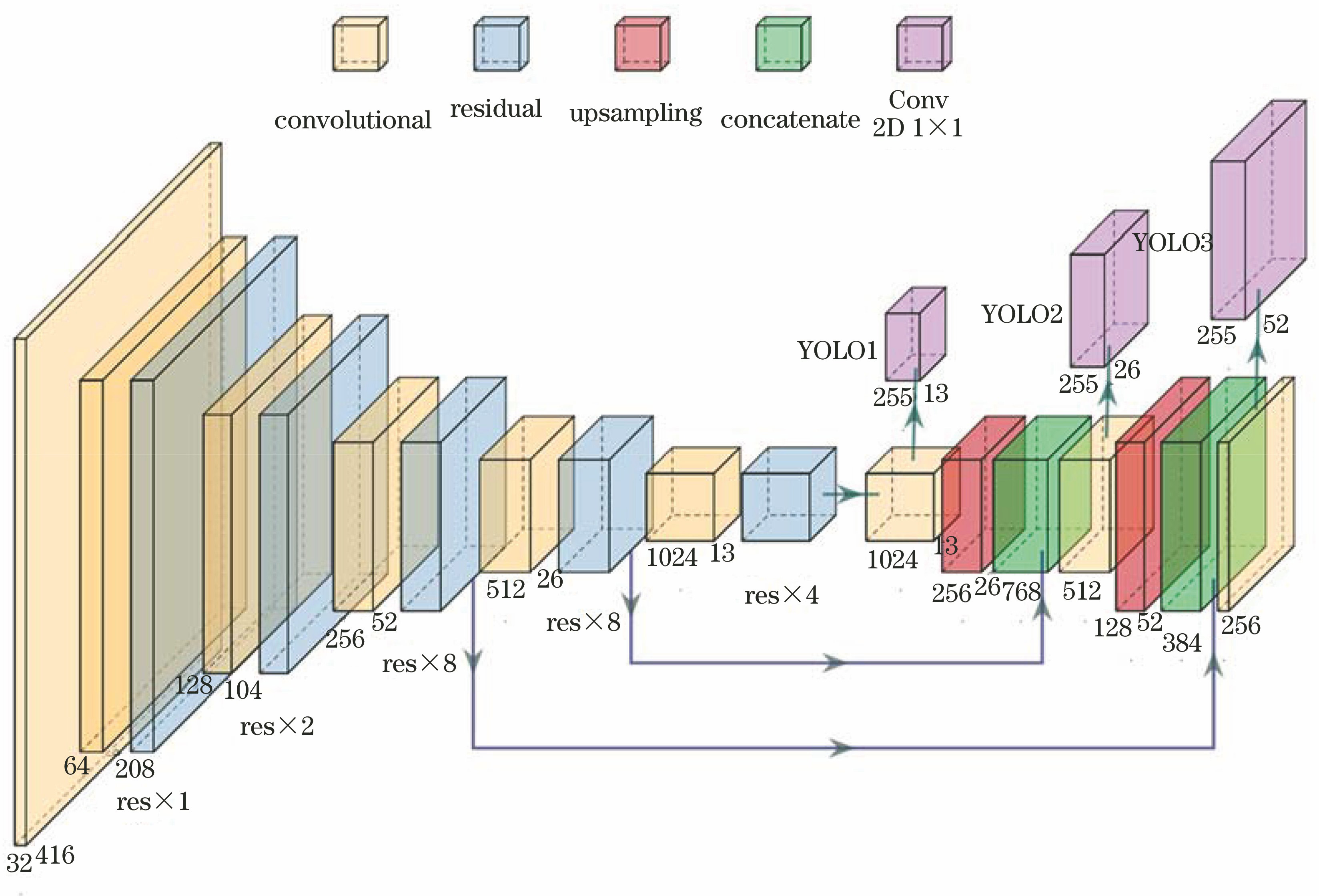

近年来,随着海量数据积累和人工智能技术的发展,深度神经网络[2]在快速提高目标检测方法[3-4]的性能方面得到了越来越多的应用。对于通用目标检测而言,Krizhevsky等[5]首先提出深度卷积神经网络,Girshick等[6]结合深度神经网络和图像目标检测进行了一系列卓有成效的工作[从R-CNN(Region-CNN)到Fast R-CNN[7],再到Faster R-CNN[8]],这些工作提供了目标检测算法的经典结构。但受R-CNN系列算法本身结构的限制,R-CNN系列算法的检测速度难以满足对部分场景进行实时性检测的需求。因此Redmon等[9]提出一种基于回归方法的YOLO(You Only Look Once)目标检测算法,在保证一定准确率的前提下,检测速度得到极大提升。Liu等[10]将YOLO的回归思想和Faster R-CNN的anchor box机制相结合,提出SSD(Single Shot MultiBox Detector)算法,该算法在保持YOLO算法快速特性的同时也保证了Faster R-CNN的边框定位效果。随后Redmon等[11-12]又对YOLO算法不断进行改进,提出了YOLO9000等检测框架,其中YOLOv3具有较高的准确率和检测速率。王柳[13]基于YOLO网络提出了一种空间多目标识别方法,实现了在近距离正视、遮挡等条件下对两种卫星的检测,但该方法仅是在地面环境下对按一定比例缩小的卫星模型进行识别。本文以深度神经网络YOLOv3作为基础,设计了空间目标检测网络。在检测网络的基础上,本文采用模型组合的方法将空间目标类别检测结果和空间目标载荷状态的检测结果进行融合,最终实现了对空间目标图像信息的自动感知。

本文主要贡献如下:

1) 提出了一种基于YOLOv3模型的空间目标检测方法,该方法能够对不同模糊程度及信噪比的空间目标图像实现类别、载荷及载荷状态的快速精准自动检测。

2) 利用模型组合方法,搭建了空间目标图像信息感知专家系统。通过模拟和实测研究了该系统对不同类别的空间目标工作状态的自动识别的性能,验证了本文提出方法的有效性。

2 数据驱动的空间目标信息感知技术

以深度神经网络为代表的数据驱动型[14]目标检测算法为监督学习算法,该算法以海量的人工标注数据作为训练集,经过训练后的深度神经网络将能够从特性相似的数据中检测出目标。但是,光电系统在对空间目标进行成像时,受观测设备和目标相对运动、大气湍流扰动及背景噪声等影响,图像往往比较模糊且信噪比较低,很难用人眼对这些图像的有效载荷及状态进行识别和判断,更无法实现对其进行标注后作为训练集再对神经网络进行训练的过程。因此,直接采用现有的目标检测框架无法对空间目标图像实现信息感知。

由于空间目标都是人造物体,其载荷的结构和形状是有限且已知的。因此,可以根据相关设计资料及少数高分辨率图像,并结合观测条件信息,建立空间目标的模拟观测图像及其对应的状态指示标签。因为这些模拟图像能够反映出实际观测图像的数据特性,所以可以利用这些模拟图像训练神经网络,进而使神经网络具有根据实际图像进行目标检测的能力。基于此,本文提出了一种数据驱动的空间目标图像信息感知方法。该方法首先通过三维建模或高分辨率观测得到不同空间目标的高分辨率图像;然后根据观测设备性能及外部环境条件,通过蒙特卡罗模拟产生不同模糊程度及噪声水平的观测图像,并根据模糊程度和噪声水平划分训练集;最后,根据实际观测数据的特性选取训练集,以对用于空间目标检测的神经网络进行混合训练,训练后的神经网络能够对不同类别的空间目标、载荷及载荷状态进行检测。在此基础上,分别利用空间目标类别标注数据和空间目标载荷状态标注数据独立地训练了两个空间目标检测网络,利用模型组合的方法将上述两个网络检测结果进行融合,实现了空间目标的信息感知。模拟及实测数据表明本文提出的方法可以对不同类别的空间目标图像信息进行自动感知。

2.1 基于深度神经网络的空间目标检测方法原理

本文以YOLOv3为基础设计了空间目标检测网络。YOLOv3是在Redmon等提出的YOLO基础上发展的一种端到端的目标检测网络,它采用多尺度神经网络结构,与YOLOv1、YOLOv2相比,其对小目标的检测能力大大提升,是一种更通用且更快速的检测算法。YOLOv3利用网格对图像进行划分,采用Darknet-53特征提取网络对划分后的图像进行特征提取,并将提取的特征用于分类和位置回归。本文首先把空间目标图像尺寸转换为416×416的像元,并将其输入网络。检测网络将图像划分为S×S(S为划分网格的数量)个网络单元格,每一个网络单元格会对中心落入其中的目标进行预测,并输出3个预测边界框,输出包含的信息分别对应中心点坐标、预测框宽高、置信度值以及类别属性。通过逻辑回归函数对每一个边界框内的目标进行得分预测,并将得分较低的边界框删除。利用非极大值抑制(NMS)算法[15]对被保留下来的候选框的相邻候选框进行筛选,最终输出空间目标检测结果。下面将分别介绍本文所提方法的网络结构和训练策略。

2.2 网络结构

2.2.1 空间目标检测网络

本文提出的空间目标检测网络结构如

2.2.2 空间目标信息感知专家系统

空间目标信息感知是在空间目标载荷检测的基础上智能地反馈空间目标的类别和工作状态。空间目标信息感知专家系统(简称为专家系统)可以直接服务于自动化的空间目标监测和管控,具有重要的实用价值。本文在空间目标载荷检测网络的基础上,搭建了专家系统。本文采用模型组合的方式搭建了专家系统,即针对空间目标的不同特性分别训练两个空间目标的检测网络,并将这两个网络的输出进行组合,实现了根据空间目标图片直接判断其综合状态的功能。专家系统工作流程图如

专家系统由3个部分组成:目标模块、工作模块和判断模块。目标模块和工作模块为利用标注不同特征的数据训练的两个空间目标检测网络。目标模块负责检测空间目标的类别,工作模块负责检测空间目标的载荷状态,最后由判断模块对目标的工作状态进行判断。本文中的空间目标的工作状态主要包括两大类。空间目标的状态与其结构的对应关系如

表 1. 空间目标的工作状态分类

Table 1. Classification of working states of space targets

|

2.3 损失函数

损失函数是决定目标检测网络最终性能的关键。通过损失函数计算目标检测网络的预测结果和数据标签的差异,并对网络权重进行更新,以保证网络检测结果满足任务要求。本文提出的网络损失函数主要由边界框中心点(x,y)的预测误差、边界框的宽(w)和高(h)的预测误差、置信度误差和分类预测误差4部分组成,具体的计算公式为

式中:B为每个网格预测的边界框的数量;

2.4 空间目标数据集构建

2.4.1 数据集构建

为保证目标检测网络的检测能力,需要大量的标注数据作为训练集。然而,受观测条件及外界环境的限制,获取及标注此类图像非常困难。但是如引言所述,由于空间目标属于人造天体,因此其载荷结构及特征为观测者所知。根据观测条件,通过计算机模拟可以产生大量包含标注信息的观测图像。以这些图像为基础,结合少量真实数据,通过迁移学习[18]就能实现对真实空间目标的检测。

本文中通过模拟生成空间目标图像的步骤如下:

1) 根据常见空间目标构型,利用三维建模软件对18种不同类型的空间目标进行建模[19-21]。这些空间目标虽然形状不同,但都是由下述载荷组成的,包括:天线、镜头(侦查相机)、太阳能电池板。为真实反映空间目标的动态特征,可根据真实物理结构对这些模型进行转动、开启及移动。本文中将所有这些空间目标放置于近地轨道(200 km)。

2) 对于每种空间目标,根据其不同的姿态及其与太阳和望远镜之间不同的相对位置获取模拟观测场景图像(每种空间目标包含300幅图像)。经过三维建模软件的渲染后,获取高分辨率空间目标图像共5400幅,其中部分图像如

图 3. 部分模拟数据集(包括18种卫星,每种卫星有5种姿态)

Fig. 3. Part of simulated dataset, including 18 satellites, each of which has 5 attitudes

3) 本文使用高保真大气湍流相位屏模型[22-23],根据

表 2. 蒙特卡罗模拟参数

Table 2. Parameters for Monte Carlo simulation

|

另外,本文获取的少量真实数据为微博数据(已获得原作者授权使用)及本文作者的望远镜实测数据,均为国际空间站过境ISS(international space station)图片,如

图 4. 部分真实数据集。(a)清晰;(b)模糊水平较低;(c)模糊水平较高

Fig. 4. Part of real dataset. (a) Clear; (b) blur of lower degree; (c) blur of higher degree

2.4.2 空间目标载荷数据集标注

首先,对包含上述18种空间目标的5400张模拟的高分辨率空间目标图像载荷进行了人工标注,主要标注三种结构:镜头、天线、电池板,其标签分别为lens, antenna和solar panel,并将该数据集记为T1。然后,将模拟的高分辨率空间目标清晰图像和短曝光PSF进行卷积并添加噪声,经过处理后,图像的信噪比RSNR=9 dB。本文中模拟了两种模糊程度(用D/r0表示)的大气湍流,分别为D/r0=4/0.3=13及D/r0=4/0.1=40,按照模糊程度从小到大,将两种数据集分别记为T2、T3。由于图像模糊及加噪声并没有改变图像内空间目标及载荷的位置和类别信息,因此对T2及T3数据集中的图像均采用T1数据集内的标签。将真实数据ISS图片进行同样的标注,并将模拟数据集和实际数据集一起构成空间目标载荷数据集。

2.4.3 空间目标类别状态数据集标注

空间目标类别状态数据集用于空间目标状态检测。该数据集基于空间目标载荷数据集创建,从18种空间目标数据集中挑选4种空间目标、共1200张图片,如

将真实数据ISS图片进行同样的标注,使其与模拟数据一起构成空间目标类别状态数据集。

图 5. 空间目标类别状态数据集。(a) reconnaissance-1;(b) reconnaissance-2;(c) communication satellite;(d) KH-11

Fig. 5. Class and state datasets of space targets. (a) reconnaissance-1; (b) reconnaissance-2; (c) communication satellite; (d) KH-11

2.5 网络训练

本文中包含用于载荷检测和类别状态检测的两个空间目标检测网络。对于每个网络,其训练数据包括实际观测数据和模拟数据两部分。

空间目标检测网络对3种不同空间目标载荷(镜头、天线、电池板)进行分类检测,对应参数num_class设置为3。超参数设置为:最大训练轮数(max_batches)为50050,初始学习率(learning_rate)为0.001,学习率衰减设置为0.9,批量大小(batchsize)为8。

空间目标检测网络对5种不同类别的空间目标进行分类检测,对应参数num_class设置为5;状态检测网络对6种不同的载荷状态进行分类检测,对应参数num_class设置为6,其超参数设置与载荷检测网络的一致。

硬件配置均为8G显存的GTX 1080 GPU,CUDA版本为10.0。训练集具体划分方法见

2.6 评价指标

本文选取的评价指标为平均精度均值(mAP),其定义为

式中:P为准确率;R为召回率;TP为真正例;FP为假正例;FN为假负例;AP为某一类的平均精度;TP为真正例(正确分类的正样本)数量;FP为假正例(错误分类的正样本)数量;FN为假负例(错误分类的负样本)数量。

3 实验结果与分析

根据空间目标信息感知技术人员经验,很难从高度退化或低信噪比的空间目标图像中获取信息。本文根据训练集感知由易到难的程度将图片划分为T1,T2,T3三个数据集,其中T1为清晰数据集,T2(D/r0=13)为模糊程度较小的数据集,T3(D/r0=40)为模糊程度较大的数据集。

3.1 空间目标检测网络用于空间目标载荷检测

使用创建的空间目标载荷数据集训练空间目标检测网络。该数据集包括海量模拟数据和少量真实数据:训练集共包含13088张图片,其中模拟图片4311×3=12933张,真实图片155张;测试集共包含1471张图片,其中模拟图片479×3=1437张,真实图片34张。输入图片大小为128×128。

3.1.1 模拟图像中空间目标载荷检测结果

图 7. 对模拟图像中空间目标载荷的检测结果。(a)(e)(i)清晰图片(T1);(b)(f)(j)模糊图片(T2),噪声为9 dB;(c)(g)(k)模糊图片(T3),噪声为9 dB;(d)(h)(l)模糊图片(T3),噪声为7 dB

Fig. 7. Detection results of space target payloads in simulated images. (a)(e)(i) Clear images (T1); (b)(f)(j) blur images (T2) with noise of 9 dB; (c)(g)(k) blur images (T3) with noise of 9 dB; (d)(h)(l) blur images (T3) with noise of 7 dB

由

3.1.2 真实图像中空间目标载荷检测结果

图 8. 真实数据(ISS)载荷识别结果。(a) 第1帧;(b)第20帧;(c)第40帧

Fig. 8. Payload identification results of real data (ISS). (a) 1st frame; (b) 20th frame; (c) 40th frame

3.1.3 对网站获取的空间目标图片的载荷检测结果

除了对模拟的空间目标数据和真实数据进行识别之外,本文还对网站上任意获取的空间目标图片进行识别,识别结果如

模型在测试集上的结果如

图 9. 对网站图片中空间目标载荷的识别结果。(a)(b)(c) ISS;(d)哈勃望远镜;(e)美国哨兵;(f)未知空间目标

Fig. 9. Payload identification results of space targets from website images. (a)(b)(c) ISS; (d) Hubble telescope; (e) Sentinel; (f) unknown space target

表 3. 空间目标载荷识别测试结果

Table 3. Test results of space target payload identification

|

3.1.4 对不同模糊条件下的空间目标图像的载荷检测结果

考虑到不同模糊条件对图像可能产生不同的影响,本文对高斯模糊下受高斯分布噪声影响的空间目标图像进行了载荷识别,参数如

表 4. 高斯模糊、噪声参数设置

Table 4. Parameters for Gaussian blur and noise

| |||||||||||||||||||

表 5. 空间目标的载荷识别测试结果(高斯模糊)

Table 5. Test results of space target payload identification (Gaussian blur)

|

图 10. 高斯模糊条件下空间目标载荷识别结果。(a)(e)原始高分辨率清晰图片;(b)(f)清晰图片;(c)(g)高斯模糊图片(T2');(d)(h)高斯模糊图片(T3')

Fig. 10. Payload identification results of space target for Gaussian blur. (a)(e) Original high-resolution clear images; (b)(f) clear images; (c)(g) Gaussian blur images from T2'; (d)(h) Gaussian blur images from T3'

3.2 空间目标信息感知专家系统用于空间目标状态感知

专家系统包含两个空间目标检测网络。这两个网络分别用于检测空间目标类别和空间目标载荷状态,之后专家系统根据两个网络的输出结果对空间目标状态进行感知。对于这两个空间目标检测网络,采用了包含模拟图像和少量真实图片的数据集对其进行了训练和检测:训练集共包含2610张图片,其中模拟图片773×3=2319张,真实图片291张;测试集共包含368张图片,其中模拟图片86×3=258张,真实图片110张。输入图片大小为128×128。该数据集分为两类:1)空间目标类别数据集(Object Dataset),包含reconnaissance-1、reconnaissance-2、communication satellite、KH-11模拟图像及ISS真实图像共5种类型的卫星及相应的标签数据;2)空间目标状态数据集(Working Dataset),包含上述卫星图像及标注为lens open、lens close、antenna open、antenna close、solar panel open、solar panel close 6个状态的标签数据。采用了2.5节所述的训练策略对上述两个网络进行了训练,训练后的专家系统能够直接对观测图像进行信息感知,其结果如下所述。

3.2.1 空间目标模拟图像状态感知结果

使用专家系统对测试集的空间目标模拟图片进行测试,结果如

图 11. 模拟空间目标状态识别结果。(a)清晰图片(T1);(b)模糊图片(T2);(c)模糊图片(T3)

Fig. 11. State identification results of simulated space targets. (a) Clear image from T1; (b) blur image from T2; (c) blur image from T3

从

3.2.2 空间目标真实图像状态感知结果

使用训练好的专家系统对测试集的国际空间站(ISS)真实图片进行检测。检测结果如

模型在测试集上的结果如

表 6. 空间目标状态识别测试结果

Table 6. Test results of status identification for space object

|

4 结论

随着人造空间目标数量的不断增多以及空间环境的日益复杂,空间目标识别方法遇到了越来越多新的挑战,传统依赖于人眼的识别方式在性能、准确率和速度等方面存在一定的不足。针对这些问题,提出了利用海量空间目标数据并基于数据驱动的方法构建空间目标智能识别方法,实现空间目标自动感知,从而有效解决对具有复杂物理特性的空间目标的身份属性识别问题。基于YOLOv3模型分别设计了载荷检测网络和类别状态检测网络,这两个网络在空间目标载荷检测和空间目标状态感知两个任务中均取得了较好的结果。

在空间目标载荷检测任务中,对多种空间目标(哨兵、锁眼卫星等)载荷(镜头、天线、电池板)在不同模糊程度、不同噪声水平等条件下进行测试,识别准确率均达到了80%以上。在空间目标状态感知任务中,所提方法根据多种空间目标的类别和载荷状态实现了对空间目标的状态感知,其类别识别准确率达到90%,受观测数据空间分辨率较低的影响,所提算法对载荷状态的识别准确率较低。同时,所提方法对真实拍摄的卫星图片如国际空间站图片(ISS)进行训练、测试,准确率可达到80%以上。经实验验证,该方法具有较高的识别精度和较快的推理速度,能够为空间目标自动感知系统的实现提供有效解决方案。针对目前方法对空间目标载荷状态的识别准确率较低的问题,在未来的研究中,将通过进一步优化数据输入方式及神经网络结构来提升载荷状态识别的检测精度与检测效率,并且将通过探索基于人工智能芯片的网络模型的高性能低延迟部署,实现空间目标信息感知系统的快速推理。

[1] 张己化, 姚东升, 谈斌. 地基光电系统空间目标探测影响因素分析[J]. 光学学报, 2008, 28(6): 1178-1182.

[2] 左超, 冯世杰, 张翔宇, 等. 深度学习下的计算成像: 现状、挑战与未来[J]. 光学学报, 2020, 40(1): 0111003.

[3] 鞠默然, 罗江宁, 王仲博, 等. 融合注意力机制的多尺度目标检测算法[J]. 光学学报, 2020, 40(13): 1315002.

[4] 孙迎春, 潘树国, 赵涛, 等. 基于优化YOLOv3算法的交通灯检测[J]. 光学学报, 2020, 40(12): 1215001.

[5] KrizhevskyA, SutskeverI, Hinton GE. ImageNet classification with deep convolution neural networks[C]∥Proceedings of the 25th International Conference on Neural Information Processing Systems(NIPS), December 3-6, 2012. Lake Tahoe, Nevada, United States. New York: Curran Associates, 2012, 1: 1097- 1105.

[6] GirshickR, DonahueJ, DarrellT, et al.Rich feature hierarchies for accurate object detection and semantic segmentation[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014. Columbus, OH, USA.New York: IEEE Press, 2014: 580- 587.

[7] GirshickR. Fast R-CNN[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015. Santiago, Chile.New York: IEEE Press, 2015: 1440- 1448.

[8] Ren S Q, He K M, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[9] RedmonJ, DivvalaS, GirshickR, et al.You only look once: unified, real-time object detection[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR), June 27-30, 2016. Las Vegas, NV, USA. New York: IEEE Press, 2016: 779- 788.

[10] LiuW, AnguelovD, ErhanD, et al. SSD: single shot MultiBox detector[M] ∥Leibe B, Matas J, Sebe N, et al. Computer vision-ECCV 2016. Lecture notes in computer science. Cham: Springer, 2016, 9905: 21- 37.

[11] RedmonJ, FarhadiA. YOLO9000: better, faster, stronger[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017. Honolulu, HI, USA. New York: IEEE Press, 2017: 6517- 6525.

[12] RedmonJ, Farhadi A. YOLOv3: an incremental improvement[EB/OL]. ( 2018-04-08)[2019-12-05]. https:∥arxiv.org/abs/1804. 02767.

[13] 王柳. 基于深度学习的空间多目标识别方法研究[J]. 无人系统技术, 2019( 3): 49- 55.

WangL. Research on spatial multi-objective recognition based on deep learning[J]. Unmanned Systems Technology, 2019( 3): 49- 55.

[14] 王文竹, 李智, 来嘉哲, 等. 基于数据驱动的空间目标智能识别[J]. 指挥与控制学报, 2019, 5(1): 25-30.

[15] NeubeckA, Van GoolL. Efficient non-maximum suppression[C]∥18th International Conference on Pattern Recognition (ICPR'06), August 20-24, 2006. Hong Kong, China.New York: IEEE Press, 2006: 850- 855.

[16] He KM, Zhang XY, Ren SQ, et al.Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016. Las Vegas, NV, USA.New York: IEEE Press, 2016: 770- 778.

[17] Lin TY, DollárP, GirshickR, et al.Feature pyramid networks for object detection[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017. Honolulu, HI, USA.New York: IEEE Press, 2017: 936- 944.

[18] Pan S J, Yang Q. A survey on transfer learning[J]. IEEE Transactions on Knowledge and Data Engineering, 2010, 22(10): 1345-1359.

[19] 孙成明, 袁艳, 吕群波. 天基空间目标光学散射特性建模与验证[J]. 光学学报, 2019, 39(11): 1129001.

[20] 汪夏, 张雅声, 徐灿, 等. 空间目标褶皱材质BRDF建模方法[J]. 光学学报, 2019, 39(10): 1024001.

[21] 刘程浩, 李智, 徐灿, 等. 基于深度神经网络的空间目标常用材质BRDF模型[J]. 光学学报, 2017, 37(11): 1129001.

[23] Jia P, Cai D M, Wang D, et al. Real-time generation of atmospheric turbulence phase screen with non-uniform fast Fourier transform[J]. Monthly Notices of the Royal Astronomical Society, 2015, 450(1): 38-44.

Article Outline

杨小姗, 潘雪峰, 苏少杰, 贾鹏. 数据驱动的空间目标图像信息感知技术[J]. 光学学报, 2021, 41(3): 0315002. Xiaoshan Yang, Xuefeng Pan, Shaojie Su, Peng Jia. Data-Driven Awareness Technology for Space Target Image Information[J]. Acta Optica Sinica, 2021, 41(3): 0315002.