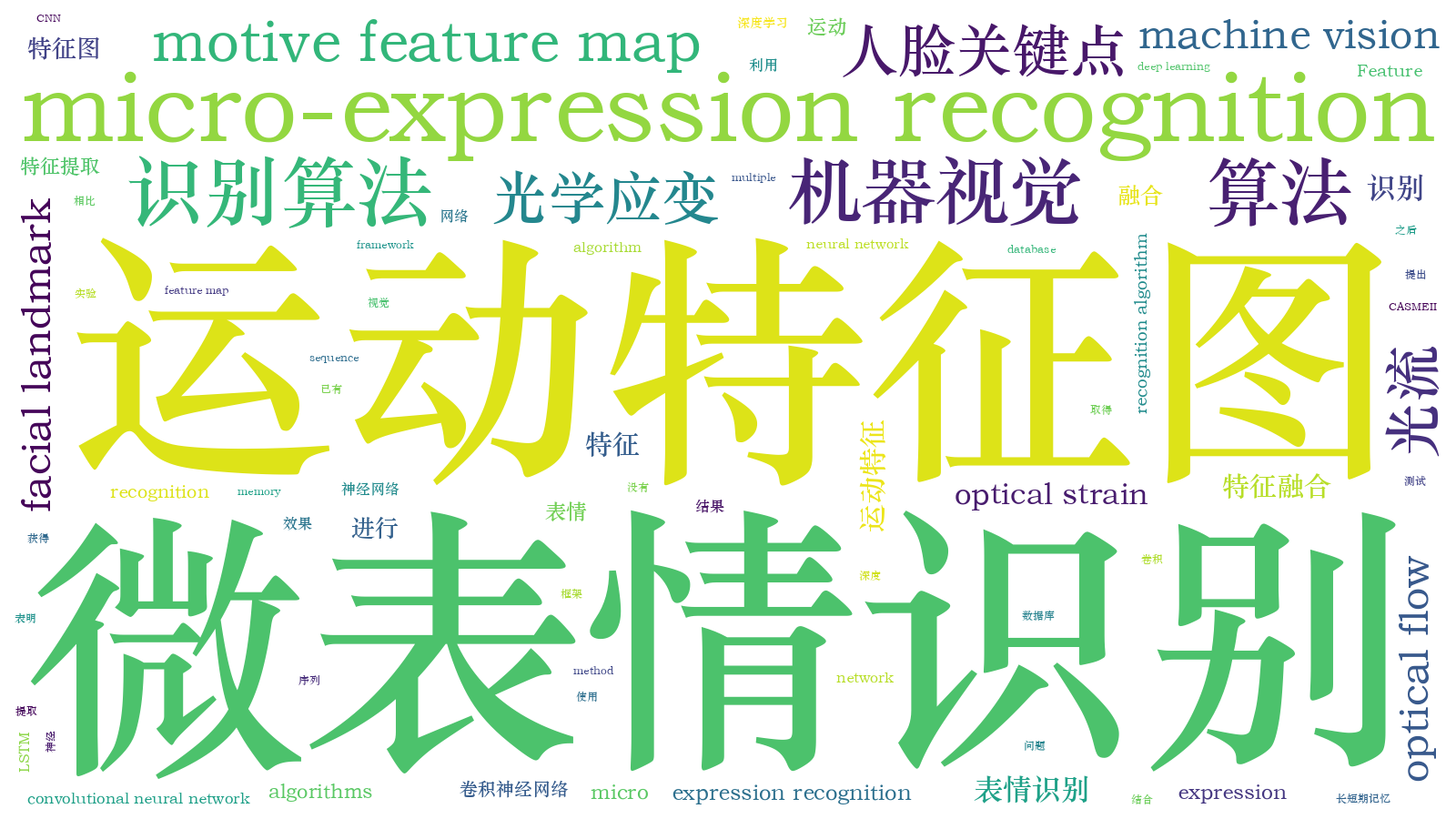

基于多运动特征融合的微表情识别算法  下载: 1221次

下载: 1221次

1 引言

不同于受人为控制的宏表情[1](即传统意义上的表情),微表情是一种无意识的、不受大脑控制的非语言面部信息,反映了人们最真实的心理感受和心理状态[2-3]。微表情可以被用来判断人们内心的真实想法,基于这一特点,微表情识别在智能医疗、公共安全、司法刑侦及心理教育等领域有广泛的应用价值。近年来,行人重识别和表情识别任务[4-5]都取得了很好的效果,但是微表情动作的幅度微弱、持续时间短,对其进行识别仍然是一个具有挑战性的问题。

微表情识别算法大致可以分为两类,即基于传统特征的微表情识别算法和基于深度学习的微表情识别算法。Pfister等[6]首次成功实现自发面部微表情的识别,使用具有三个正交平面的局部二值模式(LBP-TOP)来处理动态特征,并通过训练支持向量机(SVM)、多核学习(MKL)及随机森林(RF)方法来输出识别结果。Wang等[7]提出了一种具有六个交点的局部二值模式(LBP-SIP)的时空描述子,减少了LBP-TOP中特征的冗余。Liong等[8-9]提出一种光学应变加权特征提取方法和光学应变幅值特征提取方法,用光学应变表征运动信息,从而计算出面部微小的肌肉运动,并利用时空信息对微表情进行识别。Liu等[10]提出了一种简单有效的主方向平均光流(MDMO)特征进行微表情识别。Happy等[11]提出了一种全新的模糊光流方向直方图(FHOFO)特征,用来识别微表情。

与利用先验知识设计的传统特征相比,基于深度学习的特征是一种利用神经网络自主学习的特征,可以得到高层的语义信息,从而更能表征微表情特征。Patel等[12]首次探索深度学习在微表情识别任务上的应用,使用卷积神经网络(CNN)提取特征,并利用遗传算法对特征进行降维。Kim等[13]提出一种通过学习具有表达式状态约束的时空特征表示来识别微表情的方法,该方法使用CNN+长短期记忆(LSTM)网络的网络架构,CNN用于编码不同表情状态下的面部表情的空间特征,LSTM对微表情空间特征的时间状态变化信息进行学习。Mayya等[14]使用时间插值(TIM)对视频序列进行插值,保证每段表情序列帧数相同,然后用深度卷积神经网络提取面部特征。Khor等[15]提出一种加强的长期循环卷积网络(ELRCN),该网络对微表情序列及变换成二维光流图和光学应变图的序列进行多条CNN编码,之后再利用LSTM实现识别。Zhou等[16]提取了微表情序列开始帧和表情动作最大帧,即峰值帧之间垂直和水平方向光流图,并将其输入到双支路的Inception模块网络中。Khor等[17]设计了双路浅层的CNN,利用相同的数据预处理方式[16]将光流特征图输入到神经网络中。尽管光流特征图能够较好地突出全局一阶运动信息,但是忽略了表情主要体现在五官区域这一关键先验,而且使用单一光流特征图时无法取得稳健、全面的特征,识别效果有限。

针对上述问题,从原始微表情序列中提取三种运动特征,分析比较了不同特征图的性能,并在此基础上,提出多运动特征融合的算法,用来捕获原始序列中的微弱运动。采用CNN+LSTM框架,通过多路CNN分别对不同特征图进行特征提取,最后利用LSTM提取时序特征并进行识别。在CASMEII基准数据库[18]上进行实验,结果表明,与现有的识别算法相比,所提算法取得了比较有竞争力的结果。

2 基本原理

2.1 网络整体框架

多路CNN和LSTM结合的网络架构如

则空域阶段最后生成的特征可表示为

式中:[·]表示输出特征的串接。时域网络LSTM需要处理的特征为

式中:GLSTM(·)表示LSTM网络和全连接层的处理输出。

2.2 运动特征图

LMF图是基于人脸关键点变化生成的运动特征图。人脸活动外观模型(AAM)[20]是检测关键点的基准。文献[ 21-23]都使用了基于人脸关键点对表情进行分类的方法,视频序列中关键点位置的改变是掌握面部表情改变的重要线索之一。使用关键点的优点在于不受输入视频中的人脸形状、性别、年龄及亮度等人物或者背景特征的影响,使关注点放在面部运动上。LMF的计算公式为

式中:p(d,k)表示第k帧里第d个人脸关键点,d=1,2,…,68,k=2,3,…,10;p(d',k)表示第k帧里全部人脸关键点,d'=1,2,…,68。这里对人脸中68个关键点进行检测,因此ILMF,k的尺寸为68×68。

图 2. LMF检测过程示意。(a)人脸中68个关键点的示例;(b) LMF可视化结果

Fig. 2. Diagram of LMF detection process. (a) Example of 68 monitoring points in face; (b) LMF visualization

对光流特征图的提取是基于TV-L1[24]的近似方法,其有两个重要的优点,即更好的噪声鲁棒性和对运动流不连续的保持性。光流编码是以矢量符号表征图像运动或流动的方向和强度。光流的水平和垂直分量大小定义为

式中:dx和dy表示待估计的像素分别沿x和y维度的运动变化;dt表示时间的变化。光流的水平和垂直分量流程大小构成的光流强度大小用m表示,即

对h、ν及m进行通道维度上的拼接,形成三通道的光流特征图。

光学应变[25]是光流的导数,其特点在于能够正确表征运动连续帧之间可变性物体的微量运动。有限应变张量s的定义为

式中:主对角元素s11,s22表示法线应变分量;次对角元素s12,s21表示切线应变分量。法线应变分量度量光流沿x和y维度的变化,而切线应变分量度量沿两个轴的形变引起的角度变化。则可以使用法线和切线应变分量的平方和来计算每个像素的光学应变幅度:

则计算的光学应变幅度可构成单通道的光学应变特征图。

图 3. 光流和光学应变示意图。(a)微表情开始帧;(b)微表情峰值帧;(c)光流可视化图;(d)光学应变可视化图

Fig. 3. Diagram of optical flow and optical strain. (a) Start frame of micro-expression; (b) peak frame of micro-expression;(c) optical flow visualization image; (d) optical strain visualization image

3 实验

3.1 实验设置

网络框架是基于Keras工具箱设计的,设备为CPU Intel Xeon E5-2620和GPU GeForce GTX 1080Ti。输入数据的尺寸统一为224×224,通道数为3,LMF图和光学应变图采取通道复制的方式。空域阶段,支路模型选用人脸识别领域中经典的网络架构VGG_FACE,该网络已经有预训练模型,在一定程度上可以提高所提算法的训练效率。在时域阶段使用单层LSTM网络,输出维度为256,全连接层输出维度为128。将基于多分类的交叉熵损失作为目标函数,用Adam优化器对网络进行训练,学习率和衰减参数分别设为10-4和10-6。空域阶段训练15个epoch,时域阶段训练40个epoch,并利用早停机制保存最优模型,防止过拟合。

3.2 数据库和度量准则

在标准微表情数据库CASMEII上进行实验,它是一个综合的自发微表情数据库。该数据库共包含255个微表情片段序列,有26位亚洲参与者,帧率为200 frame/s,序列平均长度是0.34 s,相当于68 frame。这些视频分为7个类别,有其他(99个视频),厌恶(63个视频),开心(32个视频),压抑(27个视频),惊讶(25个视频),悲伤(7个视频)及恐惧(2个视频)。这里为了与主流相关工作实验的设置保持一致,选取其中数量较多的5类,分别是开心、厌恶、压抑、惊讶及其他,共246个微表情序列。

训练测试使用LOSO(leave-one-subject-out)协议,在学习过程中此协议可以保持对受试者的多样性。使用该协议进行训练的次数是26,即一个受试者的数据为测试集,剩余测试者的数据为训练集。使用识别准确率(Accuracy)、未加权平均召回(UAR)、F1分数(F1-score)指标来度量所提算法的性能,最终结果是26组实验的平均值。

3.3 消融实验

为了验证所提算法的有效性,设计了两组消融实验。第一组消融实验,验证提取的运动特征图比原始微表情序列具有更好的空间信息表达性能。选取CNN支路作为对比实验的框架。将输入序列的每一帧当作一个微表情样本,序列内图像标签统一,分别在单一CNN支路进行训练和测试,实验结果如

表 1. 在CNN模块上不同数据的性能对比

Table 1. Performance comparison of different data in CNN module

|

第二组消融实验,验证相比使用单一特征图,使用多特征融合图具有更好的识别效果。对单一特征图的训练测试结果和多特征融合图的训练测试结果进行比较,使用CNN+LSTM框架对序列进行识别,结果如

表 2. 单一特征图和多特征融合图结果的对比

Table 2. Result comparison of single feature map and multiple feature fusion map

|

3.4 与其他算法的对比

对所提算法和一些主流的微表情识别算法进行对比,其他算法包括LBP-TOP[6]、LBP-SIP[7]、ELRCN-TE[15]、FDM[26]、MRW[27]、STCLQP[28]、MDMO[10]、Bi-WOOF[29]。不同算法的识别准确率如

表 3. 不同算法的各种指标对比

Table 3. Comparison of indicators of different algorithms

|

4 结论

提出了一种基于多特征图融合的微表情识别算法。该算法将原始微表情序列变换为特征图,再将其输入到CNN+LSTM框架中进行识别。结果表明,基于特征图的方法更能够捕捉到微表情的微弱面部运动,能有效去除与微表情无关的面部特征,提升微表情识别性能。在CASMEII数据库上对多种算法进行测试,与其他识别算法相比,所提算法取得了良好的性能。利用运动特征图突出微表情运动信息是一种较好识别微表情的思路,但是识别准确率仍较低。针对微表情本身动作幅度小的特点及宏表情和微表情之间的相关性,使用动作放大算法突出微小动作,借鉴迁移学习的思路利用宏表情辅助微表情识别,都是可以进一步研究的方向和思路。

[1] 王琳琳, 刘敬浩, 付晓梅. 融合局部特征与深度置信网络的人脸表情识别[J]. 激光与光电子学进展, 2018, 55(1): 011002.

[2] 徐峰, 张军平. 人脸微表情识别综述[J]. 自动化学报, 2017, 43(3): 333-348.

Xu F, Zhang J P. Facial microexpression recognition: a survey[J]. Acta Automatica Sinica, 2017, 43(3): 333-348.

[3] Ekman P. Darwin, deception, and facial expression[J]. Annals of the New York Academy of Sciences, 2006, 1000(1): 205-221.

[4] 潘通, 李文国. 基于特征拼接的行人重识别[J]. 激光与光电子学进展, 2019, 56(16): 162001.

[5] 何志超, 赵龙章, 陈闯. 用于人脸表情识别的多分辨率特征融合卷积神经网络[J]. 激光与光电子学进展, 2018, 55(7): 071503.

[6] PfisterT, Li XB, Zhao GY, et al. Recognising spontaneous facial micro-expressions[C]∥2011 International Conference on Computer Vision, November 6-13, 2011, Barcelona, Spain. New York: IEEE, 2011: 1449- 1456.

[7] Wang YD, SeeJ, Phan Raphael C W, et al. LBP with six intersection points: reducing redundant information in LBP-TOP for micro-expression recognition[M] ∥Cremers D, Reid I, Saito H, et al. Computer vision - ACCV 2014. Cham: Springer, 2015: 525- 537.

[8] Liong ST, SeeJ, Phan Raphael C W, et al. Subtle expression recognition using optical strain weighted features[M] ∥Jawahar C V, Shan S G. Computer vision - ACCV 2014 workshops. Cham: Springer, 2015: 644- 657.

[9] Liong ST, Phan Raphael C W, See J, et al. Optical strain based recognition of subtle emotions[C]∥2014 International Symposium on Intelligent Signal Processing and Communication Systems (ISPACS), December 1-4, 2014, Kuching, Sarawak, Malaysia. New York: IEEE, 2014: 180- 184.

[10] Liu Y J, Zhang J K, Yan W J, et al. A main directional mean optical flow feature for spontaneous micro-expression recognition[J]. IEEE Transactions on Affective Computing, 2016, 7(4): 299-310.

[11] Happy S L, Routray A. Fuzzy histogram of optical flow orientations for micro-expression recognition[J]. IEEE Transactions on Affective Computing, 2019, 10(3): 394-406.

[12] PatelD, Hong XP, Zhao GY. Selective deep features for micro-expression recognition[C]∥2016 23rd International Conference on Pattern Recognition (ICPR), December 4-8, 2016, Cancun, Mexico. New York: IEEE, 2016: 2258- 2263.

[13] Kim DH, Baddar WJ, Ro YM. Micro-expression recognition with expression-state constrained spatio-temporal feature representations[C]∥Proceedings of the 2016 ACM on Multimedia Conference, October 1-19, 2016, Amsterdam, The Netherlands. New York: ACM, 2016: 382- 386.

[14] MayyaV, Pai RM, Pai M M M. Combining temporal interpolation and DCNN for faster recognition of micro-expressions in video sequences[C]∥2016 International Conference on Advances in Computing, Communications and Informatics (ICACCI), September 21-24, 2016, Jaipur, India. New York: IEEE, 2016: 699- 703.

[15] Khor HQ, SeeJ, Phan R C W, et al. Enriched long-term recurrent convolutional network for facial micro-expression recognition[C]∥2018 13th IEEE International Conference on Automatic Face & Gesture Recognition (FG 2018), May 15-19, 2018, Xi'an, China. New York: IEEE, 2018: 667- 674.

[16] ZhouL, Mao QR, Xue LY. Dual-inception network for cross-database micro-expression recognition[C]∥2019 14th IEEE International Conference on Automatic Face & Gesture Recognition (FG 2019), May 14-18, 2019, Lille, France. New York: IEEE, 2019: 1- 5.

[17] Khor HQ, SeeJ, Liong ST, et al. Dual-stream shallow networks for facial micro-expression recognition[C]∥2019 IEEE International Conference on Image Processing (ICIP), September 22-25, 2019, Taipei, Taiwan, China. New York: IEEE, 2019: 36- 40.

[18] Yan W J, Li X B, Wang S J, et al. CASME II: an improved spontaneous micro-expression database and the baseline evaluation[J]. PLoS One, 2014, 9(1): e86041.

[19] Li X B, Hong X P, Moilanen A, et al. Towards reading hidden emotions: a comparative study of spontaneous micro-expression spotting and recognition methods[J]. IEEE Transactions on Affective Computing, 2018, 9(4): 563-577.

[20] Cootes T F, Edwards G J, Taylor C J. Active appearance models[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2001, 23(6): 681-685.

[21] Choi DY, Kim DH, Song BC. Recognizing fine facial micro-expressions using two-dimensional landmark feature[C]∥2018 25th IEEE International Conference on Image Processing (ICIP), October 7-10, 2018, Athens. New York: IEEE, 2018: 1962- 1966.

[22] JungH, LeeS, YimJ, et al. Joint fine-tuning in deep neural networks for facial expression recognition[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 2983- 2991.

[23] Zhang K H, Huang Y Z, Du Y, et al. Facial expression recognition based on deep evolutional spatial-temporal networks[J]. IEEE Transactions on Image Processing, 2017, 26(9): 4193-4203.

[24] ZachC, PockT, BischofH. A duality based approach for realtime TV-L1 optical flow[M] ∥Hamprecht F A, Schnörr C, Jähne B. Pattern recognition. Heidelberg: Springer, 2007: 214- 223.

[25] ShreveM, GodavarthyS, GoldgofD, et al. Macro- and micro-expression spotting in long videos using spatio-temporal strain[C]∥Face and Gesture 2011, March 21-25, 2011, Santa Barbara, CA, USA. New York: IEEE, 2011: 51- 56.

[26] Xu F, Zhang J P, Wang J Z. Microexpression identification and categorization using a facial dynamics map[J]. IEEE Transactions on Affective Computing, 2017, 8(2): 254-267.

[27] Oh YH, Le Ngo A C, See J, et al. Monogenic riesz wavelet representation for micro-expression recognition[C]∥2015 IEEE International Conference on Digital Signal Processing (DSP), July 21-24, 2015, Singapore. New York: IEEE, 2015: 1237- 1241.

[28] Huang X H, Zhao G Y, Hong X P, et al. Spontaneous facial micro-expression analysis using spatiotemporal completed local quantized patterns[J]. Neurocomputing, 2016, 175: 564-578.

[29] Liong S T, See J, Wong K S, et al. Less is more: micro-expression recognition from video using apex frame[J]. Signal Processing: Image Communication, 2018, 62: 82-92.

苏育挺, 王蒙蒙, 刘婧, 费云鹏, 何旭. 基于多运动特征融合的微表情识别算法[J]. 激光与光电子学进展, 2020, 57(14): 141504. Yuting Su, Mengmeng Wang, Jing Liu, Yunpeng Fei, Xu He. Micro-Expression Recognition Algorithm Based on Multiple Motive Feature Fusion[J]. Laser & Optoelectronics Progress, 2020, 57(14): 141504.