基于熵率分割和多尺度分解的图像融合方法  下载: 1045次

下载: 1045次

1 引言

随着传感器技术的快速发展,传感器性能不断地提升,多个传感器的协同工作所获得的信息数量大幅增长,种类也呈现多样性。信息融合技术就是为了处理这些多传感器的信息。多传感器图像融合是信息融合技术的一种,主要处理各个图像传感器对同一场景成像中得到的互补信息,并对其进行优化结合,产生出对场景描述更精确全面的图像。在实际成像过程中,不同传感器的聚焦点不同,成像信息中得到的聚焦目标也不相同,如何在一幅图像中把整体场景的各个目标都清晰地表现出来,就需要多聚焦图像的融合技术[1]。

目前常见的图像融合主要是像素级的融合,方法也多种多样,主要包括基于空间域的算法和基于变换域的算法。基于空间域的算法主要是对图像系数的直接处理,比如像素值加权方法、主成分分析(PCA)方法、基于显著性分析的融合方法[2]、基于统计模型的贝叶斯优化融合方法、基于人类视觉特性提出的IHS变换方法、基于人工神经网络的脉冲耦合神经网络(PCNN)融合方法[3]。基于变换域的方法先对图像进行多尺度分解,然后根据高低频融合法则对系数进行选择,最后通过逆变换得到融合后的图像。比如基于金字塔变换的融合方法、基于小波变换(WT)的融合方法、基于Contourlet变换的融合方法等。近年来提出的新算法大都把两者结合起来,信息互补,可以得到更好的融合结果图。文献[ 4]提出的基于金字塔变换的融合方法,通过改进重构方法,获得更清晰的图像;文献[ 5]提出的基于WT和区域能量的融合方法,文献[ 6]提出的基于多尺度分解和方向区域的融合方法都是通过空间域和变换域的结合实现的,在进行系数选择时均需通过目标系数的局部能量比较。

目前基于变换域的方法中,融合规则都是针对目标像素或目标像素及周围少量像素组成的小窗口,使用这样的融合规则虽然能得到较好的结果图,但是图像的某些区域由于像素来自不同的源图像会产生融合过渡不自然的现象,无法充分体现出图像的区域相关性。针对这种情况,本文提出一种在多尺度分解基础上结合了熵率分割的融合方法。首先对图像进行多尺度分解,然后对低频子带进行熵率分割,得到多块具有相关性的区域,针对不同的区域进行选择,再对多个尺度图像进行反变换得到融合图像。实验结果表明,本文方法得到的融合图像边缘更加平滑,信息更加丰富,融合效果更好。

2 基本原理

2.1 非下采样Contourlet变换

多尺度分解方法采用非下采样Contourlet变换(NSCT),包括非降采样金字塔 (NSP)滤波器和非降采样方向滤波器组(NSDFB)[7]。NSCT具有多尺度、多分辨率、各向异性和平移不变的特性。除此之外,NSCT分解得到的子带具有相同大小的系数,更容易体现出子带系数之间的对应关系,可以更好地帮助图像融合。同时NSCT还消除了伪吉布斯现象,避免了其对融合产生的影响。

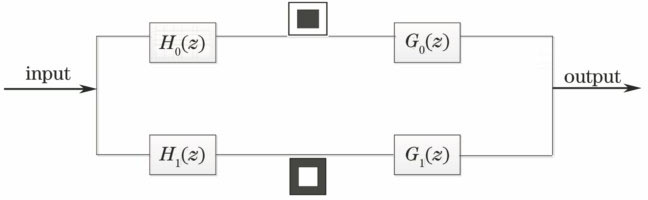

非降采样金字塔滤波器组是由多个不进行下采样的非降采样金字塔滤波器级联组成,因此具有平移不变的特性。通过滤波器把图像分解成一个高频子带和一个低频子带,然后对低频子带进行迭代分解来获得多级结构。这种滤波器组可以进行完全重构,但需要满足Bezout恒等式中的条件:

式中H0(z)表示低通分解滤波器,H1(z)表示带通分解滤波器,G0(z)表示低通重构滤波器,G1(z)表示带通重构滤波器。

通过对非降采样滤波器进行级联获得塔型滤波。在级联过程中,对后一层上的所有滤波器都进行上采样处理,由此完成双通道非采样塔形的分解和重构过程。

NSDFB结构与NSP结构相似,由一组扇形结构的非采样滤波器组构成,为了使滤波器具有平移不变性,去掉了所有结构块中的下采样操作。这种非降采样方向滤波器是双通道非降采样滤波器,为了获得多方向分解图,同时避免对图像的采样,将方向滤波器进行级联构成滤波器组,并在下一级对滤波器进行上采样,经过每一级滤波器的迭代,图像会分解成多个具有方向性的块结构。

2.2 低频子带融合规则

源图像经过NSCT后,图像的能量主要集中在低频子带中,且低频子带系数间的相关性较高,特征信息不只体现在一个像素点或者局部像素中,一般大量相关的信息会聚集在图像的某部分区域。目前

大多数多尺度算法都是对低频部分进行局部能量和方差的对比[8]。虽然都取得了一定的效果,但是由于局部对比不能完全体现系数的相关性,图像区域中的特征信息也无法完全获得,因此本文采用熵率分割,再对分割后的小块区域进行融合判断,这样可以更好地体现区域系数之间的相关性。

熵率分割是一种超像素分割的方法。2013年,Li等[9]在超像素分割的问题研究过程中,提出了熵率超像素分割。通过熵率分割可以获得更均匀紧凑的区域,使得分割后的区域符合人眼感知,且分割后得到的各个区域具有较高的相似度。这种方法是将图像映射成无向图,即G=(V,E),其中V代表图像的像素,E代表像素间的相似性,这样就把图像的分割问题转化为图的划分问题。对图G划分就是选取E的子集A,得到K个子集构成的无向图,即G1=(V,A)[10]。Li等[9]提出了一个新的聚类组合目标函数,其表达式为

式中H代表熵率条件,B代表平衡条件,λ≥0为平衡项权值。(2)式包含两个条件:1) 熵率随机游走条件;2) 集群分布的平衡条件。这两个条件的表达式解析过程比较复杂,本文不再重复讨论,可参考文献[ 9-10]。

对图像而言,熵率可以用来衡量图像中像素之间的相似程度,通过熵率对图像进行分割,使得分割后每一块区域都比较紧凑均匀,如

图 4. 熵率对集群紧凑度的影响。(a)熵率为0.81;(b)熵率为0.43;(c)熵率为0.64;(d)熵率为0.61

Fig. 4. Influence of entropy rate on cluster compactness. (a) Entropy rate is 0.81; (b) entropy rate is 0.43; (c) entropy rate is 0.64; (d) entropy rate is 0.61

观察

本文使用熵率超像素分割作为低频子带的融合规则,流程如下:

1) 把源图像A和B简单求平均融合在一起,得到图像C。

2) 使用熵率分割法把图像C分割成K个超像素块,得到分割后的图像D。

3) 分别对源图像A和B做NSCT分解并得到低频子带

4) 计算图像

式中分割区域K中共有Ssum个系数,M×N表示区域K的最小外接矩阵的大小,RF表示空间行频率,CF表示空间列频率。区域能量RE,K则是区域K的能量和。

5) 比较图像

式中

2.3 高频子带融合规则

高频子带中包含了图像的边缘细节和纹理特征,这些信息强度可以由像素系数的绝对值直接度量[11],因此对于高频子带采用基于单个像素的模最大值比较法。考虑到边缘纹理信息在图像中都会有一定的聚集,很少孤立地存在,因此在高频子带比较之后,还需要做一致性检测,使得这些像素和它周围的像素都来自一幅图像,这样融合的效果不会过于生硬。融合流程如下:

1) 分别对源图像A和B进行NSCT分解,经过N级分解后,可以得到

2) 定义一个与源图像尺寸相同的融合矩阵

3) 虽然图像分解到多个尺度上,但是同一个位置的系数应当来自于同一个源图像,这样融合的结果才能更加符合人眼视觉,因此对不同尺度子带进行一致性检测。检测尺度j下不同方向子带系数是否来自同一源图像,若不是来自同一源图像,则比较不同子带中该系数来自源图像A和B的数量,如果来自源图像A的数量多,则把该尺度下所有方向对应的融合矩阵

4) 检测图像中系数和周围的8个系数来源,并把

5) 高频子带融合。根据高频子带对应的融合矩阵

2.4 整体融合流程

整体流程如

3 实验结果及分析

对三组源图像Pepsi、Disk和Lab进行了融合,并与基于NSCT的融合方法、基于WT的融合方法、基于PCNN的融合方法、基于熵率分割的融合方法进行比较,结果证明本文方法效果更好。在NSCT变换过程中,随着分解层数的增加,图像的融合效果会更好,但当分解层数超过某一数值时,融合效果反而变差,同时随着分解层数增加,融合时间也会不断增加。当分解参数分别为[2,2],[2,3],[2,4],[2,2,3],[2,3,3],[2,3,4],[2,2,3,3],[2,3,3,3]时,参数[2,3],[2,2,3]明显高于其他参数,参数[2,2,3]虽然在SF、边缘保留值和平均梯度(AG)上略高于参数[2,3],但由于分解层数的增加使高频子带较多,在进行一致性检测时需要大量的时间,实验中参数[2,2,3]比参数[2,3]所用时间增加了31%,因此本文实验中选取参数[2,3]。

实验选取已经配准过的多聚焦融合图像Pepsi。大小为512 pixel×512 pixel,实验结果如

通过观察

表 3. Lab图像质量评价结果

Table 3. Quality assessment results on fusion image of Lab

|

表 1. Pepsi融合图像质量评价结果

Table 1. Quality assessment results on fusion image of Pepsi

|

表 2. Disk融合图像质量评价结果

Table 2. Quality assessment results on fusion image of Disk

|

考虑到主观比较方法很容易受到观察者本身主观性和片面性的影响,采用5种融合图像质量评价标准对不同的方法进行客观的比较,包括边缘信息保留值(QAB/F,用来计算融合图像中保留的来自源图像的边缘信息值)、互信息(MI,用来衡量融合图像从源图像中提取的信息量)、信息熵(用来描述图像的平均信息量,是衡量图像信息丰富程度的指标)、SF(用来反映图像在空间域的总体活跃程度)、AG(用来描述图像的清晰程度,反映图像的细节反差程度和纹理变换特征能力)[12-13]。上述评价标准值越大,融合效果越好。

图 6. Pepsi图像的融合结果。(a)左聚焦图像;(b)右聚焦图像;(c) NSCT融合方法;(d) WT融合方法;(e) PCNN融合方法;(f)熵率分割融合方法;(g)本文方法

Fig. 6. Fusion results on Pepsi image. (a) Left-focus image; (b) right-focus image; (c) NSCT fusion method; (d) WT fusion method; (e) PCNN fusion method; (f) entropy rate segmentation fusion method; (g) proposed method

比较

为了进一步验证本文方法的性能,选取已经配准过的多聚焦融合图像Disk,大小为640 pixel×480 pixel,实验结果如

由

图 7. Disk图像融合结果。(a)左聚焦图像;(b)右聚焦图像;(c) NSCT融合方法;(d) WT融合方法;(e) PCNN融合方法;(d)熵率分割融合方法;(g)本文方法

Fig. 7. Fusion results on Disk. (a) Left-focus image; (b) right-focus image; (c) NSCT fusion method; (d) WT fusion method; (e) PCNN fusion method; (f) entropy rate segmentation fusion method; (g) proposed method

为了验证本文方法的适用性,选取已经配准过的多聚焦融合图像Lab,大小为640 pixel×480 pixel,实验结果如

图 8. Lab图像融合结果图。(a)左聚焦图像;(b)右聚焦图像;(c) NSCT融合方法;(d) WT融合方法;(e) PCNN融合方法;(d)熵率分割融合方法;(g)本文方法

Fig. 8. Fusion results on Lab image. (a) Left-focus image; (b) right-focus image; (c) NSCT fusion method; (d) WT fusion method; (e) PCNN fusion method; (f) entropy rate segmentation fusion method; (g) proposed method

通过比较

4 结论

针对多聚焦图像融合问题,提出了一种基于NSCT和熵率分割的融合方法。首先把两幅源图像简单融合并进行熵率分割,再分别对其进行NSCT分解,将分解后的低频子带按照熵率分割的结果划分成不同区域,根据区域的SF和能量进行融合,同时对高频子带进行模值比较和一致性检测。最后对高低频子带进行逆变换生成融合结果图。本文方法得到的结果图保留了更多的图像特征信息,且边缘过渡自然,在主观分析和客观评价中均有较好的表现。今后的工作中,仍然需要提高方法性能,采用并行思路提升运行效率,缩短方法运行的时间。

[2] 张立保, 章珏. 基于显著性分析的自适应遥感图像融合[J]. 中国激光, 2015, 42(1): 0114001.

[4] 苗启广, 王宝树. 基于改进的拉普拉斯金字塔变换的图像融合方法[J]. 光学学报, 2007, 27(9): 1605-1610.

[5] 蔡植善, 陈木生. 基于小波变换的多聚焦图像融合方法研究[J]. 激光与光电子学进展, 2015, 52(9): 091003.

[6] 周生龙, 张涛, 蒯多杰, 等. 基于方向区域的NSCT图像融合算法[J]. 激光与红外, 2013, 43(2): 204-207.

[9] Li QP, Du JP, Song FZ, et al. Region-based multi-focus image fusion using the local spatial frequency[C]. IEEE 25 th Chinese Control and Decision Conference , 2013: 3792- 3796.

[10] 王亚杰, 叶永生, 石祥滨. 一种基于熵率超像素分割的多聚焦图像融合[J]. 光电工程, 2014, 41(9): 56-62.

[11] 宋瑞霞, 王孟, 王小春. NSCT与边缘检测相结合的多聚焦图像融合算法[J]. 计算机辅助设计与图形学学报, 2016, 28(12): 2134-2141.

[12] 杨粤涛. 基于非采样Contourlet变换的图像融合[D]. 长春: 中国科学院长春光学精密机械与物理研究所, 2012: 16- 20.

Yang YT. Research on image fusion based on nonsubsamepled contourlet transform[D]. Changchun: Changchun Institute of Optics, Fine Mechanics and Physics,Chinese Academy of Sciences, 2012: 16- 20.

[13] 徐月美. 多尺度变换的多聚焦图像融合算法研究[D]. 徐州: 中国矿业大学, 2012: 14- 16.

Xu YM. Study on multi-focus image fusion based on multi-scale transform[D]. Xuzhou: China University of Mining and Technology, 2012: 14- 16.

殷向, 马骏. 基于熵率分割和多尺度分解的图像融合方法[J]. 激光与光电子学进展, 2018, 55(1): 011011. Yin Xiang, Ma Jun. Image Fusion Method Based on Entropy Rate Segmentation and Multi-Scale Decomposition[J]. Laser & Optoelectronics Progress, 2018, 55(1): 011011.