结合一阶和二阶空间信息的行人重识别  下载: 1015次

下载: 1015次

1 引言

行人重识别[1]是利用计算机视觉技术对无重叠视角相机捕获的行人图像和特定行人图像进行特征提取,并根据距离度量方法判断是否为同一行人。随着人工智能化的推进,行人重识别技术在智能安防、无人超市、人机交互等领域有着广阔的应用前景,但光照、遮挡、分辨率、人体姿势、相机视角、背景和行人服饰等方面的变化较大,使行人重识别极具挑战性。

早期的行人重识别主要研究如何设计具有鲁棒性的手工视觉特征[2-4]和寻找合适的投影空间以对特征进行相似度量[4-6]。常见的手工视觉特征结合颜色直方图、纹理直方图对行人表征进行建模,得到的高维行人特征可通过一系列相似性度量约束寻找出一个线性投影空间,以更好地区分类内变化和类间差异。但传统方法设计手工特征时容易忽视一些视觉捕捉不到的信息,且距离度量过程不能很好地利用手工特征的高维信息,往往只能得到次优的重识别结果。因此,人们将深度学习技术应用到行人重识别任务中。不同于传统方法将行人重识别任务分为特征学习和距离度量两部分进行独立优化,深度学习利用多个非线性映射结构提取查询图像中的高级视觉语义,通过目标函数进行端到端的学习优化,将两个环节结合到一起。根据目标函数的优化,深度学习网络可自动从图像数据中学习更具有判别性的特征以适应行人重识别任务,且识别结果较好。Li等[7]提出了滤波器对神经网络(FPNN),率先将神经网络用于行人重识别领域,相比传统方法,识别性能得到了一定的提升。但单纯提取行人的全局特征会使深度网络忽略具有判别性的局部细节,在背景复杂、行人检测框不精准、有遮挡的情况下表现不佳。Zhao等[8]引入姿态估计模型检测14个人体关键点,并根据关键点划分身体部位,按自下而上的顺序进行特征融合,得到了较好的识别结果。毕晓君等[9]引入Deepcut模型获得了14通道的关键点置信图,并根据关键点置信图进行粗略姿态和精细姿态建模,以降低视角变化对行人重识别的影响。但该方法需要引入预先训练好的姿态估计模型,会给行人重识别网络引入额外误差。Cheng等[10]将查询图像切分为4个水平条带,分别提取4个局部特征和1个全局特征进行融合,用三元组损失优化整个网络。Sun等[11]设计了一个精炼部分池化(RPP)模块,重新分配水平条带边缘部分的异常值,以保持水平条带内信息的一致性。为了尽可能地减少水平切分对全局上下文信息连贯性的破坏,徐龙壮等[12]通过金字塔池化获得多尺度信息,并通过特征融合技术使相邻区域形成语义连贯性,以提供更丰富的上下文信息。

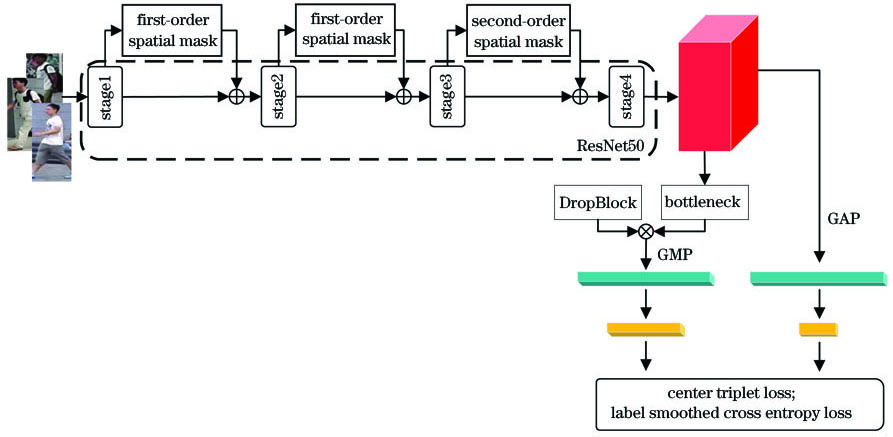

针对大多数局部网络模型只侧重于学习相邻局部之间的相关性,忽略了远距离局部间关系的问题,基于已有研究工作[13-15],本文提出了一种结合一阶和二阶空间信息的行人重识别网络模型。用卷积分支学习具有判别性的空间信息,一阶空间掩模为全局特征重新分配空间权重,以减少背景噪声对远距离相关性建模的干扰;二阶空间掩模对全局特征进行远距离依赖建模,并集成图像的局部信息。引入DropBlock对提取的行人特征进行正则化,避免网络模型过拟合的同时学习更具有判别性的局部特征。将正样本中心引入三元组损失中,使类间特征距离更大的同时保证类内样本特征具有更紧凑的空间分布。在训练阶段,用中心三元组损失联合标签平滑分类损失对整个网络进行优化。在Market-1501和DukeMTMC-reID数据集上的多次实验结果表明,相比其他算法,本网络模型抽取的特征更具判别性,且能有效提升行人重识别的精度。

2 理论与方法

本网络的框架如

图 1. 结合一阶和二阶空间信息的行人重识别网络框架

Fig. 1. Architecture of person re-identification network based on first-order and second-order spatial information

全局分支将第4阶段输出的特征图,经全局平均池化(GAP)层得到2048维的特征向量,并用由1×1卷积层、批归一化(BN)层和线性修正单元(ReLU)激活函数层组成的特征降维模块,将特征向量降至512维作为全局特征表示,由标签平滑分类损失和中心三元组损失进行优化。局部分支在第4阶段后附加了一个由卷积层和BN层、ReLU层组成的ResNet瓶颈块[16]。为了使网络模型能够学习到更多具有判别性的空间相关性,减少对某个特定区域的依赖,避免网络过拟合,将DropBlock[19]应用于瓶颈块产生的特征图,将其局部特征成块擦除。擦除后的特征图经全局最大池化(GMP)层得到2048维的局部特征向量,用降维模块将其降至1024维,由标签平滑分类损失和中心三元组损失进行优化。测试阶段将全局和局部分支的特征向量级联作为最终特征,从而计算样本之间的距离。

2.1 一阶空间掩模

在真实监控场景下,摄像头捕获的行人图像往往具有复杂的背景,且背景区域可能与行人前景变化相似,直接利用卷积特征进行二阶空间信息建模可能导致次优结果。因此,用一阶空间掩模为图像特征重新分配空间权重,有利于依赖关系获得更多的细节信息,并抑制其他无用信息,避免错误建模。

一阶空间掩模的结构如

式中,XL1-norm为特征图X通道轴上特征向量的L1范数,W为卷积层参数,σ为Sigmoid函数。Sigmoid函数将空间置信度得分归一化到

将残差学习得到的一阶空间特征图FFOM

2.2 二阶空间掩模

目前大多数行人重识别算法是训练深度学习模型对样本图像中的局部和全局、局部和局部之间的信息进行编码,以提取有效的行人特征。为了避免对样本图像进行硬切分引起的空间相关性割裂,二阶空间掩模[15]将非局部操作与二阶统计量相结合,并利用非局部操作对特征图中位置的相关性进行建模,将卷积操作获取的局部信息集成到远距离依赖建模中,具体如

二阶空间掩模结构如

式中,

最后,用一个1×1卷积作为可学习变换p将依赖特征矩阵的通道维数从c/r还原为c,经过适当的重塑,得到w×h×c的依赖特征张量

通过残差学习得到的二阶空间特征可表示为

二阶空间特征FSOM

2.3 损失函数

实验用标签平滑正则化的交叉熵损失[20-21]和改进后的三元组损失优化整个网络模型。交叉熵损失通过样本图像的分类预测值和其真实标签评估网络的性能,可表示为

式中,N为每批次中包含的样本图像数,K为每批次中包含的样本类别数,

式中,ε为平滑因子。引入平滑标签正则化的交叉熵损失不仅考虑到了行人样本正确分类的损失,也考虑了错误分类的损失,从而提高模型的学习能力,一定程度上避免模型过拟合。

为了更好地区分类内类间差异,从输入图像中学习判别性特征,首先将行人样本分为一系列三元组单元

式中,

图 5. 不同损失函数监督下的二维可视化样本分布。(a)标签平滑分类损失和基本三元组损失;(b)标签平滑分类损失和中心三元组损失

Fig. 5. Two-dimensional visualization of sample distribution supervised by different losses. (a) Label smoothed cross entropy loss and basic triplet loss; (b) label smoothed cross entropy loss and center triplet loss

3 实验分析

3.1 数据集及评价标准

为了验证结合一阶和二阶空间信息网络的有效性,在Market-1501[23]和DukeMTMC-reID[24]两个大规模的公开行人重识别数据集上进行了测试实验。

表 3. 不同算法在DukeMTMC-reID数据集上的识别结果

Table 3. Recognition results of different algorithms on the DukeMTMC-reID data set unit: %

|

表 2. 不同算法在Market-1501数据集上的识别结果

Table 2. Recognition results of different algorithms on the Market-1501 data set unit: %

|

表 1. 不同模型的实验结果

Table 1. Experimental results of different models unit: %

| |||||||||||||||||||||||||||||||||||||||

Market-1501数据集在夏季的清华校园内进行采集,行人样本具有较大的姿态和光照变化,包含6个室外摄像头(5个高分辨率摄像头和1个低分辨率摄像头)拍摄的1501个行人,共32217张图像。将751个行人的12936张图像作为训练集,将750个行人的19732张图像作为测试集。行人检测框由可变部件模型(DPM)算法和人工进行标注,更符合真实应用场景。

DukeMTMC-reID数据集在冬季的杜克大学校园内进行采集,行人样本具有较大的外观变化,包括8个室外摄像头拍摄到的1812个行人,共36441张图像,行人检测框由人工进行标注。由于只有1404个行人在超出两个摄像头中出现过,因此,随机采样702个行人的所有图像作为训练集,702个行人的所有图像作为测试集,剩余408个人的所有图像作为干扰项加入测试集,可使数据集更具挑战性。

实验使用首位命中率(Rank-1)和平均精度均值(mAP)作为评估行人重识别算法在Market-1501和DukeMTMC-reID数据集上的性能。Rank-1指标是将行人重识别作为图像检索问题进行处理,表示在图库图像中第一次检索即命中查询目标的概率。mAP是平均精度(AP)的均值,可表示为

式中,r为查询返回的图库图像总数,N为返回图像中命中查询目标的图像数量,P

3.2 实验参数设置

实验环境:系统为Ubuntu16.04,显卡为NVIDIA Quadro P5000,显存为16 GB,框架为Pytorch,用ImageNet数据集[25]上的预训练权重初始化主干网络ResNet50。为了从每张图像中捕获更详细的信息,将所有输入图像的分辨率调整为384 pixel×128 pixel,并通过水平翻转、归一化和裁剪对图像进行数据增强。设置DropBlock的擦除率γ为0.1,擦除块的高度为5,宽度为8。标签平滑分类损失中的平滑因子ε为0.1,中心三元组损失函数中的间隔阈值m为0.3,批处理大小为64,每批次中随机抽取16个行人,每个行人抽取4张图像。学习周期为400,采用Adam优化算法更新参数,初始学习率为e-3,在200个周期时衰减至e-4,在300个周期时衰减到e-5。

3.3 消融实验

为了验证本算法的有效性,在Market-1501和DukeMTMC-reID数据集上进行消融实验,结果如

为了进一步探究一阶和二阶空间信息相结合的优越性,给出了部分样本的热力图,如

图 6. 样本热力图。 (a)仅使用SOM得到的样本热力图; (b)使用OM和SOM得到的样本热力图

Fig. 6. Sample heat map. (a) Sample heat map obtained using only SOM; (b) sample heat map obtained using OM and SOM

3.4 实验结果可视化

为了更直观地展现算法的改进效果,将本算法与基准网络进行对比,并将实验结果可视化为

图 7. Market-1501数据集的可视化结果。(a)基准网络算法;(b)本算法

Fig. 7. Visualization results of Market-1501 data set. (a) Baseline network algorithm; (b) our algorithm

图 8. DukeMTMC-reID数据集的可视化结果。(a)基准网络算法;(b)本算法

Fig. 8. Visualization results of DukeMTMC-reID data set. (a) Baseline network algorithm; (b) our algorithm

可视化示例选取背景与前景变化相似的样本,其中,

3.5 与主流算法的对比

从

4 结论

提出了一种结合一阶和二阶空间信息的行人重识别网络,通过引入二阶空间掩模避免了样本局部硬切分带来的局部相关性缺失。针对背景噪声干扰局部特征远距离建模的问题,在二阶空间依赖建模前的特征提取阶段嵌入一阶空间掩模微调空间权重,抑制错误依赖关系建模。在基础三元组损失中引入正样本中心,更有效地约束类内距离,增大类间距离。在Market-1501和DukeMTMC-reID数据集上的实验结果表明,相比其他算法,本算法能提取具有鲁棒性的行人特征,有效提升行人重识别的精度。未来工作还需研究如何对行人运动的时空信息进行建模,进一步提高行人重识别的精度。

[1] 杨锋, 许玉, 尹梦晓, 等. 基于深度学习的行人重识别综述[J]. 计算机应用, 2020, 40(5): 1243-1252.

[2] Liao SC, HuY, Zhu XY, et al. Person re-identification by local maximal occurrence representation and metric learning[C]∥2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 7-12, 2015, Boston, MA, USA. New York: IEEE, 2015: 2197- 2206.

[3] Ojala T, Pietikainen M, Maenpaa T. Multiresolution gray-scale and rotation invariant texture classification with local binary patterns[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002, 24(7): 971-987.

[4] 朱小波, 车进. 基于特征融合与子空间学习的行人重识别算法[J]. 激光与光电子学进展, 2019, 56(2): 021503.

[5] ZhaoR, Ouyang WL, Wang XG. Unsupervised salience learning for person re-identification[C]∥2013 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2013, Portland, OR, USA. New York: IEEE, 2013: 3586- 3593.

[6] XiongF, Gou MR, CampsO, et al. Person re-identification using kernel-based metric learning methods[M] ∥Fleet D, Pajdla T, Schiele B, et al. Computer Vision-ECCV 2014. Lecture Notes in Computer Science. Cham: Springer, 2014, 8695: 1- 16.

[7] LiW, ZhaoR, XiaoT, et al. DeepReID: deep filter pairing neural network for person re-identification[C]∥2014 IEEE Conference on Computer Vision and Pattern Recognition, June 23-28, 2014, Columbus, OH, USA. New York: IEEE, 2014: 152- 159.

[8] Zhao HY, Tian MQ, Sun SY, et al. Spindle net: person re-identification with human body region guided feature decomposition and fusion[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 907- 915.

[9] 毕晓君, 汪灏. 基于视角信息嵌入的行人重识别[J]. 光学学报, 2019, 39(6): 0615007.

[10] ChengD, Gong YH, Zhou SP, et al. Person re-identification by multi-channel parts-based CNN with improved triplet loss function[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 1335- 1344.

[11] Sun YF, ZhengL, YangY, et al. Beyond part models: person retrieval with refined part pooling (and a strong convolutional baseline)[EB/OL]. [2020-05-23].https:∥arxiv.org/abs/1711. 09349.

[12] 徐龙壮, 彭力. 基于多尺度卷积特征融合的行人重识别[J]. 激光与光电子学进展, 2019, 56(14): 141504.

[13] Liu H, Feng J S, Qi M B, et al. End-to-end comparative attention networks for person re-identification[J]. IEEE Transactions on Image Processing, 2017, 26(7): 3492-3506.

[14] LiW, Zhu XT, Gong SG. Harmonious attention network for person re-identification[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 2285- 2294.

[15] BryanB, GongY, Zhang YZ, et al. Second-order non-local attention networks for person re-identification[C]∥2019 IEEE/CVF International Conference on Computer Vision (ICCV), October 27-November 2, 2019, Seoul, Korea (South). New York: IEEE, 2019: 3759- 3768.

[16] He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 770- 778.

[17] Dai ZZ, Chen MQ, Zhu SY, et al. Batch feature erasing for person re-identification and beyond[EB/OL]. [2020-05-21].https:∥arxiv.org/abs/1811. 07130.

[18] YuF, KoltunV, FunkhouserT. Dilated residual networks[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), July 21-26, 2017, Honolulu, HI, USA. New York: IEEE, 2017: 636- 644.

[19] GhiasiG, Lin TY, Le QV. Dropblock: a regularization method for convolutional networks[EB/OL]. [2020-05-24].https:∥arxiv.org/pdf/1810. 12890.

[20] SzegedyC, VanhouckeV, IoffeS, et al. Rethinking the inception architecture for computer vision[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 27-30, 2016, Las Vegas, NV, USA. New York: IEEE, 2016: 2818- 2826.

[21] HeT, ZhangZ, ZhangH, et al. Bag of tricks for image classification with convolutional neural networks[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 15-20, 2019, Long Beach, CA, USA. New York: IEEE, 2019: 558- 567.

[22] HermansA, BeyerL, LeibeB. In defense of the triplet loss for personre-identification[EB/OL]. [2020-05-24].https:∥arxiv.org/abs/1703. 07737.

[23] ZhengL, Shen LY, TianL, et al. Scalable person re-identification: a benchmark[C]∥2015 IEEE International Conference on Computer Vision (ICCV), December 7-13, 2015, Santiago, Chile. New York: IEEE, 2015: 1116- 1124.

[24] RistaniE, SoleraF, ZouR, et al. Performance measures and a data set for multi-target, multi-camera tracking[EB/OL]. [2020-05-20].https:∥arxiv.org/abs/1609. 01775.

[25] DengJ, DongW, SocherR, et al. ImageNet: a large-scale hierarchical image database[C]∥ 2009 IEEE Conference on Computer Vision and Pattern Recognition, June 20-25, 2009, Miami, FL, USA. New York: IEEE, 2009: 248- 255.

[26] Zheng ZD, ZhengL, YangY. Unlabeled samples generated by GAN improve the person re-identification baseline in vitro[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 3774- 3782.

[27] Sun YF, ZhengL, Deng WJ, et al. SVDNet for pedestrian retrieval[C]∥2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. New York: IEEE, 2017: 3820- 3828.

[28] XuJ, ZhaoR, ZhuF, et al. Attention-aware compositional network for personre-identification[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, June 18-23, 2018, Salt Lake City, UT, USA. New York: IEEE, 2018: 2119- 2128.

[30] Wang GS, Yuan YF, ChenX, et al. Learning discriminative features with multiple granularities for person re-identification[EB/OL]. [2020-05-21].https:∥arxiv.org/pdf/1804.01438.pdf.

[31] ZhengF, DengC, SunX, et al. Pyramidal person re-identification via multi-loss dynamic training[C]∥2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), June 15-20, 2019, Long Beach, CA, USA. New York: IEEE, 2019: 8506- 8514.

Article Outline

刘莎, 党建武, 王松, 王阳萍. 结合一阶和二阶空间信息的行人重识别[J]. 激光与光电子学进展, 2021, 58(2): 0215005. Sha Liu, Jianwu Dang, Song Wang, Yangping Wang. Person Re-Identification Based on First-Order and Second-Order Spatial Information[J]. Laser & Optoelectronics Progress, 2021, 58(2): 0215005.