基于深度学习和人眼视觉系统的遥感图像质量评价  下载: 1642次

下载: 1642次

1 引言

遥感技术能够从不同高度大范围地快速获取地面信息,目前被广泛应用于气象、地质、生态、水文等领域。图像质量直接关系到已获取信息的准确性和可靠性。一般来说,图像的退化不仅受到成像系统的影响,还受到大气和气候等环境的影响[1]。为了确保遥感数据的应用能力,对遥感图像质量的评价是很有必要的[2]。但是目前遥感图像数据量巨大,高效率并准确地实现图像质量评价具有很大的研究价值。

遥感图像质量的评价方法主要分为主观评价和客观评价。主观评价需要评分员对遥感图像进行人工判读,评价出符合人眼视觉效果的质量结果,这种方法费时费力。客观评价方法是计算机根据相应算法建立模型从而得到相应的图像质量指标。海量的遥感数据量导致人们不能对每一幅遥感图像进行主观评价,因此建立计算机自动遥感数据评估机制具有十分重要的意义。

目前,图像分辨率评估和报告标准(IRARS)委员会已经建立了国家图像可辨性评估量表(NIIRS)。经过后续的发展,NIIRS一直是美国情报界最受欢迎的图像质量指标,是由解释任务或标准定义的10级量表;Sheikh等[3]提出的视觉信息保真度(VIF)方法通过计算待评价图像与参考图像之间的互信息来衡量待评价图像质量的优劣。鉴于遥感图像最终的应用对象是人眼,所以图像质量评价结果还需要考虑人眼视觉系统(HVS)。文献[ 4]将底层特征的图像质量评估算法与梯度结构相似度算法相结合,得到一种符合人眼视觉系统特点的图像质量评估方法。Chandler等[5]基于小波域的视觉信噪比对自然图像质量进行评价。

目前广泛应用的图像质量评价方法需要依靠手工提取特征,不仅费时耗力,而且对人员技术有较高的要求,因此并不适用于图像特征各异且数据量较大的应用场景。人类大脑能够综合处理大量视觉感知信息,而深度学习能够模拟人脑的视觉认知推理过程来建立学习数据内部隐藏关系逻辑的层次模型,对于大规模、高维度数据处理拥有巨大的潜能。深度学习模型可以在接受大规模标记数据集的训练时,获得显著的泛化能力。深度卷积神经网络(CNN)模型采用多层线性和非线性变换,可以有效地处理高维度的原始图像数据,学习输入与输出之间的复杂映射,极大地降低了图像质量评价过程对特征选择的依赖[6]。

由于模糊和噪声大多数是同时存在于遥感图像中,不能归为单一的失真类型。不同类型的失真会对图像质量造成不同的影响,而当两种类型的失真同时出现在一张图像上时,人眼主观感受到的影响并不是简单的“1+1=2”,而是不同失真类型的相互影响。在混合失真中,不同失真对于图像质量的影响可能出现相互抵消或者相互增强的效果。因此,在对遥感图像质量的评价过程中需要同时考虑噪声和模糊。为解决这一困难,邵宇等[7]利用人眼视觉系统中的对比度掩盖效应,分析了模糊和噪声对遥感图像视觉特性的影响,结合结构相似性度量方法,提出了一种无参考型遥感图像质量评价方法。张飞艳等[8]在遥感影像小波域统计特性的基础上,通过分析噪声和模糊对影像特性的不同影响,从而对噪声和模糊强度分别进行判定,得出图像质量评价指标。由于遥感图像最终的接受者是人眼,因此评价遥感图像质量的方法还应该遵循人眼的视觉特性。

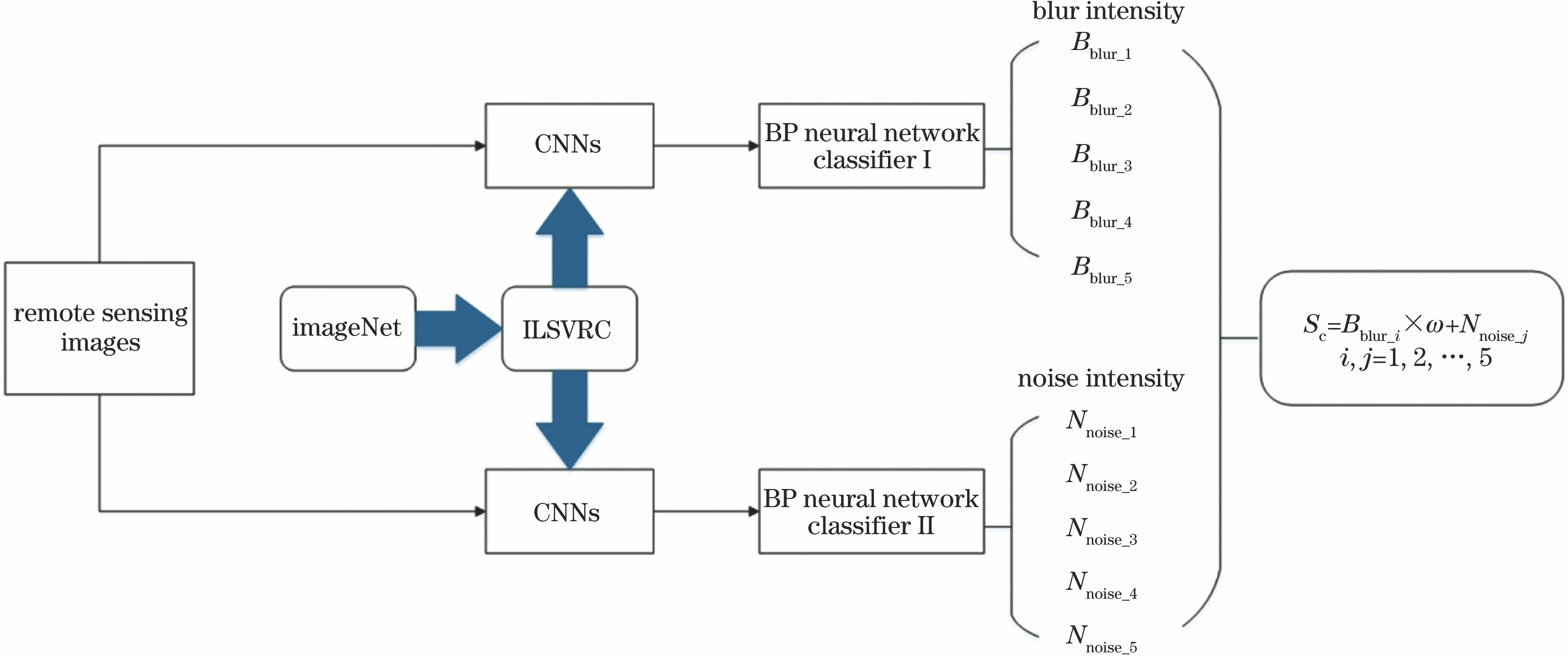

针对上述问题,提出了一种基于深度卷积神经网络的遥感图像质量评价模型,模型分为3个步骤:1) 利用深度卷积神经网络作为特征提取器,将提取特征输入BP(Back Propagation)神经网络分类器,分别建立模糊强度和噪声强度分类器;2) 根据人眼视觉特性中的对比度掩盖效应,构建模糊影响因子,对模糊强度进行感知加权;3) 修正评价模型,得到最终的遥感图像质量综合评价模型。

2 方法概述

2.1 算法总体框架

对VGG(Visual Geometry Group Network)16网络进行修改,将收集到的遥感图像样本集输入网络中,对模糊和噪声程度不同的遥感图像并行地进行特征提取,并对失真程度进行判别。根据HVS中的掩盖效应(噪声对图像平滑区域影响更大,模糊对图像边缘、纹理丰富的区域影响更大),对失真程度进行感知加权。最后利用上述方法对每一幅测试图像计算感知加权后的模糊强度,再与噪声强度综合得到遥感图像最终的质量评价结果。评价模型的整体结构如

2.2 模糊等级、噪声强度等级的判定

深度学习能够将原始输入转换为更高和更抽象级别的表示。深度学习的关键在于:这些特征层不是由人类工程师设计的,而是通过学习过程从数据中学习到的。CNN是目前进行图像分类、对象识别和其他图像处理任务等[9]一种最佳的表现方法,同时也是一种优秀的特征提取器,它可以对原始图像的特征和表征形式进行端到端的学习,进而进行分类任务,免去了手工设计特征的麻烦,CNN作为特征提取器已经被广泛用于计算机视觉任务中[10]。基于CNN的算法近年来在ILSVRC[11-12]中取得了超人类的成果,受深度学习的启发,通过修改VGG16网络来设计评价模型。基于并行深度卷积CNN的单路评价框架如

VGG网络架构最初是由Simonyan和Zisserman提出的[13]。其中,16层VGG网络经过大量实验证明其特征提取效果较好[9]。VGG16架构如

调整所有输入图像的大小后,使用海量数据集ImageNet初始化该深度网络的参数,以便与CNN兼容。由于特征信息的代表性随着网络层数的加深会越来越强,因此对Vgg16网络进行修改,仅保留网络第2个全连接层之前的部分,利用Vgg16网络作为特征提取器,将从第2个全连接层提取的4096维特征作为图像的特征向量。并且利用迁移学习的方法[14],以VGG16作为基础模型,对ImageNet数据集上的对象检测任务进行预训练。使用VGG16来提取图像的深层特征,提取到的更深层次高层特征具有充分的图像表示能力和泛化能力,其特征可以直接使用分类器来区分不同样本的高层语义信息,并应用到失真程度等级判别的任务上。BP神经网络分类器被广泛应用于分类任务,具有较强的非线性映射能力和泛化能力,是一种常用且优秀的机器学习分类器。用BP神经网络分类器替换softmax层,用提取的特征作为BP神经网络分类器的输入,通过训练好的BP神经网络分类器分别得到图像的模糊等级和噪声等级的分类结果。

模糊等级和噪声等级定义如

将图像的模糊等级和噪声等级的判别转化为BP神经网络的分类问题,由卷积神经网络提取出的图像的4096维特征利用BP神经网络分别进行模糊等级和噪声等级分类。分类阶段分为训练和分类两个部分,首先将提取的训练集图像的深度特征分别输入到两个BP神经网络分类器中,对BP分类器进行训练,从而可以得到训练好的BP神经网络分类器。训练完成后,将测试集图像的深度特征输入到已经训练好的两个BP神经网络分类器中进行分类,最终得到分类器1和分类器2的输出标签,即模糊等级和噪声等级的评价结果。

2.3 模糊度影响因子

然而,对一幅遥感图像质量的影响不应该仅仅考虑模糊强度和噪声强度的影响,还应该考虑到人眼视觉特性对遥感图像质量的影响。在数字图像处理中,视觉掩盖效应是在多个激励存在的情况下,一个激励干扰另一个激励,使得视觉阈值发生变化。HVS对于图像中不同区域有着各自不同的敏感程度。同一种类型和规模的模糊失真,会在同一图像上细节丰富区域和平坦区域上引起不同的失真程度。大量视觉经验表明[7],对于图像中的边缘和细节丰富的区域,模糊失真对图像质量的影响更大,而对于图像中的平坦区域,影响较小,如

通过引入表征图像纹理复杂程度的模糊度影响因子,反映模糊失真对图像中细节丰富区域的影响。图像的纹理[15]是图像像素颜色或灰度在空间中以一定形式变化而产生的图案,可用于反映图像本身的属性。灰度共生矩阵通过定义大量的纹理特征来对图像纹理进行有效地描述。熵是图像信息量的度量,纹理信息也属于图像的信息,是一个随机性的度量。本文采用灰度共生矩阵的熵来描述遥感图像中纹理的非均匀程度或复杂程度。当共生矩阵中所有元素的随机性较大时,空间共生矩阵中所有值几乎相等,共生矩阵中元素分散分布时,熵较大。灰度共生矩阵的熵来定义为

式中:

图 4. 模糊和噪声对遥感图像视觉特性的影响。(a)原始图像;(b)加入噪声后图像;(c)再加入噪声后图像;(d)模糊后图像;(e)再模糊后图像

Fig. 4. Influences of blur and noise on visual characteristics of remote sensing images. (a) Original image; (b) image with noise; (c) image with noise once more; (d) image with blur; (e) image with blur once more

图 5. 具有不同纹理复杂度遥感图像。(a) S=9.2784;(b) S=23.1248;(c) S=19.0502;(d) S=14.9255;(e) S=20.1074;(f) S=13.2125;(g) S=23.2592;(h) S=18.7957

Fig. 5. Remote sensing images with different texture complexity. (a) S=9.2784; (b) S=23.1248; (c) S=19.0502; (d) S=14.9255; (e) S=20.1074; (f) S=13.2125; (g) S=23.2592; (h) S=18.7957

考虑到人类对图像质量的感知是一个复杂的非线性过程,为了简化问题,选用关系函数将共生矩阵熵转化为模糊度影响因子。设模糊度影响因子为

数据分析可知,模糊度影响因子

设模糊度影响因子为

式中:

3 实验与分析

收集了包含植被、道路、城市建筑等典型遥感地物特征的QuickBird-2 卫星遥感图像,图像大小均为512 pixel×512 pixel,如

图 6. 由QuickBird-2卫星获取的幅遥感图像。(a)海港;(b)植被;(c)道路;(d)建筑群

Fig. 6. Remote sensing images acquired by QuickBird-2 satellite. (a) Harbor; (b) vegetation; (c) road; (d) buildings

将所提方法得出的结果和常用的结构相似性(SSIM)和峰值信噪比(PSNR)的评价结果进行对比。由于遥感图像的最终接收者是人,因此主观评价结果对于遥感图像的评价尤为重要。为了分析所提方法与主观评价结果的关系,建立一个包含800幅遥感图像质量评分库,参与评分的观察者共22人,其中具有图像质量评价专业背景的人有2人,一般观察者有20人。按照主观评价方法中的国际电信联盟无线通信委员会(ITU-R)质量和损伤度量表,如

表 3. ITU-R质量和损伤度量表

Table 3. ITU-R quality and impairment scales

|

采用3种衡量算法性能的技术指标,即Spearman等级次序相关系数(SROCC)、Pearson线性相关系数(PLCC)和方均根误差(RMSE),来衡量所提方法和其他评价方法与主观评价值的一致性。由于这几种方法得出的质量评价值范围不同,因此需要根据评价结果的散点图采用Logistic 函数进行非线性拟合[17]。

选取PSNR、SSIM、特征相似度(FSIM)这3种具有代表性的评价方法作为参考指标进行性能比对。

所提方法与FSIM、SSIM和PSNR的拟合散点图如

表 4. 不同方法的性能比较

Table 4. Performance comparison of different methods

|

图 8. 所提方法与SSIM、PSNR和FSIM的拟合散点图。(a) SSIM;(b) PSNR;(c) FSIM

Fig. 8. Fitting scatter plot between proposed method and SSIM, PSNR, FSIM. (a) SSIM; (b) PSNR; (c) FSIM

选用的Quickbird-2遥感卫星图像能直观反映地物的真实颜色,适合人眼的观察习惯,分辨率较高,从成像机理上接近于自然图像。将所提方法应用在自然图像上进行测试。选用美国的德克萨斯大学奥斯汀分校图像和视频工程实验室发布的混合失真图像质量评分库(LIVEMD)进行实验。LIVEMD中的模糊噪声混合数据集中包含15幅原始参考图像和225幅失真图像。模糊和噪声失真分别分为三个等级,在同一模糊等级的图像上一次添加不同等级的噪声,共分为15个子类。数据集中每幅图像都有对应的平均主观得分差(DMOS),即人眼对无失真图像和有失真图像评价得分的差异,DMOS值越小,表示图像的质量越高。

实验结果如

表 5. LIVEMD数据集中不同方法的性能比较

Table 5. Performance comparison of different methods in LIVEMD database

|

图 9. LIVEMD数据集中不同评价方法的DMOS拟合曲线图。(a) SSIM;(b)所提方法;(c) PSNR;(d) FSIM

Fig. 9. Fitting curves of DMOS for different assessment methods in LIVEMD dataset. (a) SSIM; (b) proposed method; (c) PSNR; (d) FSIM

4 结论

利用深度学习的方法,省去手工设计特征的麻烦,设计出并行CNN的评价框架,结合人眼视觉特性,提出了一种同时存在模糊和噪声的遥感图像的质量评价方法,解决了只能评价单一失真类型的图像质量的困难。并且结合人眼视觉特性中的掩盖效应,加入感知加权因子,修正评价模型,使得遥感图像质量的评价结果更加符合主观评价结果。实验结果表明,该方法能有效地评价遥感图像的质量,所得评价结果符合人类视觉感知,与主观评价结果具有较好的一致性,能够对噪声和模糊两种失真同时存在的遥感图像进行有效的、准确的评价。

[1] 王俊琦, 张立国, 付天骄, 等. 基于骨架边缘提取的遥感图像清晰度评价方法[J]. 激光与光电子学进展, 2015, 52(9): 091002.

[2] Xia YT, Chen ZZ. Quality assessment for remote sensing images: Approaches and applications[C]∥IEEE International Conference on Systems, Man, and Cybernetics, October, 9-12, 2015, Kowloon, China. New York: IEEE, 2015: 1029- 1034.

[3] Sheikh HR, Bovik AC. A visual information fidelity approach to video quality assessment[C]∥International Workshop on Video Processing and Quality Metrics for Consumer Electronics, [S. l. : s. n.]2005: 23- 25.

[4] 苗莹, 易三莉, 贺建峰, 等. 结合梯度信息的特征相似性图像质量评估[J]. 中国图象图形学报, 2015, 20(6): 749-755.

[7] 邵宇, 孙富春, 李洪波. 基于视觉特性的无参考型遥感图像质量评价方法[J]. 清华大学学报(自然科学版), 2013, 53(4): 550-555.

Shao Y, Sun F C, Li H B. No-reference remote sensing image quality assessment method using visual properties[J]. Journal of Tsinghua University (Science and Technology), 2013, 53(4): 550-555.

[8] 张飞艳, 谢伟, 林立宇, 等. 基于小波域自然影像统计特性的无参考遥感影像质量评价[J]. 电子与信息学报, 2011, 33(11): 2742-2747.

[9] BareB, LiK, YanB, et al. An accurate deep convolutional neural networks model for no-reference image quality assessment[C]∥IEEE International Conference on Multimedia and Expo, July 10-14, 2017, Hong Kong, China. New York: IEEE, 2017: 1356- 1361.

[10] 李素梅, 常永莉, 段志成. 基于卷积神经网络的立体图像舒适度客观评价[J]. 光学学报, 2018, 38(6): 0610003.

[11] DengJ, DongW, SocherR, et al. ImageNet: A large-scale hierarchical image database[C]∥ IEEE Conference on Computer Vision and Pattern Recognition, June 20-25, 2009, Miami, FL, USA. New York: IEEE, 2009: 248- 255.

[13] SimonyanK, Zisserman A. Very deep convolutional networks for large-scale image recognition[EB/OL]. ( 2015-04-13)[2018-08-06]. https:∥arxiv.org/abs/1409. 1556.

[14] YosinskiJ, CluneJ, BengioY, et al. How transferable are features in deep neural networks?[EB/OL]∥International Conference on Neural Information Processing Systems, December 8-13, 2014, Montreal, Canada,2014: 3320-3328.[2018-08-06]. https:∥arxiv.org/abs/1411. 1792.

[15] 高振宇, 杨晓梅, 龚剑明, 等. 图像复杂度描述方法研究[J]. 中国图象图形学报, 2010, 15(1): 129-135.

[16] 魏政刚, 袁杰辉, 蔡元龙. 图象质量评价方法的历史、现状和未来[J]. 中国图象图形学报: A辑, 1998, 3(5): 386-389.

Article Outline

刘迪, 李迎春. 基于深度学习和人眼视觉系统的遥感图像质量评价[J]. 激光与光电子学进展, 2019, 56(6): 061101. Di Liu, Yingchun Li. Quality Assessment of Remote Sensing Images Based on Deep Learning and Human Visual System[J]. Laser & Optoelectronics Progress, 2019, 56(6): 061101.