基于在线检测和尺度自适应的相关滤波跟踪  下载: 1163次

下载: 1163次

1 引言

目标跟踪是指给出视频中目标的初始状态(如位置和大小等),并在后续序列中对目标的位置状态进行检测标识[1]。作为计算机视觉的重要研究课题,目标跟踪广泛应用于智能交通、视频监控和人机交互等领域[2]。近年来,研究者们在目标跟踪算法的研究方面取得了很大进展,但仍面临着诸多挑战,例如复杂背景、尺度变化和目标遮挡等。

根据目标的表观建模方式,可将目标跟踪算法模型分为两类[1]:产生式模型和判别式模型。产生式模型是对目标进行建模,搜索与之匹配度最高的候选区域进行跟踪;判别式模型基于检测判别机制,通过在线更新分类模型来实现目标的定位跟踪。随着机器学习等领域技术的发展,目前多数学者主要研究判别式跟踪算法[1]。其中,相关滤波(CF)跟踪模型以其较好的跟踪性能和较高的计算效率,成为当前目标跟踪领域的研究热点之一[3]。该模型主要有两个优势:1)通过对样本的循环密集采样,可实现对有限训练数据的扩展;2)采用循环相关和快速傅里叶变换,可有效减小训练和检测的运算量[3]。因此,相关滤波跟踪模型具有训练样本稀少且实时性强的特点,更适用于跟踪领域。Bolme等[4]提出的最小输出平方误差和相关滤波跟踪(MOSSE)算法将相关滤波思想引入跟踪领域,跟踪速度可达数百帧每秒。Henriques等[5]通过训练正则化最小二乘(RLS)分类器进行跟踪判定,之后他们又提取目标的方向梯度直方图(HOG)特征并建立了多通道特征融合模型[6],取得了较好的跟踪效果。Danelljan等[7]将颜色属性(CN)信息进行主成分分析(PCA)降维与灰度特征叠加,得到了更加精确、稳健的目标表观模型。Qi等[8]充分利用卷积神经网络(CNN)层级所抽取的特征建立多个弱相关滤波跟踪器,并采用自适应对冲思想将多个弱跟踪器整合成强跟踪器。但上述算法[4-8]存在两个问题:1)采用固定尺度的滤波模板,不能适应目标尺度变化;2)在目标遮挡后,采用固定的学习机制会导致误差累积,引起跟踪漂移。为解决尺度变化问题,Danelljan等[9-10]采用尺度金字塔思想,但该方法存在两个问题:1)该策略以目标原始大小为中心层,向上下层进行权重递减叠加,当目标尺度发生变化时,固定的权重叠加会导致真实目标尺度响应的减弱;2)各层间具有一定的间隔,由金字塔对应层直接得到目标尺度,会出现估计偏差较大的问题。针对遮挡问题,Ma等[11]根据目标回归CF跟踪模型的响应值进行遮挡判断,但该过程易受目标表观变化的干扰。

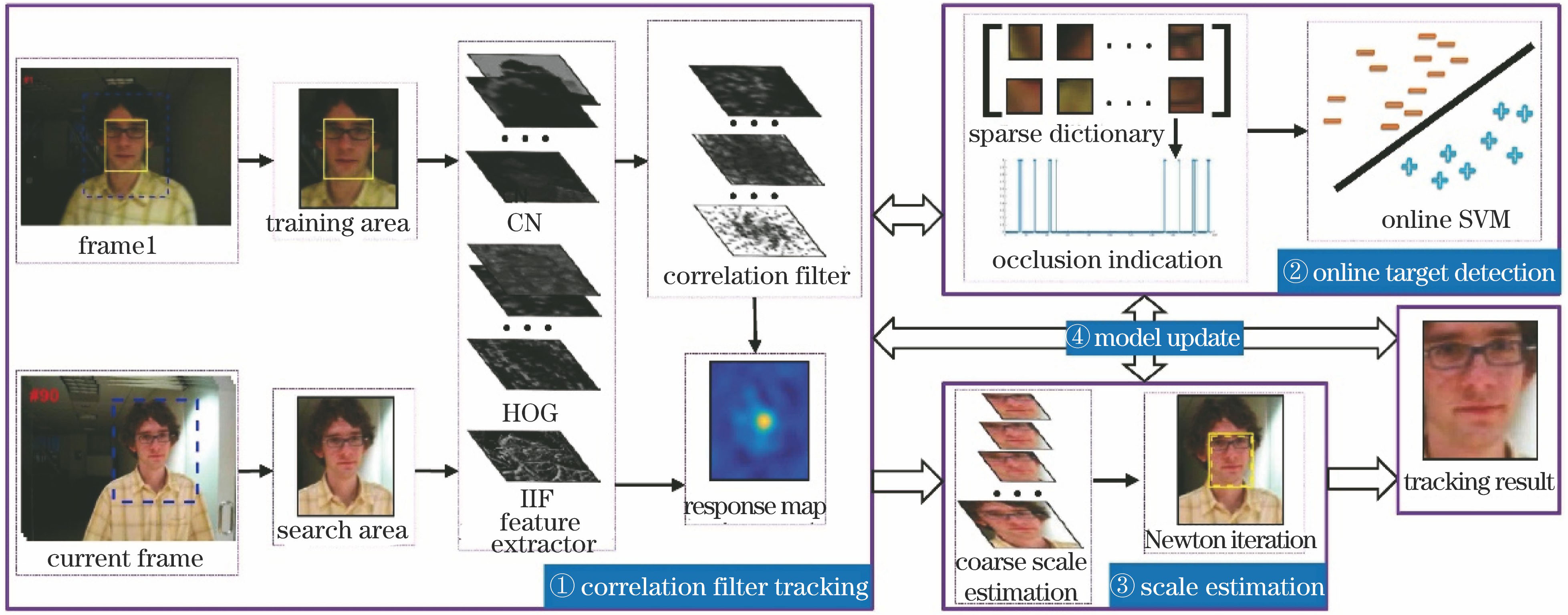

为增强CF跟踪模型对遮挡及目标尺度变化的稳健性,本文在相关滤波跟踪框架下提出基于在线检测和尺度自适应的相关滤波跟踪算法,主要开展了以下4个方面的工作:1)将HOG特征、CN特征和光照不变特征(IIF)[12]进行融合,以增强CF跟踪模型目标表征的精确性;2)提出一种在线检测机制,联合目标的局部稀疏表示模型[13]和在线支持向量机(SVM)模型[12,14],实现了目标遮挡的检测与遮挡目标的重定位;3)给出一种“由粗到精”的尺度目标估计方法,解决了尺度金字塔策略中权重配比和尺度估计不精确的问题;4)采用均衡学习策略,固定更新相关滤波系数以适应目标表观变化,根据跟踪结果的可信度保守更新稀疏表示字典和SVM检测器,以保留对目标的长时记忆,从而提高算法的适应性。

2 算法描述

所提算法主要分为4个阶段:1)采用相关滤波模型对目标进行跟踪定位;2)针对遮挡问题对目标进行在线检测;3)针对尺度变化问题对目标进行尺度估计;4)对各模块进行更新。算法框架图如

2.1 基于多特征融合的相关滤波跟踪器

在CF跟踪模型中,算法的目标是从训练样本

设训练区域

式中

式中F-1表示傅里叶逆变换,☉表示哈达玛积(对应元素相乘)。

较早的相关滤波算法,如基于检测的循环结构核跟踪算法(CSK)[5],通常采用灰度特征,故图像的噪声干扰会对跟踪性能产生较大的影响。核相关滤波的运算基于点乘和范数。根据DFT的线性特征,只需将各特征通道进行求和运算,对跟踪速度的影响很小[6]。假设特征通道数为

式中

2.2 在线目标检测机制

有效的抗遮挡机制是设计跟踪器时需要考虑的重要因素。对于相关滤波跟踪器,在目标被遮挡时,如果持续进行模板更新,会产生误差累积,当遮挡逐步消除后,则很容易误判目标。为此,提出一种在线检测机制,具体方法为:首先将当前帧相关滤波的跟踪结果输入稀疏模型;然后根据重构残差来判别是否发生遮挡及遮挡的严重程度,若遮挡严重,则根据保守更新的在线SVM进行目标再判定;最后通过计算新判定结果的遮挡指示值进行目标重选定。

稀疏表示跟踪模型是将当前的跟踪结果在基字典子空间进行映射,得到目标的稀疏表示。局部的稀疏表示跟踪模型能更好地捕获目标的表观变化,在遮挡序列集上性能更佳[16]。采用目标的原始像素进行局部表示,双线性插值后变为固定目标模板,再在目标模板上进行重叠掩模得到

式中

式中

通过训练保守的在线SVM模型来实现遮挡目标的再检测。在目标位置附近以目标真实大小的窗口滑动采集样本,提取阶梯采样特征[12]后进行在线SVM训练。假设给定的训练数据集

式中

2.3 由粗至精的目标尺度估计

在跟踪中,保持跟踪标识框大小不变,则目标尺度变小会引入背景干扰,目标尺度变大会导致目标信息缺失。因此,实现目标尺度自适应是进行稳定跟踪的重要条件。基于尺度金字塔策略[9]提出了一种由粗至精的尺度估计方法,主要改进有:1)调整尺度窗函数,增加了尺度预估计的准确性;2)在置信图频域引入牛顿迭代法,提高了尺度估计的精细程度。

以原始目标为中心,采集一系列尺度变化的子图,通过双线性插值将其变为相同尺度,提取HOG特征叠加窗函数后进行尺度相关滤波器学习。假设上一帧的目标大小

式中

式中+1表示尺度变化呈变大趋势,-1表示尺度变化呈变小趋势,0表示尺度不变。由此得到检测样本

将(9)式得到的检测样本代入(2)式可得尺度响应置信图

若

尺度参数

由此可得到当前目标的精确尺度为

2.4 基于均衡策略的模型更新

在序列中,视频场景及目标自身是复杂且不断变化的,如果跟踪器在序列第一帧建立目标的表观模型后不再改变,显然不能适应目标的表观变化,最终会导致跟踪失败,因此用最新的目标表观数据对模型进行更新是很有必要的。如果引入的更新样本有误差,会使更新后的模型存在偏差,引起跟踪漂移,同样会导致跟踪失败。鉴于上述原因,采用一种均衡模型更新策略:对相关滤波模型采用持续更新方式,以适应目标表观变化;对稀疏表示模型和SVM检测器采用保守更新方式,以保持目标的长时记忆。

符号

尺度金字塔滤波器和目标分块滤波器均采用(12)式的更新机制。由第2.2节的分析可知,目标遮挡值

式中

式中

2.5 算法实现

首先进行各模块初始化,然后进行位置检测和尺度估计,最后对各模块进行更新。具体步骤如下:

1) 输入。视频序列和首帧的目标位置

2) 输出。序列中各帧的目标位置

3) 初始化阶段。在训练区域输入相关滤波跟踪模型,由(1)式得到滤波器系数

4) 跟踪阶段

for

∥位置检测

在跟踪位置

利用

if

根据

根据

if

end

end

∥尺度估计

根据

根据

根据(10)式和

∥模型更新

根据(12)式对各相关滤波模块的系数和模板进行更新;

根据

if

提取

else

保持原模型参数不变;

end

end

3 实验结果及讨论

设计了两个针对性实验和一个综合性实验对算法的有效性进行评估:1)对算法的抗遮挡性能进行对比测试;2)对算法的尺度适应性进行对比测试;3)与现阶段性能较好的跟踪算法进行综合实验对比。实验所用对比算法均采用作者公开的源码设置,测试序列均来自标准数据集Benchmark[16],评价标准采用文献[ 16]所提的指标:中心位置误差(CLE)、距离精度(DP)和成功率(SR)。CLE指跟踪结果位置与目标基准位置之间的欧氏距离,单位为pixel;DP是CLE小于某个阈值(通常为20 pixel)[16]的帧数占序列总帧数的百分比;当重叠率大于给定阈值(通常为50%)时,认为该帧跟踪成功;SR表示跟踪成功帧数与总帧数的比率。

3.1 实验环境及参数

实验环境为:CPU型号为3.60 GHz Intel(R) Core(TM) i7,内存为16.0 GB,操作系统为Windows 7 64 bit,软件平台为Matlab R2014b。基于实验测试分析,并参考文献[

9,12-13],将具体参数设置如下:相关滤波跟踪器中,训练检测区域为目标大小的2.5倍,HOG特征的元胞大小为4 pixel×4 pixel,统计梯度方向数为9,正则化参数

目标遮挡阈值是一个重要参数,关系到在线检测机制的目标遮挡判别,对算法的跟踪位置精确度和运算速度影响较大。选用20组具有遮挡属性的标准序列(basketball,carscale,coke,david,david3,dudek,doll,faceocc1,faceocc2,football,freeman4,jogging-1,jogging-2,skating1,lemming,tiger2,walking2,woman,walking,subway)进行测试,得到算法在不同目标遮挡阈值下的平均中心位置误差和平均运算速度,结果如

图 3. 目标遮挡阈值对跟踪性能的影响。(a)平均中心位置误差;(b)平均运算速度

Fig. 3. Influence of target occlusion threshold on tracking performance. (a) Average center location error; (b) average operating speed

3.2 遮挡检测的性能测试

为验证所提算法的性能,选择3种具有代表性的抗遮挡算法进行对比,包括基于相关滤波的遮挡算法LCT[11]、自适应结构稀疏表示模型ALSA[17]和核化结构SVM算法Struck[18],并选取了4组典型的遮挡序列tiger2、lemming、walking2和faceocc2进行测试。

图 4. 4种算法对4组遮挡序列的跟踪结果。(a) Lemming; (b) walking2; (c) tiger2; (d) faceocc2

Fig. 4. Tracking results of four occluded sequences with four algorithms. (a) Lemming; (b) walking2; (c) tiger2; (d) faceocc2

图 5. 4种算法在4组遮挡序列的中心位置误差。(a) Lemming; (b) walking2; (c) tiger2; (d) faceocc2

Fig. 5. Center location error of four occluded sequences with four algorithms. (a) Lemming; (b) walking2; (c) tiger2; (d) faceocc2

3.3 尺度自适应性能测试

根据跟踪尺度变化的准确性对所提算法的性能进行验证,针对性地选择3种尺度自适应算法进行对比:基于金字塔策略的相关算法DSST[9]、检测跟踪算法TLD[19]和正向稀疏表示模型L1APG[20],用于测试的4组尺度变化序列为trellis、girl、walking和freeman1。跟踪面积[21]是指算法跟踪区域的面积,跟踪面积与目标真实面积之间的差值反映了算法的尺度适应性。4种算法在4组尺度变化序列的面积误差结果如

图 6. 4种算法对4组尺度变化序列的面积误差结果。(a) Trellis; (b) girl; (c) walking; (d) freeman1

Fig. 6. Area error results of four scale changing sequences with four algorithms. (a) Trellis; (b) girl; (c) walking; (d) freeman1

3.4 与其他稳健跟踪算法的实验比较

为进一步更为全面地评估所提算法的性能,选取了当前主流的算法进行对比,主要包括两类:1)相关滤波算法,KCF[6]、SAMF[10]、Staple[22]和HDT[8];2)其他代表性算法,双线性结构SVM算法DLSSVM[23]、多专家联合模型MEEM[12]和稀疏协作模型SCM[13]。为了便于对比,

表 1. 5种相关滤波跟踪模型比较

Table 1. Comparison of five correlation filter tracking models

|

图 7. 8种算法的距离精度和成功率曲线图。(a)整体性能(50);(b)遮挡(29);(c)尺度变化(27);(d)光照变化(25);(e)复杂背景(21)

Fig. 7. Curves of distance precision and success rate of eight algorithms. (a) Overall performance (50); (b) occlusion (29); (c) scale variation (27); (d) illumination variation (25); (e) complex background (21)

标准数据集Benchmark中光照变化子集共有25组序列,这里对

图 8. 8种算法对2组典型光照变化序列的跟踪结果。(a) Shaking; (b) soccer

Fig. 8. Tracking results of two typical illumination variant sequences with eight algorithms. (a) Shaking; (b) soccer

表 2. 8种跟踪算法的平均运算速度

Table 2. Average operating speed of eight tracking algorithms

|

4 结论

提出了一种基于在线检测和尺度自适应的相关滤波跟踪算法,通过特征融合方法实现了特征间的有效互补,提高了目标表征的准确性。设计了在线检测机制和由粗至精的尺度估计方法,并采用均衡策略进行模型更新,实现了复杂场景下对目标的稳定跟踪。通过对两个针对性实验和一个综合性实验进行验证,结果表明,与其他算法相比,所提算法对光照变化、遮挡和目标尺度变化等场景具有更强的稳健性。

[2] 赵高鹏, 沈玉鹏, 王建宇. 基于核循环结构的自适应特征融合目标跟踪[J]. 光学学报, 2017, 37(8): 0815001.

赵高鹏, 沈玉鹏, 王建宇. 基于核循环结构的自适应特征融合目标跟踪[J]. 光学学报, 2017, 37(8): 0815001.

[4] Bolme DS, Beveridge JR, Draper BA, et al. Visual object tracking using adaptive correlation filters[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2010: 2544- 2550.

Bolme DS, Beveridge JR, Draper BA, et al. Visual object tracking using adaptive correlation filters[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2010: 2544- 2550.

[5] Henriques JF, CaseiroR, MartinsP, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C]∥Proceedings of European Conference on Computer Vision, 2012: 702- 715.

Henriques JF, CaseiroR, MartinsP, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C]∥Proceedings of European Conference on Computer Vision, 2012: 702- 715.

[7] DanelljanM, Khan FS, FelsbergM, et al. Adaptive color attributes for real-time visual tracking[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2014: 1090- 1097.

DanelljanM, Khan FS, FelsbergM, et al. Adaptive color attributes for real-time visual tracking[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2014: 1090- 1097.

[8] QiY, ZhangS, QinL, et al. Hedged deep tracking[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2016: 4303- 4311.

QiY, ZhangS, QinL, et al. Hedged deep tracking[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2016: 4303- 4311.

[9] DanelljanM, HagerG, Khan FS, et al. Accurate scale estimation for robust visual tracking[C]∥Proceedings of British Machine Vision Conference, 2014: 1- 11.

DanelljanM, HagerG, Khan FS, et al. Accurate scale estimation for robust visual tracking[C]∥Proceedings of British Machine Vision Conference, 2014: 1- 11.

[10] LiY, Zhu JK. A scale adaptive kernel correlation filter tracker with feature integration[C]∥Proceedings of European Conference on Computer Vision, 2014: 254- 265.

LiY, Zhu JK. A scale adaptive kernel correlation filter tracker with feature integration[C]∥Proceedings of European Conference on Computer Vision, 2014: 254- 265.

[11] MaC, Yang XK, Zhang CY, et al. Long-term correlation tracking[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2015: 5388- 5396.

MaC, Yang XK, Zhang CY, et al. Long-term correlation tracking[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2015: 5388- 5396.

[12] ZhangJ, MaS, SclaroffS. MEEM: Robust tracking via multiple experts using entropy minimization[C]∥Proceedings of European Conference on Computer Vision, 2014: 188- 203.

ZhangJ, MaS, SclaroffS. MEEM: Robust tracking via multiple experts using entropy minimization[C]∥Proceedings of European Conference on Computer Vision, 2014: 188- 203.

[15] ScholkopfB, Smola AJ. Learning with kernels: Support vector machines, regularization, optimization, and beyond[M]. London: MIT Press, 2002: 405- 423.

ScholkopfB, Smola AJ. Learning with kernels: Support vector machines, regularization, optimization, and beyond[M]. London: MIT Press, 2002: 405- 423.

[16] WuY, LimJ, Yang MH. Online object tracking: A benchmark[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2013: 2411- 2418.

WuY, LimJ, Yang MH. Online object tracking: A benchmark[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2013: 2411- 2418.

[17] JiaX, Lu HC, Yang MH. Visual tracking via adaptive structural local sparse appearance model[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2012: 1822- 1829.

JiaX, Lu HC, Yang MH. Visual tracking via adaptive structural local sparse appearance model[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2012: 1822- 1829.

[18] HareS, SaffariA, Torr P H S. Struck: Structured output tracking with kernels[C]∥Proceedings of IEEE International Conference on Computer Vision, 2011: 263- 270.

HareS, SaffariA, Torr P H S. Struck: Structured output tracking with kernels[C]∥Proceedings of IEEE International Conference on Computer Vision, 2011: 263- 270.

[20] Bao CL, WuY, Ling HB, et al. Real time robust L1 tracker using accelerated proximal gradient approach[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2012: 1830- 1837.

Bao CL, WuY, Ling HB, et al. Real time robust L1 tracker using accelerated proximal gradient approach[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2012: 1830- 1837.

[21] 罗会兰, 杜芳芳, 孔繁胜. 像素点特征加权的尺度自适应跟踪算法[J]. 通信学报, 2015, 36(10): 200-211.

罗会兰, 杜芳芳, 孔繁胜. 像素点特征加权的尺度自适应跟踪算法[J]. 通信学报, 2015, 36(10): 200-211.

Luo H L, Du F F, Kong F S. Pixel feature-weighted scale-adaptive object tracking algorithm[J]. Journal on Communications, 2015, 36(10): 200-211.

[22] BertinettoL, ValmadreJ, GolodetzS, et al. Staple: Complementary learners for real-time tracking[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2016: 1401- 1409.

BertinettoL, ValmadreJ, GolodetzS, et al. Staple: Complementary learners for real-time tracking[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2016: 1401- 1409.

[23] Ning JF, Yang JM, Jiang SJ, et al. Object tracking via dual linear structured SVM and explicit feature map[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2016: 4266- 4274.

Ning JF, Yang JM, Jiang SJ, et al. Object tracking via dual linear structured SVM and explicit feature map[C]∥Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, 2016: 4266- 4274.

Article Outline

王艳川, 黄海, 李邵梅, 高超. 基于在线检测和尺度自适应的相关滤波跟踪[J]. 光学学报, 2018, 38(2): 0215002. Yanchuan Wang, Hai Huang, Shaomei Li, Chao Gao. Correlation Filter Tracking Based on Online Detection and Scale-Adaption[J]. Acta Optica Sinica, 2018, 38(2): 0215002.