加速分割特征优化的图像配准方法  下载: 962次

下载: 962次

1 引言

图像配准是指对不同传感器、视角、时间、光照条件情况下获取的两张或多张图像确定图像间的位置关系的过程,其目的是将待配准图像通过空间几何变换使其与参考图像对齐[1]。遥感影像配准是影像信息提取与处理中最基本的问题之一,是实现同一场景多幅遥感影像分析和处理的基础,是遥感影像融合、遥感影像拼接、三维重建、变化检测等应用中的关键步骤之一。当时间、视角、光照等发生变化时,同一区域拍摄的图像会存在不同程度的几何形变,为了将一组连续拍摄的遥感图像拼接起来,首先需要对重叠区域的图像进行配准[2]。

图像配准方法一般分为基于灰度的配准方法、基于特征的配准方法和基于变换域的配准方法[3]。基于特征的配准方法由于对图像的旋转、缩放、尺度变化等有较好的稳健性,应用最为广泛[4]。基于特征的配准算法主要有4个步骤:特征点检测、特征匹配、图像空间变换及图像重采样。其中,特征点检测与匹配是图像配准的核心步骤,图像匹配的好坏及其分布直接影响配准精度,建立稳定可靠的特征点匹配对应关系决定了配准精度及效率。目前基于特征的配准算法主要集中于尺度不变特征变换(SIFT)算法[5]、主成分分析(PCA)-SIFT算法[6]、加速稳健特征(SURF)算法[7]和以SIFT为基础进行改进的系列算法等,该类算法的配准精度高,对视角、时间、光照等变换具有较好的适应性,但存在特征描述符维数高、运算量大、计算时间长等缺点。由于遥感图像拼接过程需要处理的图像较多,为了提高图像间配准效率,一些学者提出了利用二进制字符串作为描述符的算法,如二进制稳健独立基本特征(BRIEF)算法[8]、快速特征点提取和描述的算法(ORB)[9]、二进制稳健不变的可扩展关键点(BRISK)[10]等算法。基于二进制描述符的算法较以SIFT系列算法在匹配效率上得到了很好的提升,计算效率是SIFT算法的两个数量级,但此类算法的稳健性低于以SIFT算法为基础的算法,误匹配率较高,且BRIEF、ORB算法采用随机点对选取方式,很大程度上影响算法的匹配精度。

为解决二进制描述符点对选取问题,本文引入视网膜特征点(FREAK)描述算法[11],利用空间自相关性理论,有效解决匹配特征点描述符随机点对选取带来的匹配精度低等问题。在点对采样过程中,基于空间自相关性对点对进行采样,即在中心区域采样点的密度最高,而离中心区域较远的区域,采样点的密度呈指数下降,且各采样点间存在一定的重叠有助于提高描述精度。兼顾配准算法的精度及效率两个方面,本文基于加速分割特征(FAST)检测算法,并通过构建尺度空间来实现尺度不变特征点检测方法;结合FREAK描述算法对特征点进行描述,通过计算其汉明距离来得到两幅图像的匹配点对,再结合随机一致性采样方法和最小二乘法计算图像间的变换关系,最后得到配准后的图像。

2 图像配准

2.1 特征点检测

FAST特征点检测算法[12],由于其高效的计算性能,目前已广泛应用于特征检测、图像配准、目标识别等领域。

FAST特征点检测算法通过检测候选像素点

式中:

如果圆周上的16个像素点中,存在连续多个像素点的灰度值均满足

从FAST整个检测算法可以看出,算法存在以下缺陷。

1) 由于FAST特征点检测算法没有考虑到尺度变化的情况,因此在图像尺度变化的情况下,特征点的检测精度不理想。

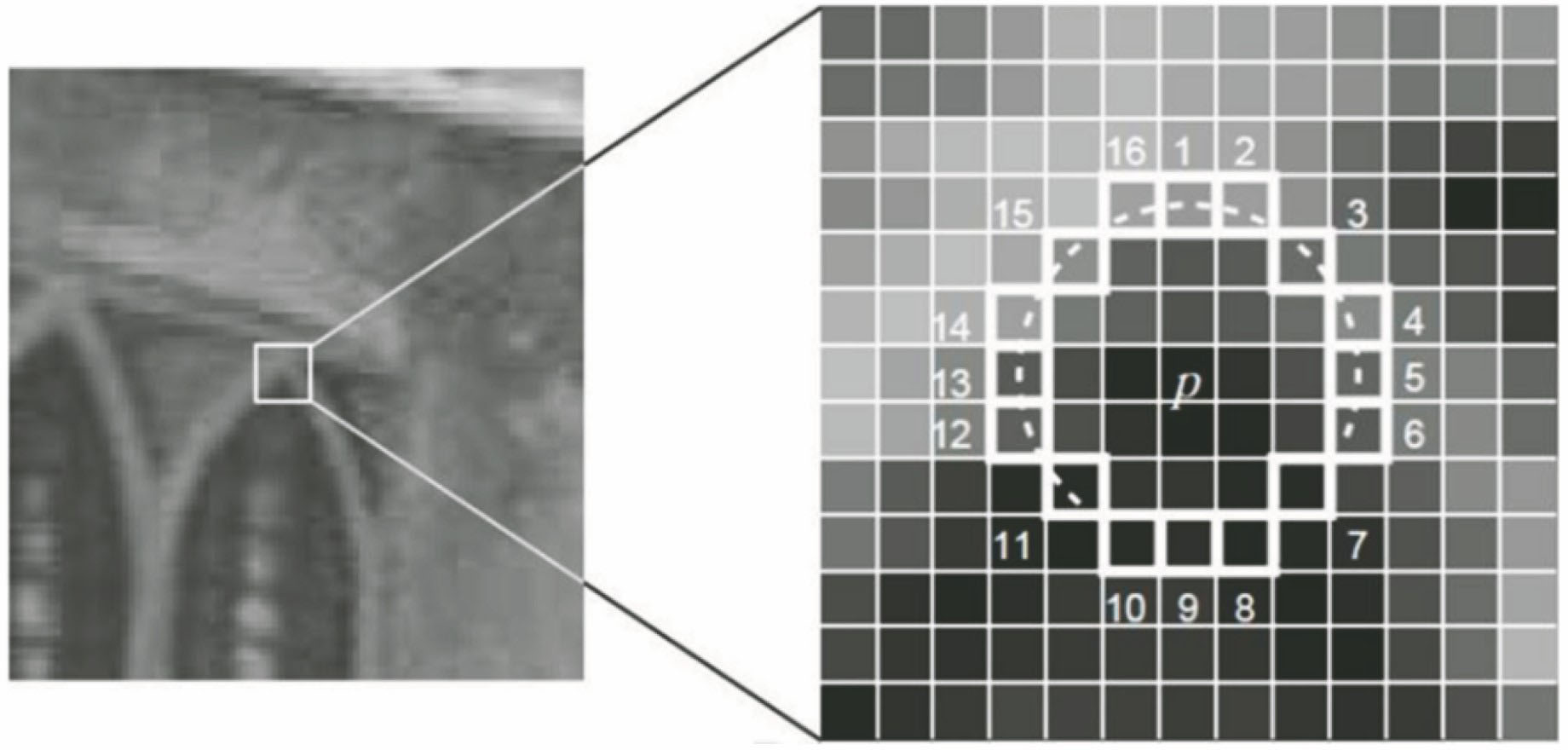

2) FAST检测算法对斜边缘的响应较强,容易检测过多的伪角点,如

图 2. 斜边缘伪角点检测。(a)边缘线;(b)点p的判定圆环;(c)点p的判定结果

Fig. 2. Skewed edge pseudo corner. (a) Edge; (b) decision circle of p; (c) detection result of p

基于此,为克服FAST在检测过程中的缺陷,本文结合Harris算子提出尺度不变性FAST检测算法。

2.1.1 基于Harris算子的特征点过滤

利用FAST算子对特征点进行提取后,会存在较强的边缘响应,而Harris算子[13]对边缘响应的处理较好,能够对提取后的特征点进行排序,并利用Harris算子对特征点进行过滤。其处理步骤如下:1)选用较小的阈值

2.1.2 基于FAST算子的尺度空间构建

FAST算子由于没有构建尺度空间,因此在尺度变化明显时,特征点的提取结果不稳定,重复率较低。为使FAST能够在尺度变化时也能够稳定地检测到特征点,通过构建图像高斯金字塔,并在此基础上采用FAST算子提取特征点。一般图像金字塔的构建方式是对原始图像通过降采样得到一组从上至下、由大到小的图像形成的塔状模型。每次图像降采样所得到的新图像为金字塔的一层(每层一张图像),每个金字塔共

式中(

先对图像进行金字塔构建,再对各层的图像分别进行特征点检测,最后在尺度空间中对特征点进行非极大值抑制的判定来选择极大值点。在离散空间中,检测到的极大值点不一定是真正的极大值点,因此,为提高特征点检测的稳定性,在连续的尺度空间中需要对探测的极大值点进行曲线拟合来达到子像素级精度。

2.2 特征描述

对特征点进行提取后,需要对特征点进行描述。FREAK描述符是一种采用二进制比特串来对特征点进行描述的算子,如

FREAK描述符特征点的具体采样过程如下。

1) 首先设定采样点的层数

2) 每个采样点在采样前为避免图像噪声,首先进行高斯平滑,高斯核的大小与采样点的同心圆的半径成正比。

3) 相邻采样点的范围(以采样点为中心,高斯核为半径的圆)具有重叠区域。冗余采样会使检测精度更高。

当采样点进行采样后,需要根据采样点对来对特征点进行描述。描述方法如下:

式中:

两个二进制比特串的相似性通过计算汉明距离的大小来判断,而汉明距离通过对两个二进制比特串进行异或运算得到,用

式中⊗为异或运算符,

FREAK算法对特征点间的最小汉明距离进行一一计算来获得图像间的匹配点对,这种方式导致匹配速度慢且误匹配严重,最终影响图像间的配准精度与效率。为此,基于双向匹配采用快速最近邻域搜索(FLANN)方法[14]对匹配点对进行搜索从而提高效率,并通过随机抽样一致性(RANSAC)[15]方法剔除误匹配点对。具体步骤如下。

1) 利用FLANN算法搜索特征点对间的最近邻点对与次近邻点对。原始图像中特征点

2) 通过计算匹配比率,得到初始匹配集。计算匹配比率

3) 为了更进一步精炼匹配对,采用RANSAC方法从初始匹配集中进行精筛选,获取最佳匹配点对。

4) 图像配准参数计算。利用单应性矩阵计算图像间的配准参数。

本文方法的整体思路如

图 5. 基于FAST和FREAK的图像配准框图

Fig. 5. Image registration frame diagram of FAST combined with FREAK

3 实验与分析

采用改进的FAST算法并结合FREAK描述子对两幅待配准图像进行特征点检测和特征匹配,并基于单应矩阵变换计算图像间的配准参数。为了验证本文算法的有效性,利用卫星遥感图像进行图像配准性能评价。实验在VS2010和OpenCV2.4.8平台环境下予以实现,并将本文算法与SIFT算法、二进制BRIEF算法和原始FREAK算法进行对比。

3.1 配准精度分析

平面的单应性是指一个平面到另一平面的投影映射[16],因此为了表达图像间的投影变换关系,通常需要计算图像间的单应性矩阵。如果能找到稳定的4对匹配点,则可以计算单应性矩阵。但两幅图像在匹配过程中,总存在误匹配点,因此在计算单应性矩阵的过程中,通常需要找出多于4对的匹配点,因此采用RANSAC方法来计算。为验证SIFT算法、BRIEF算法、原始FREAK算法和本文算法单应矩阵计算的准确性,采用重投影误差[17]的方式进行测试和对比。对单应矩阵计算两幅图像的重投影误差方法如下,假设两幅图像中的对应匹配点满足:

式中

式中

重投影误差是指投影点的理论值与图像上的测量点之间的误差,测量点并非绝对精确,因此,可以根据重投影误差的大小来评判图像配准的精度。选用具有旋转变换的1000×1000的一对图像,根据重投影误差计算方法计算SIFT、BRIEF、原始FREAK和本文算法的所有匹配点对间的重投影误差。由于每个算法得到的匹配点对不同,匹配点对数量也有差异,因此采用平均重投影误差来比较4种方法的误差结果,如

本文方法的平均重投影误差最小,误差范围在1 pixel内,由于BRIEF和FREAK算法在特征点检测阶段分别只用了原始的FAST算法,存在大量的误匹配点,且在尺度变换与旋转变换的情况下,特征点的误差检测较大,因此,会导致配准过程中的重投影误差较大。本文算法的配准精度与SIFT算法的配准精度相当,但是效率优于SIFT算法。

表 1. 单应矩阵重投影误差

Table 1. Reprojection error of homography pixel

| |||||||||||||||||||||||||||||||||||||||

3.2 配准时间对比

表 2. 配准各阶段的运行时间

Table 2. Running time of each phase of registrationms

|

3.3 实验结果

为了验证本文算法的适应范围,实验选取4组航拍图像,分别具有光照变换、尺度变换、旋转变换以及视角变换。

4 结论

提出了一种改进的FAST算法并结合FREAK描述子的快速图像配准方法。方法解决了FAST算法中存在的边缘伪角点及尺度问题,采用FREAK特征描述符算子对特征点进行描述,利用FLANN算法实现二进制特征匹配的快速搜索,并基于单应矩阵变换计算图像间的配准参数,最后将本文方法应用于航拍图像进行全景拼接。实验分析表明,本文方法在配准速度、准确性、稳定性等方面具有一定的优势。但算法仍然有一定的局限性,比如在视角变换与尺度变换情况下,提取的特征点匹配对的数量相对较少,因此,算法在保证运算效率和提取精度的基础上,还需要进一步完善以适应于各种不同场景的变换。

[1] 王灿进, 孙涛, 王锐, 等. 基于彩色二进制局部不变特征的图像配准[J]. 中国激光, 2015, 42(1): 0109001.

[2] 杨飒, 夏明华, 郑志硕. 基于多项式确定性矩阵的SIFT医学图像配准算法[J]. 激光与光电子学进展, 2016, 53(8): 081002.

[3] 杨飒, 杨春玲. 基于压缩感知与尺度不变特征变换的图像配准算法[J]. 光学学报, 2014, 34(11): 1110001.

[4] 董强, 刘晶红, 王超, 等. 基于改进BRISK的图像拼接算法[J]. 电子与信息学报, 2017, 39(2): 444-450.

[6] KeY, SukthankarR. PCA-SIFT: a more distinctive representation for local image descriptors[C]∥Proceedings of the 2004 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2004.

[8] CalonderM, LepetitV, StrechaC, et al. BRIEF: binary robust independent elementary features[C]∥Proceedings of the 11 th European Conference on Computer Vision , 2010: 778- 792.

[9] RubleeE, RabaudV, KonoligeK, et al. ORB: an efficient alternative to SIFT or SURF[C]∥Proceedings of 2011 International Conference on Computer Vision, 2011: 2564- 2571.

[10] LeuteneggerS, ChliM, Siegwart RY. BRISK: binary robust invariant scalable keypoints[C]∥Proceedings of 2011 International Conference on Computer Vision, 2011: 2548- 2555.

[11] AlahiA, OrtizR, VandergheynstP. FREAK: fast retina keypoint[C]∥Proceedings of 2012 IEEE Conference on Computer Vision and Pattern Recognition, 2012: 510- 517.

[12] RostenE, DrummondT. Machine learning for high-speed corner detection[C]∥Proceedings of 9 th European Conference on Computer Vision , 2006: 430- 443.

[13] Harris CG, Stephens M J. A combined corner and edge detector[C]∥Proceedings of the 4 th Alvey Vision Conference , 1998, 15∶50.

[14] Sattler T, Leibe B, Kobbelt L. Efficient & effective prioritized matching for large-scale image-based localization[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2017, 39(9): 1744-1756.

[16] 邹朋朋, 张滋黎, 王平, 等. 基于共线向量与平面单应性的双目相机标定方法[J]. 光学学报, 2017, 37(11): 1115006.

李佳, 段平, 姚永祥, 程峰. 加速分割特征优化的图像配准方法[J]. 激光与光电子学进展, 2019, 56(1): 011006. Jia Li, Ping Duan, Yongxiang Yao, Feng Cheng. Image Registration Method Based on Accelerated Segmentation Feature Optimization[J]. Laser & Optoelectronics Progress, 2019, 56(1): 011006.