结构光三维传感器测量网相关技术  下载: 644次

下载: 644次

0 引 言

结构光三维测量与成像的理论与技术已取得快速发展,并被广泛应用于影视、游戏、虚拟现实、数字化博物馆、生产装配、工业检测、逆向工程、CAD建模制造等领域[1-3]。随着测量对象的复杂化和测量精度要求的不断提高,结构光三维测量与成像方法呈现的发展趋势:(1)尺度向大、小两级延伸,对象的拓扑、结构、材质趋于复杂多样化;(2)精度、速度要求不断提高;(3)方法向专业化、集成化发展;(4)网络多站式几何量测量、面向测量任务的组合测量方法呈现互补融合的态势;(5)高逼真度、高精度、高密度、高效三维测量与成像获取手段已成为未来发展趋势。

对于具有较大尺寸且形状、材质较复杂类物体,快速获取其高精度、高密度、高保真度三维信息具有一定的挑战性。以人体三维信息获取为例,其困难主要体现在:(1)人体尺寸较大,为获取其高密度数据需分多视场测量;(2)人体较难保持长时间静止不动,需要快速测量,而多视场测量会消耗更多时间;(3)人体各部位形状差异较大,各部位对测量数据的需求存在差异,例如脸部细节较多,往往需较高密度数据,而身体部位细节较少无需较高密度数据;(4)此外,类如头发类物体,其几何形状拓扑非常精细复杂,这一直是光学三维测量成像与数字化建模的难点[4-5]。文中将重点介绍多节点三维传感器测量网络相关技术,以解决较大尺寸物体的快速、高精度、高密度、高保真度三维信息获取与建模问题,其涉及到结构光三维测量基本原理介绍,以及多节点三维传感器测量网络的构建、标定及数据建模等相关技术。

1 结构光三维测量与成像相关技术

结构光三维测量系统通常可分为单目(单个相机)系统和双目(两个相机)系统,同时包括一个结构光产生装置,该装置核心作用是为三维测量系统提供主动结构编码照明。结构光编码方式主要有黑白条纹编码、彩色条纹编码、散斑编码、相位编码等[6-9],其中相位编码具有空间连续性好、受环境光影响小的优势,其测量数据的精度和密度较好。本文后续介绍的测量网中单节点三维传感器采用相位编码方式,主要涉及两个关键技术环节。

1.1 条纹分析与相位重建(单幅 vs. 多幅)

条纹分析与相位重建目标是获取高精度的相位编码信息,其通常以条纹图案呈现,结构照明装置投射标准正弦光到物体表面,相机继而采集经物体表面调制的变形条纹图像,由条纹图像分析解调出包含物体深度信息的相位编码信息。按照所使用条纹图像的幅数,相位重建可分为单幅和多幅两类方法。单幅相位重建通常对条纹图进行空间变换,例如傅里叶变换[10-11],小波变换[12-13],希尔伯特变换[14]等,进而筛选出包含相位信息的特征区域。这类方法最显著的优势是适用于动态三维成像与测量,但面对深度不连续、表面纹理复杂及曲率变化较大的物体时精度和鲁棒性往往难以满足要求,限制了该类方法的应用范围。多幅相位重建技术是在时间维度上对相位信息进行编解码,例如被广泛应用的相移法[15-16]。多幅相位重建对测量环境具有较好的鲁棒性,且重建精度高,然而仅适用于静态物体。为突破多幅相位重建的速度限制,通过多波长复用将时间维信号编码在相机的不同颜色通道上,实现了基于彩色编码的快速三维成像与测量[17-18]。然而,彩色编码各通道间存在颜色串扰、响应不均匀以及对彩色纹理表面不鲁棒等问题。目前相位重建与条纹分析的一个研究趋势是利用软硬件对结构光进行调制,例如二值离焦投影[19-20]、阵列投影[21]和声光调制[22]等,从而大幅度提升投影速率,实现高速三维成像与测量。但离焦投影或激光散斑降低了条纹图像的信噪比,使得相位重建精度较低。从20世纪80年代至今,同时兼顾高精度、高速度和高鲁棒性的相位重建和条纹分析仍具有一定挑战性。

1.2 三维重建与系统标定(方法和模型)

相位信息被物体的深度信息所调制,因此,基于相位编码的三维重建方法可分为两类:一类是进一步从相位信息中解调出物体的深度信息,即相位-深度映射[23-28];另一类是将相位信息作为编码特征点进行三维重建,即立体视觉[29-33]。对于一个三维成像与测量系统,相位与深度之间存在特定的映射关系,通过系统标定确定相位-深度映射系数之后,相位可以直接映射到深度,实现高效、高精度的三维重建。这种高效的转换取决于系统的几何结构,比如使用参考面,光轴共面或垂直于参考面等,而且需要使用精密位移台或量块获取一系列深度值进行标定,这些因素限制着这类方法的实际应用。相反,根据光路的可逆性,结构照明装置可视为逆向相机,与实际相机组成一个双(多)目成像系统,并且相位信息提供了同名点的编码特征,利用立体视觉即可实现三维重建。立体视觉的系统结构具有更多的自由度,并且可以借助相机模型进行灵活、有效的系统建模和标定。然而,立体视觉需要耗费较大的时间代价进行对应点搜索,三维重建效率明显低于相位-深度映射。近几年来,研究人员提出了一些相位-深度映射和立体视觉相结合的方法[34-36],一方面在相位-深度映射中引入相机标定方法,另一方面在立体视觉中建立相位-深度(三维)映射模型,旨在实现高精度、高效和灵活的三维成像与测量。

2 多节点三维传感器测量网的构建

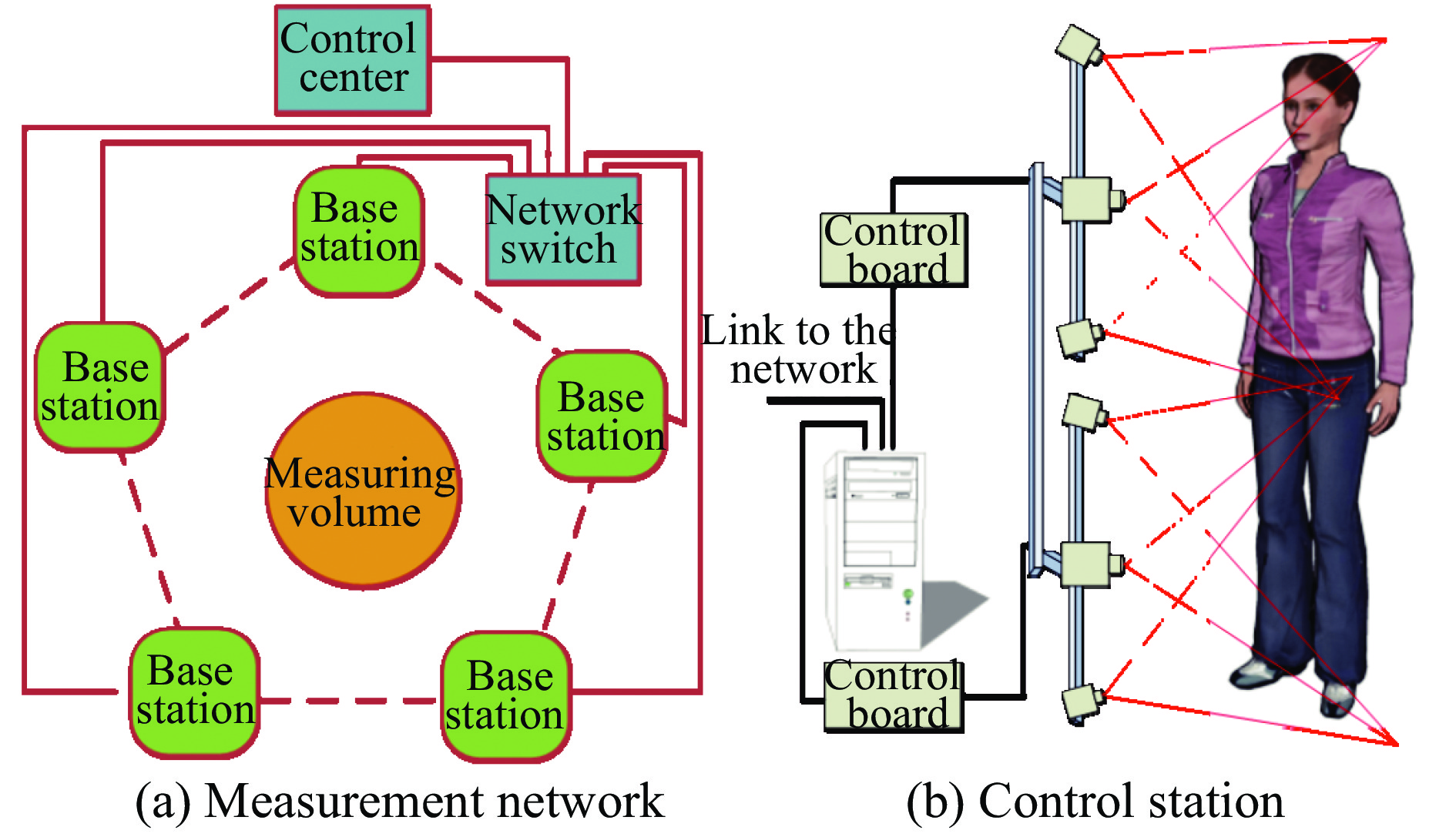

在测量尺寸较大、拓扑复杂的物体(如大尺寸薄壁件),或者对表面测量有时间要求(如人体测量)时,利用多个双目结构光三维传感器搭建多测量节点光学三维测量网能在一定测量空间内实现快速和自动化的全空间测量[37-40]。此节主要涉及测量网构建相关的两个关键问题:多节点测量网的结构设计和节点网络规划。

2.1 多节点三维传感器测量网的结构设计

该部分以组网便携性为指导,优化系统硬件结构设计,实现即插即用式节点扩展功能;进一步优化测量网络各节点三维传感器的工作时序,实现节点间结构光照明无串扰时同时序工作,有串扰时分时序工作;优化三维测量数据的传输模式,减少数据传输占整体测量时间的比重。

该测量网采用单节点三维传感器作为独立基站,由于基站调控的相互独立性,有利于整体系统调试和灵活扩展应用。同时建立控制中心,利用千兆网络实现基站和控制中心之间控制指令和测量数据的传输。

图 1. Schematic diagram of measurement network structure

Fig. 1. Schematic diagram of measurement network structure

为提升测量网络工作效率,一方面,提升单节点三维传感器采集效率,采用条纹投影采集一体化控制方案,实现条纹投影与相机采集的同步,开发的

2.2 多节点测量网的网络规划模型与优化算法

为了适应大尺寸、拓扑结构复杂物体的高精度三维彩色数据获取,充分考虑被测物体与测量网络的空间几何结构以及光学成像参数影响,需构建基于物体空间几何特征和表面反射特性关联优化的多节点三维传感器测量网络规划方案[41-43]。其中重点构建两个空间约束条件:工作空间约束,即节点三维传感器位置必落在整个工作区范围内;测量空间约束,即对任意测量点至少落在一个节点三维传感器测量范围内,如

2.2.1 三维传感器工作空间约束建模

文中结合实际情况,重点考虑三维传感器可见性、视场角、景深、投影仪约束、遮挡、禁止区域等约束条件,如

(1)可见性约束:物体表面上物点P的法向量与该点的视线方向向量点乘值小于0,则满足可见性,如

(2)视场角约束:受传感器面积和镜头焦距的限制,视觉传感器只能采集特定视角内的图像,该视场区域一般为四棱锥形,如

(3)景深约束:在物方焦平面前后能够清晰成像的范围称为景深,相机景深与焦距、对焦距离、光圈值等参数密切相关。经过景深约束后,相机视场范围为一个四棱台。对于双目系统,如

(4)遮挡约束:可分为两种情况:一种是传感器和物体之间存在其他阻碍物;另一种是物体自身的某些部分不规则,存在遮挡,致使无法拍摄到。

(5)禁止约束:即传感器无法到达的区域,即前面所述工作空间约束。

2.2.2 模型视点规划

为简化模型,采用一种顺序迭代方法逐步实现基于已知物体模型的视点规划,算法流程如下,流程图如

(1)根据被测物体模型抽取控制点云以表征测量空间,选取物体点云模型中的Xmax、Xmin、Ymax、Ymin和Zmax、Zmin,计算候选视点区域的大小。候选视点空间中的每一个网格点看作是视点候选位置。

(2)对每个候选视点位置进行景深和可见性约束,计算并保存满足约束条件的点云。

(3)以候选视点空间中的每个点云为中心,统计满足视场角约束的点云数量,比较满足三个约束的候选视点指向某点云的数量,数量最大的位置确定为视点位置,并通过视点位置和指向该点云的方向确定视线方向。

(4)对点云数量差值在阈值范围内的候选视点进行遮挡约束判定,进一步确定满足约束条件候选视点。遮挡约束的判定:在候选点云中随机取n个点云,将传感器位置与随机点云之间n等分,取每个分割点的K邻域点云,进行遮挡判断。分别计算几个候选视点中遮挡点云的数量,遮挡数量最少的候选视点确定为传感器的视点位置。

(5)确定了一个视点位置和视线方向后,去除已选的点云,重复进行以上操作,依次确定多个视点的位置和视线方向。

(6)当剩下的点云数量小于设定的阈值时,认为基本上全部覆盖,算法终止。

3 多节点三维传感器测量网的标定

3.1 大尺寸立体标靶的高精度构建

针对大尺寸标定基准参照物加工困难问题,采用自适应立体标靶制作方案,即根据测量空间尺寸,构建编码标志点参照物,利用近景摄影测量技术构建立体标定基准。以人体测量为例,立体标靶采用刚体多面立柱体,并在每一面上粘贴环状编码标志点,构成立体标靶。该部分涉及编码标志点的自动识别、圆心校正、光束平差等相关技术[44-47]。其主要步骤如下:

(1)用高分辨了数码相机(尼康D200)在58个不同的视角拍摄获得标靶图像,如

式中:

3.2 多节点三维传感器测量网络的同步标定

对于多节点三维传感器标定较为普遍的标定方案为分步标定法,即先对各个节点三维传感器逐一标定出其内部参数,再确定出各个节点传感器之间的外部结构参数。该方案思想较简洁明了,但由于该方案需对每个节点传感器逐一操作,较为繁琐、耗时、非自动化,而且,外部结构参数的确定仍需额外方法。由于文中三维传感器采用双目结构系统,并借助三维立体标靶,即可实现各节点传感器内部参数与各节点之间外部结构参数同时标定。因此,可将复杂的多节点三维传感器网络标定问题转化为多相机网络标定问题,减少了系统标定的复杂性。

将校正后的标靶置于三维成像系统的测量空间之内,控制系统内的各摄像机采集标靶的图像,根据图像中的标志点标定系统内各摄像机的参数以及各摄像机之间的相互坐标变换关系,完成系统的标定,如

式中:

其中,需要确定三维基准点Xj与其图像坐标

式中:

理论上,如果每台摄像机能够一次拍摄到标定靶中足够多的非共面基准点,即可完成摄像机的标定和测量网的标定。为了进一步提高标定结果的可靠性,在实际标定中,通常改变标靶的姿态拍摄M组图像,利用多组图像以提供更多的约束方程,能更准确地优化摄像机内外参和畸变系数,有助于得到更稳定的传感器节点的结构参数和外参。对于某一节点i而言,将双目传感器的结构参数和该节点的外参作为待优化的参数向量,构造新的优化目标函数:

式中:上标s为系统的第s个拍摄姿态,t为标靶中第t个基准点;

4 多节点三维传感器测量网数据建模

为获取物体完整三维模型,需将不同视场获取物体深度数据与纹理数据进行匹配与融合操作。对于深度数据匹配应用最为广泛的是迭代最近点(ICP)方法[48],该方法对高密度数据匹配精度高、但计算量大、对初值敏感。为解决初值问题先后发展了诸多粗匹配方法,如借助标志点、基于三维几何特征(旋转图像(spin image)、点签名(point signature)、双切线(bi-tangent curves)、曲面的曲率以及平面和特征线等等)、基于二维纹理特征(图像相关、SIFT等)、基于机械手等仪器设备等[49-50]。对多视场深度数据的融合方法,主要有基于缝合思想和隐函数思想两种方法[50]:基于缝合方法的优点是计算量不大,但重叠区域的识别和保持接缝处的连续性、光滑性较为困难。基于隐函数方法主要通过构造带有符号的距离函数,采用不同的体绘制算法来提取所需要的多边形网格。该类方法能够保持接缝处光滑,但计算复杂度较高。相较于前期三维传感,该部分属于后期建模,属计算机图形学领域,相对较为独立。但文中介绍的多节点三维传感器测量网络,尤其是网络标定相关技术及输出参数,为该部分实现多传感器测量数据的自动匹配提供了帮助。下面逐一简要介绍相关处理方案[51-60]。

4.1 三维深度数据匹配

由3.2部分可知,测量网标定结果参数包含各节点三维传感器间的外部参数,即为各传感器测量三维深度数据间的旋转平移刚体变换参数。该参数可作为数据匹配的初始估计,结合一种迭代全局ICP方法以减少匹配误差积累。匹配的误差积累主要来源于测量网内部多个三维传感器之间测量数据的匹配误差(各节点传感器间标定误差)、测量网多视场测量数据间的匹配误差(对于物体相对于测量网变换角度,产生多视场数据情况)、及其两者相衔接的匹配误差。

全局ICP迭代算法如下:

While (no converges){ /*收敛条件:

For (i = 1; i

1、提取与

2、将点转换到世界坐标系;

3、计算转换矩阵

4、

}

}

此外,为加快收敛速度,采用一种多分辨的采样方法,由低分辨逐渐向高分辨过渡,以减少ICP运算时间。具体方法可参见文献[54-56],此处不再展开。

4.2 三维数据与纹理数据融合

当前三维深度数据融合方法较为成熟,且随着三维传感技术发展,三维深度数据精度和质量也愈高,故融合模型基本无问题。而纹理数据获取受环境照明影响较大,尤其对于测量网的各节点传感器均从不同角度获取纹理数据,照明差异尤为明显。为此,为获取物体高保真度、高精度的颜色信息,构建光照系统及颜色采集系统,对光源、物体及传感器进行高精度标定。一方面,根据测量物体、系统及环境等因素,设计LED阵列光源,建立测量空间无影人工日光控制,从而最大程度获取均匀照明,为高保真颜色信息获取提供环境支持。另一方面,由3.2节测量网络标定处理可将纹理相机的内外参数同时标定,即可获取亚像素级深度纹理映射,该部分内容可参见相关标定论文。基于三维融合模型及纹理映射关系即可实现纹理融合,即将各传感器纹理数据进行颜色校正、接缝平滑、插值平均等处理,为三维模型生成整张纹理映射图。课题组前期提出了基于复合权重的纹理数据融合方案,根据相机相对几何模型的姿态、空间几何模型以及几何模型投影到纹理图侧影轮廓等信息,构造几何三角面片在各个子纹理图中的颜色权重,采用法向量权重、边缘权重、深度权重相结合的方式定义复合权重,客观的衡量物体在采集纹理图中的颜色置信度。

图 9. 3D measurement and imaging for human body

Fig. 9. 3D measurement and imaging for human body

5 结 论

阐述了基于条纹相位结构光的多节点三维传感器测量网络相关技术,涉及到了网络构造与规划、网络标定、网络数据融合等问题。在解决中大尺寸物体的自动化、快速三维测量及工业检测具有较大应用价值;为结构光三维传感技术发展提供了补充式理论与实践探索。文中内容涉及三维传感、条纹分析、摄像机标定、深度重建、网络规划、近景摄影测量、图像识别、深度数据匹配、纹理融合等相关知识,由于篇幅限制,诸多技术细节未能展开阐述,具体可参考相关文献。

[4] Daanen H A M, TerHaar F B. 3D whole body scanners revisited[J]. Displays, 2013, 34: 270-275.

[7] He Jinying, Liu Xiaoli, Peng Xiang. Integer pixel correlation searching for three-dimensional digital speckle based on gray constraint[J]. Chinese Journal of Lasers, 2017, 44(4): 150-157.

[43] Scott W R. Model-based view planning[J]. Machine Vision and Applications, 2009, 20(1): 47-69.

[46] Yin Yongkai, Liu Xiaoli, Li Ameng. Sub-pixel location of circle target and its application[J]. Infrared and Laser Engineering, 2008, 37(4): 47-50.

[50] Liu Xiaoli. Key techniques in multiple range images modeling [D]. Tianjin: Tianjin University, 2008. (in Chinese)

[51] Liu X, Peng X, He D, et al. Automatic 3D imaging modeling system with col infmation f cultural heritage digitization [C]Fringe 2013, 2013: 821826.

[53] Liu X, Peng X, Yin Y. Generation of photorealistic 3D image using optical digitizer[J]. Applied Optics, 2012, 51(7): 1304-1311.

[55] Liu X, He X, Liu Z, et al. Automatic registration of range images combined with the system calibration global ICP [C]SPIE, 2012: 84991X.

[57] Liu Xiaoli, Peng Xiang, Li Ameng. Range images registration combined with texture information[J]. Journal of Computer-aided Design & Computer Graphics, 2007, 19(3): 340-345.

[58] Liu Xingming, Liu Xiaoli, Yin Yongkai. Texture blending of 3D photo-realistic model[J]. Journal of Computer-aided Design & Computer Graphics, 2012, 24(11): 1440-1446.

[60] Liu Xiaoli, Peng Xiang, Li Ameng. Integration of multiple range images based on ray casting[J]. Journal of Computer-aided Design & Computer Graphics, 2007, 19(10): 1286-1291.

Article Outline

刘晓利, 何懂, 陈海龙, 蔡泽伟, 殷永凯, 彭翔. 结构光三维传感器测量网相关技术[J]. 红外与激光工程, 2020, 49(3): 0303007. Xiaoli Liu, Dong He, Hailong Chen, Zewei Cai, Yongkai Yin, Xiang Peng. Techniques of structured light measurement network with 3D sensors[J]. Infrared and Laser Engineering, 2020, 49(3): 0303007.